教程+资源,python scrapy实战爬取知乎最性感妹子的爆照合集(12G)!

一.出发点:

之前在知乎看到一位大牛(二胖)写的一篇文章:python爬取知乎最受欢迎的妹子(大概题目是这个,具体记不清了),但是这位二胖哥没有给出源码,而我也没用过python,正好顺便学一学,所以我决定自己动手搞一搞.

爬取已经完成,文末有 python的源码和妹子图片的百度云地址

二.准备:

爬虫还是要用python(之前用过一个国人大牛写的java爬虫框架 webmagic),所以花了点时间看了下网上python的教程,语法什么的(当然什么都没记住~),然后看了看scrapy这个爬虫框架,大概了解了其中各个组件的作用,每个组件的作用和爬取数据的几个步骤.

三.思路分析:

知乎二胖哥的思路大致如下:

- 1 手动找到部分宅男, 抓取他们关注的女性用户 和 部分问题的女性回答者

作为 "初始美女"群体 - 2 抓取 "初始美女" 所有的粉丝, 作为 "宅男群体"

- 3 再抓取 "宅男群体" 关注的人里面取top 1000, 得到知乎最受欢迎的美女.

我和二胖哥的目的有所不同,

二胖是要找到最受欢迎的妹子,

而我的目的是: - 1 学习使用python 的 scrapy框架

- 2 爬取精彩又性感的文章和图片.

所以我通过两个方面开始爬取: - 某些女生回答的多的问题, 比如: 拥有大长腿是怎样的感觉?

- 收藏夹. 知乎有收藏夹功能,把不同问题下的答案放到一个收藏加下.我关注了一个叫做

知乎妹子爆照合集的收藏夹

我大概爬取了12G的图片资源(因为我的服务器只有12G的剩余空间了...)

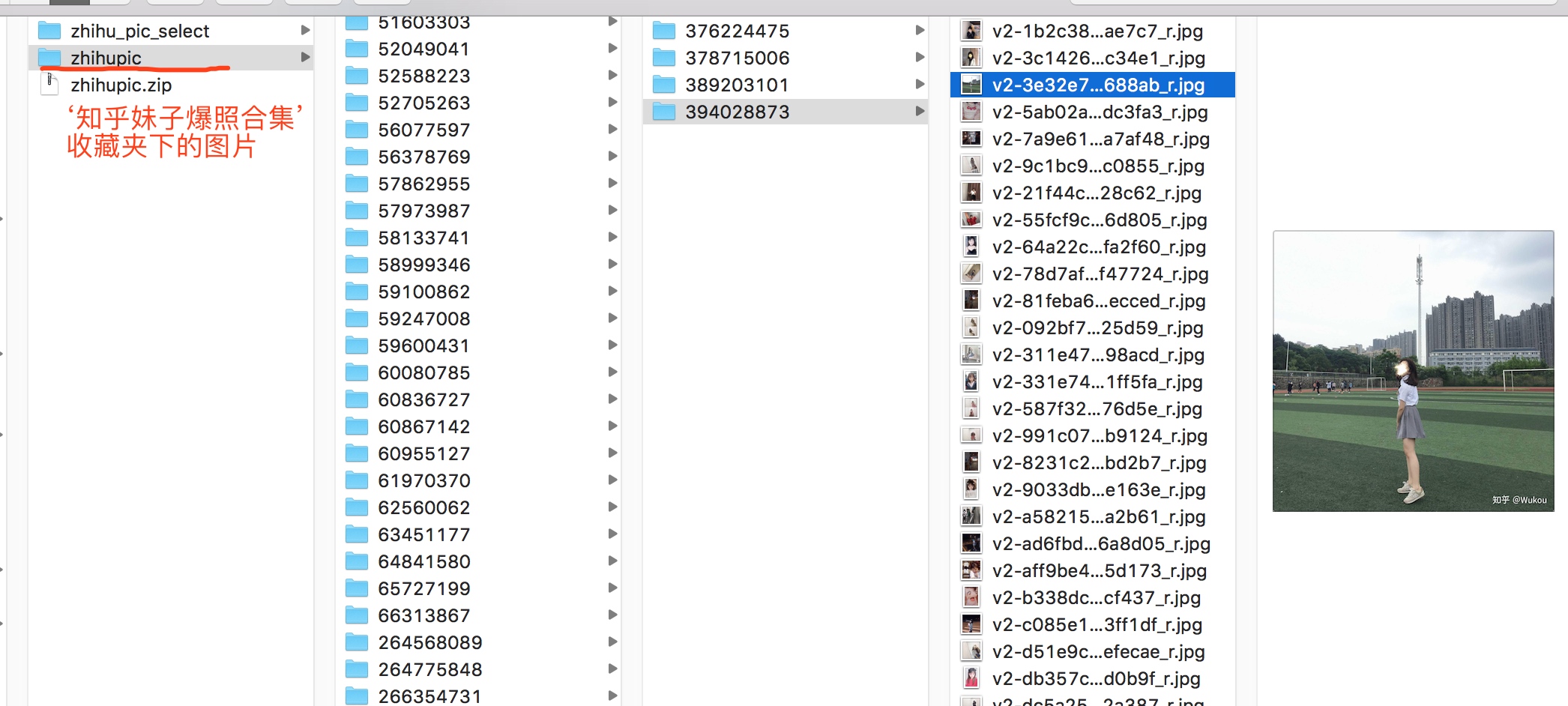

我存储图片的目录是按照 问题id/回答id的格式存放的.

四.收藏夹里的问题很多,大致目录如下:

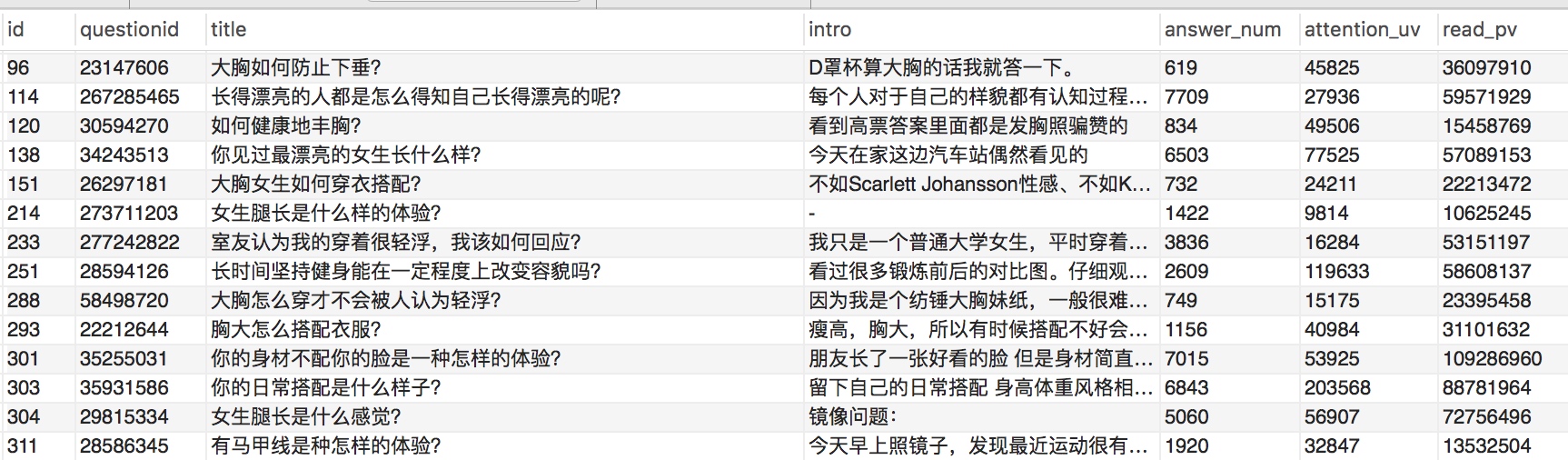

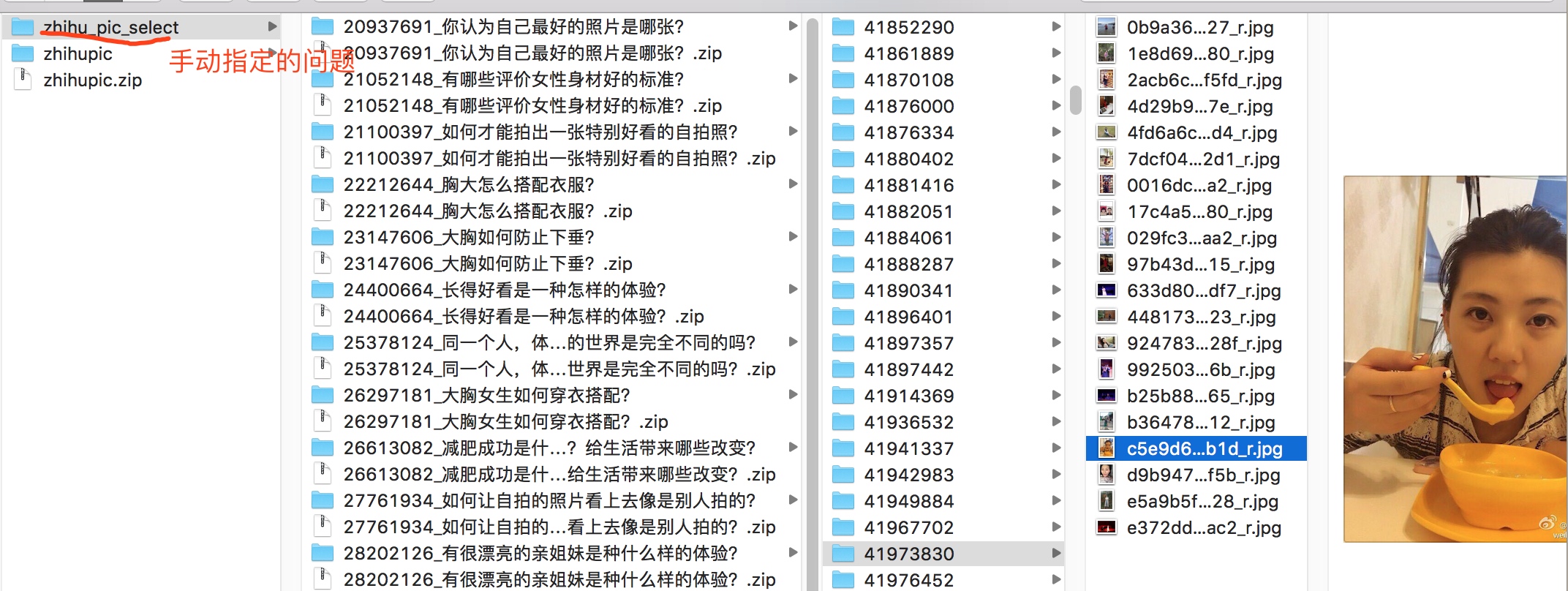

五.手动指定了几个问题如下:

指定的问题:

基本上这些问题都是妹子爆照多的话题,有不少妹子照片.

目录结构:

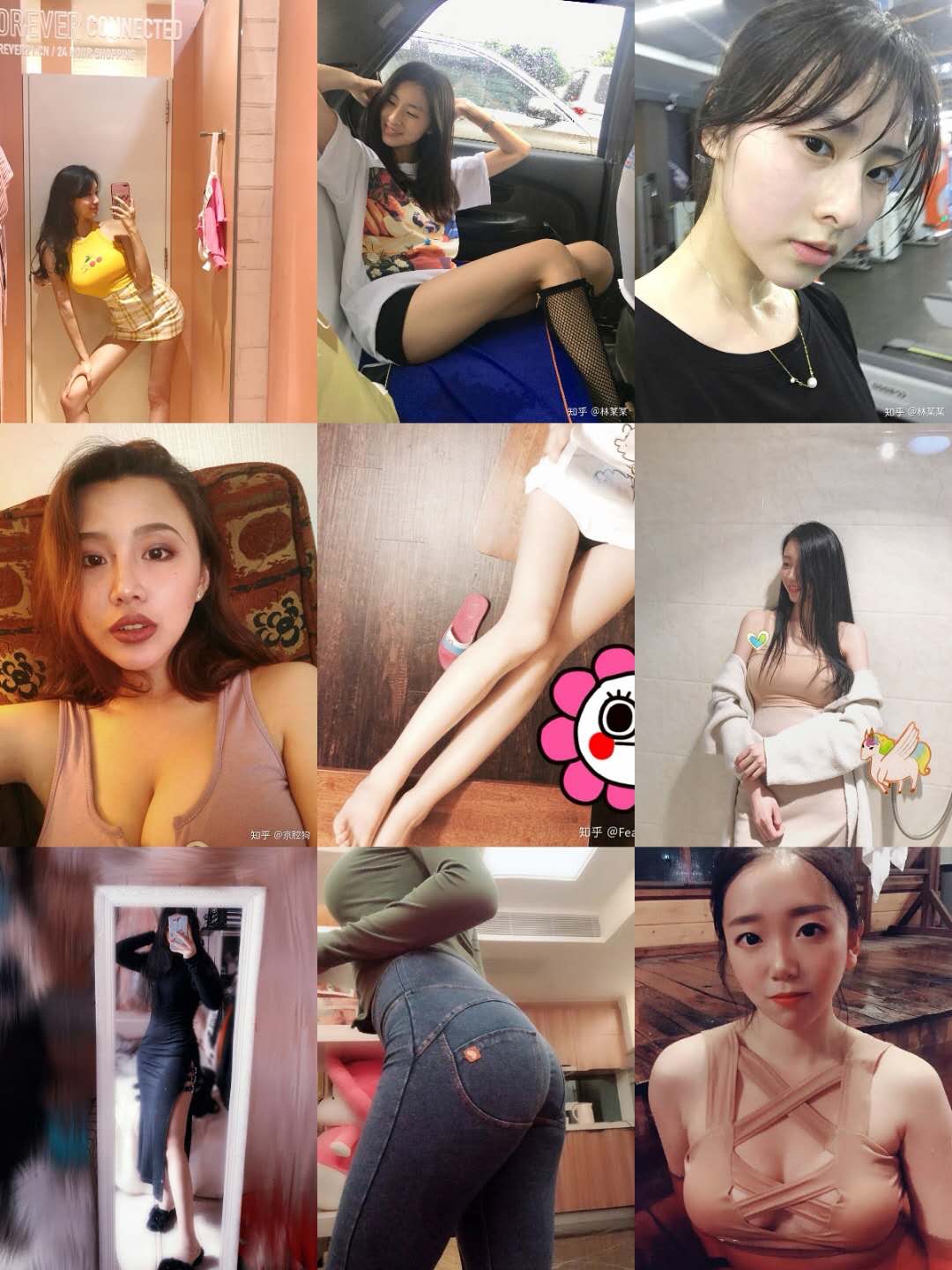

六.成果展示:

七.爬取方法介绍:

爬取网页(知乎)信息大概分为以下几个步骤:

- 确定爬取的初始页面(url地址)

- 确定要爬取哪些内容,使用xpath获取爬取内容的html文档路径获取内容.(或者能够从页面找到ajax调用后台的接口,去调接口拿到数据,一般返回的json格式,比使用xpath方便.)

- 爬取到内容的处理, 存数据库(mysql,mongo,等),落地到文件,等~

八.爬取教程分享

python scrapy爬虫框架概念介绍(个人理解总结为一张图)

python scrapy 登录知乎过程

使用python scrapy爬取知乎提问信息

python scrapy爬取知乎问题和收藏夹下所有答案的内容和图片

九.福利分享

如果有同学对python的爬虫代码和妹子图片感兴趣,

我已上传,关注微信公众号:程序员灯塔 (code12306)

回复 '知乎源码',获取python源码

回复 '知乎美女',获取12G图片资源的百度网盘地址.

程序员灯塔,关注互联网+大数据技术. 分享面试攻略+技术干货!

教程+资源,python scrapy实战爬取知乎最性感妹子的爆照合集(12G)!的更多相关文章

- 简单的scrapy实战:爬取腾讯招聘北京地区的相关招聘信息

简单的scrapy实战:爬取腾讯招聘北京地区的相关招聘信息 简单的scrapy实战:爬取腾讯招聘北京地区的相关招聘信息 系统环境:Fedora22(昨天已安装scrapy环境) 爬取的开始URL:ht ...

- python爬虫实战---爬取大众点评评论

python爬虫实战—爬取大众点评评论(加密字体) 1.首先打开一个店铺找到评论 很多人学习python,不知道从何学起.很多人学习python,掌握了基本语法过后,不知道在哪里寻找案例上手.很多已经 ...

- python scrapy+Mongodb爬取蜻蜓FM,酷我及懒人听书

1.初衷:想在网上批量下载点听书.脱口秀之类,资源匮乏,大家可以一试 2.技术:wireshark scrapy jsonMonogoDB 3.思路:wireshark分析移动APP返回的各种连接分类 ...

- scrapy实战--爬取最新美剧

现在写一个利用scrapy爬虫框架爬取最新美剧的项目. 准备工作: 目标地址:http://www.meijutt.com/new100.html 爬取项目:美剧名称.状态.电视台.更新时间 1.创建 ...

- Python scrapy框架爬取瓜子二手车信息数据

项目实施依赖: python,scrapy ,fiddler scrapy安装依赖的包: 可以到https://www.lfd.uci.edu/~gohlke/pythonlibs/ 下载 pywi ...

- python scrapy框架爬取豆瓣

刚刚学了一下,还不是很明白.随手记录. 在piplines.py文件中 将爬到的数据 放到json中 class DoubanmoviePipelin2json(object):#打开文件 open_ ...

- Python+Scrapy+Crawlspider 爬取数据且存入MySQL数据库

1.Scrapy使用流程 1-1.使用Terminal终端创建工程,输入指令:scrapy startproject ProName 1-2.进入工程目录:cd ProName 1-3.创建爬虫文件( ...

- Python爬虫之爬取慕课网课程评分

BS是什么? BeautifulSoup是一个基于标签的文本解析工具.可以根据标签提取想要的内容,很适合处理html和xml这类语言文本.如果你希望了解更多关于BS的介绍和用法,请看Beautiful ...

- 使用python scrapy爬取知乎提问信息

前文介绍了python的scrapy爬虫框架和登录知乎的方法. 这里介绍如何爬取知乎的问题信息,并保存到mysql数据库中. 首先,看一下我要爬取哪些内容: 如下图所示,我要爬取一个问题的6个信息: ...

随机推荐

- leetcode — merge-k-sorted-lists

import java.util.ArrayList; import java.util.List; import java.util.PriorityQueue; /** * Source : ht ...

- JavaWeb学习 (二十七)————监听器(Listener)在开发中的应用

监听器在JavaWeb开发中用得比较多,下面说一下监听器(Listener)在开发中的常见应用 一.统计当前在线人数 在JavaWeb应用开发中,有时候我们需要统计当前在线的用户数,此时就可以使用监听 ...

- 使用gitlab, jenkins搭建CI(持续集成)系统(3) -- 根据不同触发条件执行不同的构建任务

前面在jenkins中安装的gitlab hook支持不同的参数,具体可以参考gitlab hook文档https://github.com/jenkinsci/gitlab-hook-plugin# ...

- K均值聚类

聚类(cluster)与分类的不同之处在于, 分类算法训练过程中样本所属的分类是已知的属监督学习. 而聚类算法不需要带有分类的训练数据,而是根据样本特征的相似性将其分为几类,又称为无监督分类. K均值 ...

- [IOI2014] 假期

Description 有\(N(N\leq 10^5)\)个排列在一条线上的城市,每个城市有\(val_i\)个景点.每天你可以选择在当前城市\(i\)游览景点,或者前往城市\(i-1\)或城市\( ...

- Badge

The following plugin provides functionality available through Pipeline-compatible steps. Read more a ...

- Spring Integration实现分布式锁

学习本篇之前,可以先看下文章 什么是分布式锁,了解下基本概念. 之前都是手写一个分布式锁,其实Spring早就提供了分布式锁的实现.早期,分布式锁的相关代码存在于Spring Cloud的子项目Spr ...

- 安装Eclipse时遇到”java was started but returned exit code = 13“如何解决?

有的时候运行开发工具时会出现java was started but returned exit code = 13......的提示,绝大多数的问题都是版本问题: 我们可以打开命令行工具cmd 输入 ...

- [android] 手机卫士保存安全号码

调用ListView对象的setOnItemClickListener()方法,设置条目的点击事件,参数:OnItemClickListener对象 使用匿名内部类实现,重写onClick()方法,传 ...

- 【Spring】4、Spring中 @Autowired标签与 @Resource标签 的区别

转自:http://blog.csdn.net/angus_17/article/details/7543478 spring不但支持自己定义的@Autowired注解,还支持由JSR-250规范定义 ...