requests+lxml+xpath爬取电影天堂

1.导入相应的包

import requests

from lxml import etree

2.原始ur

url="https://www.dytt8.net/html/gndy/dyzz/list_23_1.html"

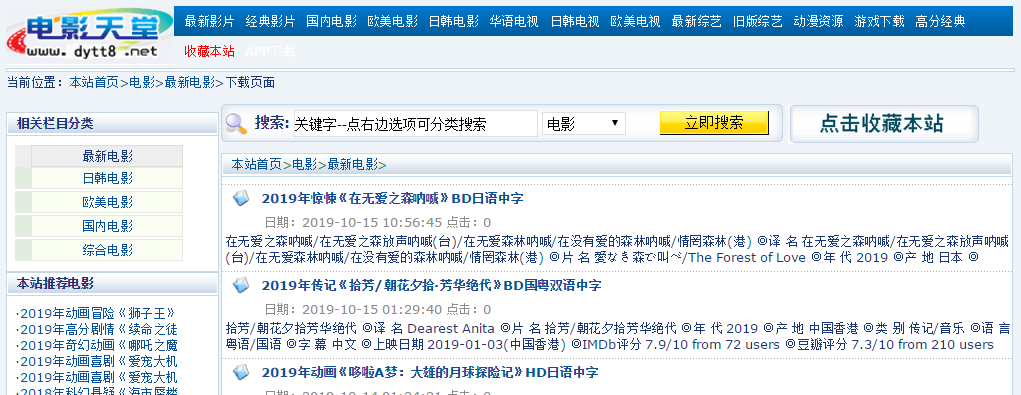

我们要爬取的是最新电影,在该界面中,我们发现,具体的信息存储在每个名字的链接中,因此我们要获取所有电影的链接才能得到电影的信息。同时我们观察url,发现

list_23_1,最后的1是页面位于第几页。右键点击其中一个电影的名字-检查。

我们发现,其部分连接位于具有class="tbspan"的table的<b>中,首先建立一个函数,用来得到所有的链接:

#用于补全url

base_url="https://www.dytt8.net"

def get_domain_urls(url):

response=requests.get(url=url,headers=headers)

text=response.text

html=etree.HTML(text)

#找到具有class="tbspan"的table下的所有a下面的href里面的值

detail_urls=html.xpath("//table[@class='tbspan']//a/@href")

#将url进行补全

detail_urls=map(lambda url:base_url+url,detail_urls)

return detail_urls

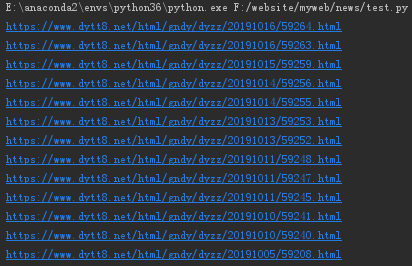

我们输出第1页中的所有url结果:

url="https://www.dytt8.net/html/gndy/dyzz/list_23_1.html"

for i in get_domain_urls(url):

print(i)

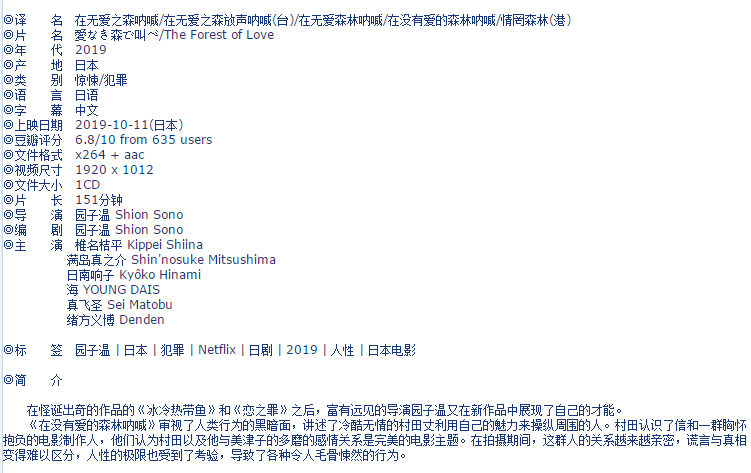

我们随便进入第一个链接:

按下F12,发现这些信息基本上都在div id="Zoom"中,接下来我们就可以对该界面进行解析。

def parse_detail_page(url):

movie={}

response=requests.get(url,headers=headers)

text=response.content.decode("GBK")

html=etree.HTML(text)

zoom=html.xpath("//div[@id='Zoom']")[0]

infos=zoom.xpath("//text()")

def parse_info(info,rule):

return info.replace(rule,"").lstrip()

for k,v in enumerate(infos):

if v.startswith("◎译 名"):

v=parse_info(v,"◎译 名").split("/")[0]

movie["name"]=v

elif v.startswith("◎产 地"):

v=parse_info(v,"◎产 地")

movie["country"]=v

elif v.startswith("◎类 别"):

v=parse_info(v,"◎类 别")

movie["category"]=v

elif v.startswith("◎豆瓣评分"):

v=parse_info(v,"◎豆瓣评分").split("/")[0]

movie["douban"]=v

elif v.startswith("◎导 演"):

v=parse_info(v,"◎导 演")

movie["director"]=v

elif v.startswith("◎主 演"):

v=parse_info(v,"◎主 演")

actors=[v]

for x in range(k+1,len(infos)):

actor=infos[x].strip()

if actor.startswith("◎"):

break

actors.append(actor)

movie["actors"]=actors

elif v.startswith("◎简 介"):

profile=""

for x in range(k+1,len(infos)):

tmp=infos[x].strip()

if tmp.startswith("【下载地址】"):

break

else:

profile=profile+tmp

movie["profile"]=profile

down_url=html.xpath("//td[@bgcolor='#fdfddf']/a/@href")

movie["down_url"]=down_url

return movie

最后将这两个整合进一个爬虫中:

def spider():

domain_url="https://www.dytt8.net/html/gndy/dyzz/list_23_{}.html"

movies=[]

for i in range(1,2):

page=str(i)

url=domain_url.format(page)

detail_urls=get_domain_urls(url)

for detail_url in detail_urls:

movie = parse_detail_page(detail_url)

movies.append(movie)

print(movies)

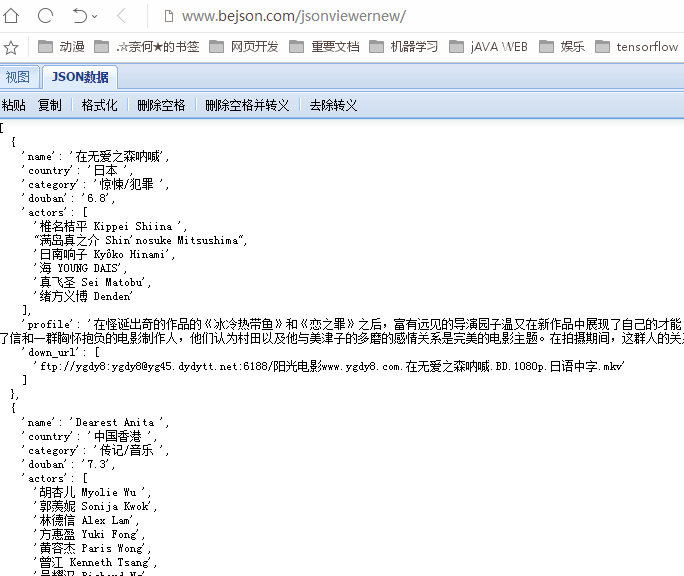

运行爬虫,得到以下结果(在Json查看器中进行格式化):

至此,一个简单的电影爬虫就完成了。

requests+lxml+xpath爬取电影天堂的更多相关文章

- requests+lxml+xpath爬取豆瓣电影

(1)lxml解析html from lxml import etree #创建一个html对象 html=stree.HTML(text) result=etree.tostring(html,en ...

- 爬虫系列(十) 用requests和xpath爬取豆瓣电影

这篇文章我们将使用 requests 和 xpath 爬取豆瓣电影 Top250,下面先贴上最终的效果图: 1.网页分析 (1)分析 URL 规律 我们首先使用 Chrome 浏览器打开 豆瓣电影 T ...

- 爬虫系列(十一) 用requests和xpath爬取豆瓣电影评论

这篇文章,我们继续利用 requests 和 xpath 爬取豆瓣电影的短评,下面还是先贴上效果图: 1.网页分析 (1)翻页 我们还是使用 Chrome 浏览器打开豆瓣电影中某一部电影的评论进行分析 ...

- python利用requests和threading模块,实现多线程爬取电影天堂最新电影信息。

利用爬到的数据,基于Django搭建的一个最新电影信息网站: n1celll.xyz (用的花生壳动态域名解析,服务器在自己的电脑上,纯属自娱自乐哈.) 今天想利用所学知识来爬取电影天堂所有最新电影 ...

- 14.python案例:爬取电影天堂中所有电视剧信息

1.python案例:爬取电影天堂中所有电视剧信息 #!/usr/bin/env python3 # -*- coding: UTF-8 -*- '''======================== ...

- scrapy框架用CrawlSpider类爬取电影天堂.

本文使用CrawlSpider方法爬取电影天堂网站内国内电影分类下的所有电影的名称和下载地址 CrawlSpider其实就是Spider的一个子类. CrawlSpider功能更加强大(链接提取器,规 ...

- Python爬取电影天堂指定电视剧或者电影

1.分析搜索请求 一位高人曾经说过,想爬取数据,要先分析网站 今天我们爬取电影天堂,有好看的美剧我在上面都能找到,算是很全了. 这个网站的广告出奇的多,用过都知道,点一下搜索就会弹出个窗口,伴随着滑稽 ...

- requests结合xpath爬取豆瓣最新上映电影

# -*- coding: utf-8 -*- """ 豆瓣最新上映电影爬取 # ul = etree.tostring(ul, encoding="utf-8 ...

- requests+BeautifulSoup | 爬取电影天堂全站电影资源

import requests import urllib.request as ur from bs4 import BeautifulSoup import csv import threadin ...

随机推荐

- selenium-03-常用操作

基本介绍: Selenium工具专门为WEB应用程序编写的一个验收测试工具. Selenium的核心:browser bot,是用JavaScript编写的. Selenium工具有4种:Seleni ...

- 商用hadoop集群的配置命令分布

角色 安装 hdfs配置 yarn配置 hdfs 格式化 启动yarn服务 启动hdfs服务 master yum install hadoop-hdfs-namenode yum install h ...

- 05、Linux通配符、转义字符、环境变量

问题:作为Linux运维人员,我们有时候也会遇到明明一个文件的名称就在嘴边但就是想不起来的情况.如果就记得一个文件的开头几个字母,想遍历查找出所有以这个关键词开头的文件,该怎么操作呢? 范例:单个查看 ...

- 今天第一次解决了程序在未装VS和XP下运行的问题

http://www.cnblogs.com/zero5/p/3162948.html 一位素不相识的朋友做的代码雨屏保程序 - 残雪孤侠 - 博客园 上面是我的BLOG 群共享里,有程序和代码 ...

- Mybatis面试题吐血总结

高强度训练第二十天总结:Mybatis面试题 什么是Mybatis? Mybatis 是一个半 ORM(对象关系映射)框架,它内部封装了 JDBC,开发时 只需要关注 SQL 语句本身,不需要花费精力 ...

- MongoDB的复制源oplog

之前有说过MongoDB的复制是异步复制的,其实也就是通过oplog来实现的,他存放在local数据库中,我们来查询一下主节点的日志大小. 除了主节点有oplog之外,其他节点也就有oplog ...

- 如何编写高质量的 JS 函数(3) --函数式编程[理论篇]

本文首发于 vivo互联网技术 微信公众号 链接:https://mp.weixin.qq.com/s/EWSqZuujHIRyx8Eb2SSidQ作者:杨昆 [编写高质量函数系列]中, <如何 ...

- .NET进阶篇-丑话先说,Flag先立

作为开发者,工作了几年,也总觉得技术栈和刚毕业区别不大,用的技术还都是N年前的,每每看到新东西,也只心里哇塞惊叹一下,然后就回归于忙碌.怪自己的技术池太浅,热门的令人称奇的技术也都是在其他巨人的肩膀上 ...

- 当我们在聊 Serverless 时你应该知道这些

作者 | 杨泽强(竹涧)阿里云技术专家 说起当前最火的技术,除了最新的区块链.AI,还有一个不得不提的概念是 Serverless.Serverless 作为一种新型的互联网架构,直接或间接推动了云计 ...

- WebGL简易教程(十):光照

目录 1. 概述 2. 原理 2.1. 光源类型 2.2. 反射类型 2.2.1. 环境反射(enviroment/ambient reflection) 2.2.2. 漫反射(diffuse ref ...