菜鸟学IT之python网页爬取多页爬取

作业来源:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE1/homework/3002

0.从新闻url获取点击次数,并整理成函数

- newsUrl

- newsId(re.search())

- clickUrl(str.format())

- requests.get(clickUrl)

- re.search()/.split()

- str.lstrip(),str.rstrip()

- int

- 整理成函数

- 获取新闻发布时间及类型转换也整理成函数

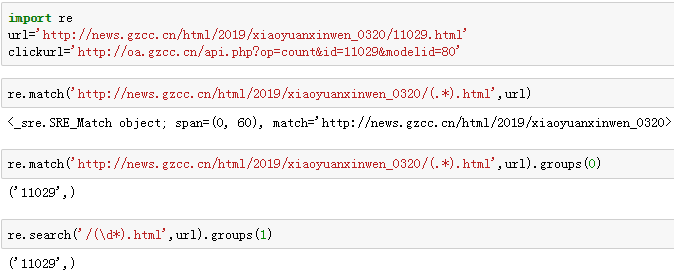

import re

url='http://news.gzcc.cn/html/2019/xiaoyuanxinwen_0320/11029.html'

clickurl='http://oa.gzcc.cn/api.php?op=count&id=11029&modelid=80'

re.match('http://news.gzcc.cn/html/2019/xiaoyuanxinwen_0320/(.*).html',url)

re.match('http://news.gzcc.cn/html/2019/xiaoyuanxinwen_0320/(.*).html',url).groups(0)

re.search('/(\d*).html',url).groups(1)

re.findall('(\d+)',url)

结果如下:

1.从新闻url获取新闻详情: 字典,anews

import requests

from bs4 import BeautifulSoup

from datetime import datetime

import re def click(url):

id=re.findall('(\d{1,5})',url)[-1]

clickUrl = 'http://oa.gzcc.cn/api.php?op=count&id=11029&modelid=80'.format(id)

resClick = requests.get(clickUrl)

newsClick = int(resClick.text.split('.html')[-1].lstrip("('").rstrip("');"))

return newsClick def newsdt(showinfo):

newsDate = showinfo.split()[0].split(':')[1]

newsTime = showinfo.split()[1]

newsDT = newsDate+' '+newsTime

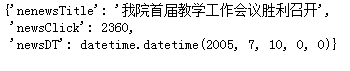

dt = datetime.strptime(newsDT, '%Y-%m-%d %H:%M:%S') return dt def anews(url):

newsDetail = {}

res = requests.get(url)

res.encoding ='utf-8'

soup = BeautifulSoup(res.text,'html.parser')

newsDetail['nenewsTitle'] =soup.select('.show-title')[0].text

showinfo = soup.select('.show-info')[0].text

newsDetail['newsDT']=newsdt(showinfo)

newsDetail['newsClick'] =click(newsUrl)

return newsDetail newsUrl='http://news.gzcc.cn/html/2005/xiaoyuanxinwen_0710/4.html'

anews(newsUrl)

结果:

2.从列表页的url获取新闻url:列表append(字典) alist

- 获取列表数据

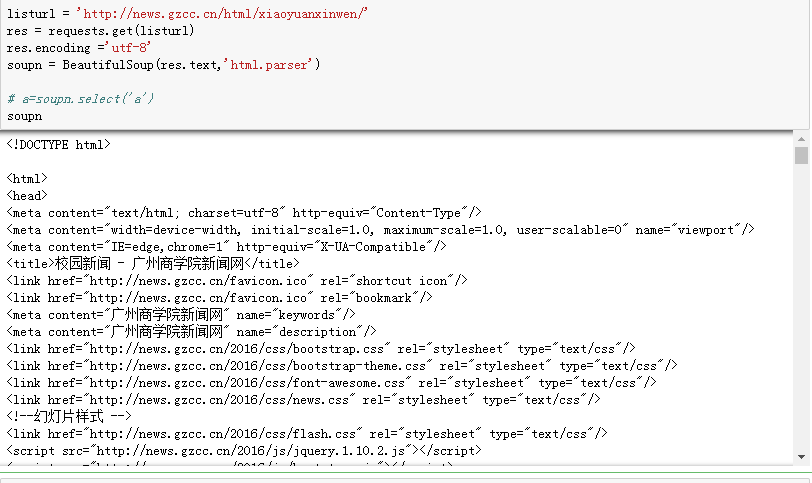

listurl = 'http://news.gzcc.cn/html/xiaoyuanxinwen/'

res = requests.get(listurl)

res.encoding ='utf-8'

soupn = BeautifulSoup(res.text,'html.parser') # a=soupn.select('a')

soupn

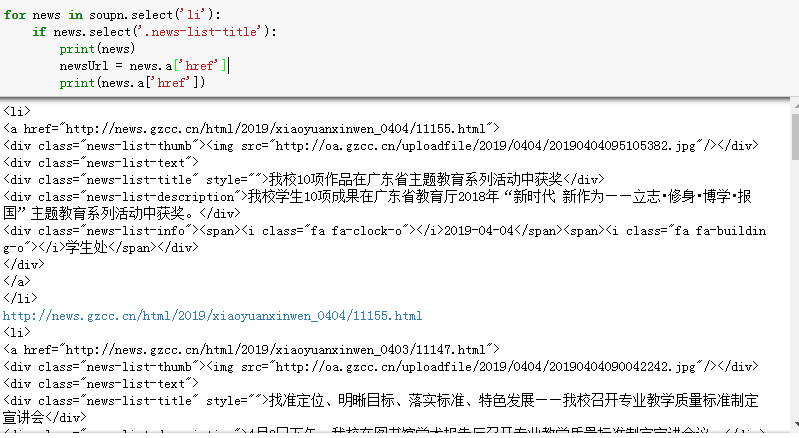

2.过滤过滤数据,只获取列表的新闻信息

for news in soupn.select('li'):

if news.select('.news-list-title'):

print(news)

newsUrl = news.a['href']

print(news.a['href'])

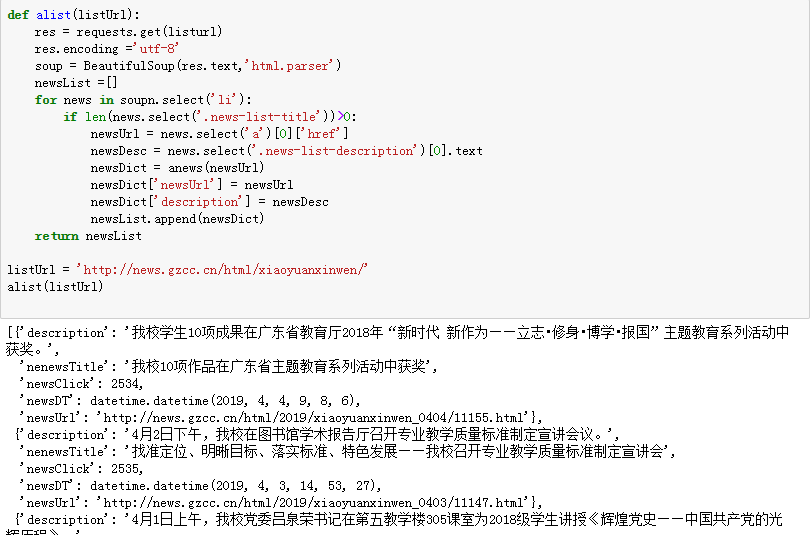

3.获取整页信息

def alist(listUrl):

res = requests.get(listurl)

res.encoding ='utf-8'

soup = BeautifulSoup(res.text,'html.parser')

newsList =[]

for news in soupn.select('li'):

if len(news.select('.news-list-title'))>0:

newsUrl = news.select('a')[0]['href']

newsDesc = news.select('.news-list-description')[0].text

newsDict = anews(newsUrl)

newsDict['newsUrl'] = newsUrl

newsDict['description'] = newsDesc

newsList.append(newsDict)

return newsList listUrl = 'http://news.gzcc.cn/html/xiaoyuanxinwen/'

alist(listUrl)

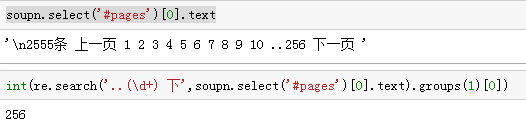

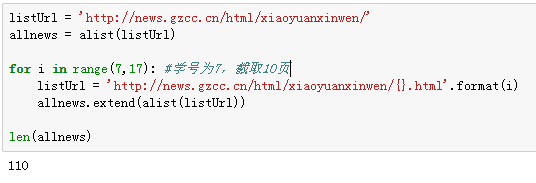

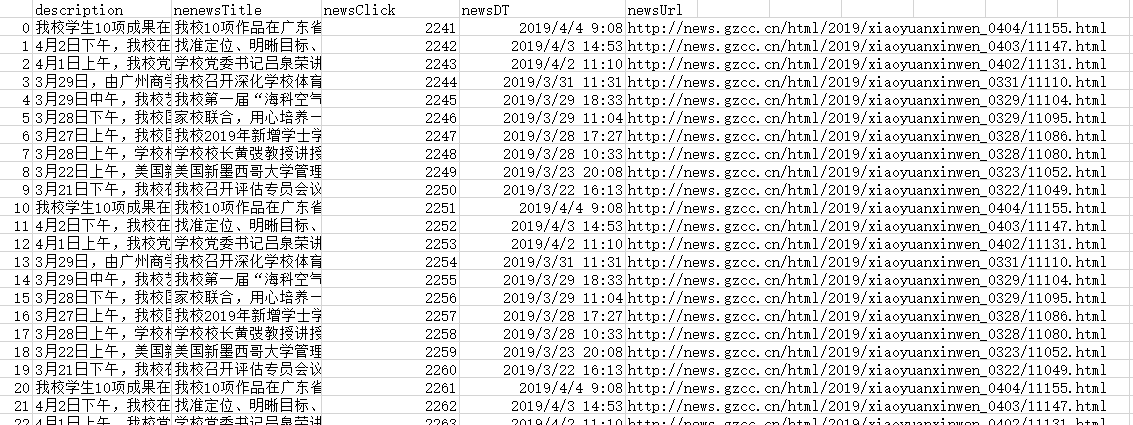

3.生成所页列表页的url并获取全部新闻 :列表extend(列表) allnews

*每个同学爬学号尾数开始的10个列表页

- 获取多页信息

- 截取以学号尾数开始的10个列表页

listUrl = 'http://news.gzcc.cn/html/xiaoyuanxinwen/'

allnews = alist(listUrl) for i in range(7,17): #学号为7,截取10页

listUrl = 'http://news.gzcc.cn/html/xiaoyuanxinwen/{}.html'.format(i)

allnews.extend(alist(listUrl)) len(allnews)

4.设置合理的爬取间隔

import time

import random

time.sleep(random.random()*3)

import time

import random

listUrl = 'http://news.gzcc.cn/html/xiaoyuanxinwen/'

allnews = alist(listUrl) for i in range(1,170): #学号为7,截取10页

listUrl = 'http://news.gzcc.cn/html/xiaoyuanxinwen/{}.html'.format(i)

allnews.extend(alist(listUrl))

time.sleep(random.random()*3) #设置每3秒爬取一次

print(alist(listUrl)) len(allnews)

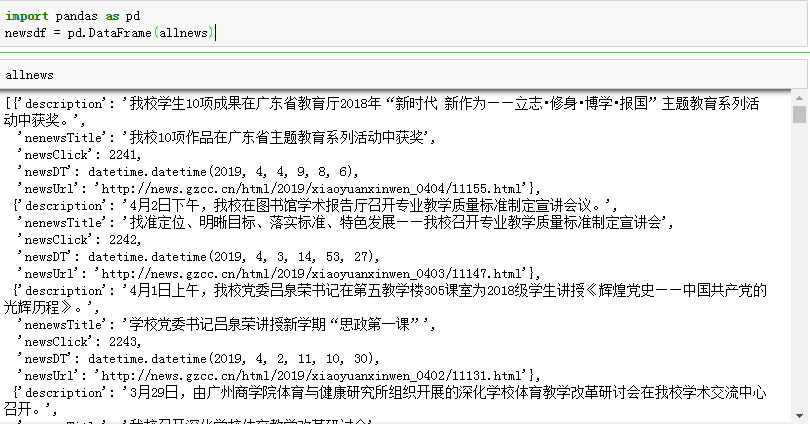

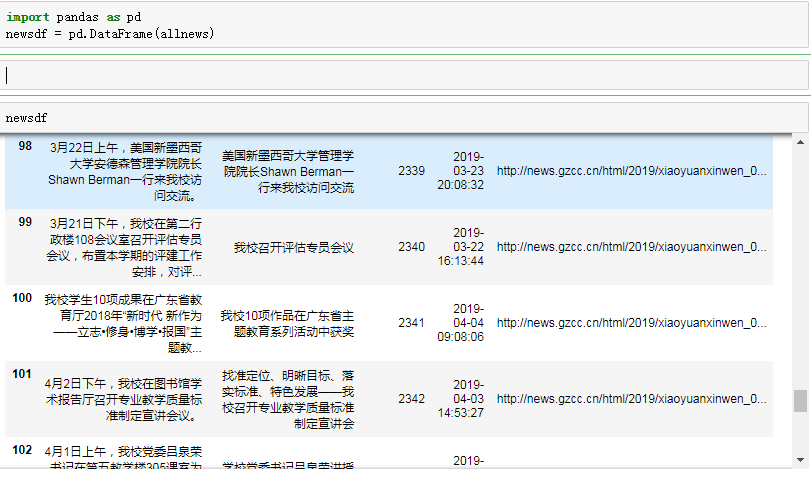

5.用pandas做简单的数据处理并保存

保存到csv或excel文件

newsdf.to_csv(r'F:\duym\爬虫\gzccnews.csv')

- 使用pandas函数整理爬取的数据

- 列表的形式打印数据

- 显示 “newsClick” 游览次数大于2337的新闻

- 生成csv文件

newsdf.to_csv(r'E:\gzcc.csv')

菜鸟学IT之python网页爬取多页爬取的更多相关文章

- 菜鸟学IT之python网页爬取初体验

作业来源:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE1/homework/2881 1. 简单说明爬虫原理 爬虫简单来说就是通过程序模拟浏览器放松请求站 ...

- python实现一个栏目的分页抓取列表页抓取

python实现一个栏目的分页抓取列表页抓取 #!/usr/bin/env python # coding=utf-8 import requests from bs4 import Beautifu ...

- 菜鸟学IT之python词云初体验

作业来源:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE1/homework/2822 1. 下载一长篇中文小说. 2. 从文件读取待分析文本. txt = ...

- python网页爬虫开发之五-反爬

1.头信息检查是否频繁相同 随机产生一个headers, #user_agent 集合 user_agent_list = [ 'Mozilla/5.0 (Windows NT 6.1; WOW64 ...

- Python爬虫学习三------requests+BeautifulSoup爬取简单网页

第一次第一次用MarkDown来写博客,先试试效果吧! 昨天2018俄罗斯世界杯拉开了大幕,作为一个伪球迷,当然也得为世界杯做出一点贡献啦. 于是今天就编写了一个爬虫程序将腾讯新闻下世界杯专题的相关新 ...

- 初识python 之 爬虫:使用正则表达式爬取“糗事百科 - 文字版”网页数据

初识python 之 爬虫:使用正则表达式爬取"古诗文"网页数据 的兄弟篇. 详细代码如下: #!/user/bin env python # author:Simple-Sir ...

- 初识python 之 爬虫:使用正则表达式爬取“古诗文”网页数据

通过requests.re(正则表达式) 爬取"古诗文"网页数据. 详细代码如下: #!/user/bin env python # author:Simple-Sir # tim ...

- Python网页解析库:用requests-html爬取网页

Python网页解析库:用requests-html爬取网页 1. 开始 Python 中可以进行网页解析的库有很多,常见的有 BeautifulSoup 和 lxml 等.在网上玩爬虫的文章通常都是 ...

- python使用requests库爬取网页的小实例:爬取京东网页

爬取京东网页的全代码: #爬取京东页面的全代码 import requests url="https://item.jd.com/2967929.html" try: r=requ ...

随机推荐

- DataIntegrityViolationException

今天出现了这个问题: org.springframework.dao.DataIntegrityViolationException: Could not execute JDBC batch upd ...

- 【Android Studio安装部署系列】二十七、Android studio修改项目名称和包名

版权声明:本文为HaiyuKing原创文章,转载请注明出处! 概述 实际项目开发中可能碰到项目名称写错了或者需要修改,而且包名可能也想要修改,那么如何操作呢. 本文是在Android Studio3. ...

- pycharm安装svn插件

弄了svn的服务端和客户端,为了方便我pycharm的使用,我又在pycharm里进行了配置,要用到subversion 下载 https://sourceforge.net/projects/win ...

- 微信小程序开发06-一个业务页面的完成

前言 接上文:微信小程序开发05-日历组件的实现 github地址:https://github.com/yexiaochai/wxdemo 这里来说一说我们的理念,我们也学习小程序开发有一周多了,从 ...

- DS控件库 DS按钮多种样式

在DS控件库(DSControls)中,DS按钮的功能非常多,通过设置不同的属性值来使按钮呈现不同的效果.DS按钮的常用属性如下: 使用不同的属性调出不同的外观样式示例

- chrome主页被篡改为hao123 win10系统

应该是开了个从流氓网站下的蓝灯,然后发现主页被篡改 尝试chrome设置修改无效,应该是快捷方式被改了 系统 win10 1.打开对应的下面两个地址,找到chrome的快捷方式,右键属性 C:\Use ...

- mysql-16进制、十进制互转

先截取左边4位,再转换: conv(left(t1.DEVICEID, 4), 16, 10) //转十进制 conv(left(t1.DEVICEID, 4), 10, 16) ...

- mysql判断条件不存在插入存在更新某字段

insert into mst_sequence(seq_type, seq_desc, seq_date, seq_no, create_time) VALUES('CK', 'XXX', NOW( ...

- 44.Odoo产品分析 (五) – 定制板块(1) – 管理odoo安装(1)

查看Odoo产品分析系列--目录 1 管理员的注意事项 在记录重要的配置细节时必须要小心,而且必须要有一个连续性的合适的.让系统能够安装备份并运行在一个可接受的时间内的计划. 1.1 制定实施策略 如 ...

- appium+python搭建自动化测试框架_Appium元素定位(二)

Appium元素定位: 工具:Android\android-sdk\tools uiautomatorviewer.bat 1. id定位: self.driver.find_element_ ...