【KAWAKO】TVM-使用c++进行推理

前言

在tvm工程的apps目录下,有一个howto_deploy的工程,根据此工程进行修改,可以得到c++推理程序。

修改cpp_deploy.cc文件

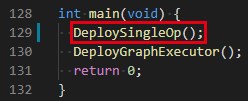

DeploySingleOp()函数不需要,直接将其和相关的Verify函数一起删掉。

修改DeployGraphExecutor()函数

读取指定模型,同时获得后面所需的函数

LOG(INFO) << "Running graph executor...";

printf("load in the library\n");

DLDevice dev{kDLCPU, 1};

tvm::runtime::Module mod_factory = tvm::runtime::Module::LoadFromFile("../model_autotune.so");

printf("create the graph executor module\n");

tvm::runtime::Module gmod = mod_factory.GetFunction("default")(dev);printf(" default\n");

tvm::runtime::PackedFunc set_input = gmod.GetFunction("set_input");printf(" set_input\n");

tvm::runtime::PackedFunc get_output = gmod.GetFunction("get_output");printf(" get_output\n");

tvm::runtime::PackedFunc run = gmod.GetFunction("run");printf(" run\n");

定义输入输出的变量

printf("Use the C++ API\n");

tvm::runtime::NDArray input = tvm::runtime::NDArray::Empty({1, 1, 640}, DLDataType{kDLFloat, 32, 1}, dev);

tvm::runtime::NDArray input_state = tvm::runtime::NDArray::Empty({1, 2, 128, 2}, DLDataType{kDLFloat, 32, 1}, dev);

tvm::runtime::NDArray output = tvm::runtime::NDArray::Empty({1, 1, 640}, DLDataType{kDLFloat, 32, 1}, dev);

tvm::runtime::NDArray output_state = tvm::runtime::NDArray::Empty({1, 2, 128, 2}, DLDataType{kDLFloat, 32, 1}, dev);

从bin文件中读取数据

float input_storage[1 * 1 * 640];

FILE* fp = fopen("../input.bin", "rb");

fread(input->data, 1 * 1 * 640, 4, fp);

fclose(fp);

float input_state_storage[1 * 2 * 128 * 2];

FILE* fp_state = fopen("../input_state.bin", "rb");

fread(input_state->data, 1 * 2 * 128 * 2, 4, fp_state);

fclose(fp_state);

将数据输入到网络

printf("set the right input\n");

set_input("input_4", input);

set_input("input_5", input_state);

运行推理

struct timeval t0, t1;

int times = 100000; // 3394

gettimeofday(&t0, 0);

printf("run the code\n");

for(int i=0;i<times;i++)

run();

gettimeofday(&t1, 0);

printf("%.5fms\n", ((t1.tv_sec - t0.tv_sec) * 1000 + (t1.tv_usec - t0.tv_usec) / 1000.f)/times);

得到输出

printf("get the output\n");

get_output(0, output);printf(" 0\n");

get_output(1, output_state);printf(" 1\n");

将输出保存到bin文件

FILE* fp_out = fopen("output.bin", "wb");

fwrite(output->data, 1 * 1 * 640, 4, fp_out);

fclose(fp_out);

FILE* fp_out_state = fopen("output_state.bin", "wb");

fwrite(output_state->data, 1 * 2 * 128 * 2, 4, fp_out_state);

fclose(fp_out_state);

numpy与bin文件的互相转换

numpy转bin

import numpy as np

import os

input_1 = np.load("./input.npy")

input_2 = np.load("./input_states.npy")

build_dir = "./"

with open(os.path.join(build_dir, "input.bin"), "wb") as fp:

fp.write(input_1.astype(np.float32).tobytes())

with open(os.path.join(build_dir, "input_state.bin"), "wb") as fp:

fp.write(input_2.astype(np.float32).tobytes())

bin转numpy

output = np.fromfile("./output.bin", dtype=np.float32)

output_state = np.fromfile("./output_state.bin", dtype=np.float32)

使用CMakeLists.txt进行编译

在howto_deploy目录下创建CMakeLists.txt

cmake_minimum_required(VERSION 3.2)

project(how2delploy C CXX)

SET(CMAKE_CXX_FLAGS_DEBUG "$ENV{CXXFLAGS} -O3 -Wall -g2 -ggdb")

SET(CMAKE_CXX_FLAGS_RELEASE "$ENV{CXXFLAGS} -O3 -Wall -fPIC")

set(TVM_ROOT /path/to/tvm)

set(DMLC_CORE ${TVM_ROOT}/3rdparty/dmlc-core)

include_directories(${TVM_ROOT}/include)

include_directories(${DMLC_CORE}/include)

include_directories(${TVM_ROOT}/3rdparty/dlpack/include)

link_directories(${TVM_ROOT}/build/Release)

add_definitions(-DDMLC_USE_LOGGING_LIBRARY=<tvm/runtime/logging.h>)

add_executable(cpp_deploy_norm cpp_deploy.cc)

target_link_libraries(cpp_deploy_norm ${TVM_ROOT}/build/libtvm_runtime.so)

老四连

mkdir build

cd build

cmake ..

make

运行

cd build

./cpp_deploy_norm

【KAWAKO】TVM-使用c++进行推理的更多相关文章

- 使用Tensorize评估硬件内部特性

使用Tensorize评估硬件内部特性 这是有关如何在TVM中执行张量的入门文档. 通过使用调度原语tensorize,人们可以用相应的内部函数代替计算单元,从而轻松利用handcrafted mic ...

- 【翻译】借助 NeoCPU 在 CPU 上进行 CNN 模型推理优化

本文翻译自 Yizhi Liu, Yao Wang, Ruofei Yu.. 的 "Optimizing CNN Model Inference on CPUs" 原文链接: h ...

- AI推理与Compiler

AI推理与Compiler AI芯片编译器能加深对AI的理解, AI芯片编译器不光涉及编译器知识,还涉及AI芯片架构和并行计算如OpenCL/Cuda等.如果从深度学习平台获得IR输入,还需要了解深度 ...

- 将TVM集成到PyTorch

将TVM集成到PyTorch 随着TVM不断展示出对深度学习执行效率的改进,很明显PyTorch将从直接利用编译器堆栈中受益.PyTorch的主要宗旨是提供无缝且强大的集成,而这不会妨碍用户.PyTo ...

- TVM代码生成codegen

TVM代码生成codegen 硬件后端提供程序(例如Intel,NVIDIA,ARM等),提供诸如cuBLAS或cuDNN之类的内核库以及许多常用的深度学习内核,或者提供框架例,如带有图形引擎的DNN ...

- 桥接PyTorch和TVM

桥接PyTorch和TVM 人工智能最引人入胜的一些应用是自然语言处理.像BERT或GPT-2之类的模型及其变体,可以获住足够多的文本信息. 这些模型属于称为Transformers的神经网络类体系结 ...

- TVM适配NN编译Compiler缺陷

TVM适配NN编译Compiler缺陷 内容纲要 前言 TVM针对VTA的编译流程 自定义VTA架构:TVM的缺陷与性能瓶颈 TVM缺陷与瓶颈 缺陷一:SRAM配置灵活性差 缺陷二:计算阵列配置僵硬 ...

- TVM优化GPU机器翻译

TVM优化GPU机器翻译 背景 神经机器翻译(NMT)是一种自动化的端到端方法,具有克服传统基于短语的翻译系统中的弱点的潜力.最近,阿里巴巴集团正在为全球电子商务部署NMT服务. 将Transform ...

- TVM 优化 ARM GPU 上的移动深度学习

TVM 优化 ARM GPU 上的移动深度学习 随着深度学习的巨大成功,将深度神经网络部署到移动设备的需求正在迅速增长.与桌面平台上所做的类似,在移动设备中使用 GPU 既有利于推理速度,也有利于能源 ...

- 端到端TVM编译器(下)

端到端TVM编译器(下) 4.3 Tensorization DL工作负载具有很高的运算强度,通常可以分解为张量运算符,如矩阵乘法或一维卷积.这些自然分解导致了最近的添加张量计算原语.这些新的原语带来 ...

随机推荐

- JDBC Request 中 Variable names 以及 Result variable name 的使用方法

1.Variable name 的使用方法 设置好JDBC Connection Configuration.JDBC Request 具体配置百度 如果数据库查询的结果不止一列那就在Variabl ...

- Python异步爬虫(aiohttp版)

异步协程不太了解的话可以去看我上篇博客:https://www.cnblogs.com/Red-Sun/p/16934843.html PS:本博客是个人笔记分享,不需要扫码加群或必须关注什么的(如果 ...

- form表单里的button 等元素不能使用margin: 0 auto;

记得把form和button都设为display:block; 就能用margin: 0 auto;水平居中了

- AcWing341. 洛谷P1073, NOIP2009 最优贸易

AcWing题目传送门 洛谷题目传送门 题目大意 \(~~~~~~\)一个投机倒把的奸商想要通过城市不太健全的贸易系统坑点钱,任意城市都可以买入或者卖出水晶球,他想尽量在便宜的城市买入,在贵的城市卖出 ...

- Linux基础第五章 进程控制

5.2 fork fork函数实现进程复制,类似于动物界的单性繁殖,fork函数直接创建一个子进程.这是Linux创建进程最常用的方法.在这一小节中,子进程概念指fork产生的进程,父进程指主动调用f ...

- MongoDB 索引原理与索引优化

转载请注明出处: 1.MongoDB索引 索引通常能够极大的提高查询的效率, 如果没有索引, MongoDB 在读取数据时必须扫描集合中的每个文件并选取那些符合查询条件的记录.这种扫描全集合的查询效率 ...

- [seaborn] seaborn学习笔记0-seaborn学习笔记章节

seaborn学习笔记章节 seaborn是一个基于matplotlib的Python数据可视化库.seaborn是matplotlib的高级封装,可以绘制有吸引力且信息丰富的统计图形.相对于matp ...

- Java中Elasticsearch 实现分页方式(三种方式)

目录 ES 简介 ES 的特点: 一.from + size 浅分页 二.scroll 深分页 scroll删除 三.search_after 深分页 ES 简介 Elasticsearch 是一个基 ...

- dispatch_source_t定时器

定时器简述 在iOS中,计时器是比较常用的,用于统计累加数据或者倒计时等,计时器大概有那么三种,分别是: NSTimer CADisplayLink dispatch_source_t 比较 1.NS ...

- 使用Rancher管理K3s

rancher中国镜像站地址 https://rancher-mirror.oss-cn-beijing.aliyuncs.com/ https://rancher-mirror.rancher.cn ...