GCE 部署 ELK 7.1可视化分析 nginx

一、准备

我这边有一个网站放在了 Google VM 上面,所以打算在购买一台服务器安装 ELK 来处理分析 nginx 的访问日志。

- 操作系统版本:CentOS 7

- ELK版本:7.1

1.1、服务器环境准备

我们这里还是采用官方的 yum 源进行安装,简单省事,首先配置官方 yum 仓库。

rpm --import https://artifacts.elastic.co/GPG-KEY-elasticsearch

cat >> /etc/yum.repos.d/elasticsearch.repo <<EOF

[elasticsearch-7.x]

name=Elasticsearch repository for 7.x packages

baseurl=https://artifacts.elastic.co/packages/7.x/yum

gpgcheck=1

gpgkey=https://artifacts.elastic.co/GPG-KEY-elasticsearch

enabled=1

autorefresh=1

type=rpm-md

EOF

关闭防火墙。

systemctl stop firewalld.service

systemctl disable firewalld.service

二、安装 ES

Elasticsearch 的软件包自带一个版本的 OpenJDK,所以我们这里不需要单独去安装 JDK 了,直接使用官方的就行。

yum install elasticsearch -y

因为默认是监听 IP 是127.0.0.1,我们需要开启配置文件/etc/elasticsearch/elasticsearch.yml的一个参数network.host,写上自己的本地IP即可。

2.1、遇到小问题

如此修改了一下配置文件之后,我发现无法启动了,日志也没有看到什么错误,我就手动执行查看问题。

[root@elk ~]# su - elasticsearch -s /bin/sh -c "/usr/share/elasticsearch/bin/elasticsearch"

su: warning: cannot change directory to /nonexistent: No such file or directory

OpenJDK 64-Bit Server VM warning: Option UseConcMarkSweepGC was deprecated in version 9.0 and will likely be removed in a future release.

[2019-05-31T03:20:42,902][INFO ][o.e.e.NodeEnvironment ] [elk] using [1] data paths, mounts [[/ (rootfs)]], net usable_space [7.7gb], net total_space [9.9gb], types [rootfs]

[2019-05-31T03:20:42,908][INFO ][o.e.e.NodeEnvironment ] [elk] heap size [990.7mb], compressed ordinary object pointers [true]

.................................

[2019-05-31T03:20:50,083][INFO ][o.e.x.s.a.s.FileRolesStore] [elk] parsed [0] roles from file [/etc/elasticsearch/roles.yml]

[2019-05-31T03:20:50,933][INFO ][o.e.x.m.p.l.CppLogMessageHandler] [elk] [controller/5098] [Main.cc@109] controller (64 bit): Version 7.1.1 (Build fd619a36eb77df) Copyright (c) 2019 Elasticsearch BV

[2019-05-31T03:20:51,489][DEBUG][o.e.a.ActionModule ] [elk] Using REST wrapper from plugin org.elasticsearch.xpack.security.Security

[2019-05-31T03:20:51,881][INFO ][o.e.d.DiscoveryModule ] [elk] using discovery type [zen] and seed hosts providers [settings]

[2019-05-31T03:20:53,019][INFO ][o.e.n.Node ] [elk] initialized

[2019-05-31T03:20:53,020][INFO ][o.e.n.Node ] [elk] starting ...

[2019-05-31T03:20:53,178][INFO ][o.e.t.TransportService ] [elk] publish_address {10.154.0.3:9300}, bound_addresses {10.154.0.3:9300}

[2019-05-31T03:20:53,187][INFO ][o.e.b.BootstrapChecks ] [elk] bound or publishing to a non-loopback address, enforcing bootstrap checks

ERROR: [2] bootstrap checks failed

[1]: max file descriptors [4096] for elasticsearch process is too low, increase to at least [65535]

[2]: the default discovery settings are unsuitable for production use; at least one of [discovery.seed_hosts, discovery.seed_providers, cluster.initial_master_nodes] must be configured

[2019-05-31T03:20:53,221][INFO ][o.e.n.Node ] [elk] stopping ...

[2019-05-31T03:20:53,243][INFO ][o.e.n.Node ] [elk] stopped

[2019-05-31T03:20:53,244][INFO ][o.e.n.Node ] [elk] closing ...

[2019-05-31T03:20:53,259][INFO ][o.e.n.Node ] [elk] closed

[2019-05-31T03:20:53,264][INFO ][o.e.x.m.p.NativeController] [elk] Native controller process has stopped - no new native processes can be started

我们可以看到下面的两个错误,一个是说最大文件打开数比较小,一个说还必须开启一个 discovery 设置,那我们分别操作一下。

#临时修改,立刻生效

ulimit -n 655350

#永久修改

echo "* soft nofile 655360" >> /etc/security/limits.conf

echo "* hard nofile 655360" >> /etc/security/limits.conf

我修改后的配置文件如下:

node.name: node-1

path.data: /var/lib/elasticsearch

path.logs: /var/log/elasticsearch

network.host: 10.154.0.3

cluster.initial_master_nodes: ["node-1", "node-2"]

然后我们就可以启动了。

systemctl daemon-reload

systemctl enable elasticsearch.service

systemctl start elasticsearch.service

访问一下页面。

{

"name" : "node-1",

"cluster_name" : "elasticsearch",

"cluster_uuid" : "P0GGZU9pRzutp-zHDZvYuQ",

"version" : {

"number" : "7.1.1",

"build_flavor" : "default",

"build_type" : "rpm",

"build_hash" : "7a013de",

"build_date" : "2019-05-23T14:04:00.380842Z",

"build_snapshot" : false,

"lucene_version" : "8.0.0",

"minimum_wire_compatibility_version" : "6.8.0",

"minimum_index_compatibility_version" : "6.0.0-beta1"

},

"tagline" : "You Know, for Search"

}

三、安装 Kibana

为了节省机器资源,我们这里使用安装在一台机器上面,因为环境上面已经配置好,我们这里直接进行安装。

yum install kibana -y

编辑配置文件/etc/kibana/kibana.yml,修改如下内容:

server.port: 5601

server.host: "10.154.0.3"

elasticsearch.hosts: ["http://10.154.0.3:9200"]

启动服务。

systemctl daemon-reload

systemctl enable kibana.service

systemctl start kibana.service

访问画面正常显示即我们安装完成。

四、安装 Logstash

yum install logstash -y

创建配置文件/etc/logstash/conf.d/logstash.conf,增加如下内容:

input {

beats {

port => 5044

}

}

filter {

if [fields][type] == "nginx_access" {

grok {

match => { "message" => "%{NGINXACCESS}" }

}

}

if [fields][type] == "apache_access" {

grok {

match => { "message" => "%{COMBINEDAPACHELOG}" }

}

}

mutate {

remove_field =>["message"]

remove_field =>["host"]

remove_field =>["input"]

remove_field =>["prospector"]

remove_field =>["beat"]

}

geoip {

source => "clientip"

}

date {

match => [ "timestamp" , "dd/MMM/yyyy:HH:mm:ss Z" ]

}

}

output {

if [fields][type] == "nginx_access" {

elasticsearch {

hosts => "172.18.8.200:9200"

index => "%{[fields][type]}-%{+YYYY.MM.dd}"

}

}

if [fields][type] == "apache_access" {

elasticsearch {

hosts => "172.18.8.200:9200"

index => "%{[fields][type]}-%{+YYYY.MM.dd}"

}

}

}

未完待续。。。

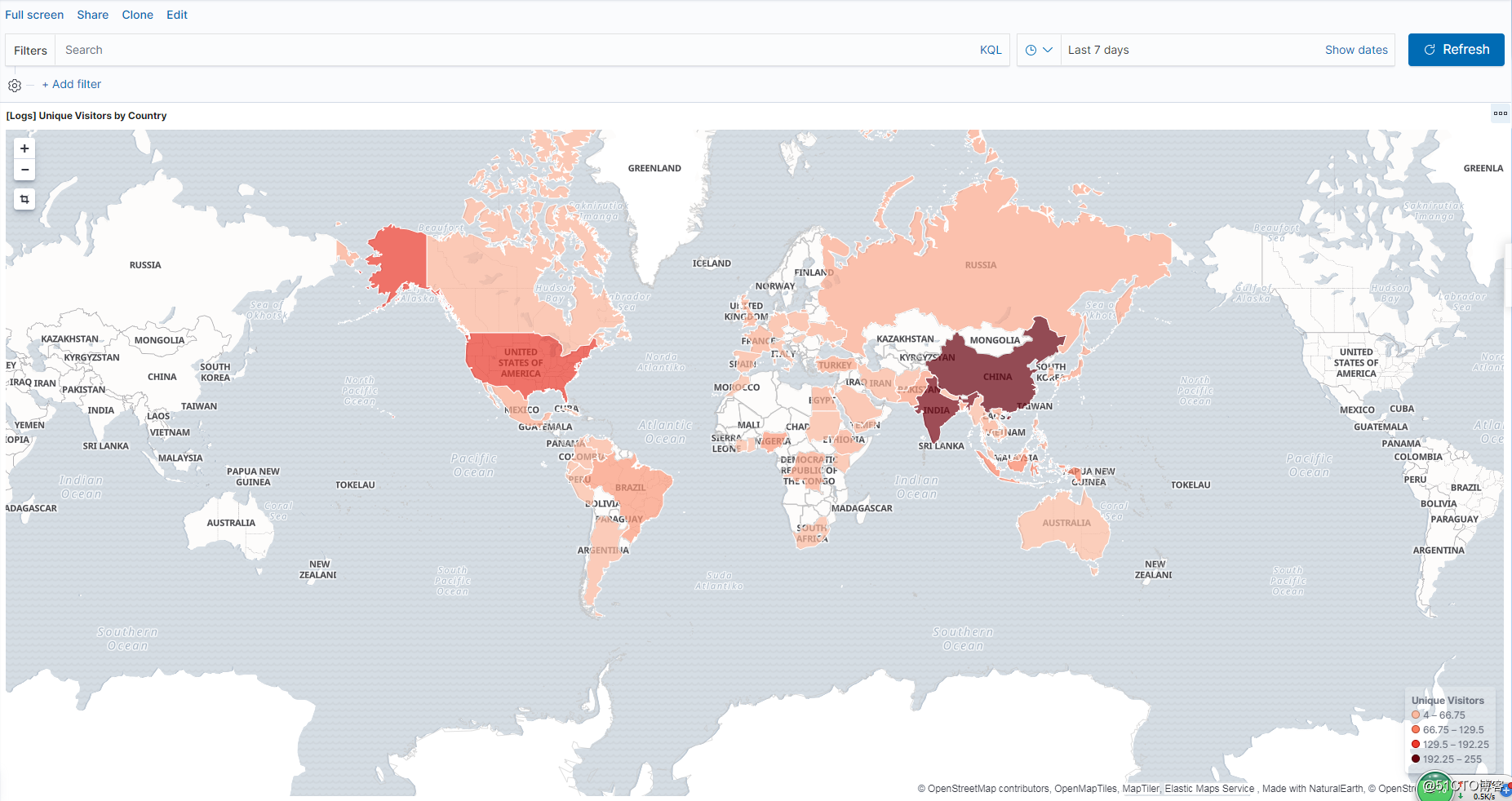

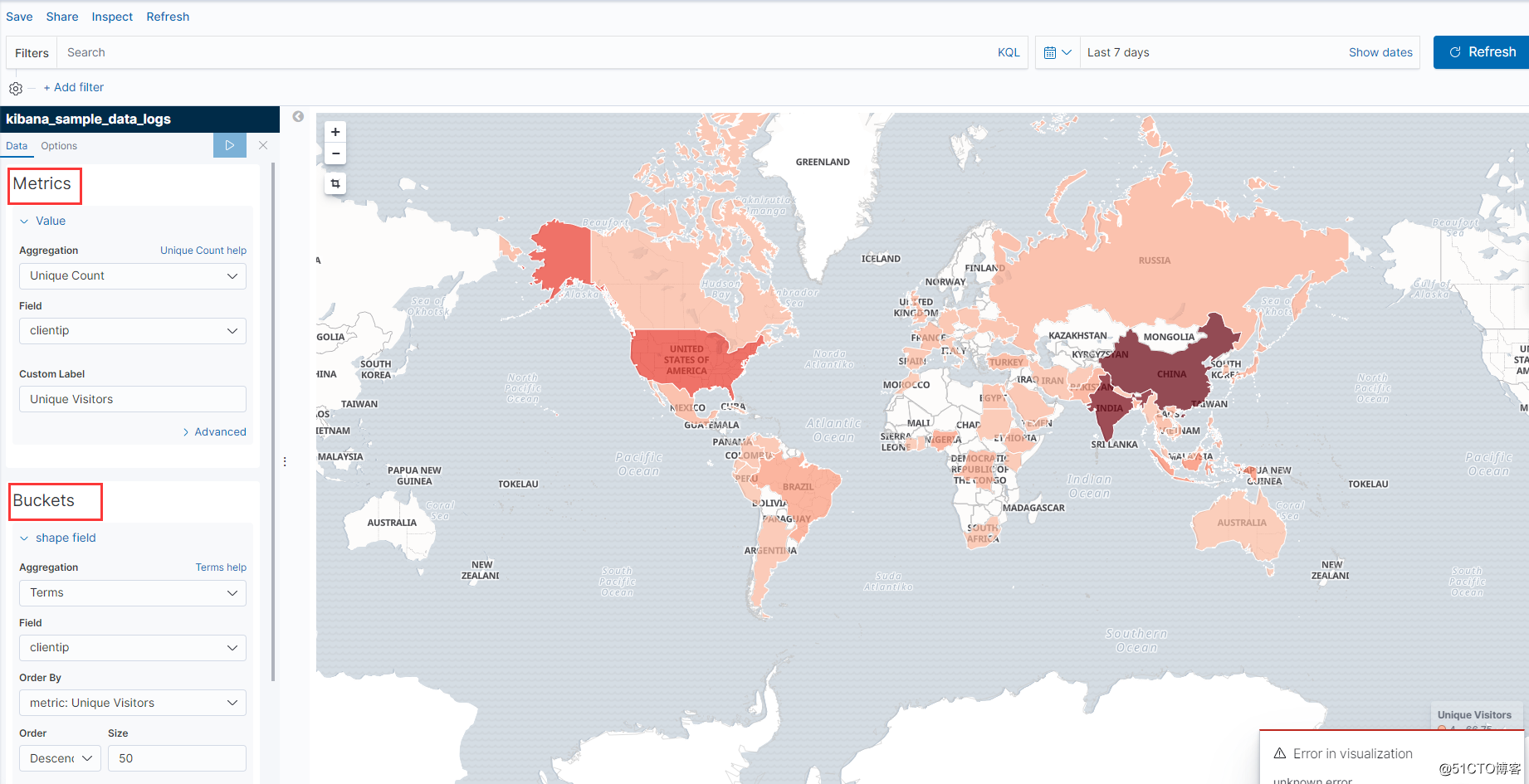

最终效果图如下:

GCE 部署 ELK 7.1可视化分析 nginx的更多相关文章

- Linux下单机部署ELK日志收集、分析环境

一.ELK简介 ELK是elastic 公司旗下三款产品ElasticSearch .Logstash .Kibana的首字母组合,主要用于日志收集.分析与报表展示. ELK Stack包含:Elas ...

- 使用Docker快速部署ELK分析Nginx日志实践(二)

Kibana汉化使用中文界面实践 一.背景 笔者在上一篇文章使用Docker快速部署ELK分析Nginx日志实践当中有提到如何快速搭建ELK分析Nginx日志,但是这只是第一步,后面还有很多仪表盘需要 ...

- 使用Docker快速部署ELK分析Nginx日志实践

原文:使用Docker快速部署ELK分析Nginx日志实践 一.背景 笔者所在项目组的项目由多个子项目所组成,每一个子项目都存在一定的日志,有时候想排查一些问题,需要到各个地方去查看,极为不方便,此前 ...

- elk平台分析nginx日志的基本搭建

一.elk套件介绍 ELK 由 ElasticSearch . Logstash 和 Kiabana 三个开源工具组成.官方网站: https://www.elastic.co/products El ...

- [原创]ubuntu14.04部署ELK+redis日志分析系统

ubuntu14.04部署ELK+redis日志分析系统 [环境] host1:172.17.0.4 搭建ELK+redis服务 host2:172.17.0.3 搭建logstash+nginx服务 ...

- 利用ELK分析Nginx日志生产实战(高清多图)

本文以api.mingongge.com.cn域名为测试对象进行统计,日志为crm.mingongge.com.cn和risk.mingongge.com.cn请求之和(此二者域名不具生产换环境统计意 ...

- 利用ELK分析Nginx日志

本文以api.mingongge.com.cn域名为测试对象进行统计,日志为crm.mingongge.com.cn和risk.mingongge.com.cn请求之和(此二者域名不具生产换环境统计意 ...

- 利用docker部署elk交换机日志分析

今天我们来聊一下利用docker部署elk日志分析系统,这里解析一下elk是啥东西.elk分别是Elasticsearch,Logstash和Kibana的首字母缩写. Elasticsearch是一 ...

- elk收集分析nginx access日志

elk收集分析nginx access日志 首先elk的搭建按照这篇文章使用elk+redis搭建nginx日志分析平台说的,使用redis的push和pop做队列,然后有个logstash_inde ...

随机推荐

- Java 基础 - Collection集合通用方法及操作/ArrayList和LinkedList的差别优势 /弃用的Vector

Collection的笔记: /**存储对象考虑使用: * 1.数组, ①一旦创建,其长度不可变!② 长度难于应对实际情况 * 2.Java集合, ①Collection集合: 1.set: 元素无序 ...

- vs调试 iis发布之后的项目

方法一 启动vs 访问iis地址 即可调试 方法二 点击调试, 选择附加到进程 选择所有用户进程, 选择w3wp.exe ,附加 , 即可调试

- P2634 [国家集训队]聪聪可可 点分治

思路:点分治 提交:1次 题解: 不需要什么容斥...接着板子题说: 还是基本思路:对于一颗子树,与之前的子树做贡献. 我们把路径的权值在\(\%3\)意义下分类,即开三个桶\(c[0],c[1],c ...

- 浏览器事件环(EventLoop)

1. 基础知识 1. js语言特点 1. js语言是单线程语言,主线程是单线程.如UI渲染,脚本加载是主线程任务. 2. js语言采用事件循环(EventLoop)机制. 2. 同步任务: 不被引擎挂 ...

- 路由器配置——DHCP+DHCP中继服务配置

一.实验目的:掌握DHCP服务基本配置及DHCP中继服务配置,实现全网互通 二.拓扑图: 三.具体步骤配置: (1)R1路由器配置: Router>enable --进入特权模式 Router ...

- strconv

导入strconv包 Append Format Parse 字符串转其他类型 parse返回两个值,一个转换值,一个err,没有错误时,err返回的是nil,有错误,err接受错误信息. 整型转字符 ...

- .pid文件

pid文件为进程文件,默认的在每个/var/run/目录下生成,当使用systemctl进行进程启动的时候,在这个目录下就会生成相应的pid文件,今天在进行poc测试的时候,对进程执行了enable操 ...

- 「CF484E」Sign on Fence「整体二分」「线段树」

题意 给定一个长度为\(n\)的正整数序列,第\(i\)个数为\(h_i\),\(m\)个询问,每次询问\((l, r, w)\),为\([l, r]\)所有长度为\(w\)的子区间最小值的最大值.( ...

- 异步时钟FIFO(一)

FIFO一般用于通过两个不同时钟域的数据传输.一个水池有进和出两个通道,由于进出口水流不一致所以需要水池加以缓冲.堆栈也是相当于水池的作用.如果输入端不是连续的数据流,可以通过堆栈来调节使数据以稳定的 ...

- tar 命令出现 Cowardly refusing to create an empty archive 问题详解

错误提示的字面意思是,系统惴惴不安地拒绝执行创建一个空压缩包的任务.检查tar命令的语法!!!参考:https://blog.csdn.net/deniro_li/article/details/54 ...