手把手教你Spring Boot2.x整合kafka

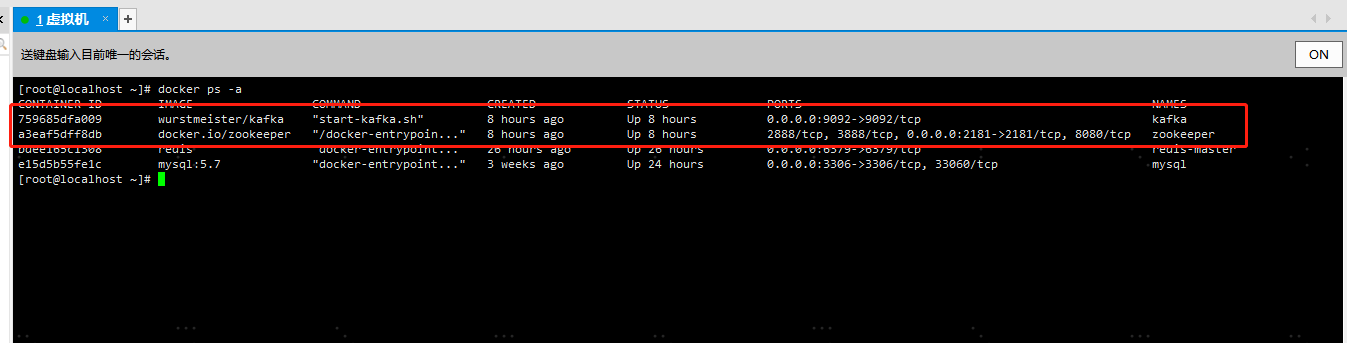

首先得自己搭建一个kafka,搭建教程请自行百度,本人是使用docker搭建了一个单机版的zookeeper+kafka作为演示,文末会有完整代码包提供给大家下载参考

废话不多说,教程开始

一、老规矩,先在pom.xml中添加kafka相关依赖

<dependency>

<groupId>org.springframework.kafka</groupId>

<artifactId>spring-kafka</artifactId>

</dependency>

二、在application.yml中添加相关配置

spring:

#kafka配置

kafka:

#这里改为你的kafka服务器ip和端口号

bootstrap-servers: 10.24.19.237:9092

#=============== producer =======================

producer:

#如果该值大于零时,表示启用重试失败的发送次数

retries: 0

#每当多个记录被发送到同一分区时,生产者将尝试将记录一起批量处理为更少的请求,默认值为16384(单位字节)

batch-size: 16384

#生产者可用于缓冲等待发送到服务器的记录的内存总字节数,默认值为3355443

buffer-memory: 33554432

#key的Serializer类,实现类实现了接口org.apache.kafka.common.serialization.Serializer

key-serializer: org.apache.kafka.common.serialization.StringSerializer

#value的Serializer类,实现类实现了接口org.apache.kafka.common.serialization.Serializer

value-serializer: org.apache.kafka.common.serialization.StringSerializer

#=============== consumer =======================

consumer:

#用于标识此使用者所属的使用者组的唯一字符串

group-id: test-consumer-group

#当Kafka中没有初始偏移量或者服务器上不再存在当前偏移量时该怎么办,默认值为latest,表示自动将偏移重置为最新的偏移量

#可选的值为latest, earliest, none

auto-offset-reset: earliest

#消费者的偏移量将在后台定期提交,默认值为true

enable-auto-commit: true

#如果'enable-auto-commit'为true,则消费者偏移自动提交给Kafka的频率(以毫秒为单位),默认值为5000。

auto-commit-interval: 100

#密钥的反序列化器类,实现类实现了接口org.apache.kafka.common.serialization.Deserializer

key-deserializer: org.apache.kafka.common.serialization.StringDeserializer

#值的反序列化器类,实现类实现了接口org.apache.kafka.common.serialization.Deserializer

value-deserializer: org.apache.kafka.common.serialization.StringDeserializer

三、添加操作kafka的工具类KafkaUtils.java(这里我只是简单的封装了一些方法,大家可以根据需要自行添加需要的方法)

package com.example.study.util;

import com.google.common.collect.Lists;

import org.apache.kafka.clients.admin.*;

import org.apache.kafka.common.TopicPartitionInfo;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.kafka.core.KafkaTemplate;

import org.springframework.stereotype.Component;

import javax.annotation.PostConstruct;

import java.util.Collection;

import java.util.HashMap;

import java.util.List;

import java.util.Map;

import java.util.concurrent.ExecutionException;

import java.util.concurrent.atomic.AtomicReference;

import java.util.stream.Collectors;

/**

* 操作kafka的工具类

*

* @author 154594742@qq.com

* @date 2021/3/2 14:52

*/

@Component

public class KafkaUtils {

@Value("${spring.kafka.bootstrap-servers}")

private String springKafkaBootstrapServers;

private AdminClient adminClient;

@Autowired

private KafkaTemplate kafkaTemplate;

/**

* 初始化AdminClient

* '@PostConstruct该注解被用来修饰一个非静态的void()方法。

* 被@PostConstruct修饰的方法会在服务器加载Servlet的时候运行,并且只会被服务器执行一次。

* PostConstruct在构造函数之后执行,init()方法之前执行。

*/

@PostConstruct

private void initAdminClient() {

Map<String, Object> props = new HashMap<>(1);

props.put(AdminClientConfig.BOOTSTRAP_SERVERS_CONFIG, springKafkaBootstrapServers);

adminClient = KafkaAdminClient.create(props);

}

/**

* 新增topic,支持批量

*/

public void createTopic(Collection<NewTopic> newTopics) {

adminClient.createTopics(newTopics);

}

/**

* 删除topic,支持批量

*/

public void deleteTopic(Collection<String> topics) {

adminClient.deleteTopics(topics);

}

/**

* 获取指定topic的信息

*/

public String getTopicInfo(Collection<String> topics) {

AtomicReference<String> info = new AtomicReference<>("");

try {

adminClient.describeTopics(topics).all().get().forEach((topic, description) -> {

for (TopicPartitionInfo partition : description.partitions()) {

info.set(info + partition.toString() + "\n");

}

});

} catch (InterruptedException | ExecutionException e) {

e.printStackTrace();

}

return info.get();

}

/**

* 获取全部topic

*/

public List<String> getAllTopic() {

try {

return adminClient.listTopics().listings().get().stream().map(TopicListing::name).collect(Collectors.toList());

} catch (InterruptedException | ExecutionException e) {

e.printStackTrace();

}

return Lists.newArrayList();

}

/**

* 往topic中发送消息

*/

public void sendMessage(String topic, String message) {

kafkaTemplate.send(topic, message);

}

}

四、添加KafkaController.java作为kafka的demo类

package com.example.study.controller;

import com.example.study.model.vo.ResponseVo;

import com.example.study.util.BuildResponseUtils;

import com.example.study.util.KafkaUtils;

import com.google.common.collect.Lists;

import io.swagger.annotations.Api;

import io.swagger.annotations.ApiOperation;

import lombok.extern.slf4j.Slf4j;

import org.apache.kafka.clients.admin.NewTopic;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.kafka.annotation.KafkaListener;

import org.springframework.web.bind.annotation.*;

import java.util.List;

/**

* kafka控制器

*

* @author 154594742@qq.com

* @date 2021/3/2 15:01

*/

@RestController

@Api(tags = "Kafka控制器")

@Slf4j

public class KafkaController {

@Autowired

private KafkaUtils kafkaUtils;

/**

* 新增topic (支持批量,这里就单个作为演示)

*

* @param topic topic

* @return ResponseVo

*/

@ApiOperation("新增topic")

@PostMapping("kafka")

public ResponseVo<?> add(String topic) {

NewTopic newTopic = new NewTopic(topic, 3, (short) 1);

kafkaUtils.createTopic(Lists.newArrayList(newTopic));

return BuildResponseUtils.success();

}

/**

* 查询topic信息 (支持批量,这里就单个作为演示)

*

* @param topic 自增主键

* @return ResponseVo

*/

@ApiOperation("查询topic信息")

@GetMapping("kafka/{topic}")

public ResponseVo<String> getBytTopic(@PathVariable String topic) {

return BuildResponseUtils.buildResponse(kafkaUtils.getTopicInfo(Lists.newArrayList(topic)));

}

/**

* 删除topic (支持批量,这里就单个作为演示)

* (注意:如果topic正在被监听会给人感觉删除不掉(但其实是删除掉后又会被创建))

*

* @param topic topic

* @return ResponseVo

*/

@ApiOperation("删除topic")

@DeleteMapping("kafka/{topic}")

public ResponseVo<?> delete(@PathVariable String topic) {

kafkaUtils.deleteTopic(Lists.newArrayList(topic));

return BuildResponseUtils.success();

}

/**

* 查询所有topic

*

* @return ResponseVo

*/

@ApiOperation("查询所有topic")

@GetMapping("kafka/allTopic")

public ResponseVo<List<String>> getAllTopic() {

return BuildResponseUtils.buildResponse(kafkaUtils.getAllTopic());

}

/**

* 生产者往topic中发送消息demo

*

* @param topic

* @param message

* @return

*/

@ApiOperation("往topic发送消息")

@PostMapping("kafka/message")

public ResponseVo<?> sendMessage(String topic, String message) {

kafkaUtils.sendMessage(topic, message);

return BuildResponseUtils.success();

}

/**

* 消费者示例demo

* <p>

* 基于注解监听多个topic,消费topic中消息

* (注意:如果监听的topic不存在则会自动创建)

*/

@KafkaListener(topics = {"topic1", "topic2", "topic3"})

public void consume(String message) {

log.info("receive msg: " + message);

}

}

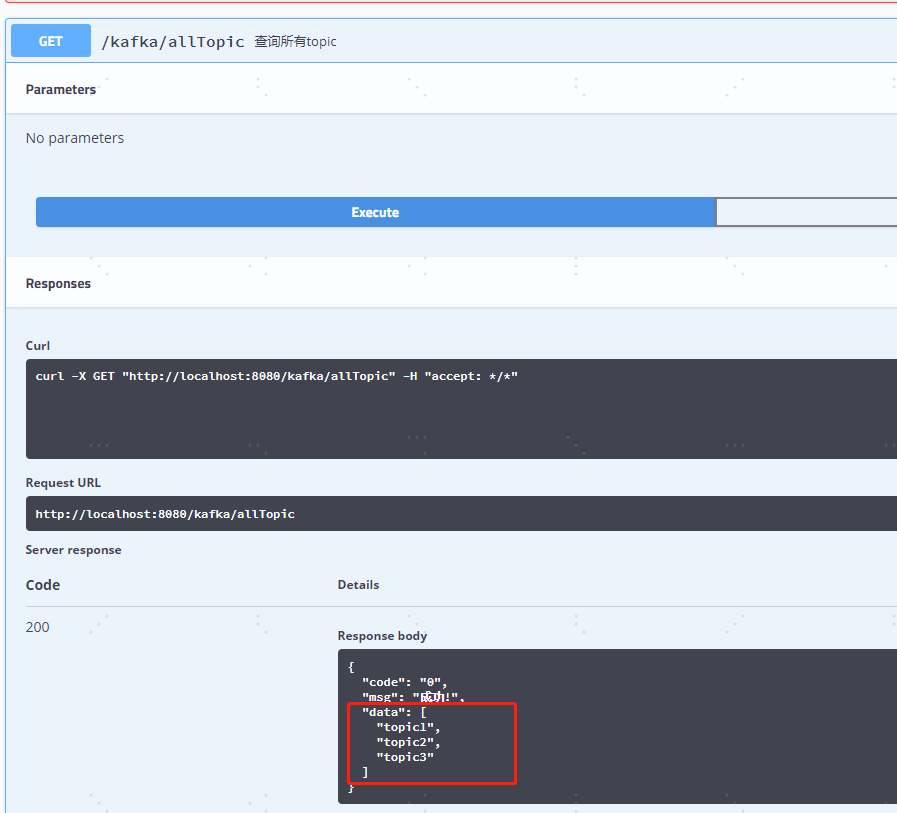

五、运行项目,然后访问 http://localhost:8080/swagger-ui.html 测试一下效果吧

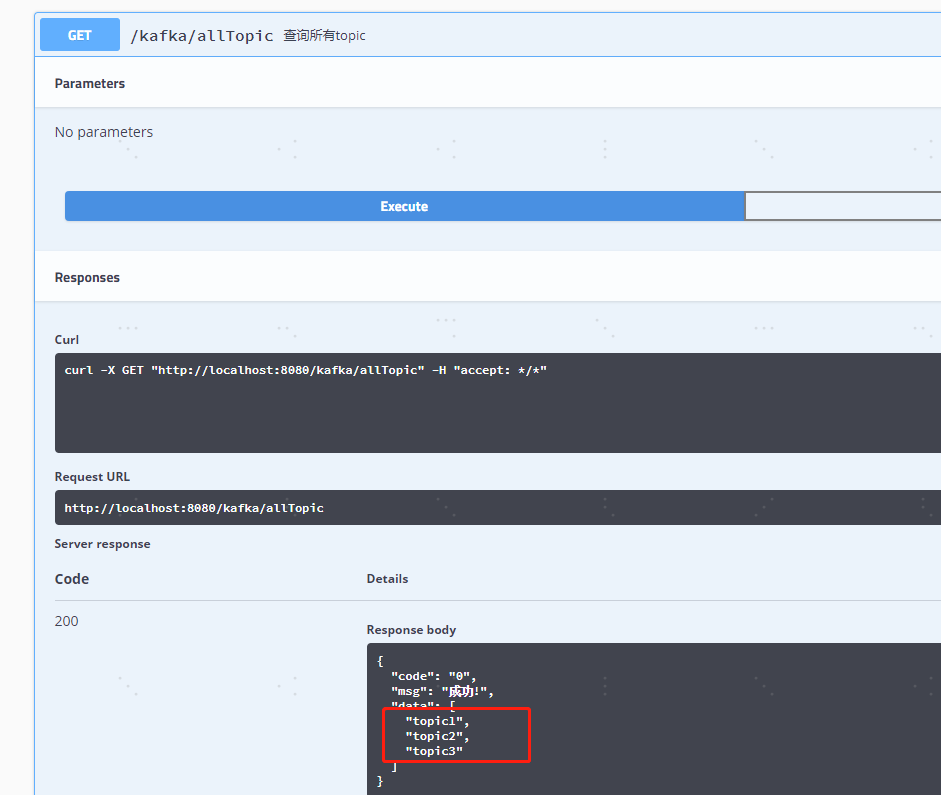

这三个topic本来是不存在的,这里是由@KafkaListener注解方式监听时自动创建的

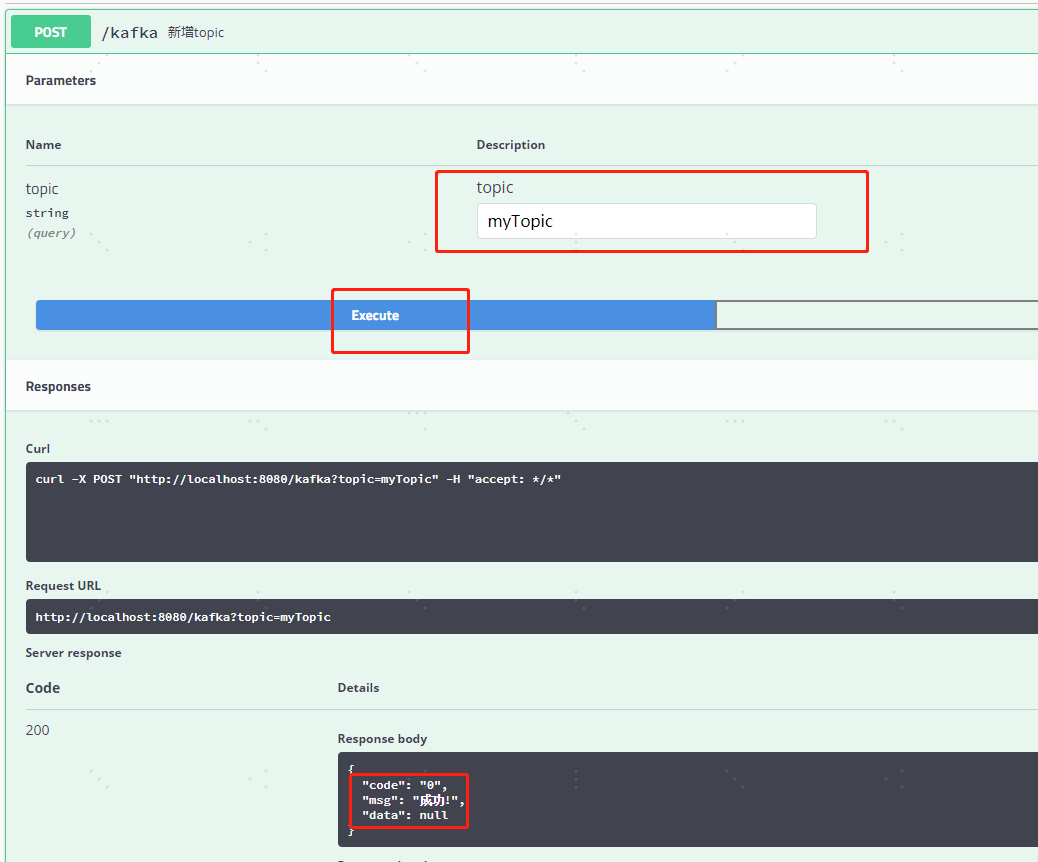

1、我们来新增一个名为‘myTopic’的topic试试

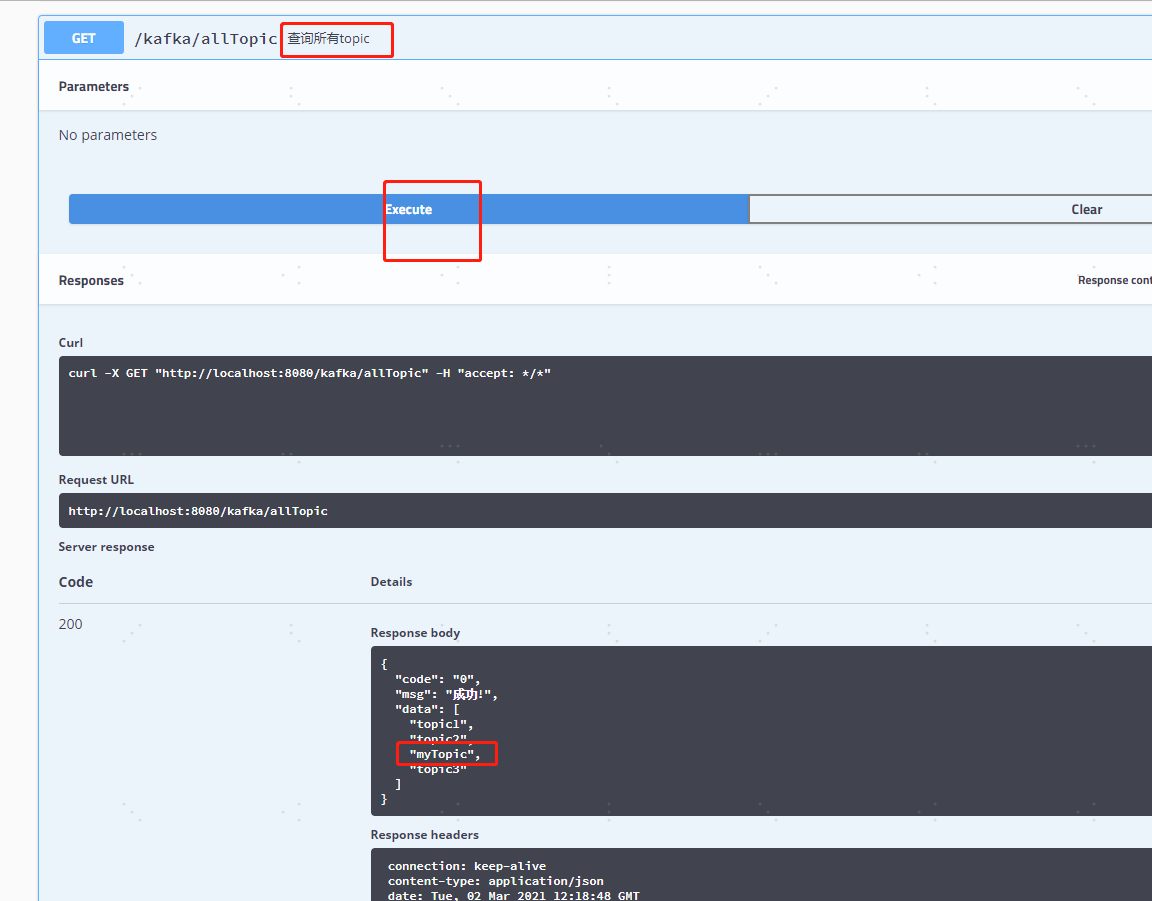

2、再重新查询一下所有的topic发现我们新增topic成功了

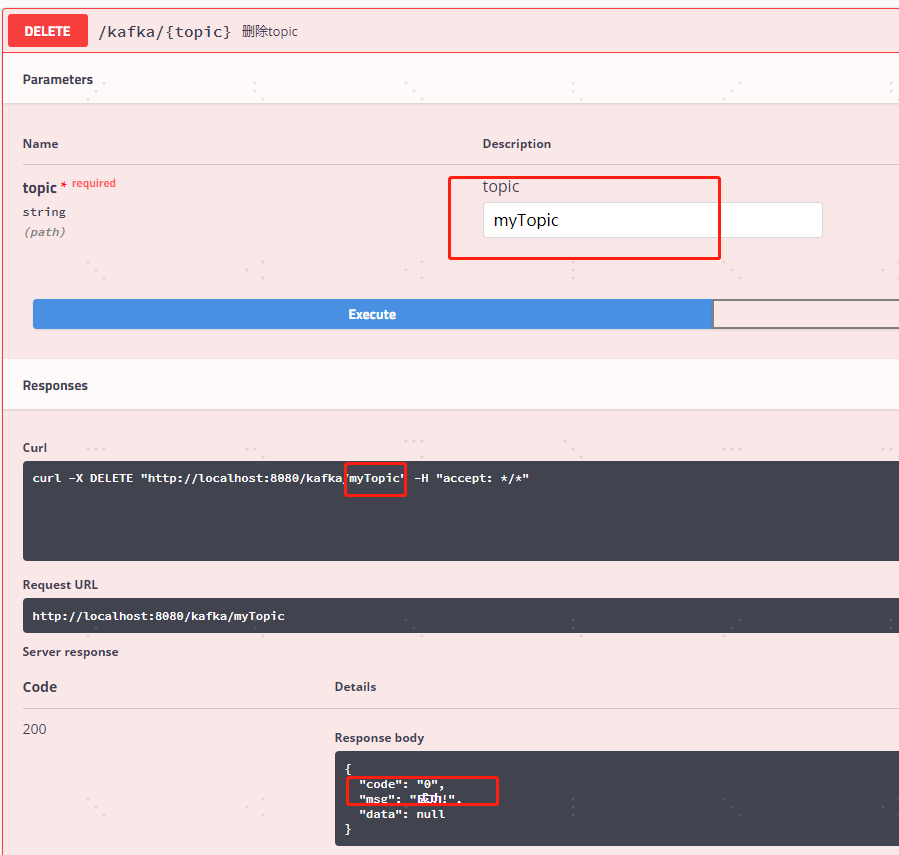

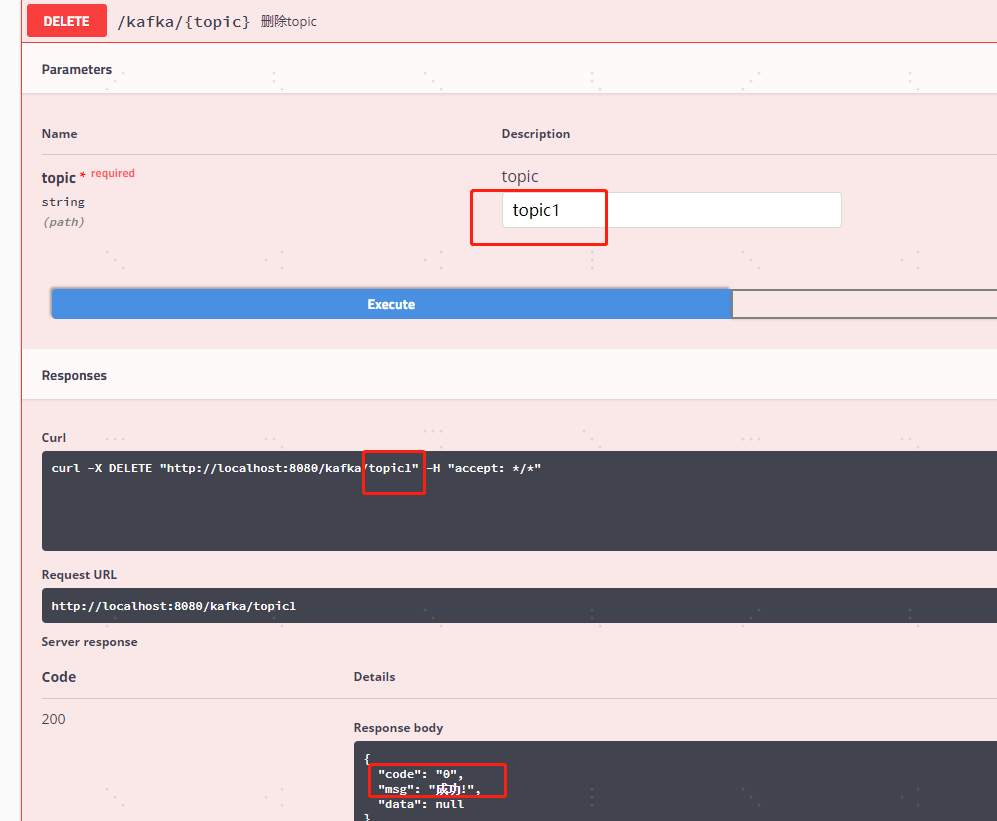

3、接下来我们试试删除一下myTopic和由@KafkaListener注解方式监听时自动创建的topic1

4、我们再查询一下所有的topic发现‘myTopic’被删除掉了,但是‘topic1’并没有被删除掉,原因就是因为‘topic1’正在被监听,删除掉后又会被自动创建,正如我代码的注释中的说明一样

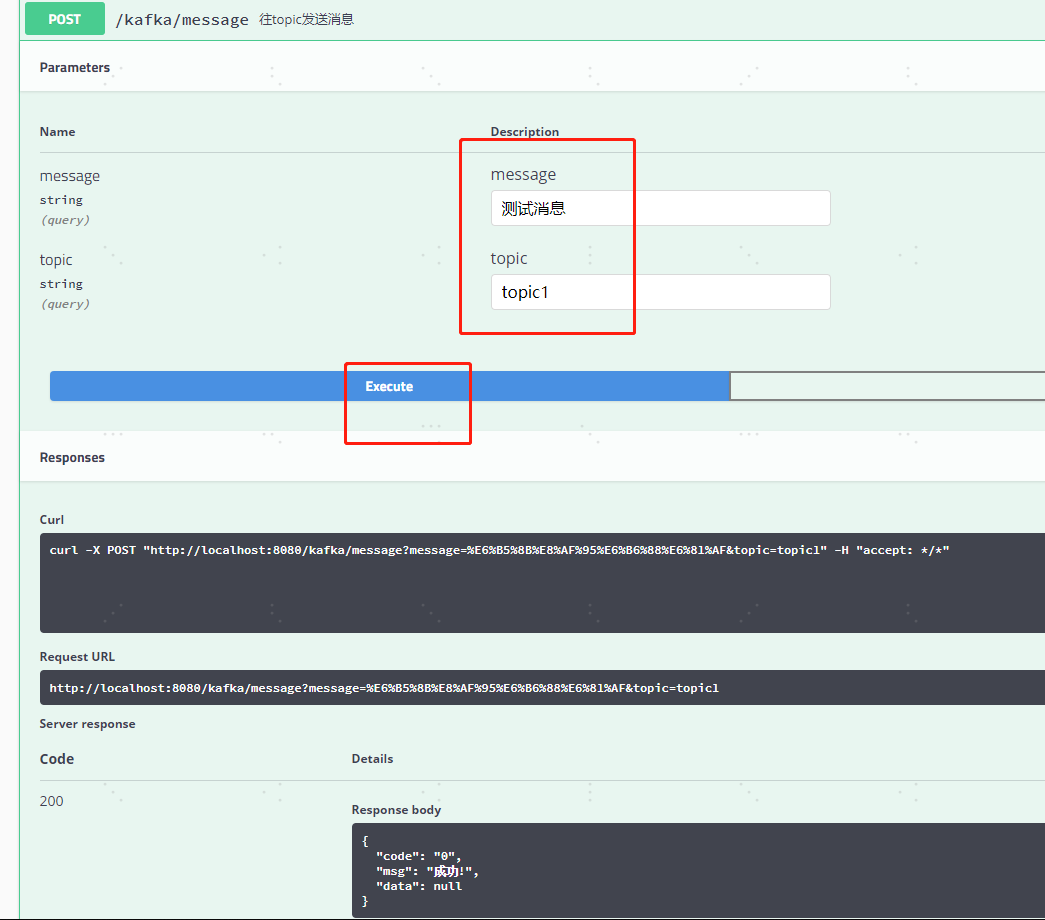

六、我们来试试我们最关心也是最常用的功能,作为生产者发送消息到topic以及作为消费者消费topic中的消息

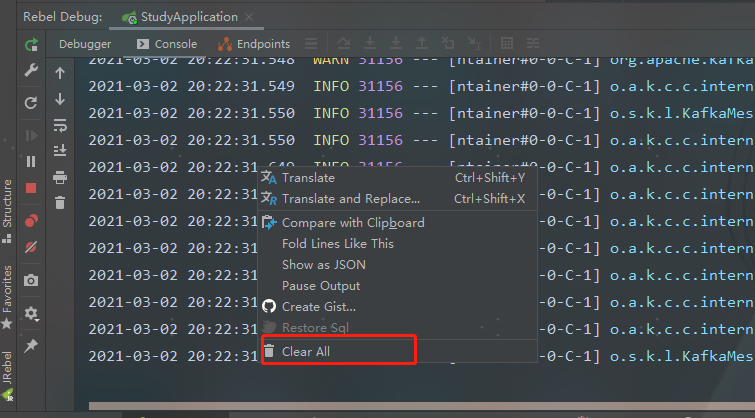

1、我们先把控制台的日志先清除一下方便待会儿查看效果

2、我们往正在被监听的"topic1"、"topic2"、"topic3"中的任意一个发送测试消息

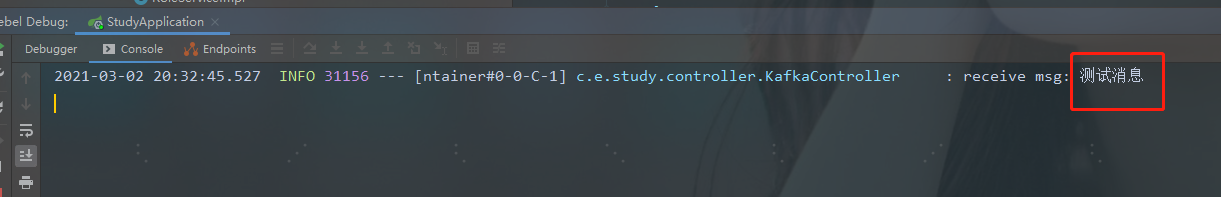

3、查看IDEA控制台发现topic中的消息被监听消费到了,大功告成

附上完整代码包供大家学习参考,如果对你有帮助,请给个关注或者点个赞吧! 点击下载完整代码包

手把手教你Spring Boot2.x整合kafka的更多相关文章

- 手把手教你Spring Boot2.x整合Elasticsearch(ES)

文末会附上完整的代码包供大家下载参考,码字不易,如果对你有帮助请给个点赞和关注,谢谢! 如果只是想看java对于Elasticsearch的操作可以直接看第四大点 一.docker部署Elastics ...

- Spring Boot2.0 整合 Kafka

Kafka 概述 Apache Kafka 是一个分布式流处理平台,用于构建实时的数据管道和流式的应用.它可以让你发布和订阅流式的记录,可以储存流式的记录,并且有较好的容错性,可以在流式记录产生时就进 ...

- 手把手教你Spring Boot整合Mybatis Plus和Swagger2

前言:如果你是初学者,请完全按照我的教程以及代码来搭建(文末会附上完整的项目代码包,你可以直接下载我提供的完整项目代码包然后自行体验!),为了照顾初学者所以贴图比较多,请耐心跟着教程来,希望这个项目D ...

- 手把手教你Spring Boot整合Mybatis Plus 代码生成器

一.在pom.xml中添加所需依赖 <!-- MyBatis-Plus代码生成器--> <dependency> <groupId>com.baomidou< ...

- Spring Boot2.X整合消息中间件RabbitMQ原理简浅探析

目录 1.简单概述RabbitMQ重要作用 2.简单概述RabbitMQ重要概念 3.Spring Boot整合RabbitMQ 前言 RabbitMQ是一个消息队列,主要是用来实现应用程序的异步和解 ...

- 基于Redis的消息队列使用:spring boot2.0整合redis

一 . 引入依赖 <?xml version="1.0" encoding="UTF-8"?> <project xmlns="ht ...

- spring boot2 kafka

一.软件版本 1.linux:centos6 2.zookeeper:zookeeper-3.4.1 3.kafka:kafka_2.12-2.2.0 4.jdk:1.8 5.instelliJ Id ...

- 手把手教你使用IDEA2020创建SpringBoot项目

一.New Project 二.如图选择Spring Initalizr,选择jdk版本,然后点击Next(注意:SpringBoot2开始至少使用JDK1.8) 三.如图根据自己需要修改,然后点击N ...

- 手把手教你整合最优雅SSM框架:SpringMVC + Spring + MyBatis

在写代码之前我们先了解一下这三个框架分别是干什么的? 相信大以前也看过不少这些概念,我这就用大白话来讲,如果之前有了解过可以跳过这一大段,直接看代码! SpringMVC:它用于web层,相当于con ...

随机推荐

- hdu2852 KiKi's K-Number

Problem Description For the k-th number, we all should be very familiar with it. Of course,to kiki i ...

- 洛谷 P6851 onu (贪心,模拟)

题意:C和D打牌,每张牌有花色和点数,小D刚开始的分数为\(v\),不管输还是赢,只要小D出了牌(花色必须相同),就能得到那张牌点数的分数,若是赢了(点数不小于D的牌),他可以另外加\(c\)分,输了 ...

- 在程序中通过Process启动外部exe的方法及注意事项

启动外部进程的方法: /// <summary> /// 启动外部进程 /// </summary> /// <param name="path"&g ...

- 2.使用Helm构建ElasticSearch集群

作者 微信:tangy8080 电子邮箱:914661180@qq.com 更新时间:2019-05-24 16:08:53 星期五 欢迎您订阅和分享我的订阅号,订阅号内会不定期分享一些我自己学习过程 ...

- VMware虚拟化与Kubernetes(K8s)类比阐述-适合VMware用户

概述 容器技术是最近几年非常热门的技术,它似乎就是为云端的应用量身定制的,所以它也被贴上了云原生应用 (Cloud Native Application) 技术的标签.目前最为流行的容器管理调度平台是 ...

- Leetcode(884)-索引处的解码字符串

给定一个编码字符串 S.为了找出解码字符串并将其写入磁带,从编码字符串中每次读取一个字符,并采取以下步骤: 如果所读的字符是字母,则将该字母写在磁带上. 如果所读的字符是数字(例如 d),则整个当前磁 ...

- IGS OPC UA 配置

igs项目-右键属性-选择OPC UA,如图配置 ,其他默认 如果打开的是IGS-administration,在右下角会有通知栏图标,右键图标选择 OPC UA 配置 添加服务器节点,网络适配器选择 ...

- 在Python里,用股票案例讲描述性统计分析方法(内容来自我的书)

描述性统计是数学统计分析里的一种方法,通过这种统计方法,能分析出数据整体状况以及数据间的关联.在这部分里,将用股票数据为样本,以matplotlib类为可视化工具,讲述描述性统计里常用指标的计算方法和 ...

- js type automatic conversion

js type automatic conversion String & Number `255` < 16; false `15` < 16; true `25` < 1 ...

- wxPython 创建基本窗口

$ pip install wxPython import wx class MyFrame(wx.Frame): def __init__(self, parent, title): super(M ...