Spurious Local Minima are Common in Two-Layer ReLU Neural Networks

@article{safran2017spurious,

title={Spurious Local Minima are Common in Two-Layer ReLU Neural Networks},

author={Safran, Itay and Shamir, Ohad},

journal={arXiv: Learning},

year={2017}}

引

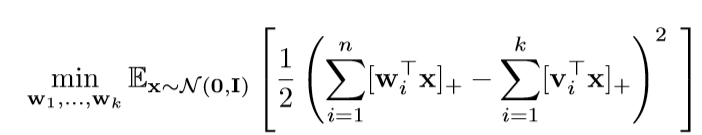

文章的论证部分让人头疼,仅在这里介绍一下主要内容. 这篇文章关注的是单个隐层, 激活函数为ReLU的神经网络, 且对输入数据有特殊的限制, 数据为:

\]

其中\(\mathbf{v}_i\)是给定的, 而\(\mathbf{x} \sim \mathcal{N}(\mathbf{0}, \mathbf{I})\). 而这篇文章考虑的是:

即, 这个损失函数是否具有局部最优解.

主要内容

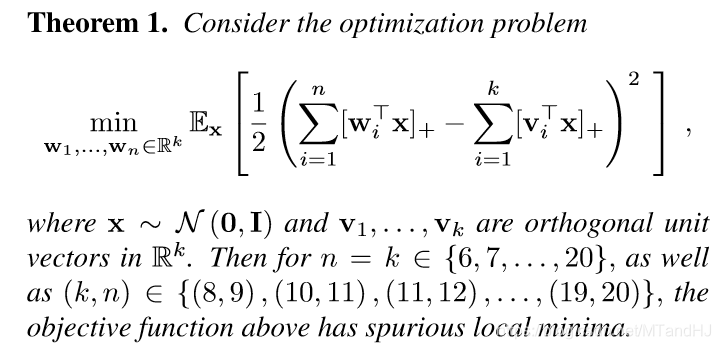

定理1

注意, \(\mathbf{v}_1, \mathbf{v}_2, \ldots, \mathbf{v}_k\)是正交的, 且\(n=k\). 这个时候,损失函数是有局部最优解的, 不过在后面作者提到, 如果\(n>k\), 即overparameter的情况, 这个情况是大大优化的, 甚至出现没有局部最优解(不过是通过实验说明的).

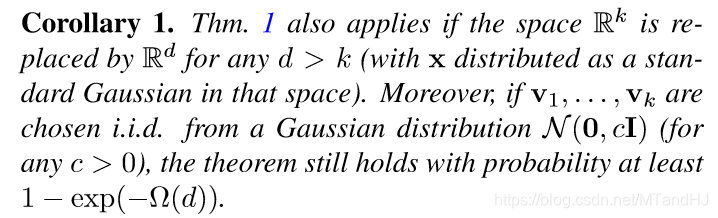

推论1

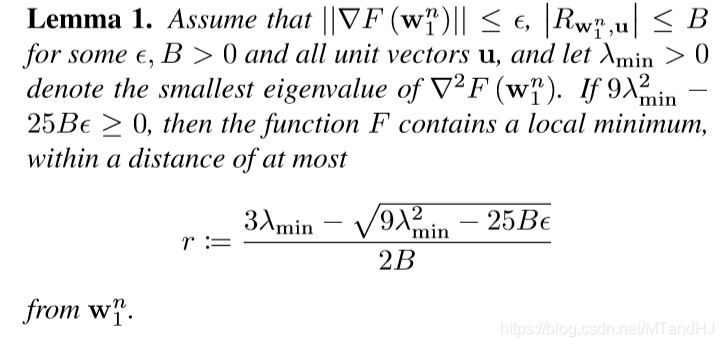

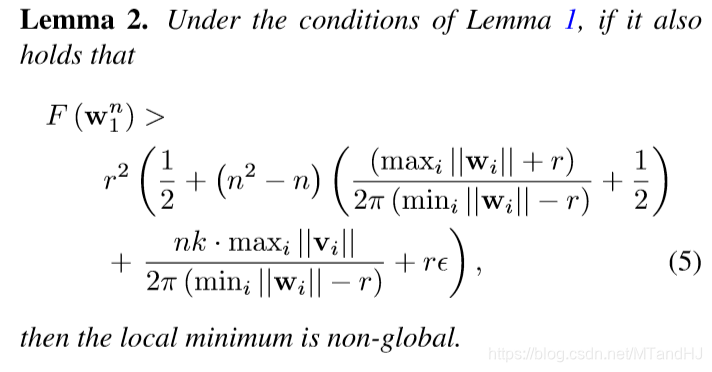

引理1 引理2

这部分有些符号没有给出, 如果感兴趣回看论文, 这俩个引理是用来说明, 如何在实验中, 通过一些指标来判断是否收敛到某个极值点了(当然, 这需要特别的计算机制来避免舍入误差带来的影响, 作者似乎是通过Matlab里的一个包实现的).

Spurious Local Minima are Common in Two-Layer ReLU Neural Networks的更多相关文章

- Learning local feature descriptors with triplets and shallow convolutional neural networks 论文阅读笔记

题目翻译:学习 local feature descriptors 使用 triplets 还有浅的卷积神经网络.读罢此文,只觉收获满满,同时另外印象最深的也是一个浅(文章中会提及)字. 1 Cont ...

- 缓存地图 ArcGIS ——Local compact and exploded tile cache layer for WPF API

ArcGISArcGIS 主页 特色 合约 图库 地图 组 帮助 我的内容 我的组织 登录 我的个人资料 帮助 管理员指南 登出 0 搜索全部内容 搜索地图 搜索图层 搜索应用程序 搜索工具 搜索 ...

- Deep Linear Networks with Arbitrary Loss: All Local Minima Are Global

目录 问题 假设和重要结果 证明 注 Laurent T, Von Brecht J H. Deep linear networks with arbitrary loss: All local mi ...

- Visualizing LSTM Layer with t-sne in Neural Networks

LSTM 可视化 Visualizing Layer Representations in Neural Networks Visualizing and interpreting represent ...

- Local Binary Convolutional Neural Networks ---卷积深度网络移植到嵌入式设备上?

前言:今天他给大家带来一篇发表在CVPR 2017上的文章. 原文:LBCNN 原文代码:https://github.com/juefeix/lbcnn.torch 本文主要内容:把局部二值与卷积神 ...

- 课程一(Neural Networks and Deep Learning),第三周(Shallow neural networks)—— 3.Programming Assignment : Planar data classification with a hidden layer

Planar data classification with a hidden layer Welcome to the second programming exercise of the dee ...

- 论文解读(LA-GNN)《Local Augmentation for Graph Neural Networks》

论文信息 论文标题:Local Augmentation for Graph Neural Networks论文作者:Songtao Liu, Hanze Dong, Lanqing Li, Ting ...

- 论文翻译:LP-3DCNN: Unveiling Local Phase in 3D Convolutional Neural Networks

引言 传统的3D卷积神经网络(CNN)计算成本高,内存密集,容易过度拟合,最重要的是,需要改进其特征学习能力.为了解决这些问题,我们提出了整流局部相位体积(ReLPV)模块,它是标准3D卷积层的有效替 ...

- Neural Networks and Deep Learning(week3)Planar data classification with one hidden layer(基于单隐藏层神经网络的平面数据分类)

Planar data classification with one hidden layer 你会学习到如何: 用单隐层实现一个二分类神经网络 使用一个非线性激励函数,如 tanh 计算交叉熵的损 ...

随机推荐

- 日常Java 2021/9/21

将Java数组中的元素前后反转.题目要求:已知一个数组arr = {11,12,13,14,15}用程序实现把该数组中的元素值交换,交换后的数组arr = { 15,14,13,12,11},并输出交 ...

- ubuntu18.10搜狗输入法的安装

记录一下 1.卸载ibus ubuntu默认使用ibus管理输入法,官方推荐使用fcitx.我们先卸载ibus sudo apt-get remove ibus 清除ibus配置,如果没有设置 sud ...

- 【leetcode】 450. Delete Node in a BST

Given a root node reference of a BST and a key, delete the node with the given key in the BST. Retur ...

- 【STM32】使用SDIO进行SD卡读写,包含文件管理FatFs(五)-文件管理初步介绍

其他链接 [STM32]使用SDIO进行SD卡读写,包含文件管理FatFs(一)-初步认识SD卡 [STM32]使用SDIO进行SD卡读写,包含文件管理FatFs(二)-了解SD总线,命令的相关介绍 ...

- 银联acp手机支付总结

总结: 1.手机调用后台服务端接口,获取银联返回的流水号tn 银联支付是请求后台,后台向银联下单,返回交易流水号,然后返回给用户,用户通过这个交易流水号,向银联发送请求,获取订单信息,然后再填写银行卡 ...

- spring整合mybatis和springmvc的配置概图

- 【JAVA今法修真】 第三章 关系非关系 redis法器

您好,我是南橘,万法仙门的掌门,刚刚从九州世界穿越到地球,因为时空乱流的影响导致我的法力全失,现在不得不通过这个平台向广大修真天才们借去力量.你们的每一个点赞,每一个关注都是让我回到九州世界的助力,兄 ...

- pipeline 共享库

目录 一.简介 二.共享库扩展 共享库使用 共享库结构 pipeline模板 一些小问题 三.共享库例子 使用公共变量 使用共享库的src方法 使用共享库的vars方法 四.插件实现pipeline ...

- typescript接口---interface

假如我现在需要批量生产一批对象,这些对象有相同的属性,并且对应属性值的数据类型一致.该怎么去做? 在ts中,因为要检验数据类型,所以必须对每个变量进行规范,自然也提供了一种批量规范的功能.这个功能就是 ...

- 任务信息的高级选项(Project)

<Project2016 企业项目管理实践>张会斌 董方好 编著 张同学说,[高级]选项卡很重要,嗯,本妖深以为然! 这里的[高级]选项卡,是指[任务信息]里的,在默认视图下,只要双击某任 ...