python 爬虫入门案例----爬取某站上海租房图片

前言

对于一个net开发这爬虫真真的以前没有写过。这段时间开始学习python爬虫,今天周末无聊写了一段代码爬取上海租房图片,其实很简短就是利用爬虫的第三方库Requests与BeautifulSoup。python 版本:python3.6 ,IDE :pycharm。其实就几行代码,但希望没有开发基础的人也能一下子看明白,所以大神请绕行。

第三方库

首先安装

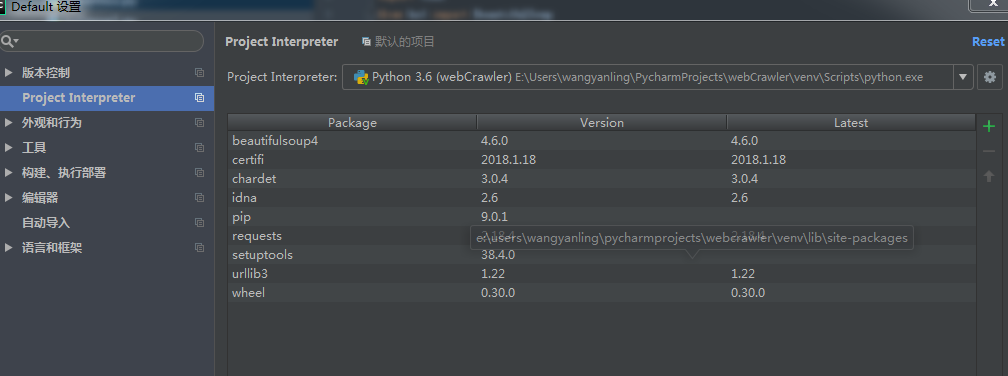

我是用的pycharm所以另为的脚本安装我这就不介绍了。

如上图打开默认设置选择Project Interprecter,双击pip或者点击加号,搜索要安装的第三方库。其中如果建立的项目多记得Project Interprecter要选择正确的安装位置不然无法导入。

Requests库

requests库的官方定义:Requests 唯一的一个非转基因的 Python HTTP 库,人类可以安全享用。其实他就是请求网络获取网页数据的。

import requests

header={'User-Agent':'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/55.0.2883.87 Safari/537.36'}

res=requests.get('http://sh.58.com/zufang/',headers=header)

try:

print(res.text);

except ConnectionError:

print('访问被拒绝!!!')

结果如下:

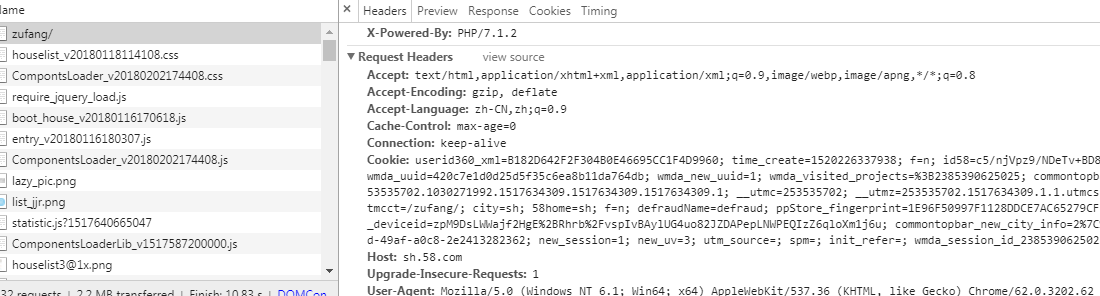

其中Request Headers的参数如下:

#headers的一些属性: #Accept:指定客户端能够接收的内容类型,内容类型的先后次序表示客户都接收的先后次序 #Accept-Lanuage:指定HTTP客户端浏览器用来展示返回信息优先选择的语言 #Accept-Encoding指定客户端浏览器可以支持的web服务器返回内容压缩编码类型。表示允许服务器在将输出内容发送到客户端以前进行压缩,以节约带宽。而这里设置的就是客户端浏览器所能够支持的返回压缩格式。 #Accept-Charset:HTTP客户端浏览器可以接受的字符编码集 # User-Agent : 有些服务器或 Proxy 会通过该值来判断是否是浏览器发出的请求 # Content-Type : 在使用 REST 接口时,服务器会检查该值,用来确定 HTTP Body 中的内容该怎样解析。 # application/xml : 在 XML RPC,如 RESTful/SOAP 调用时使用 # application/json : 在 JSON RPC 调用时使用 # application/x-www-form-urlencoded : 浏览器提交 Web 表单时使用 # 在使用服务器提供的 RESTful 或 SOAP 服务时, Content-Type 设置错误会导致服务器拒绝服务

BeautifulSoup库

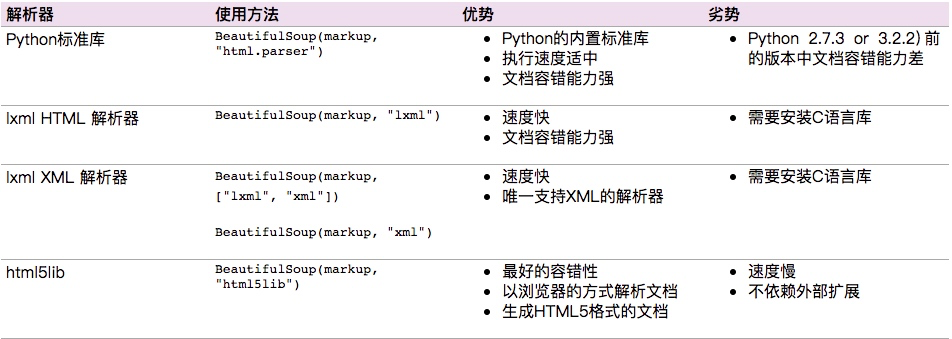

BeautifulSoup可以轻松的解析Requests库请求的页面,并把页面源代码解析为Soup文档,一边过滤提取数据。这是bs4.2的文档。

Beautiful Soup支持Python标准库中的HTML解析器,还支持一些第三方的解析器,如果我们不安装它,则 Python 会使用 Python默认的解析器,其中lxml 据说是相对而言比较强大的我下面的暗示是python 标准库的。

选择器select

# 选择所有div标签

soup.select("div")

# 选择所有p标签中的第三个标签

soup.select("p:nth-of-type(3)")

相当于soup.select(p)[2]

# 选择div标签下的所有img标签

soup.select("div img")

# 选择div标签下的直接a子标签

soup.select("div > a")

# 选择id=link1后的所有兄弟节点标签

soup.select("#link1 ~ .mybro")

# 选择id=link1后的下一个兄弟节点标签

soup.select("#link1 + .mybro")

# 选择a标签,其类属性为className的标签

soup.select("a .className")

# 选择a标签,其id属性为idName的标签

soup.select("a #idName")

# 选择a标签,其属性中存在attrName的所有标签

soup.select("a[attrName]")

# 选择a标签,其属性href=http://wangyanling.com的所有标签

soup.select("a[href='http://wangyanling.com']")

# 选择a标签,其href属性以http开头

soup.select('a[href^="http"]')

# 选择a标签,其href属性以lacie结尾

soup.select('a[href$="lacie"]')

# 选择a标签,其href属性包含.com

soup.select('a[href*=".com"]')

# 从html中排除某标签,此时soup中不再有script标签

[s.extract() for s in soup('script')]

# 如果想排除多个呢

[s.extract() for s in soup(['script','fram']

BeautifulSoup库需要学习的知识点,请参考bs4.2的文档。在这不再过多叙述。

import requests

from bs4 import BeautifulSoup

header={'User-Agent':'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/55.0.2883.87 Safari/537.36'}

res=requests.get('http://cd.58.com/zufang/',headers=header)

soup=BeautifulSoup(res.text,'html.parser')

print(soup.prettify())

案例:爬取上海租房图片

import requests

import urllib.request

import os

import time

from bs4 import BeautifulSoup

header={'User-Agent':'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/62.0.3202.62 Safari/537.36'}

url=['http://sh.58.com/zufang/pn{}/?ClickID=2'.format(number) for number in range(6,51)]#分页抓取

adminCout=6

for arurl in url:

adminCout=adminCout+1

res=requests.get(arurl,headers=header)

soup=BeautifulSoup(res.text,'html.parser')

arryImg=soup.select('.img_list img')

print(arryImg)

count = 0;

for img in arryImg:

print(img['lazy_src'])

_url = img['lazy_src']

pathName = "E:\\2333\\" + str(adminCout)+"_"+str(count) + ".jpg" # 设置路径和文件名

result = urllib.request.urlopen(_url) # 打开链接,和python2.x不同请注意了

data = result.read() # 否则开始下载到本地

with open(pathName, "wb") as code:

code.write(data)

code.close()

count = count + 1 # 计数+1

print("正在下载第:", count)

time.sleep(30)

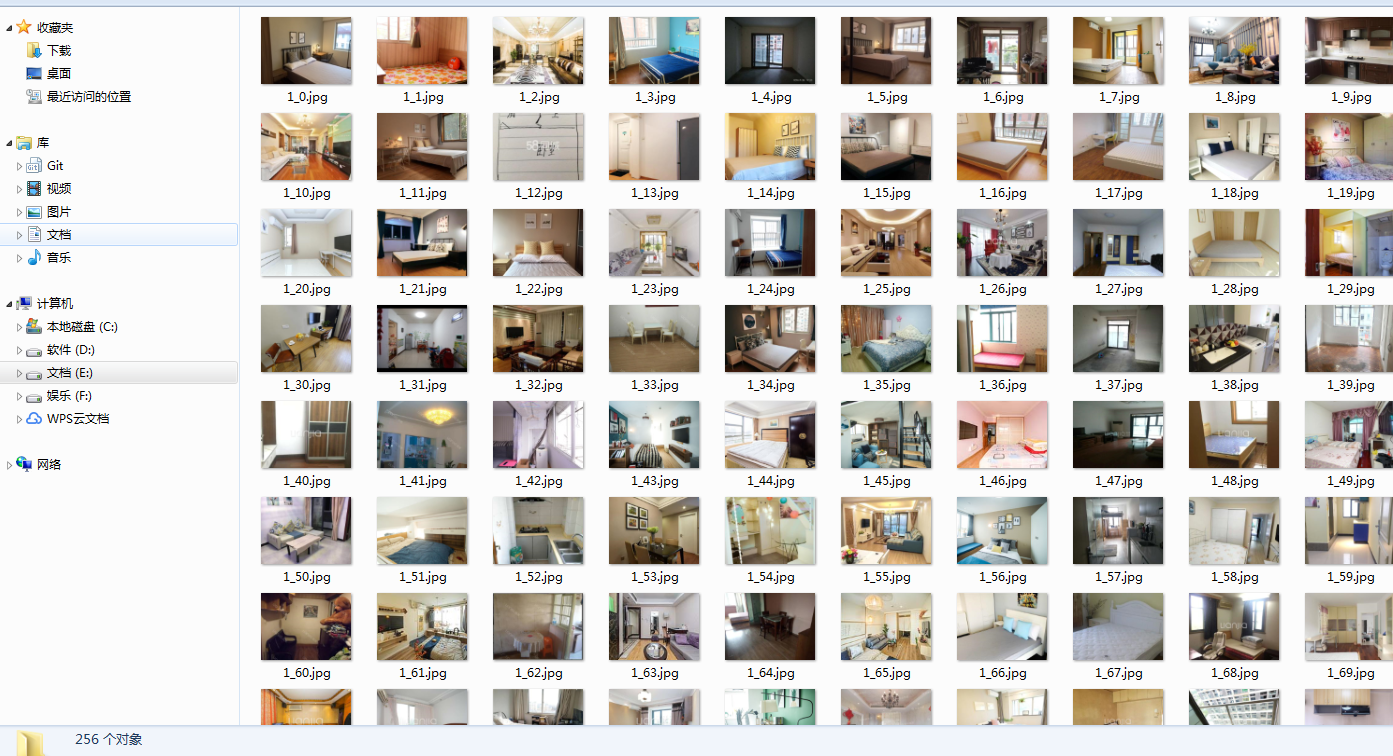

只是实现功能,至于代码结果如下:

结语:

对于python并非为了从net跳出来,学习python只是感兴趣,但是通过这段时间的学习确实有些思想从net的思路中跳了出来,接下来一年的业余时间应该都会花在学习python上,还希望自己能坚持下去。这应该是2017年最后一篇文章,在这给大家拜个早年。

python 爬虫入门案例----爬取某站上海租房图片的更多相关文章

- python 爬虫入门----案例爬取上海租房图片

前言 对于一个net开发这爬虫真真的以前没有写过.这段时间学习python爬虫,今天周末无聊写了一段代码爬取上海租房图片,其实很简短就是利用爬虫的第三方库Requests与BeautifulSoup. ...

- python爬取某站上海租房图片

前言 对于一个net开发这爬虫真真的以前没有写过.这段时间开始学习python爬虫,今天周末无聊写了一段代码爬取上海租房图片,其实很简短就是利用爬虫的第三方库Requests与BeautifulSou ...

- Python 爬虫入门之爬取妹子图

Python 爬虫入门之爬取妹子图 来源:李英杰 链接: https://segmentfault.com/a/1190000015798452 听说你写代码没动力?本文就给你动力,爬取妹子图.如果 ...

- Python爬虫实例:爬取B站《工作细胞》短评——异步加载信息的爬取

很多网页的信息都是通过异步加载的,本文就举例讨论下此类网页的抓取. <工作细胞>最近比较火,bilibili 上目前的短评已经有17000多条. 先看分析下页面 右边 li 标签中的就是短 ...

- Python 爬虫入门(二)——爬取妹子图

Python 爬虫入门 听说你写代码没动力?本文就给你动力,爬取妹子图.如果这也没动力那就没救了. GitHub 地址: https://github.com/injetlee/Python/blob ...

- Python 爬虫入门(一)——爬取糗百

爬取糗百内容 GitHub 代码地址https://github.com/injetlee/Python/blob/master/qiubai_crawer.py 微信公众号:[智能制造专栏],欢迎关 ...

- Python爬虫入门:爬取豆瓣电影TOP250

一个很简单的爬虫. 从这里学习的,解释的挺好的:https://xlzd.me/2015/12/16/python-crawler-03 分享写这个代码用到了的学习的链接: BeautifulSoup ...

- Python爬虫入门:爬取pixiv

终于想开始爬自己想爬的网站了.于是就试着爬P站试试手. 我爬的图的目标网址是: http://www.pixiv.net/search.php?word=%E5%9B%9B%E6%9C%88%E3%8 ...

- python 爬虫入门1 爬取代理服务器网址

刚学,只会一点正则,还只能爬1页..以后还会加入测试 #coding:utf-8 import urllib import urllib2 import re #抓取代理服务器地址 Key = 1 u ...

随机推荐

- .NET Core调用WCF的最佳实践

现在.NET Core貌似很火,与其他.NET开发者交流不说上几句.NET Core都感觉自己落伍了一样.但是冷静背后我们要也看到.NET Core目前还有太多不足,别的不多说,与自家的服务框架WCF ...

- 在.net中创建Access数据库

static void Main(string[] args) { //环境要求 //安装 access 2003, //引用com组件:Microsoft ADO Ext. 2.8 for DDL ...

- Dapper.Contrib.Extensions问题

Dapper.Contrib.Extensions问题 Dapper.Extension.1.0.0.1\lib\net45\Dapper.Extension.dll Dapper.Contrib.1 ...

- 加固apk的开发者最常面对的十种问题

欢迎访问网易云社区,了解更多网易技术产品运营经验. 因为工信部对移动App应用安全过检要求日益增多,不加固大都达不到工信部的要求,同时开发者加固App大都是为了防止以下10个检测项出现问题,影响App ...

- BZOJ 1801--中国象棋(DP)

1801: [Ahoi2009]chess 中国象棋 Time Limit: 10 Sec Memory Limit: 64 MBSubmit: 1995 Solved: 1160[Submit] ...

- robot framework学习笔记之三—Scalar变量

一.变量赋值 1)Set赋值 通常使用Set Variable关键字对变量进行赋值,其他Set相关的带Variable的关键字也可以进行赋值 赋值的时候,变量后面写不写『=』都可以,如下: 如果${v ...

- [CSS3] 3D桃心

<!DOCTYPE html> <html> <head> <meta charset="UTF-8"> <title> ...

- python 异步IO(syncio) 协程

python asyncio 网络模型有很多中,为了实现高并发也有很多方案,多线程,多进程.无论多线程和多进程,IO的调度更多取决于系统,而协程的方式,调度来自用户,用户可以在函数中yield一个状态 ...

- [Alpha]Scrum Meeting#7

github 本次会议项目由PM召开,时间为4月9日晚上10点30分 时长15分钟 任务表格 人员 昨日工作 下一步工作 木鬼 整理并发布之前因为清明耽误的博客 撰写每日例会报告 SiMrua 添加暂 ...

- BZOJ AC 300祭!