Python网络爬虫笔记(五):下载、分析京东P20销售数据

(一) 分析网页

下载下面这个链接的销售数据

https://item.jd.com/6733026.html#comment

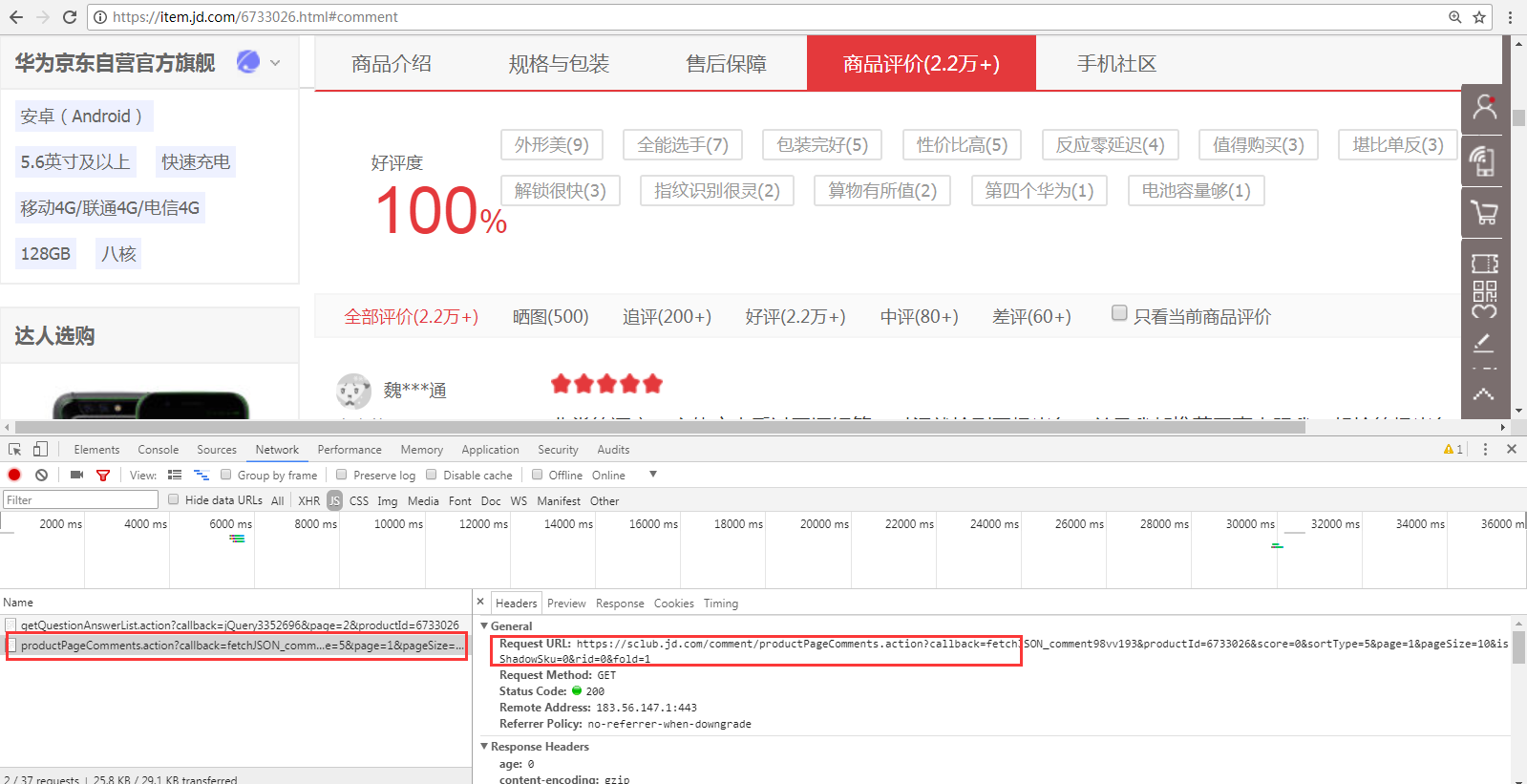

1、 翻页的时候,谷歌F12的Network页签可以看到下面的请求。(这里的翻页指商品评价中1、2、3页等)

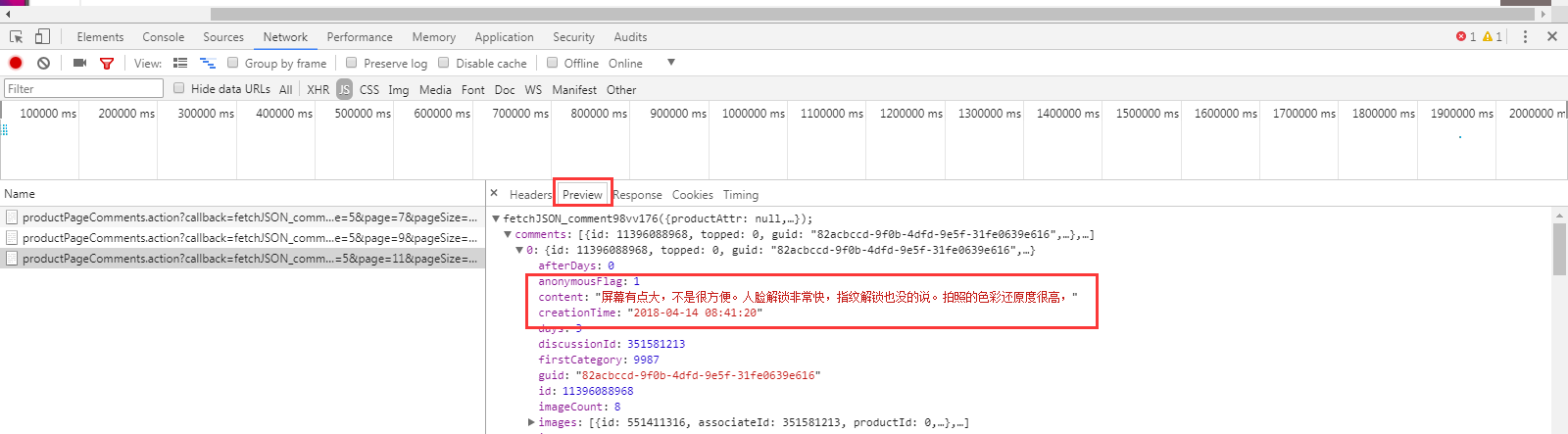

从Preview页签可以看出,这个请求是获取评论信息的

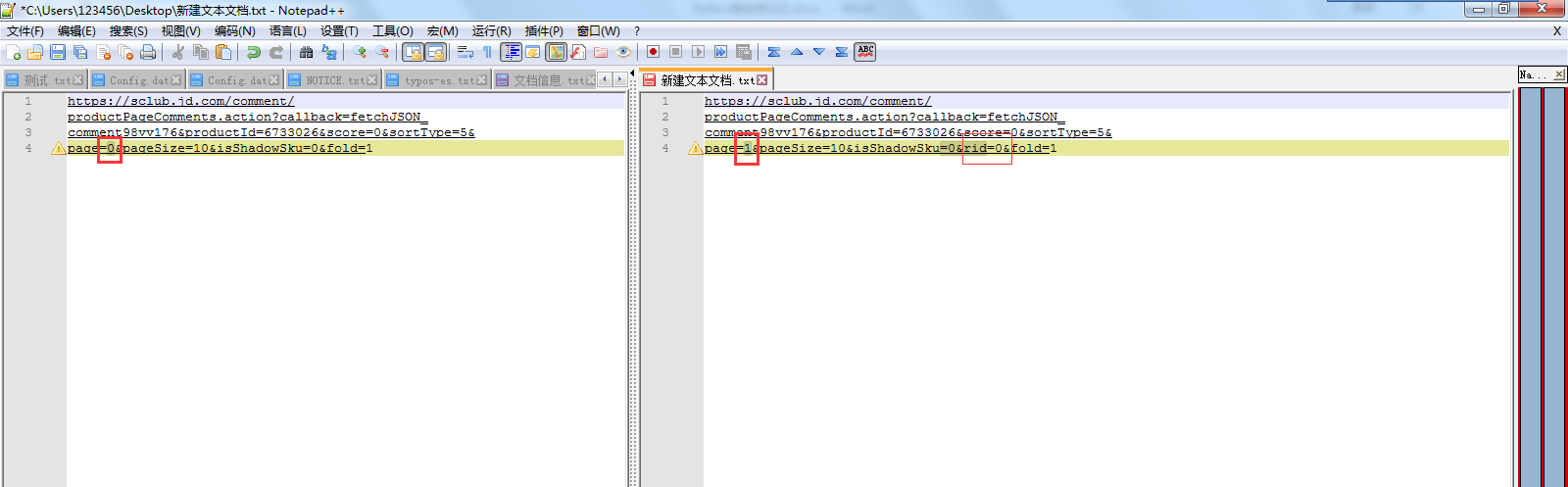

2、 对比第一页、第二页、第三页…请求URL的区别

可以发现 page=0、page=1,0和1指的应该是页数。

第一页的 request url:没有这个rid=0& 。 第二、三页…的request url:多了这个rid=0&

除了上面这2个地方,其他内容都是一样的。

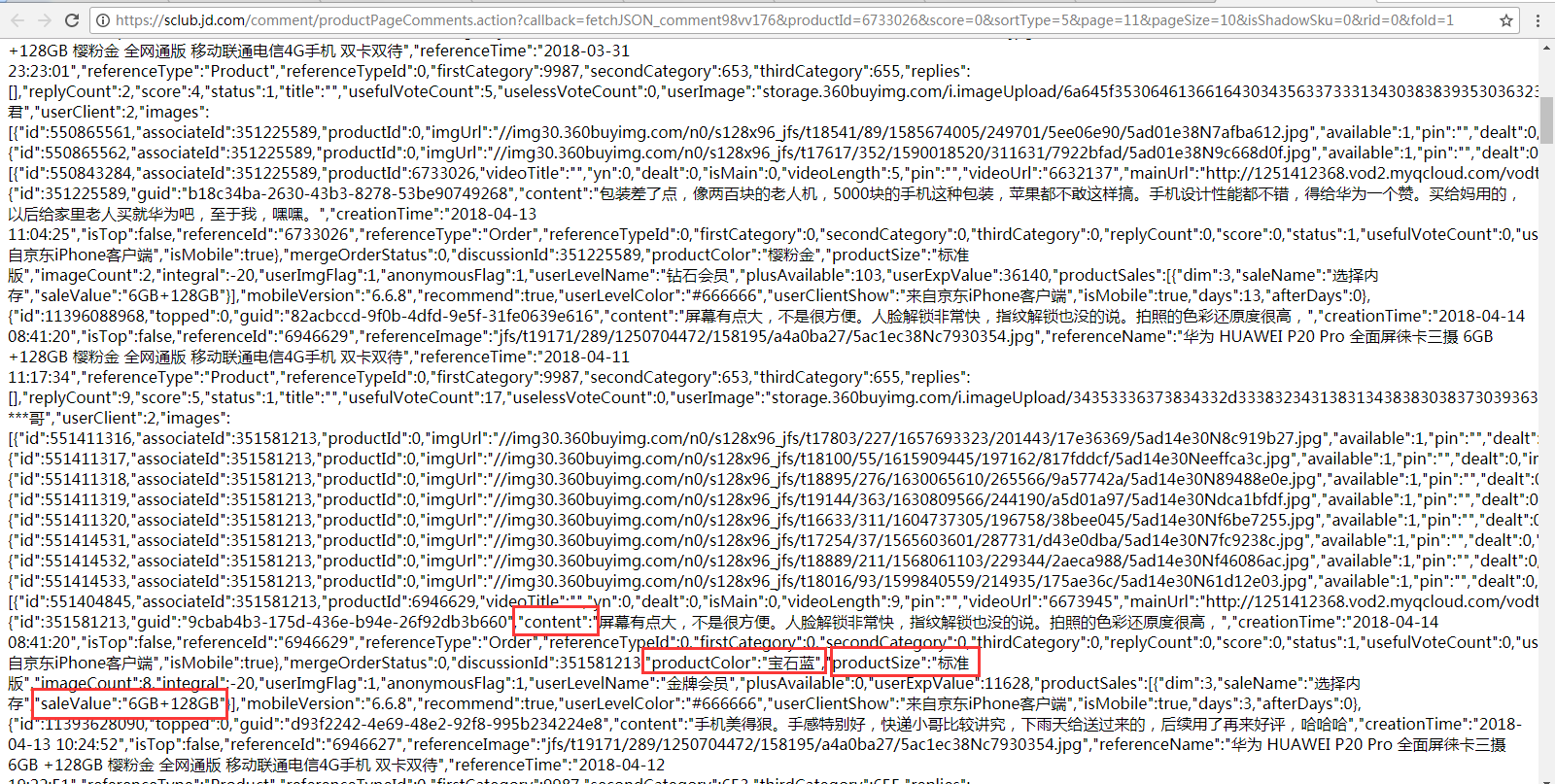

3、 直接在浏览器输入 复制出来的request url,可以看到评论、颜色、版本、内存信息,代码将根据这些信息来写正则表达式进行匹配。

(二) 实现代码

delayed.py的代码和我前面发的是一样的(Python网络爬虫笔记(二)),不限速的话把和这个模块相关的代码删除就行了

import urllib.request as ure

import urllib.parse

import openpyxl

import re

import os

from delayed import WaitFor

def download(url,user_agent='FireDrich',num=2,proxy=None):

print('下载:'+url)

#设置用户代理

headers = {'user_agent':user_agent}

request = ure.Request(url,headers=headers)

#支持代理

opener = ure.build_opener()

if proxy:

proxy_params = {urllib.parse.urlparse(url).scheme: proxy}

opener.add_handler(ure.ProxyHandler(proxy_params))

try:

#下载网页

# html = ure.urlopen(request).read()

html = opener.open(request).read()

except ure.URLError as e:

print('下载失败'+e.reason)

html=None

if num>0:

#遇到5XX错误时,递归调用自身重试下载,最多重复2次

if hasattr(e,'code') and 500<=e.code<600:

return download(url,num=num-1)

return html

def writeXls(sale_list):

#如果Excel不存在,创建Excel,否则直接打开已经存在文档

if 'P20销售情况.xlsx' not in os.listdir():

wb =openpyxl.Workbook()

else:

wb =openpyxl.load_workbook('P20销售情况.xlsx')

sheet = wb['Sheet']

sheet['A1'] = '颜色'

sheet['B1'] = '版本'

sheet['C1'] = '内存'

sheet['D1'] = '评论'

sheet['E1'] = '评论时间'

x = 2

#迭代所有销售信息(列表)

for s in sale_list:

#获取颜色等信息

content = s[0]

creationTime = s[1]

productColor = s[2]

productSize = s[3]

saleValue = s[4]

# 将颜色等信息添加到Excel

sheet['A' + str(x)] = productColor

sheet['B' + str(x)] = productSize

sheet['C' + str(x)] = saleValue

sheet['D' + str(x)] = content

sheet['E' + str(x)] = creationTime

x += 1

wb.save('P20销售情况.xlsx') page = 0

allSale =[]

waitFor = WaitFor(2)

#预编译匹配颜色、版本、内存等信息的正则表达式

regex = re.compile('"content":"(.*?)","creationTime":"(.*?)".*?"productColor":"(.*?)","productSize":"(.*?)".*?"saleValue":"(.*?)"')

#这里只下载20页数据,可以设置大一些(因为就算没评论信息,也能下载到一些标签信息等,所以可以if 正则没匹配的话就结束循环,当然,下面没处理这个)

while page<20:

if page==0:

url = 'https://sclub.jd.com/comment/productPageComments.action?callback=fetchJSON_comment98vv176&productId=6733026&score=0&sortType=5&page=' + str(page) + '&pageSize=10&isShadowSku=0&fold=1'

else:

url = 'https://sclub.jd.com/comment/productPageComments.action?callback=fetchJSON_comment98vv176&productId=6733026&score=0&sortType=5&page=' + str(page) + '&pageSize=10&isShadowSku=0&rid=0&fold=1'

waitFor.wait(url)

html = download(url)

html = html.decode('GBK')

#以列表形式返回颜色、版本、内存等信息

sale = regex.findall(html)

#将颜色、版本、内存等信息添加到allSale中(扩展allSale列表)

allSale.extend(sale)

page += 1 writeXls(allSale)

(三) 数据分析

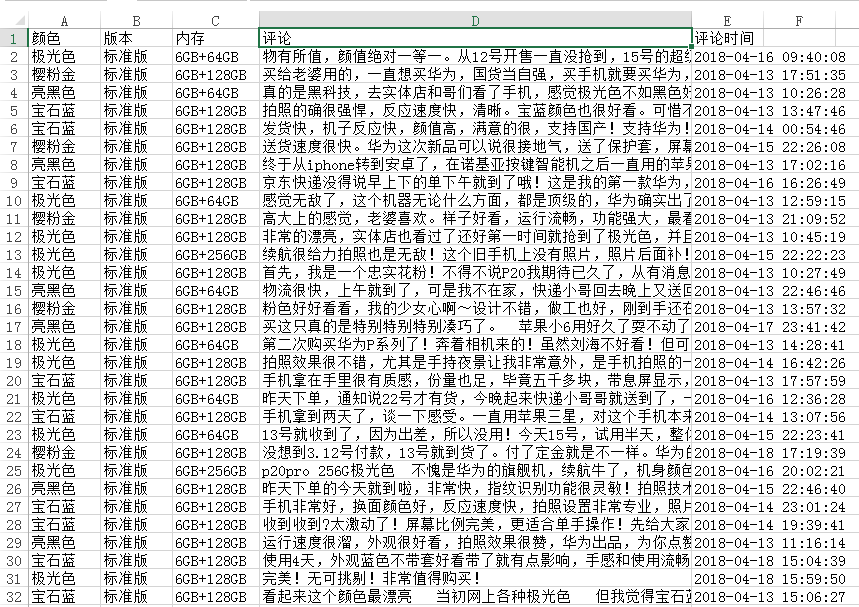

1、 下载后的数据如下图所示。

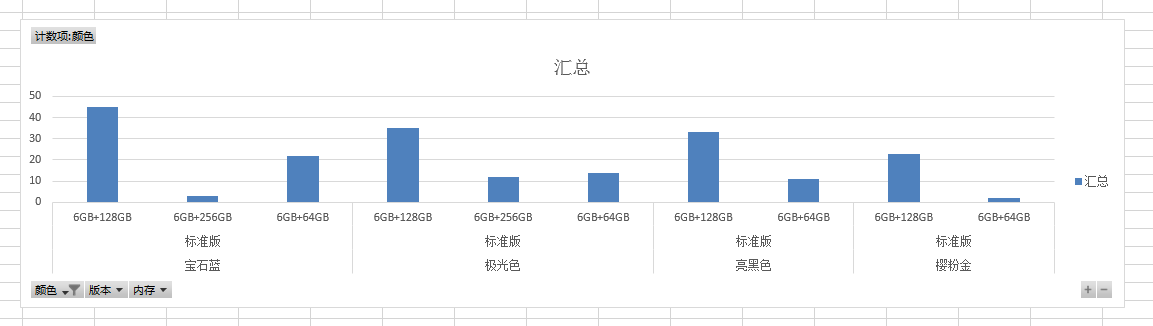

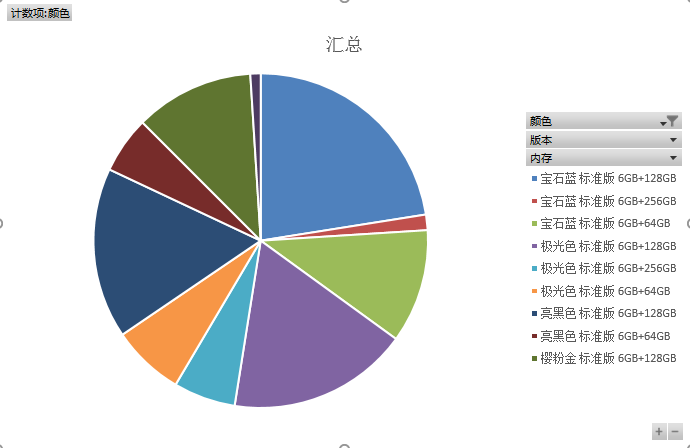

2、 生成图表。

我的博客即将搬运同步至腾讯云+社区,邀请大家一同入驻:https://cloud.tencent.com/developer/support-plan?invite_code=3ff1njli6hwk0

Python网络爬虫笔记(五):下载、分析京东P20销售数据的更多相关文章

- Python网络爬虫实战(五)批量下载B站收藏夹视频

我们除了爬取文本信息,有的时候还需要爬媒体信息,比如视频图片音乐等.就拿B站来说,我的收藏夹内的视频可能随时会失效,所以把它们下载到本地是非常保险的一件事. 对于这种大量列表型的数据,可以猜测B站收藏 ...

- Python网络爬虫笔记(二):链接爬虫和下载限速

(一)代码1(link_crawler()和get_links()实现链接爬虫) import urllib.request as ure import re import urllib.parse ...

- python网络爬虫笔记(五)

一.python的类对象的继承 1.所有的父类都是object类,由于类可以起到模块的作用,因此,可以在创建实例的时候,巴西一些认为必须要绑定的属性填写上去,通过定义一个特殊的方法 __init__, ...

- Python网络爬虫笔记(四):使用selenium获取动态加载的内容

(一) 说明 上一篇只能下载一页的数据,第2.3.4....100页的数据没法获取,在上一篇的基础上修改了下,使用selenium去获取所有页的href属性值. 使用selenium去模拟浏览器有点 ...

- Python网络爬虫笔记(一):网页抓取方式和LXML示例

(一) 三种网页抓取方法 1. 正则表达式: 模块使用C语言编写,速度快,但是很脆弱,可能网页更新后就不能用了. 2. Beautiful Soup 模块使用Python编写,速度慢. ...

- [Python]网络爬虫(五):urllib2的使用细节与抓站技巧

转自:http://blog.csdn.net/pleasecallmewhy/article/details/8925978 前面说到了urllib2的简单入门,下面整理了一部分urllib2的使用 ...

- [Python]网络爬虫(五):urllib2的使用细节与抓站技巧(转)

1.Proxy 的设置 urllib2 默认会使用环境变量 http_proxy 来设置 HTTP Proxy. 如果想在程序中明确控制 Proxy 而不受环境变量的影响,可以使用代理. 新建test ...

- python网络爬虫笔记(九)

4.1.1 urllib2 和urllib是两个不一样的模块 urllib2最简单的就是使用urllie2.urlopen函数使用如下 urllib2.urlopen(url[,data[,timeo ...

- python网络爬虫笔记(八)

一.pthon 序列化json格式 1.将python内置对象转换成json 模块,dumps()方法返回的是一个str,内容是标准的JSON,dump()方法可以直接吧JSON写入一个file-li ...

随机推荐

- Android开发之dip, dp, px, sp区别

显示单位px和dip以及sp的区别 dip: device independent pixels(设备独立像素). 不同设备有不同的显示效果,这个和设备硬件有关,一般我们为了支持WVGA.HVGA和Q ...

- Java创建线程的三种方式

一.继承Thread类创建线程类 (1)定义Thread类的子类,并重写该类的run方法,该run方法的方法体就代表了线程要完成的任务.因此把run()方法称为执行体. (2)创建Thread子类的实 ...

- javaScript设计模式-创建型设计模式

我们大家一听到设计模式就感觉设计模式是一个高端的东西,到底什么是设计模式呢?其实设计模式也就是我们的前辈在写代码的时候遇到的问题,提出的解决方案,为了方便人与人之间的交流,取了个名字,叫做设计模式. ...

- Alpha第七天

Alpha第七天 听说 031502543 周龙荣(队长) 031502615 李家鹏 031502632 伍晨薇 031502637 张柽 031502639 郑秦 1.前言 任务分配是VV.ZQ. ...

- bug终结者 团队作业第三周

bug终结者 团队作业第三周 团队展示 队名 bug终结者 队员风采: 杨京典 20162302 风格:先构建框架,在一 一实现,在实现的过程中不断测试和修改. 擅长的技术:拆分问题,使用相对简单的思 ...

- 201621123057 《Java程序设计》第13周学习总结

1. 本周学习总结 以你喜欢的方式(思维导图.OneNote或其他)归纳总结多网络相关内容. 2. 为你的系统增加网络功能(购物车.图书馆管理.斗地主等)-分组完成 为了让你的系统可以被多个用户通过网 ...

- mongodb 复制(副本集)

复制(副本集) 什么是复制 复制提供了数据的冗余备份,并在多个服务器上存储数据副本,提高了数据的可用性,并可以保证数据的安全性 复制还允许从硬件故障和服务中断中恢复数据 为什么要复制 数据备份 数据灾 ...

- pickle使用及案例

一.字典格式数据源写入数据库文件 #!/usr/bin/env python # -*- coding:utf-8 -*- import pickle accounts ={1000:'alex', ...

- iOS开发-OC分支结构

BOOL类型 返回值:真:YES 假:NO BOOL数据类型占一个字节的内存空间,占位符为%d. 计算机在识别时,YES就替换成1,NO就替换成0. bool是C语言中的布尔类型,返回值为true ...

- 机器学习中 K近邻法(knn)与k-means的区别

简介 K近邻法(knn)是一种基本的分类与回归方法.k-means是一种简单而有效的聚类方法.虽然两者用途不同.解决的问题不同,但是在算法上有很多相似性,于是将二者放在一起,这样能够更好地对比二者的异 ...