python网络爬虫与信息提取 学习笔记day2

Day2:

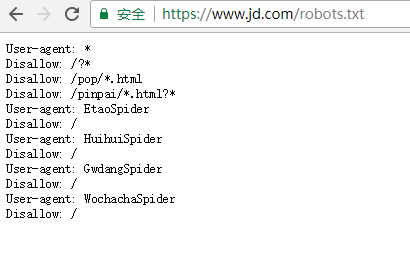

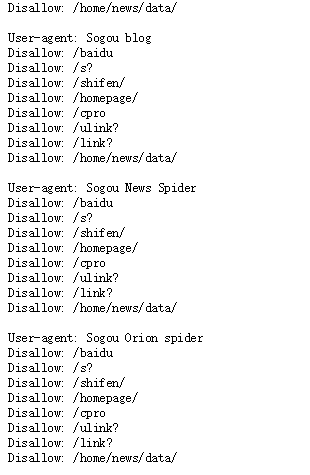

查看robots协议:

查看京东的robots协议

查看百度的robots协议,可以看到百度拒绝了搜狗的爬虫233

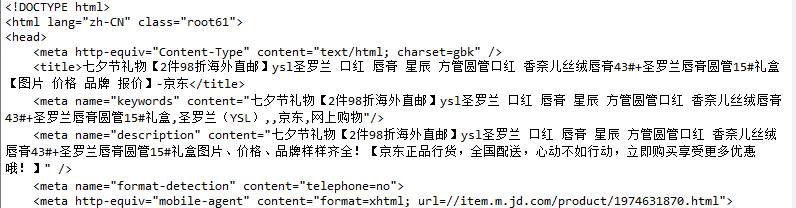

爬取京东商品页面相关信息:

import requests

url = "https://item.jd.hk/1974631870.html"

try:

r = requests.get(url)

r.raise_for_status()

r.encoding = r.apparent_encoding

print(r.text[:1000])

except:

print("产生异常")

爬取亚马逊商品页面相关信息:

由于亚马逊拒绝爬虫访问,所以需要更改header的值,将python伪装成浏览器访问

import requests

url = "https://www.amazon.cn/dp/B0186FESGW/ref=fs_kin"

try:

kv = { 'user-agent':'Mozilla/5.0'}

r = requests.get(url,headers = kv)

r.status_code

r.raise_for_status()

r.encoding = r.apparent_encoding

print(r.text[:1000])

except:

print("产生异常")

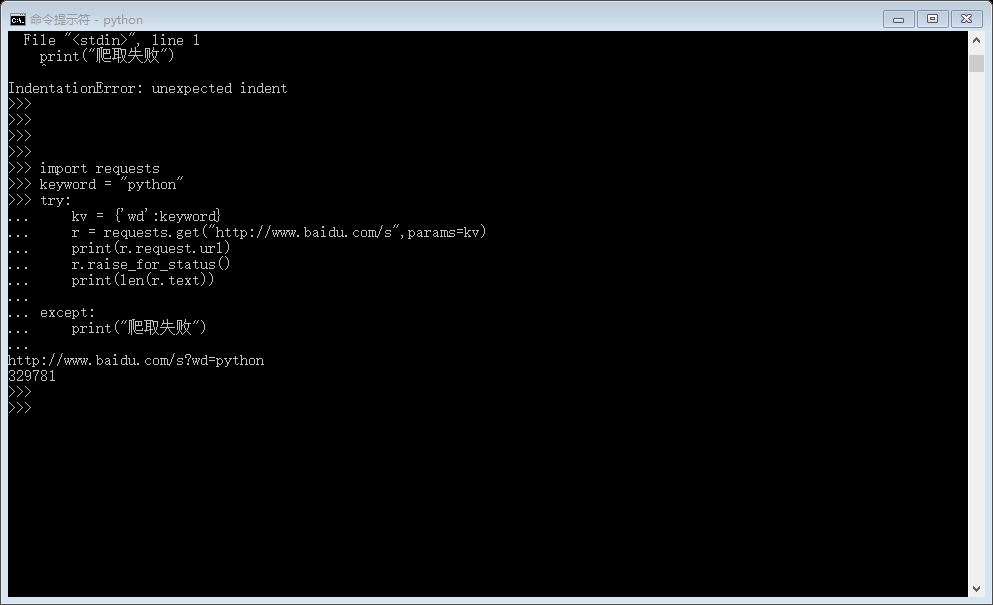

爬取百度关键词查询结果 : 本例关键词为python

import requests

keyword = "python"

try:

kv = {'wd':keyword}

r = requests.get("http://www.baidu.com/s",params=kv)

print(r.request.url)

r.raise_for_status()

print(len(r.text)) except:

print("爬取失败")

网络图片,视频等二进制文件的爬取和保存:

import requests

import os url = "http://image.nationalgeographic.com.cn/2017/0819/20170819021922613.jpg"

root = "f://pics//"

path = root + url.split('/')[-1]

try:

if not os.path.exists(root): #处理根目录是否存在问题

os.mkdir(root)

if not os.path.exists(path): #处理文件是否存在问题

kv = { 'user-agent':'Mozilla/5.0'}

r = requests.get(url,headers = kv) r.status_code

with open(path,'wb') as f:

f.write(r.content)#r.content为二进制形式

f.close()

print("文件保存成功")

else:

print("文件已存在")

except:

print("爬取失败")

Ip地址归属地的查询:

import requests

url = "http://m.ip138.com/ip.asp?ip="

try:

r=requests.get(url+'202.204.80.112')

r.raise_for_status()

r.encoding = r.apparent_encoding

print(r.text[-500:])

except:

print("爬取失败")

python网络爬虫与信息提取 学习笔记day2的更多相关文章

- python网络爬虫与信息提取 学习笔记day3

Day3: 只需两行代码解析html或xml信息 具体代码实现:day3_1 注意BeautifulSoup的B和S需要大写,因为python大小写敏感 import requests r ...

- python网络爬虫与信息提取 学习笔记day1

Day1: 安装python之后,为其配置requests第三方库,并爬取百度主页内容. 语句解释: r.status_code检测请求的状态码,如果状态码为200,则说明访问成功,否则,则说明访问失 ...

- python 网络爬虫与信息提取 学习笔记day4

正则表达式简介: 简洁表示一组字符串的特征或者模式,在文本处理中十分常用,主要应用于字符串匹配中 1. 通用的字符串表达框架 2. 简洁表达一组字符串的表达式 3. 针对字符串表达简洁和特征思想 ...

- 第3次作业-MOOC学习笔记:Python网络爬虫与信息提取

1.注册中国大学MOOC 2.选择北京理工大学嵩天老师的<Python网络爬虫与信息提取>MOOC课程 3.学习完成第0周至第4周的课程内容,并完成各周作业 4.提供图片或网站显示的学习进 ...

- 第三次作业-MOOC学习笔记:Python网络爬虫与信息提取

1.注册中国大学MOOC 2.选择北京理工大学嵩天老师的<Python网络爬虫与信息提取>MOOC课程 3.学习完成第0周至第4周的课程内容,并完成各周作业 第一周 Requests库的爬 ...

- 第三次作业-Python网络爬虫与信息提取

1.注册中国大学MOOC 2.选择北京理工大学嵩天老师的<Python网络爬虫与信息提取>MOOC课程 3.学习完成第0周至第4周的课程内容,并完成各周作业 过程. 5.写一篇不少于100 ...

- Python网络爬虫与信息提取

1.Requests库入门 Requests安装 用管理员身份打开命令提示符: pip install requests 测试:打开IDLE: >>> import requests ...

- Python网络爬虫与信息提取笔记

直接复制粘贴笔记发现有问题 文档下载地址//download.csdn.net/download/hide_on_rush/12266493 掌握定向网络数据爬取和网页解析的基本能力常用的 Pytho ...

- 【学习笔记】PYTHON网络爬虫与信息提取(北理工 嵩天)

学习目的:掌握定向网络数据爬取和网页解析的基本能力the Website is the API- 1 python ide 文本ide:IDLE,Sublime Text集成ide:Pychar ...

随机推荐

- 使用vlookup嵌套INDIRECT函数实现跨表数据引用

这是一个使用 vlookup 函数嵌套 INDIRECT 函数来实现跨工作表数据引用的教程. 某小学决定要抽查本校三年级三个班的期末考情况,抽查方法为在每个班中抽查5名学生,将这15名学生的期末考情况 ...

- postgresql数据操作

windows下操作postgresql 删除数据库:dropdb.exe -U postgres 数据库名称 创建数据库createdb.exe -U postgres lilei_db1--lil ...

- Hadoop搭建全程

修改配置文件 cd /etc/sysconfig/network-scripts #进入网络配置目录 dir ifcfg* #找到网卡配置文件 ifc ...

- LNMP详解

目录 Nginx配置 1 PHP解析 1 Mysql操作 3 服务安装 3 连接测试 3 数据配置 3 Blogs建立 4 LNMP 环境 Mysql:1 ...

- 剑指Offer-字符流中第一个不重复的字符

package String; import java.util.LinkedHashMap; import java.util.Map; /** * 字符流中第一个不重复的字符 * 题目描述 * 请 ...

- IT外包一定要按着程序流程做

步骤1: 衡量外包对你的公司是否有意义.在分析是否需要将你的工作进行外包的阶段,对本公司现有的业务做好基准调查以判定它们在多大程度上符合行业标准.或许,自行开展离岸业务--在其他地区建立离岸IT资源更 ...

- 造轮子-Java泛型堆排

个人博客地址:http://kyle.org.cn/2018/03/13/heapsort/ Java实现泛型堆排算法,用于N个对象中选择最大或者最小的前M个,其中M<=N 类似于Mysql中o ...

- 三十天学不会TCP,UDP/IP网络编程 -- TCP中的智慧之连续ARQ

突然发现上一篇文章贴图有问题,关键我怎么调也调不好,为了表达歉意,我再贴一篇gitbook上的吧,虽然违背了我自己的隔一篇在这里发一次的潜规则~其余完整版可以去gitbook(https://www. ...

- Spring MVC的handlermapping之SimpleUrlHandlerMapping初始化

前面信息同BeanNameUrlHandlerMapping,这里不再过多分析,详情请看 :Spring MVC的handlermapping之BeanNameUrlHandlerMapping初始化 ...

- Jquery精妙的自定义事件

对于jQuery自定义事件,很多JavaScript开发者都会有所疑惑:在日常开发过程中会不会用到呢?而本文将结合一个开发案例,其中的一些地方应用到了jQuery的自定义事件,而且达到了很好的效果-精 ...