个人作业2-6.4-Python爬取顶会信息

1、个人作业2

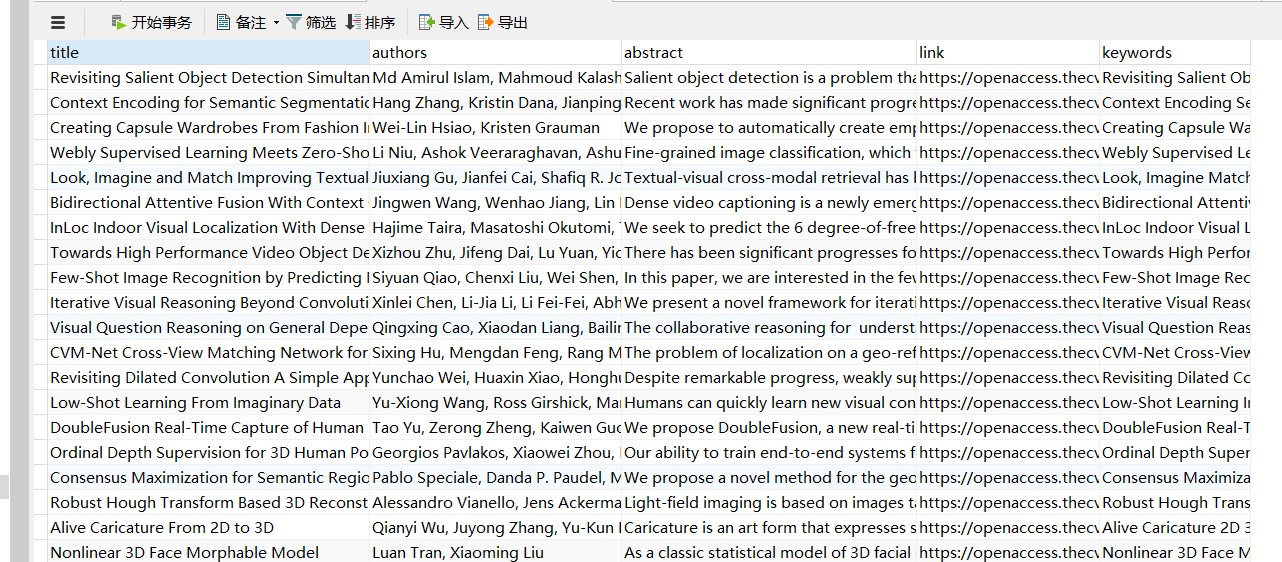

数据爬取阶段

import requests

from lxml import etree

import pymysql

def getdata(url):

# 请求CVPR主页

page_text = requests.get(url).text

parser = etree.HTMLParser(encoding="utf-8")

tree = etree.HTML(page_text, parser=parser)

#html

# 爬取论文连接

hrefs = tree.xpath('//dt[@class="ptitle"]/a/@href')

print(len(hrefs))

# 爬取论文信息

titles = []

pdfs = []

abstracts = []

authors = []

keywords = []

for href in hrefs:

db = pymysql.connect(host="127.0.0.1", user="root", password="lin0613",

database="users")

href = "https://openaccess.thecvf.com/" + href

page_text = requests.get(href).text

tree_link = etree.HTML(page_text, parser=parser)

title = tree_link.xpath('/html/body/div/dl/dd/div[@id="papertitle"]/text()')

title[0] = title[0].strip()

titles += title

title[0] = title[0].replace(":", "")

words = title[0].split()

keyword = ""

for word in words:

if checkword(word):

save_keywords(pymysql.connect(host="127.0.0.1", user="root", password="lin0613",database="users"), word)

keyword += word + " "

keywords.append(keyword)

pdf = tree_link.xpath('/html/body/div/dl/dd/a[contains(text(),"pdf")]/@href')

pdf[0] = pdf[0].replace("../../", "https://openaccess.thecvf.com/")

pdfs += pdf

abstract = tree_link.xpath('/html/body/div/dl/dd/div[@id="abstract"]/text()')

abstract[0] = abstract[0].strip()

abstracts += abstract

author = tree_link.xpath('/html/body/div/dl/dd/div/b/i/text()')

authors += author

# print(title)

# print(author)

# print(pdf)

# print(abstract)

save(db, title[0], author[0], abstract[0], href, keyword)

print(titles)

print(hrefs)

print(authors)

print(abstracts)

print(pdfs)

def save(db, title, author, abstract, link, keyword):

# 使用cursor()方法获取操作游标

cursor = db.cursor()

# SQL 插入语句

sql = "INSERT INTO papers(title, authors, abstract_text, original_link, keywords) \

VALUES ('%s', '%s', '%s', '%s', '%s')" % \

(title, author, abstract, link, keyword)

try:

# 执行sql语句

cursor.execute(sql)

print("true")

# 执行sql语句

db.commit()

except:

print("error wenzhang")

# 发生错误时回滚

db.rollback()

# 关闭数据库连接

db.close()

def save_keywords(db, keyword):

# 使用cursor()方法获取操作游标

cursor = db.cursor()

# SQL 插入语句

sql = "INSERT INTO keywords(keyword) VALUES ('%s')" % (keyword)

try:

# 执行sql语句

cursor.execute(sql)

# 执行sql语句

print("true")

db.commit()

except:

print("error word")

# 发生错误时回滚

db.rollback()

# 关闭数据库连接

db.close()

def checkword(word):

invalid_words = ['the', 'a', 'an', 'and', 'by', 'of', 'in', 'on', 'is', 'to', "as", "from", "for", "with", "that",

"have", "by", "on", "upon", "about", "above", "across", "among", "ahead", "after", "a",

"analthough", "at", "also", "along", "around", "always", "away", "anyup", "under", "untilbefore",

"between", "beyond", "behind", "because", "what", "when", "would", "could", "who", "whom", "whose",

"which", "where", "why", "without", "whether", "down", "during", "despite", "over", "off", "only",

"other", "out", "than", "the", "thenthrough", "throughout", "that", "these", "this", "those",

"there", "therefore", "some", "such", "since", "so", "can", "many", "much", "more", "may", "might",

"must", "ever", "even", "every", "each" ,"with","A","With","From"]

if word.lower() in invalid_words:

return False

else:

return True

if __name__ == '__main__':

#getdata("https://openaccess.thecvf.com/CVPR2018?day=2018-06-20")

getdata("https://openaccess.thecvf.com/CVPR2018?day=2018-06-21")

getdata("https://openaccess.thecvf.com/CVPR2019?day=2019-06-18")

#getdata("https://openaccess.thecvf.com/CVPR2019?day=2019-06-19")

#getdata("https://openaccess.thecvf.com/CVPR2019?day=2019-06-20")

getdata("https://openaccess.thecvf.com/CVPR2020?day=2020-06-16")

#getdata("https://openaccess.thecvf.com/CVPR2020?day=2020-06-17")

#getdata("https://openaccess.thecvf.com/CVPR2020?day=2020-06-18")

#getdata("https://openaccess.thecvf.com/CVPR2018?day=2018-06-19")

个人作业2-6.4-Python爬取顶会信息的更多相关文章

- Python爬取拉勾网招聘信息并写入Excel

这个是我想爬取的链接:http://www.lagou.com/zhaopin/Python/?labelWords=label 页面显示如下: 在Chrome浏览器中审查元素,找到对应的链接: 然后 ...

- python爬取豆瓣视频信息代码

目录 一:代码 二:结果如下(部分例子) 这里是爬取豆瓣视频信息,用pyquery库(jquery的python库). 一:代码 from urllib.request import quote ...

- Python 爬取美团酒店信息

事由:近期和朋友聊天,聊到黄山酒店事情,需要了解一下黄山的酒店情况,然后就想着用python 爬一些数据出来,做个参考 主要思路:通过查找,基本思路清晰,目标明确,仅仅爬取美团莫一地区的酒店信息,不过 ...

- python 爬取豆瓣书籍信息

继爬取 猫眼电影TOP100榜单 之后,再来爬一下豆瓣的书籍信息(主要是书的信息,评分及占比,评论并未爬取).原创,转载请联系我. 需求:爬取豆瓣某类型标签下的所有书籍的详细信息及评分 语言:pyth ...

- python爬取电影网站信息

一.爬取前提1)本地安装了mysql数据库 5.6版本2)安装了Python 2.7 二.爬取内容 电影名称.电影简介.电影图片.电影下载链接 三.爬取逻辑1)进入电影网列表页, 针对列表的html内 ...

- python爬取豆瓣电影信息数据

题外话+ 大家好啊,最近自己在做一个属于自己的博客网站(准备辞职回家养老了,明年再战)在家里 琐事也很多, 加上自己 一回到家就懒了(主要是家里冷啊! 广东十几度,老家几度,躲在被窝瑟瑟发抖,) 由于 ...

- python爬取梦幻西游召唤兽资质信息(不包含变异)

一.分析 1.爬取网站:https://xyq.163.com/chongwu/ 2.获取网页源码: request.get("https://xyq.163.com/chongwu/&qu ...

- python 爬取bilibili 视频信息

抓包时发现子菜单请求数据时一般需要rid,但的确存在一些如游戏->游戏赛事不使用rid,对于这种未进行处理,此外rid一般在主菜单的响应中,但有的如番剧这种,rid在子菜单的url中,此外返回的 ...

- python爬取网业信息案例

需求:爬取网站上的公司信息 代码如下: import json import os import shutil import requests import re import time reques ...

随机推荐

- LuoguP1619 解一元二次方程的烦恼 题解

Content 模拟一个系统,给出一个数 \(n\),让你判断是否是素数,如果是合数的话就要质因数分解. 需要注意的几点: 数字超过 \(4\times 10^7\),输出溢出提示. 数字小于 \(2 ...

- CF158A Next Round 题解

Content 有 \(n\) 个人参加比赛,第 \(i\) 名在第一轮的分数是 \(a_i\)(保证 \(a_i\geqslant a_{i+1}\))已知下一轮预计能进 \(k\) 人,当然如果有 ...

- CF977B Two-gram 题解

Content 给定一个字符串 \(s\),请求出出现次数最多的长度为 \(2\) 的子串. 数据范围:\(2\leqslant |s|\leqslant 100\). Solution 直接求出所有 ...

- CF1097B Petr and a Combination Lock 题解

Content 有一个锁,它只有指针再次指到 \(0\) 刻度处才可以开锁(起始状态如图所示,一圈 \(360\) 度). 以下给出 \(n\) 个操作及每次转动度数,如果可以通过逆时针或顺时针再次转 ...

- CF1492A Three swimmers 题解

Update \(\texttt{2021.3.9}\) 修改了题解中的错别字. \(\texttt{2021.12.16}\) 修改了一个没括回的区间. Content 有 \(3\) 个游泳者,同 ...

- java 编程基础 类加载器

什么是类加载器 类加载器负责将class文件(可能在磁盘上,也可能在网络上)加载到内存中,并为之生成对应的java.lang.Class对象.Java开发中无须过分关心类加载机制,但所有的编程人员都应 ...

- C++ 11新特性:std::future & std::shared_future) (转载)

上一讲<C++11 并发指南四(<future> 详解二 std::packaged_task 介绍)>主要介绍了 <future> 头文件中的 std::pack ...

- ajaxFileUpload上传文件成功后却无法解析服务器返回的json数据

可能是应该返回内容带了标签,过滤下 var index=data.indexOf("<"); if (index!=-1){ data=data.substring(0,in ...

- JAVA获取当前请求的URL地址,包含请求链接中的参数

/** * 获得当前访问的URL路径 * @param request * @return */ public static String getLocation(HttpServletRequest ...

- TempCache 临时内存缓存器

TempCache.h /* *************************************************** * Copyright(c) Xiamen AutoNavi Co ...