python爬取酷狗音乐

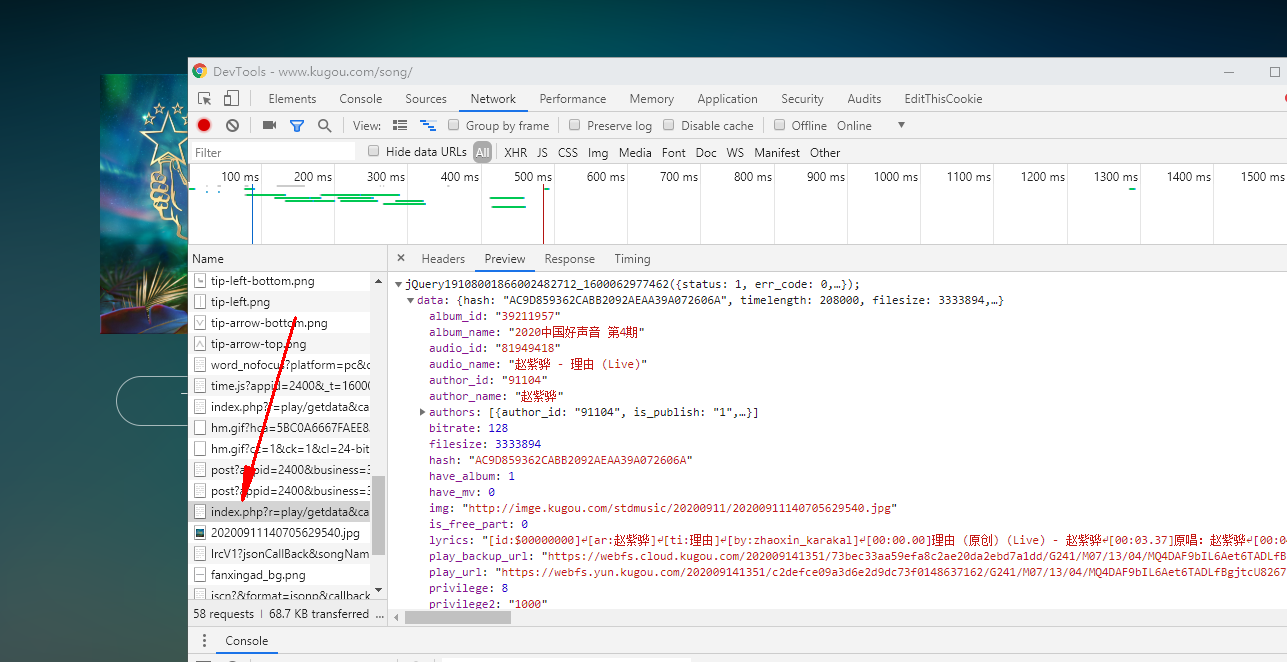

我们随便访问一个歌曲可以看到url有个hash

https://www.kugou.com/song/#hash=AC9D859362CABB2092AEAA39A072606A&album_id=39211957

但是这个hash是可以得到的

import re

import requests

import json

headers = {

'cookie': 'kg_mid=7a7f50715e7cbc43187cb14650a074d7; ACK_SERVER_10015=%7B%22list%22%3A%5B%5B%22gzlogin-user.kugou.com%22%5D%5D%7D; ACK_SERVER_10016=%7B%22list%22%3A%5B%5B%22gzreg-user.kugou.com%22%5D%5D%7D; ACK_SERVER_10017=%7B%22list%22%3A%5B%5B%22gzverifycode.service.kugou.com%22%5D%5D%7D; kg_dfid=2lP8Vp1RHLHj0wmucn0XlXFL; kg_dfid_collect=d41d8cd98f00b204e9800998ecf8427e; Hm_lvt_aedee6983d4cfc62f509129360d6bb3d=1600062203; kg_mid_temp=7a7f50715e7cbc43187cb14650a074d7; KuGooRandom=66401600062231494; Hm_lpvt_aedee6983d4cfc62f509129360d6bb3d=1600062409',

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.103 Safari/537.36'

}

hash_com = re.compile('"Hash":"(.*?)"',re.I|re.S)

html = requests.get('https://www.kugou.com/yy/html/rank.html',headers=headers)

hash_result = hash_com.findall(html.text)

print(hash_result)

然后我们刷新歌曲这里得网页可以看到都是在这里

然后我敲门只留hash前面看看能不能访问

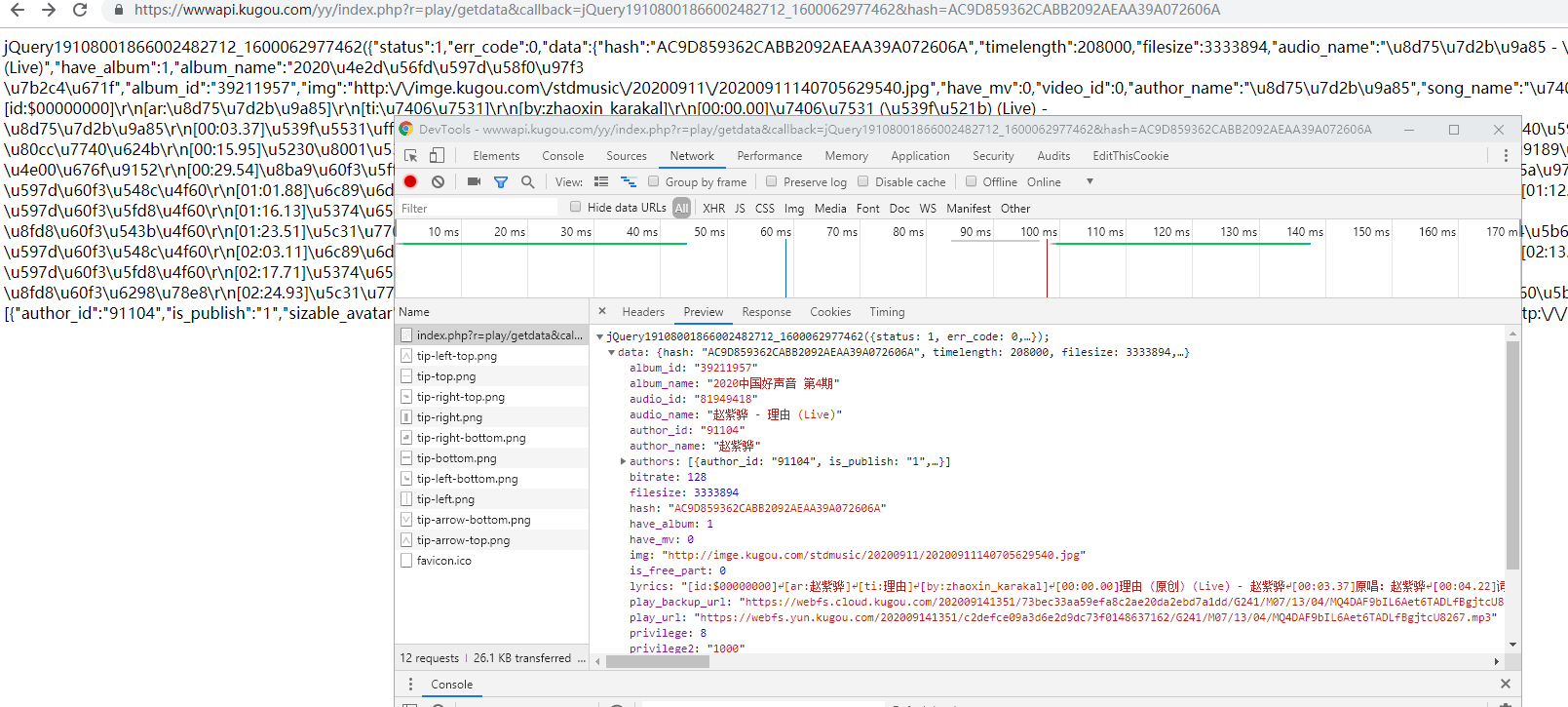

https://wwwapi.kugou.com/yy/index.php?r=play/getdata&callback=jQuery19108001866002482712_1600062977462&hash=AC9D859362CABB2092AEAA39A072606A

访问是可以的

然后我们再拼接一下

import re

import requests

import json

headers = {

'cookie': 'kg_mid=7a7f50715e7cbc43187cb14650a074d7; ACK_SERVER_10015=%7B%22list%22%3A%5B%5B%22gzlogin-user.kugou.com%22%5D%5D%7D; ACK_SERVER_10016=%7B%22list%22%3A%5B%5B%22gzreg-user.kugou.com%22%5D%5D%7D; ACK_SERVER_10017=%7B%22list%22%3A%5B%5B%22gzverifycode.service.kugou.com%22%5D%5D%7D; kg_dfid=2lP8Vp1RHLHj0wmucn0XlXFL; kg_dfid_collect=d41d8cd98f00b204e9800998ecf8427e; Hm_lvt_aedee6983d4cfc62f509129360d6bb3d=1600062203; kg_mid_temp=7a7f50715e7cbc43187cb14650a074d7; KuGooRandom=66401600062231494; Hm_lpvt_aedee6983d4cfc62f509129360d6bb3d=1600062409',

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.103 Safari/537.36'

}

hash_com = re.compile('"Hash":"(.*?)"',re.I|re.S)

html = requests.get('https://www.kugou.com/yy/html/rank.html',headers=headers)

hash_result = hash_com.findall(html.text)

# print(hash_result)

base_url = 'https://wwwapi.kugou.com/yy/index.php?r=play/getdata&callback=jQuery19108001866002482712_1600062977462&hash='

for hash in hash_result:

url = base_url+hash

# print(url)

然后再获取url

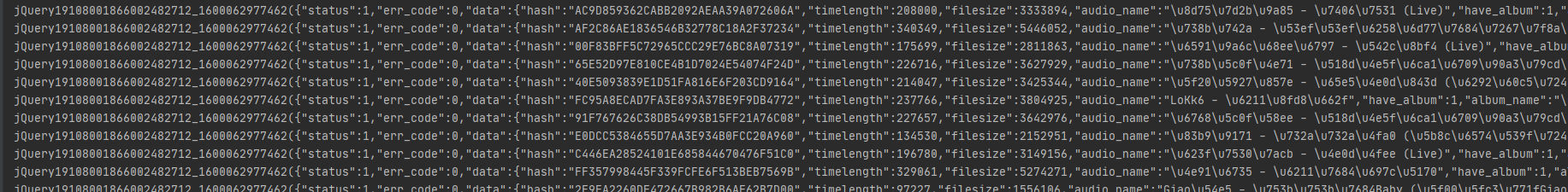

jsondata = requests.get(url,headers=headers)

print(jsondata.text)

输出为

我们来.json()看看

print(jsondata.json())

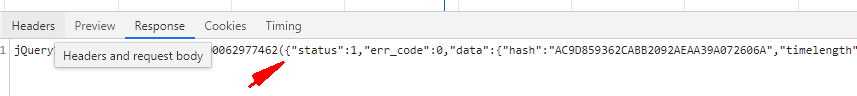

但是返回错误了,所以不是一个合法json,来转换一下,通过find来找到合法的json头部和尾部

他的合法开头再这里

结尾就是 .mp3"}}

start = jsondata.text.find('{"status":1')

end = jsondata.text.find('.mp3"}}')+len('.mp3"}}')

print(jsondata.text[start:end])

这里加上len就是因为[]是左闭右合的,返回

全部代码

import re

import requests

import json

import os

headers = {

'cookie': 'kg_mid=7a7f50715e7cbc43187cb14650a074d7; ACK_SERVER_10015=%7B%22list%22%3A%5B%5B%22gzlogin-user.kugou.com%22%5D%5D%7D; ACK_SERVER_10016=%7B%22list%22%3A%5B%5B%22gzreg-user.kugou.com%22%5D%5D%7D; ACK_SERVER_10017=%7B%22list%22%3A%5B%5B%22gzverifycode.service.kugou.com%22%5D%5D%7D; kg_dfid=2lP8Vp1RHLHj0wmucn0XlXFL; kg_dfid_collect=d41d8cd98f00b204e9800998ecf8427e; Hm_lvt_aedee6983d4cfc62f509129360d6bb3d=1600062203; kg_mid_temp=7a7f50715e7cbc43187cb14650a074d7; KuGooRandom=66401600062231494; Hm_lpvt_aedee6983d4cfc62f509129360d6bb3d=1600062409',

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.103 Safari/537.36'

}

hash_com = re.compile('"Hash":"(.*?)"',re.I|re.S)

html = requests.get('https://www.kugou.com/yy/html/rank.html',headers=headers)

hash_result = hash_com.findall(html.text)

# print(hash_result)

base_url = 'https://wwwapi.kugou.com/yy/index.php?r=play/getdata&callback=jQuery19108001866002482712_1600062977462&hash='

for hash in hash_result:

url = base_url+hash

# print(url)

jsondata = requests.get(url,headers=headers)

start = jsondata.text.find('{"status":1')

end = jsondata.text.find('.mp3"}}')+len('.mp3"}}')

# print(jsondata.text[start:end])

songurl = json.loads(jsondata.text[start:end])['data']['play_url']

title = json.loads(jsondata.text[start:end])['data']['audio_name']

if not os.path.exists('酷狗'):

os.mkdir('酷狗')

with open('酷狗/{}.mp3'.format(title),'wb')as f:

f.write(requests.get(songurl).content)

python爬取酷狗音乐的更多相关文章

- python爬取酷狗音乐排行榜

本文为大家分享了python爬取酷狗音乐排行榜的具体代码,供大家参考,具体内容如下

- Java爬虫系列之实战:爬取酷狗音乐网 TOP500 的歌曲(附源码)

在前面分享的两篇随笔中分别介绍了HttpClient和Jsoup以及简单的代码案例: Java爬虫系列二:使用HttpClient抓取页面HTML Java爬虫系列三:使用Jsoup解析HTML 今天 ...

- Python爬取酷狗飙升榜前十首(100)首,写入CSV文件

酷狗飙升榜,写入CSV文件 爬取酷狗音乐飙升榜的前十首歌名.歌手.时间,是一个很好的爬取网页内容的例子,对爬虫不熟悉的读者可以根据这个例子熟悉爬虫是如何爬取网页内容的. 需要用到的库:requests ...

- python使用beautifulsoup4爬取酷狗音乐

声明:本文仅为技术交流,请勿用于它处. 小编经常在网上听一些音乐但是有一些网站好多音乐都是付费下载的正好我会点爬虫技术,空闲时间写了一份,截止4月底没有问题的,会下载到当前目录,只要按照bs4库就好, ...

- 使用scrapy 爬取酷狗音乐歌手及歌曲名并存入mongodb中

备注还没来得及写,共爬取八千多的歌手,每名歌手平均三十首歌曲算,大概二十多万首歌曲 run.py #!/usr/bin/env python # -*- coding: utf-8 -*- __aut ...

- 【Python】【爬虫】爬取酷狗音乐网络红歌榜

原理:我的上篇博客 import requests import time from bs4 import BeautifulSoup def get_html(url): ''' 获得 HTML ' ...

- 【Python】【爬虫】爬取酷狗TOP500

好啦好啦,那我们来拉开我们的爬虫之旅吧~~~ 这一只小爬虫是爬取酷狗TOP500的,使用的爬取手法简单粗暴,目的是帮大家初步窥探爬虫长啥样,后期会慢慢变得健壮起来的. 环境配置 在此之前需要下载一个谷 ...

- htmlunit+fastjson抓取酷狗音乐 qq音乐链接及下载

上次学了jsoup之后,发现一些动态生成的网页内容是无法抓取的,于是又学习了htmlunit,下面是抓取酷狗音乐与qq音乐链接的例子: 酷狗音乐: import java.io.BufferedInp ...

- 使用Xpath爬取酷狗TOP500的歌曲信息

使用xpath爬取酷狗TOP500的歌曲信息, 将排名.歌手名.歌曲名.歌曲时长,提取的结果以文件形式保存下来.参考网址:http://www.kugou.com/yy/rank/home/1-888 ...

随机推荐

- powerdesigner16.5 生成sql语句

1.首先安装好designer. 2.打开之后新建一个project. 3.创建之后可能会生成这样的页面. 4.点击这个图标就能调出那个视图框. 5.在project处单机右键,New一个Concep ...

- First-Spike-Based Visual Categorization Using Reward-Modulated STDP

郑重声明:原文参见标题,如有侵权,请联系作者,将会撤销发布! Abstract 强化学习(RL)最近以击败欧洲围棋冠军等重大成就重新受到欢迎.在这里,我们第一次表明,RL可以有效地用于训练一个脉冲神经 ...

- Shell编程—数据展示

1.标准文件描述符 Linux用文件描述符(file descriptor)来标识每个文件对象.文件描述符是一个非负整数,可以唯一标识会话中打开的文件.每个进程一次 多可以有九个文件描述符.出于特殊目 ...

- PCIe例程理解(一)用户逻辑模块(接收)仿真分析

前言 本文从例子程序细节上(语法层面)去理解PCIe对于事物层数据的接收及解析. 参考数据手册:PG054: 例子程序有Vivado生成: 为什么将这个内容写出来? 通过写博客,可以检验自己理解了这个 ...

- Spring Security如何优雅的增加OAuth2协议授权模式

一.什么是OAuth2协议? OAuth 2.0 是一个关于授权的开放的网络协议,是目前最流行的授权机制. 数据的所有者告诉系统,同意授权第三方应用进入系统,获取这些数据.系统从而产生一个短期的进入令 ...

- LuaProfiler

Lua Profiler机制的源码解析 https://www.jianshu.com/p/f6606b27e9de

- MPL心得

1.右值引用变量是个左值,把一个右值引用参数继续传递给其他函数调用时,需要使用std::forward否则会按照左值匹配 2.const T和T const在匹配模板参数的时候是相同的,而const ...

- 编程体系结构(01):Java编程基础

一.数据类型 1.基础类型 整型:byte .short .int .long 浮点型:float.double 字节型:char 2.包装类型 Byte,Short,Integer,Long Flo ...

- Kubernetes K8S之资源控制器Job和CronJob详解

Kubernetes的资源控制器Job和CronJob详解与示例 主机配置规划 服务器名称(hostname) 系统版本 配置 内网IP 外网IP(模拟) k8s-master CentOS7.7 2 ...

- 实操ES6之Promise

箭头函数和this 写Promise的时候,自然而然会使用箭头函数的编写方式.箭头函数就是.Neter们熟知的lambda函数,已经被大部分主流语言支持,也受到了广大码农的交口称赞,但是Jser们却会 ...