学生课程分数的Spark SQL分析

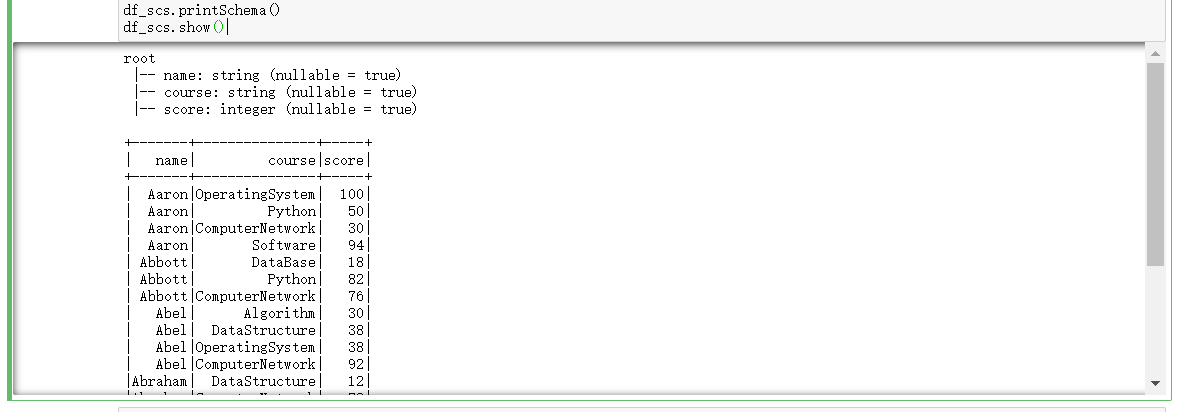

读学生课程分数文件chapter4-data01.txt,创建DataFrame。

url = "file:///D:/chapter4-data01.txt"

rdd = spark.sparkContext.textFile(url).map(lambda line:line.split(','))

rdd.take(3) from pyspark.sql.types import IntegerType,StringType,StructField,StructType

from pyspark.sql import Row #生成“表头”

fields = [StructField('name',StringType(),True),StructField('course',StringType(),True),StructField('score',IntegerType(),True)]

schema = StructType(fields) # 生成“表中的记录”

data = rdd.map(lambda p:Row(p[0],p[1],int(p[2]))) # 把“表头”和“表中的记录”拼接在一起

df_scs = spark.createDataFrame(data,schema)

df_scs.printSchema()

df_scs.show()

一:用DataFrame的操作或SQL语句完成以下数据分析要求,并和用RDD操作的实现进行对比:

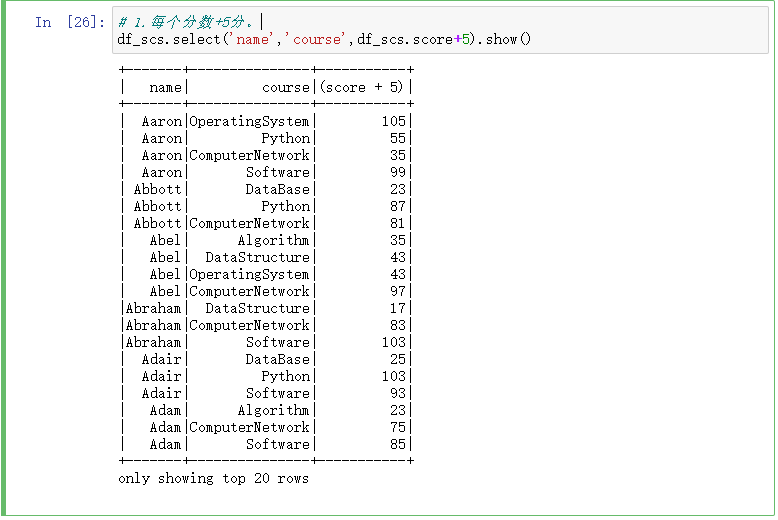

1.每个分数+5分。

# 1.每个分数+5分。

df_scs.select('name','course',df_scs.score+5).show()

2.总共有多少学生?

# 2.总共有多少学生?

df_scs.select(df_scs.name).distinct().count() df_scs.select(df_scs['name']).distinct().count() df_scs.select('name').distinct().count()

3.总共开设了哪些课程?

# 3.总共开设了哪些课程?

df_scs.select('course').distinct().show()

4.每个学生选修了多少门课?

# 4.每个学生选修了多少门课?

df_scs.groupBy('name').count().show()

5.每门课程有多少个学生选?

# 5.每门课程有多少个学生选?

df_scs.groupBy('course').count().show()

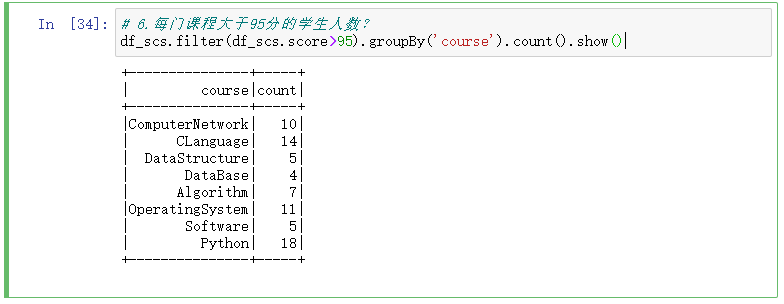

6.每门课程大于95分的学生人数?

# 6.每门课程大于95分的学生人数?

df_scs.filter(df_scs.score>95).groupBy('course').count().show()

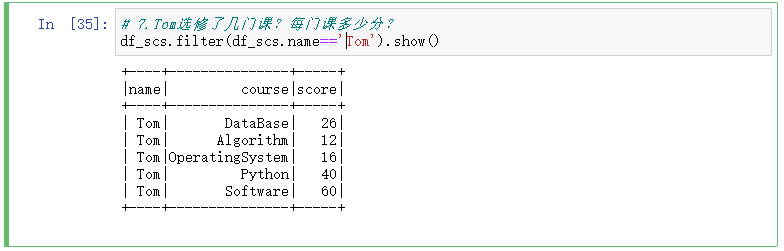

7.Tom选修了几门课?每门课多少分?

# 7.Tom选修了几门课?每门课多少分?

df_scs.filter(df_scs.name=='Tom').show()

8.Tom的成绩按分数大小排序。

# 8.Tom的成绩按分数大小排序。

df_scs.filter(df_scs.name=='Tom').orderBy(df_scs.score).show()

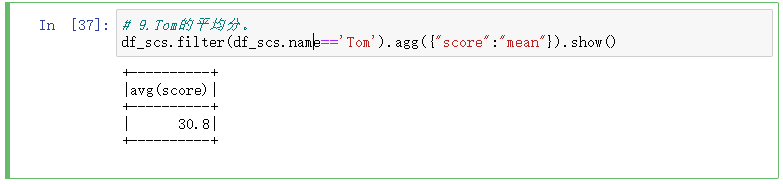

9.Tom的平均分。

# 9.Tom的平均分。

df_scs.filter(df_scs.name=='Tom').agg({"score":"mean"}).show()

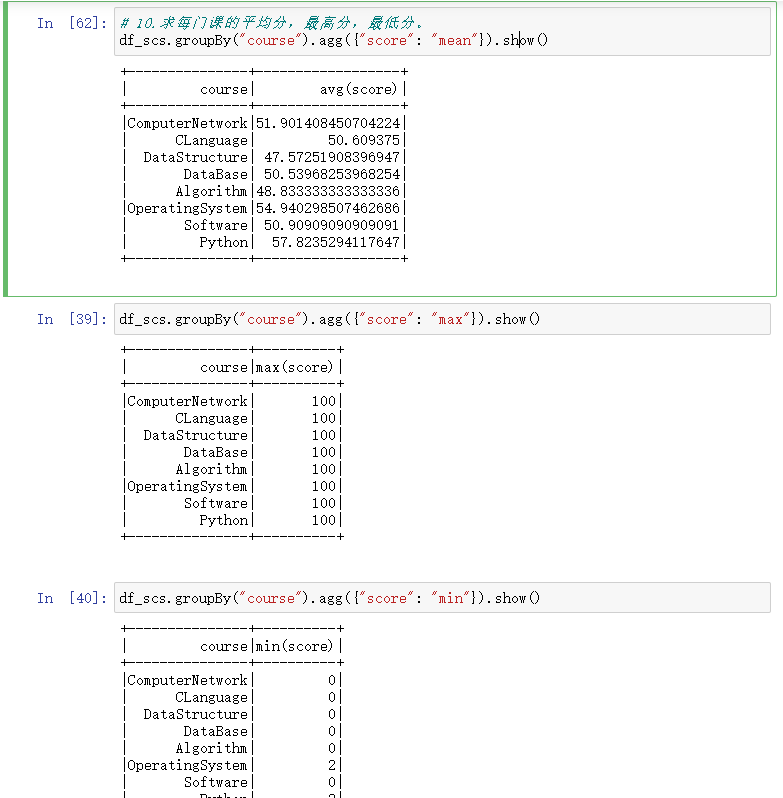

10.求每门课的平均分,最高分,最低分。

# 10.求每门课的平均分,最高分,最低分。

df_scs.groupBy("course").agg({"score": "mean"}).show() df_scs.groupBy("course").agg({"score": "max"}).show() df_scs.groupBy("course").agg({"score": "min"}).show()

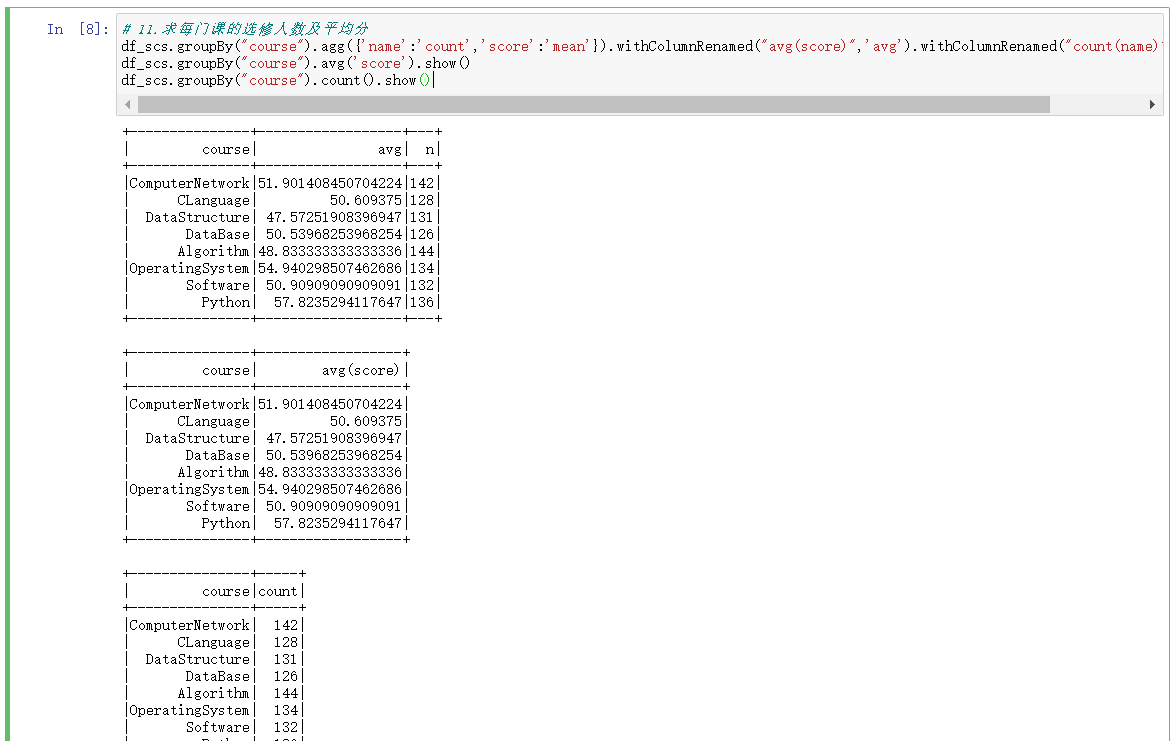

11.求每门课的选修人数及平均分,精确到2位小数。

# 11.求每门课的选修人数及平均分,精确到2位小数。

df_scs.select(countDistinct('name').alias('学生人数'),countDistinct('course').alias('课程数'),round(mean('score'),2).alias('所有课的平均分')).show()

12.每门课的不及格人数,通过率

# 12.每门课的不及格人数,通过率

df_scs.filter(df_scs.score<60).groupBy('course').count().show()

13.结果可视化。

二、用SQL语句完成以上数据分析要求

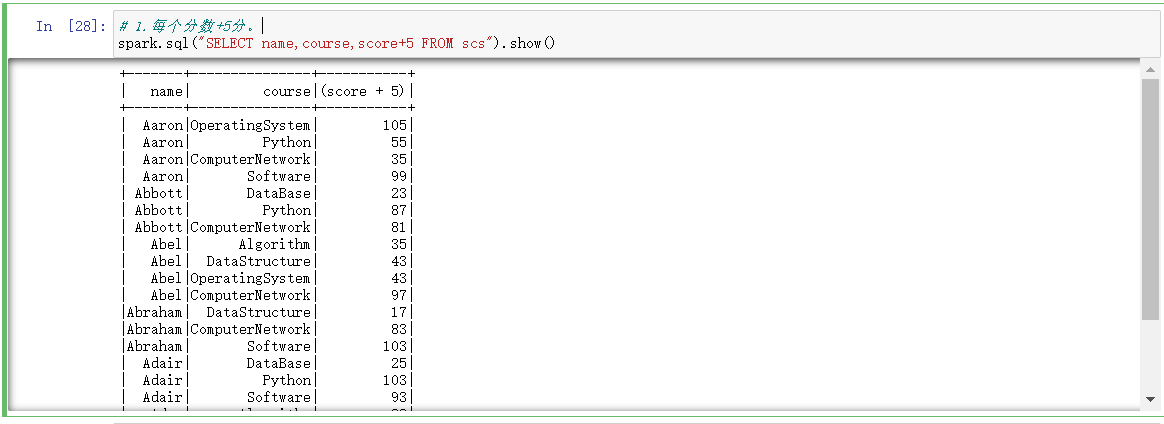

1.每个分数+5分。

# 1.每个分数+5分。

spark.sql("SELECT name,course,score+5 FROM scs").show()

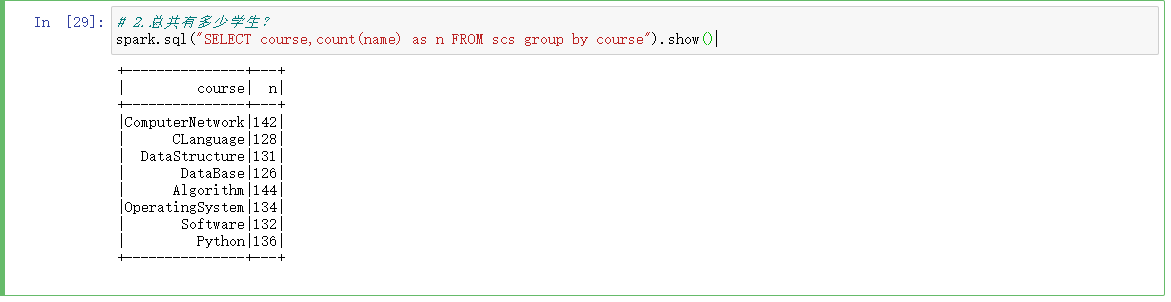

2.总共有多少学生?

# 2.总共有多少学生?

spark.sql("SELECT course,count(name) as n FROM scs group by course").show()

3.总共开设了哪些课程?

# 3.总共开设了哪些课程?

spark.sql("SELECT course FROM scs group by course").show()

4.每个学生选修了多少门课?

# 4.每个学生选修了多少门课?

spark.sql("SELECT name,count(course) FROM scs group by name").show()

5.每门课程有多少个学生选?

# 5.每门课程有多少个学生选?

spark.sql("SELECT course,count(name) FROM scs group by course").show()

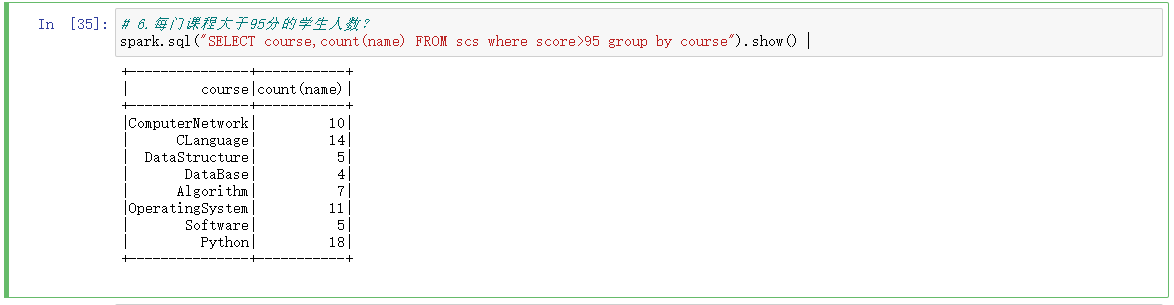

6.每门课程大于95分的学生人数?

# 6.每门课程大于95分的学生人数?

spark.sql("SELECT course,count(name) FROM scs where score>95 group by course").show()

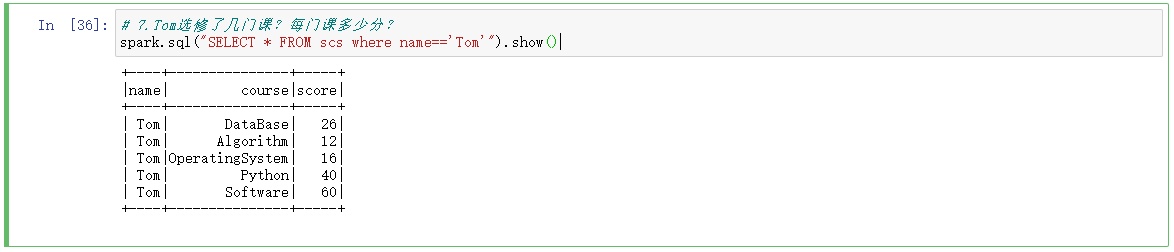

7.Tom选修了几门课?每门课多少分?

# 7.Tom选修了几门课?每门课多少分?

spark.sql("SELECT * FROM scs where name=='Tom'").show()

8.Tom的成绩按分数大小排序。

# 8.Tom的成绩按分数大小排序。

spark.sql("SELECT * FROM scs where name=='Tom' order by score desc").show()

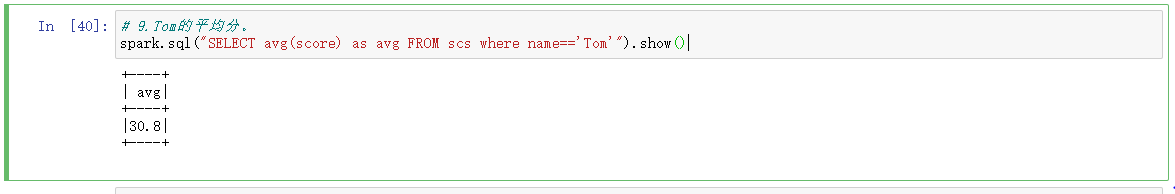

9.Tom的平均分。

# 9.Tom的平均分。

spark.sql("SELECT avg(score) as avg FROM scs where name=='Tom'").show()

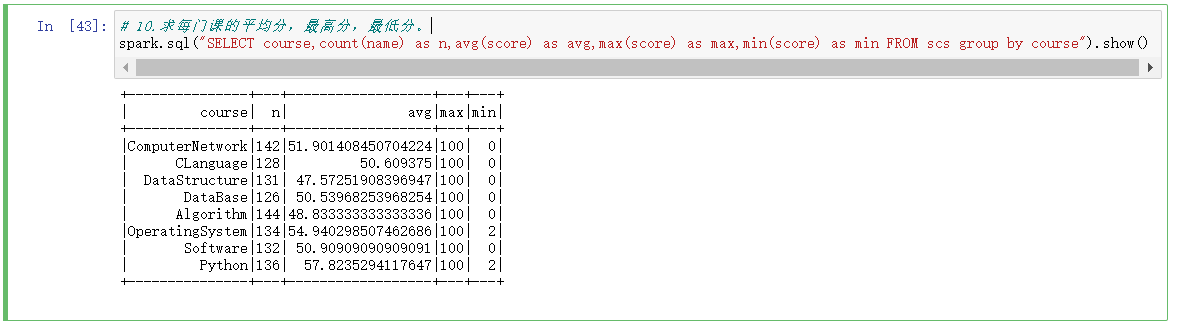

10.求每门课的平均分,最高分,最低分。

# 10.求每门课的平均分,最高分,最低分。

spark.sql("SELECT course,count(name) as n,avg(score) as avg,max(score) as max,min(score) as min FROM scs group by course").show()

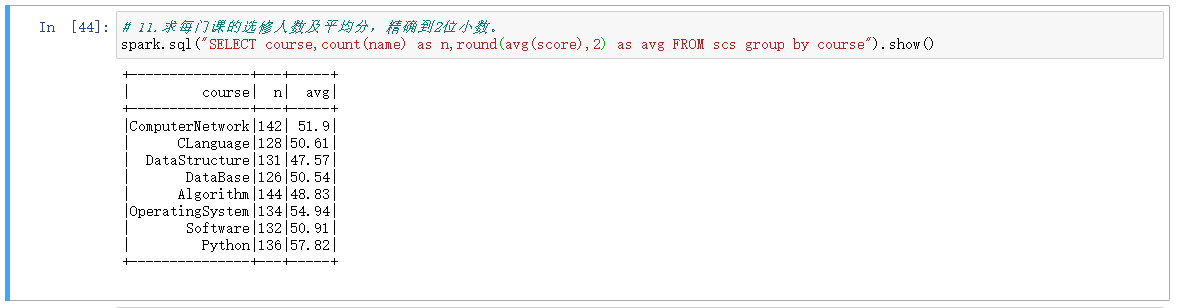

11.求每门课的选修人数及平均分,精确到2位小数。

# 11.求每门课的选修人数及平均分,精确到2位小数。

spark.sql("SELECT course,count(name) as n,round(avg(score),2) as avg FROM scs group by course").show()

12.每门课的不及格人数,通过率

# 12.每门课的不及格人数,通过率

spark.sql("SELECT course,count(name) as n,avg(score) as avg FROM scs group by course").createOrReplaceTempView("a")

spark.sql("SELECT course,count(score) as notPass FROM scs where score<60 group by course").createOrReplaceTempView("b")

spark.sql("SELECT * from a left join b on a.course=b.course").show() spark.sql("select a.course,round(a.avg,2),b.notPass,round((a.n-b.notPass)/a.n,2) as passRat from a left join b on a.course=b.course").show()

三、对比分别用RDD操作实现、用DataFrame操作实现和用SQL语句实现的异同。(比较两个以上问题)

例如:每门课的选修人数与平均分

1.RDD实现

# 方法一 combineByKey()

course = words.combineByKey(lambda v:(int(v),1),lambda c,v:(c[0]+int(v),c[1]+1),lambda c1,c2:(c1[0]+c2[0],c1[1]+c2[1])) #每门课的选修人数及所有人的总分。combineByKey()

course.map(lambda x:(x[0],x[1][1],round(x[1][0]/x[1][1],2))).collect() #每门课的选修人数及平均分,精确到2位小数。 #方法二 reduceByKey()

lines.map(lambda line:line.split(',')).map(lambda x:(x[1],(int(x[2]),1))).reduceByKey(lambda a,b:(a[0]+b[0],a[1]+b[1])).collect()

2.DataFrame实现

df_scs.groupBy("course").agg({'name':'count','score':'mean'}).withColumnRenamed("avg(score)",'avg').withColumnRenamed("count(name)",'n').show()

df_scs.groupBy("course").avg('score').show()

df_scs.groupBy("course").count().show()

3.SQL语句

spark.sql("SELECT course,count(name) as n,avg(score) as avg FROM scs group by course").show()

四、结果可视化。

函数:http://spark.apache.org/docs/2.2.0/api/python/pyspark.sql.html#module-pyspark.sql.functions

学生课程分数的Spark SQL分析的更多相关文章

- 08 学生课程分数的Spark SQL分析

读学生课程分数文件chapter4-data01.txt,创建DataFrame. 用DataFrame的操作或SQL语句完成以下数据分析要求,并和用RDD操作的实现进行对比: 每个分数+5分. 总共 ...

- hive Spark SQL分析窗口函数

Spark1.4发布,支持了窗口分析函数(window functions).在离线平台中,90%以上的离线分析任务都是使用Hive实现,其中必然会使用很多窗口分析函数,如果SparkSQL支持窗口分 ...

- Spark SQL大数据处理并写入Elasticsearch

SparkSQL(Spark用于处理结构化数据的模块) 通过SparkSQL导入的数据可以来自MySQL数据库.Json数据.Csv数据等,通过load这些数据可以对其做一系列计算 下面通过程序代码来 ...

- 05 RDD练习:词频统计,学习课程分数

.词频统计: 1.读文本文件生成RDD lines 2.将一行一行的文本分割成单词 words flatmap() 3.全部转换为小写 lower() 4.去掉长度小于3的单词 filter() 5. ...

- 小菜菜mysql练习解读分析1——查询" 01 "课程比" 02 "课程成绩高的学生的信息及课程分数

查询" 01 "课程比" 02 "课程成绩高的学生的信息及课程分数 好的,第一道题,刚开始做,就栽了个跟头,爽歪歪,至于怎么栽跟头的 ——需要分析题目,查询的是 ...

- 大数据学习day26----hive01----1hive的简介 2 hive的安装(hive的两种连接方式,后台启动,标准输出,错误输出)3. 数据库的基本操作 4. 建表(内部表和外部表的创建以及应用场景,数据导入,学生、分数sql练习)5.分区表 6加载数据的方式

1. hive的简介(具体见文档) Hive是分析处理结构化数据的工具 本质:将hive sql转化成MapReduce程序或者spark程序 Hive处理的数据一般存储在HDFS上,其分析数据底 ...

- Spark SQL慕课网日志分析(1)--系列软件(单机)安装配置使用

来源: 慕课网 Spark SQL慕课网日志分析_大数据实战 目标: spark系列软件的伪分布式的安装.配置.编译 spark的使用 系统: mac 10.13.3 /ubuntu 16.06,两个 ...

- Mysql--查询"01"课程比"02"课程成绩高的学生的信息及课程分数

今天在写Mysql代码作业时,写到这个题,感觉值得分享!!!!!!! 查询"01"课程比"02"课程成绩高的学生的信息及课程分数 分析如下: 首先先查询&quo ...

- Spark SQL概念学习系列之Spark SQL 架构分析(四)

Spark SQL 与传统 DBMS 的查询优化器 + 执行器的架构较为类似,只不过其执行器是在分布式环境中实现,并采用的 Spark 作为执行引擎. Spark SQL 的查询优化是Catalyst ...

- Spark SQL 源代码分析之 In-Memory Columnar Storage 之 in-memory query

/** Spark SQL源代码分析系列文章*/ 前面讲到了Spark SQL In-Memory Columnar Storage的存储结构是基于列存储的. 那么基于以上存储结构,我们查询cache ...

随机推荐

- 案例: 利用 Hugging Face 进行复杂文本分类

Witty 与 Hugging Face 专家加速计划的成功案例 如果你对如何更快构建 ML 解决方案感兴趣,请访问 专家加速计划 登陆页面并通过 填写表单 联系我们! 业务背景 随着 IT 技术不断 ...

- 一文快速入门任务调度框架-Quartz

前言 还不会 Quartz?如果你还没有接触过Quartz,那么你可能错过了一个很棒的任务调度框架!Quartz 提供了一种灵活.可靠的方式来管理和执行定时任务,让咱们的定时任务更加优雅.本篇文章将为 ...

- l洛谷第二题

题目描述 给定一个 n\times nn×n 的正方形棋盘,几位玩家在上面玩三子棋. 三子棋的规则是每位玩家轮流写下一个字母,同一名玩家的字母相同.当有一名玩家在行.列或者斜线上连续组成了 33 个自 ...

- vue之数组与对象的检测与更新

目录 说明 语法 示例 说明 MVVM会自动检测变量的变化,当变量改变,页面也会对应的变化,但是有一点需要注意,如果有一个对象增加值的时候,不能直接修改,需要使用Vue.set()方法 语法 Vue. ...

- Kubernetes学习之旅

# Kubernetes学习之旅 ## 引言 - 为什么选择Kubernetes- Kubernetes简介- Kubernetes的发展历程 ## Kubernetes基本概念 - 节点(Node) ...

- 简单的cs修改器

目录 各个函数解析 main() GetPid() 无限子弹 无限血 无限金币 Patch() 无僵直 稳定射击 Depatch1 手枪连发 Depatch 源代码部分 各个函数解析 这是我根据b站上 ...

- vs的常用配置【以及vs常用的快捷键】

1.颜色设置 (1) 编译器的主题颜色设置 (2) 字体和颜色设置 (3) 字体大小 更快捷的修改字体大小方式:ctr+鼠标滚轮 2.行号设置 默认就有,不用设置了 3.把解决方案资源管理器移动到左边 ...

- fio性能测试-环境搭建,功能介绍,测试讲解

fio性能测试-环境搭建,功能介绍,测试讲解 Fio介绍:FIO(Flexible I/O Tester)是一个用于测试磁盘.文件系统.块设备和网络设备性能的工具.它可以模拟不同类型的I/O负载,包括 ...

- Typecho<=1.2.0 存储型XSS 复现

Typecho<=1.2.0 存储型XSS 影响版本 漏洞影响版本:Typecho <= 1.2.0 漏洞复现 cookie.js // 定义一个全局变量 website,值为一个具体的网 ...

- Java线程中断机制

在阅读AQS源码以及juc包很多基于AQS的应用源码过程中,会遇到很多interrupted相关的方法,这里复习一下java线程中断相关. 要点:使用interrupt()中断一个线程,该方法只是标记 ...