神经网络的训练和测试 python

承接上一节,神经网络需要训练,那么训练集来自哪?测试的数据又来自哪?

《python神经网络编程》一书给出了训练集,识别图片中的数字。测试集的链接如下:

https://raw.githubusercontent.com/makeyourownneuralnetwork/makeyourownneuralnetwork/master/mnist_dataset/mnist_test_10.csv

为了方便,这只是一个小的测试集,才10个。

训练集链接:https://raw.githubusercontent.com/makeyourownneuralnetwork/makeyourownneuralnetwork/master/mnist_dataset/mnist_train_100.csv

这是包含100个数据的训练集。

训练集和测试集的每段的第一个字母是期望的数字,每段剩余的文本是表示这个数字的像素集合,为784个数据。为了计算,我们要把文本转化为数字进行存放。把第一个数据当作期望数据,剩余的784个数据当作输入。因此输入节点设为784个。输出节点设为10个,因为要识别的是10个数据0到9。隐藏层节点选为100个,并没有进行科学的计算。

import numpy

import scipy.special

import matplotlib.pyplot as plt

import pylab

# 神经网络类定义

class NeuralNetwork():

# 初始化神经网络

def __init__(self, inputnodes, hiddennodes, outputnodes, learningrate):

# 设置输入层节点,隐藏层节点和输出层节点的数量

self.inodes = inputnodes

self.hnodes = hiddennodes

self.onodes = outputnodes

# 学习率设置

self.lr = learningrate

# 权重矩阵设置 正态分布

self.wih = numpy.random.normal(0.0, pow(self.hnodes, -0.5), (self.hnodes, self.inodes))

self.who = numpy.random.normal(0.0, pow(self.onodes, -0.5), (self.onodes, self.hnodes))

# 激活函数设置,sigmod()函数

self.activation_function = lambda x: scipy.special.expit(x)

pass # 训练神经网络

def train(self,input_list,target_list):

# 转换输入输出列表到二维数组

inputs = numpy.array(input_list, ndmin=2).T

targets = numpy.array(target_list,ndmin= 2).T

# 计算到隐藏层的信号

hidden_inputs = numpy.dot(self.wih, inputs)

# 计算隐藏层输出的信号

hidden_outputs = self.activation_function(hidden_inputs)

# 计算到输出层的信号

final_inputs = numpy.dot(self.who, hidden_outputs)

final_outputs = self.activation_function(final_inputs) output_errors = targets - final_outputs

hidden_errors = numpy.dot(self.who.T,output_errors) #隐藏层和输出层权重更新

self.who += self.lr * numpy.dot((output_errors*final_outputs*(1.0-final_outputs)),

numpy.transpose(hidden_outputs))

#输入层和隐藏层权重更新

self.wih += self.lr * numpy.dot((hidden_errors * hidden_outputs * (1.0 - hidden_outputs)),

numpy.transpose(inputs))

pass

# 查询神经网络

def query(self, input_list):

# 转换输入列表到二维数组

inputs = numpy.array(input_list, ndmin=2).T

# 计算到隐藏层的信号

hidden_inputs = numpy.dot(self.wih, inputs)

# 计算隐藏层输出的信号

hidden_outputs = self.activation_function(hidden_inputs)

# 计算到输出层的信号

final_inputs = numpy.dot(self.who, hidden_outputs)

final_outputs = self.activation_function(final_inputs) return final_outputs # 设置每层节点个数

input_nodes = 784

hidden_nodes = 100

output_nodes = 10

# 设置学习率为0.3

learning_rate = 0.3

# 创建神经网络

n = NeuralNetwork(input_nodes, hidden_nodes, output_nodes, learning_rate) #读取训练数据集 转化为列表

training_data_file = open("D:/mnist_train_100.csv",'r')

training_data_list = training_data_file.readlines();

training_data_file.close() #训练神经网络

for record in training_data_list:

#根据逗号,将文本数据进行拆分

all_values = record.split(',')

#将文本字符串转化为实数,并创建这些数字的数组。

inputs = (numpy.asfarray(all_values[1:])/255.0 * 0.99) + 0.01

#创建用零填充的数组,数组的长度为output_nodes,加0.01解决了0输入造成的问题

targets = numpy.zeros(output_nodes) + 0.01

#使用目标标签,将正确元素设置为0.99

targets[int(all_values[0])] = 0.99

n.train(inputs,targets)

pass #读取测试文件

test_data_file = open("D:/mnist_test_10.csv",'r')

test_data_list = test_data_file.readlines()

test_data_file.close() all_values = test_data_list[0].split(',')

print(all_values[0]) #输出目标值 image_array = numpy.asfarray(all_values[1:]).reshape((28,28))

print(n.query((numpy.asfarray(all_values[1:])/255.0*0.99)+0.01))#输出标签值

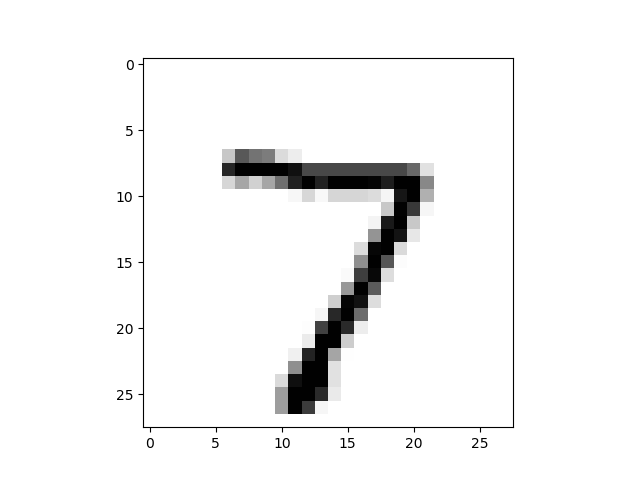

plt.imshow(image_array,cmap='Greys',interpolation='None')#显示原图像

pylab.show()

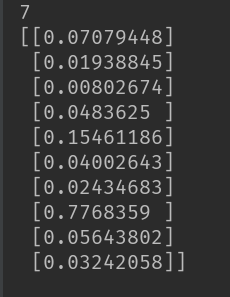

输出情况:

从结果可以看出,我们输入的目标值为7,结果中第7个标签所对应的值最大,表明了正确识别了目标值。和图片中的值一样。

神经网络的训练和测试 python的更多相关文章

- ensorflow学习笔记四:mnist实例--用简单的神经网络来训练和测试

http://www.cnblogs.com/denny402/p/5852983.html ensorflow学习笔记四:mnist实例--用简单的神经网络来训练和测试 刚开始学习tf时,我们从 ...

- tensorflow学习笔记四:mnist实例--用简单的神经网络来训练和测试

刚开始学习tf时,我们从简单的地方开始.卷积神经网络(CNN)是由简单的神经网络(NN)发展而来的,因此,我们的第一个例子,就从神经网络开始. 神经网络没有卷积功能,只有简单的三层:输入层,隐藏层和输 ...

- Python实现一个简单三层神经网络的搭建并测试

python实现一个简单三层神经网络的搭建(有代码) 废话不多说了,直接步入正题,一个完整的神经网络一般由三层构成:输入层,隐藏层(可以有多层)和输出层.本文所构建的神经网络隐藏层只有一层.一个神经网 ...

- 机器学习基础:(Python)训练集测试集分割与交叉验证

在上一篇关于Python中的线性回归的文章之后,我想再写一篇关于训练测试分割和交叉验证的文章.在数据科学和数据分析领域中,这两个概念经常被用作防止或最小化过度拟合的工具.我会解释当使用统计模型时,通常 ...

- 《TensorFlow实战》中AlexNet卷积神经网络的训练中

TensorFlow实战中AlexNet卷积神经网络的训练 01 出错 TypeError: as_default() missing 1 required positional argument: ...

- Caffe系列4——基于Caffe的MNIST数据集训练与测试(手把手教你使用Lenet识别手写字体)

基于Caffe的MNIST数据集训练与测试 原创:转载请注明https://www.cnblogs.com/xiaoboge/p/10688926.html 摘要 在前面的博文中,我详细介绍了Caf ...

- Caffe初试(二)windows下的cafee训练和测试mnist数据集

一.mnist数据集 mnist是一个手写数字数据库,由Google实验室的Corinna Cortes和纽约大学柯朗研究院的Yann LeCun等人建立,它有60000个训练样本集和10000个测试 ...

- Caffe上用SSD训练和测试自己的数据

学习caffe第一天,用SSD上上手. 我的根目录$caffe_root为/home/gpu/ljy/caffe 一.运行SSD示例代码 1.到https://github.com ...

- 物体检测算法 SSD 的训练和测试

物体检测算法 SSD 的训练和测试 GitHub:https://github.com/stoneyang/caffe_ssd Paper: https://arxiv.org/abs/1512.02 ...

随机推荐

- Linux yum apt-get 方式

Linux 大致可以分两大类 RedHat分支 redhat, centos ,mandrake,mandriva,国产的红x等 1 常见的安装包格式 rpm包,安装rpm包的命令是“rpm -参 ...

- laravel安装时openssl_encrypt() 的问题?Call to undefined function openssl_decrypt()

解决方案: 如果通过上面的步骤还是不能解决参考如下: 1.从php安装根目录中拷贝 libeay32.dll 和 ssleay32.dll 然后 覆盖掉apache/bin 下的对应文件(注意需要将h ...

- Android 5.0 以上监听网络变化

大家好,大概有一个多月没有更新博客了,我是干什么去了呢?很明显,程序员当然要加班……这一次跟大家分享一下新项目的一些心得. 监听网络变化在开发中是经常用到的,例如我们断网有一些友好的提示,或者根据不同 ...

- 使用swagger时遇到的问题

后端写好接口后开始和前端进行联调,为了减少时间成本或者说是后端不想写文档,所以便想使用一套可以自动化生成api接口文档的工具,swagger正是可以解决这一需求.于是很早之前就想把swagger集成到 ...

- ubuntu16.4安装 VirtualBox

1) 从oracle官网下载virtual box安装包 2) 安装支持包 sudo apt-get install libqt5x11extras5 libsdl1.2debian 3) sudo ...

- selenium入门14 窗口切换

窗口切换: 当前窗口句柄 current_window_handle 所有的窗口句柄 window_handles 切换窗口 switch_to_window() #coding=utf-8 #切换窗 ...

- 【CCPC-Wannafly Winter Camp Day4 (Div1) C】最小边覆盖(简单题)

点此看题面 大致题意: 给你一个边集的子集,问你这可不可能是这张图的最小边覆盖. 大致思路 考虑到,如果一条边连接的两个点度数都大于等于\(2\),则这条边完全可以删去. 因此,我们只要判断是否存在这 ...

- 模拟停车POJ(3505)

题目链接:http://poj.org/problem?id=3505 解题报告: #include <stdio.h> #include <iostream> #includ ...

- softmax sigmoid

softmax和sigmoid实际上都是属于logistic regression,sigmoid是二分类的lr,拟合Bernoulli distribution(二项分布):0softmax是多分类 ...

- 尝试将 SCRIPT ompbox\private\ompmex 作为函数执行

1.安装VS2010 2.配置ombox 在ombox路径下 mex -setup C++ 然后 make