整理requests和正则表达式爬取猫眼Top100中遇到的问题及解决方案

最近看崔庆才老师的爬虫课程,第一个实战课程是requests和正则表达式爬取猫眼电影Top100榜单。虽然理解崔老师每一步代码的实现过程,但自己敲代码的时候还是遇到了不少问题:

问题1:获取response.text时出现中文乱码的问题

问题2:通过requests.get()方法获取的网页代码与网页源代码不一致的问题

问题3:正则表达式匹配内容为空(多次修改pattern,甚至直接copy崔老师视频中的pattern也输出为空)

问题1:获取response.text时出现中文乱码的问题

1 import requests

2 from requests.exceptions import RequestException

3 import re

4

5 def get_one_page(url):

6 try:

7 response = requests.get(url)

8 if response.status_code == 200:

9 return response.text

10 else:

11 return None

12 except RequestException:

13 return None

14

15 shili = get_one_page('http://maoyan.com/board/4?')

16 print(shili)

上述代码运行后出现中文乱码的问题,经过网上收集资料显示:requests是从服务器返回的Response Headers 中Content-Type中获取编码,若指定了Charset就根据指定识别编码,否则就使用默认的ISO-8859-1,当服务器不符合此规范时就会出现乱码。解决方案是根据requests中的utils模块的get_encodings_from_content()方法进行解码:

# 将上述代码中第9行进行修改

content = response.text.encode('ISO-8859-1').decode(requests.utils.get_encodings_from_content(response.text)[0])

return content

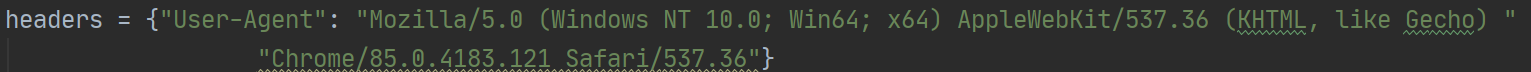

这样就顺利解决了中文乱码的问题,但是后面发现有更简单的方法(通过添加headers参数):

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecho) Chrome/85.0.4183.121 Safari/537.36'

}

response = requests.get(url, headers=headers)

问题2:通过requests.get()方法获取的网页代码与网页源代码不一致的问题

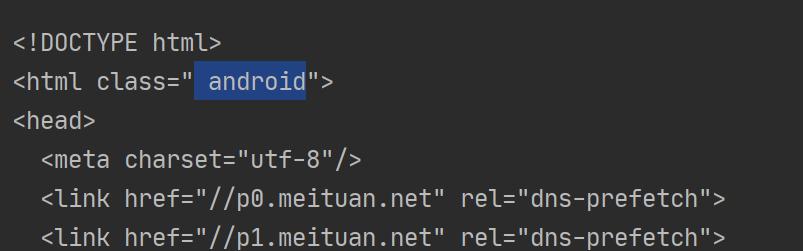

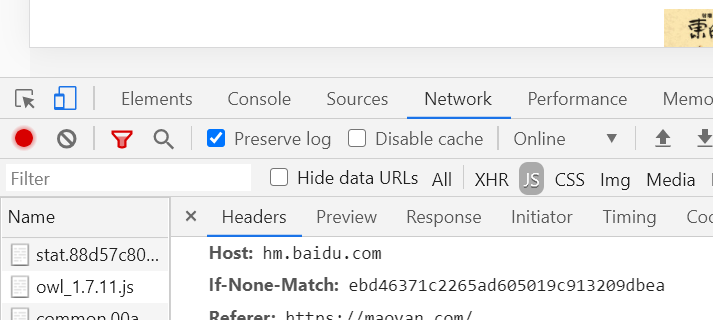

从network - Requests Headers下直接复制user-agent来添加请求头,发现得到的网页代码html属性是“android”:

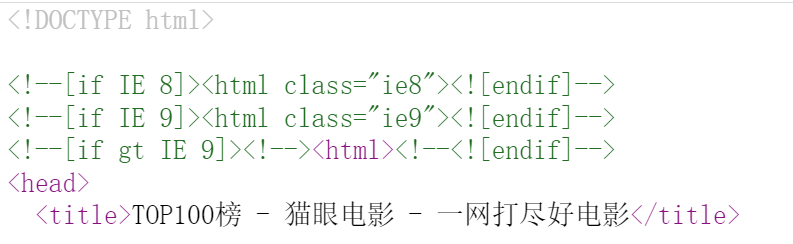

正确的源代码应该是这样的:

经过与崔老师的代码比较并进行调试,发现是浏览器复制的请求头出现了问题:

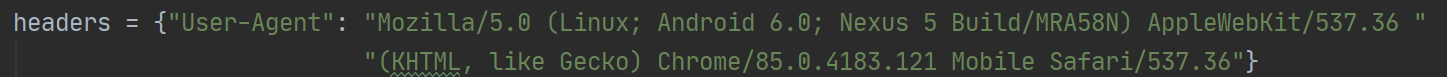

浏览器直接复制的user-agent 是这样的:

于是我上网搜索请求头user-agent的构成,以Chrome为例:

将其分为四个部分:

(1)默认部分:Mozilla/5.0

(2)表示操作系统版本部分:(Windows NT 10.0; Win64; x64)

(3)表示搜索引擎部分:AppleWebKit/537.36 (KHTML, like Gecho)

(4)表示浏览器版本部分:Chrome/85.0.4183.121 Safari/537.36

发现通过浏览器直接复制的user-agent中操作系统版本不对,这是因为在F12代码页面下点击了左上角的手机模式,将其关闭即可。

问题3:正则表达式匹配内容为空(多次修改pattern,甚至直接copy视频中的pattern也输出为空)

敲代码时自己尝试写正则表达式,运行后没有报错但是返回空列表:

def parser_one_page(html):

pattern = re.compile('<dd>.*?board-index.*?>(\d+)</i>.*?data-src="(.*?)".*?name"><a.*?>'

+ '(.*?)</a>.*?star">(.*?)</p>.*?releasetime">(.*?)</p>.*?integer">'

+ '(.*?)</i>.*?fraction">(.*?)</i>.*?</dd>', re.S)

items = re.findall(pattern, html)

print(items) def main():

url = 'https://maoyan.com/board/4?'

html = get_one_page(url)

parser_one_page(html) if __name__ == '__main__':

main()

后面发现直接复制URL时是https协议,改为http后能够正确返回pattern匹配内容。

非计算机专业爬虫小白,理论知识不足,欢迎计算机大神批评指正。

整理requests和正则表达式爬取猫眼Top100中遇到的问题及解决方案的更多相关文章

- 使用Requests+正则表达式爬取猫眼TOP100电影并保存到文件或MongoDB,并下载图片

需要着重学习的地方:(1)爬取分页数据时,url链接的构建(2)保存json格式数据到文件,中文显示问题(3)线程池的使用(4)正则表达式的写法(5)根据图片url链接下载图片并保存(6)MongoD ...

- requests和正则表达式爬取猫眼电影Top100练习

1 import requests 2 import re 3 from multiprocessing import Pool 4 from requests.exceptions import R ...

- Requests+BeautifulSoup+正则表达式爬取猫眼电影Top100(名称,演员,评分,封面,上映时间,简介)

# encoding:utf-8 from requests.exceptions import RequestException import requests import re import j ...

- python3.6 利用requests和正则表达式爬取猫眼电影TOP100

import requests from requests.exceptions import RequestException from multiprocessing import Pool im ...

- PYTHON 爬虫笔记八:利用Requests+正则表达式爬取猫眼电影top100(实战项目一)

利用Requests+正则表达式爬取猫眼电影top100 目标站点分析 流程框架 爬虫实战 使用requests库获取top100首页: import requests def get_one_pag ...

- 14-Requests+正则表达式爬取猫眼电影

'''Requests+正则表达式爬取猫眼电影TOP100''''''流程框架:抓去单页内容:利用requests请求目标站点,得到单个网页HTML代码,返回结果.正则表达式分析:根据HTML代码分析 ...

- Python 爬取 猫眼 top100 电影例子

一个Python 爬取猫眼top100的小栗子 import json import requests import re from multiprocessing import Pool #//进程 ...

- python爬虫:爬取猫眼TOP100榜的100部高分经典电影

1.问题描述: 爬取猫眼TOP100榜的100部高分经典电影,并将数据存储到CSV文件中 2.思路分析: (1)目标网址:http://maoyan.com/board/4 (2)代码结构: (3) ...

- 使用Beautiful Soup爬取猫眼TOP100的电影信息

使用Beautiful Soup爬取猫眼TOP100的电影信息,将排名.图片.电影名称.演员.时间.评分等信息,提取的结果以文件形式保存下来. import time import json impo ...

随机推荐

- 手写区分PC还是手机移动端

区分首先要了解window.navigator 输出navigator appCodeName: "Mozilla" appName: "Netscape" a ...

- Redis锁实现防重复提交和并发问题

@Slf4j @Component public class RedisLock { public static final int LOCK_EXPIRE = 5000; @Autowired pr ...

- AOP理论

目录 AOP理论 什么是AOP 那Spring AOP,AspectJ又是啥呢? 为什么说AOP是OOP的补充和完善呢? 应用场景举例 AOP的优点 AOP的术语整理 AOP理论 什么是AOP AOP ...

- Construct a Matrix (矩阵快速幂+构造)

There is a set of matrixes that are constructed subject to the following constraints: 1. The matrix ...

- 01 fs模块

1 fs.readFile 异步执行函数 /** fs 读取文件相对路径是相对终端命令行所在的路径 process.cwd()返回终端命令行的绝对路径 * */ fs = require('fs') ...

- 14_Web服务器-并发服务器

1.服务器概述 1.硬件服务器(IBM,HP): 主机 集群 2.软件服务器(HTTPserver Django flask): 网络服务器,在后端提供网络功能逻辑处理数据处理的程序或者架构等 3.服 ...

- JVM学习第三天(JVM的执行子系统)之字节码指令

早上看了Class类文件结构,晚上继续来看字节码指令,毕竟谁也不是一步登天的(说白了还是穷); 字节码指令 Java虚拟机的指令由一个字节长度的.代表着某种特定操作含义的数字(称为操作码,Opcode ...

- Azure Storage 系列(四)在.Net 上使用Table Storage

一,引言 今天我们就不多说废话了,直接进入正题,Azure Table Storage.开始内容之前,我们先介绍一下Azure Table Storage. 1,什么是Azure Table Stor ...

- Linux/Unix Terminal中文件/目录的颜色各代表什么意思?

注意:console/terminal中文件目录的颜色设置是可以更改的,故环境不同颜色就可能不一样. 下面是我所用终端的颜色示例: 颜色说明: 白色:普通文件 紫色:目录 红色:有问题的链接文件 蓝绿 ...

- Nginx之https配置

14.1. 对称加密 安全隐患:钥匙除我之外,还有多个人拥有.泄露风险较大,钥匙传递的过程风险较大 14.2. 非对称加密 优缺点:私钥很安全.但是非对称算法开销很大,大批量应用于业务,会导致性能成本 ...