用Python爬取文章,并转PDF格式电子书

wkhtmltopdf [软件],这个是必学准备好的,不然这个案例是实现不出来的

获取文章内容代码 (https://jq.qq.com/?_wv=1027&k=QgGWqAVF)

发送请求, 对于url地址发送请求

解析数据, 提取内容

保存数据, 先保存成html文件

再把html文件转成PDF

代码实现 (https://jq.qq.com/?_wv=1027&k=QgGWqAVF)

请求数据

python学习交流群:660193417###

import requests # 数据请求模块

url = f'https://blog.csdn.net/fei347795790/article/list/1' # 确定请求网址

# headers 请求头, 主要用于伪装python, 防止程序被服务器识别出来

headers = {

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/100.0.4896.88 Safari/537.36'

}

# 用requests模块里面get方式发送请求

response = requests.get(url=url, headers=headers)

print(response.text)

<Response [200]> 响应对象 200 表示请求成功

解析数据, 提取内容 (https://jq.qq.com/?_wv=1027&k=QgGWqAVF)

python学习交流群:660193417###

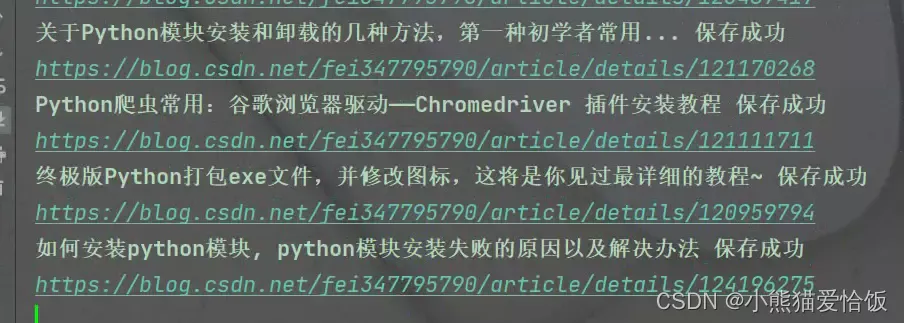

for index in href:

html_data = requests.get(url=index, headers=headers).text

selector_1 = parsel.Selector(html_data)

title = selector_1.css('#articleContentId::text').get()

content = selector_1.css('#content_views').get()

article_content = html_str.format(article=content)

print(title)

print(article_content)

break

保存数据 (https://jq.qq.com/?_wv=1027&k=QgGWqAVF)

python学习交流群:660193417###

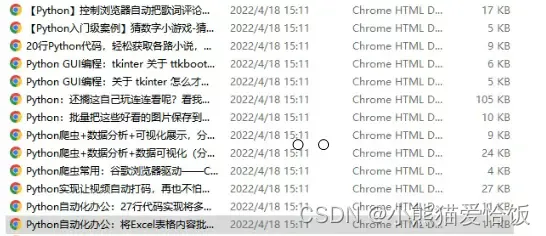

html_path = 'html\\' + title +'.html'

with open(html_path, mode='w', encoding=' utf-8') as f:

f.write(article_content)

print(title,'保存成功')

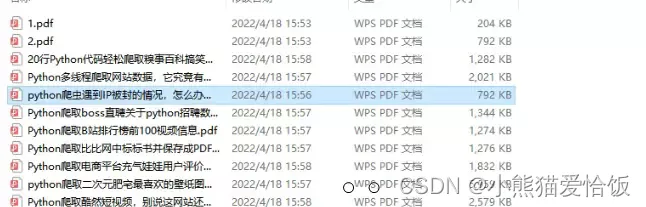

转制为pdf文件 (https://jq.qq.com/?_wv=1027&k=QgGWqAVF)

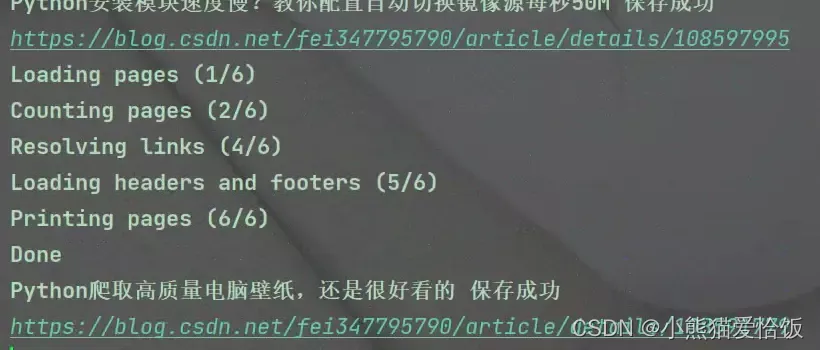

html_path = 'html\\ + title + '.html'

pdf_path = 'pdf\\' + title + '.pdf'

with open(html_path, mode='w', encoding='utf-8') as f:

f.write(article_content)

config = pdfkit.configuration(wkhtmltopdf=r'C:\01-Software-installation\wkhtmltopdf\bin\wkhtmltopdf.exe')

ppdfkit.from_file(html_path,pdf_path,configuration=config)

print(title,'保存成功')

来!试试看!

用Python爬取文章,并转PDF格式电子书的更多相关文章

- python 爬取文章

这里我们利用强大的python爬虫来爬取一篇文章.仅仅做一个示范,更高级的用法还要大家自己实践. 好了,这里就不啰嗦了,找到一篇文章的url地址:http://www.duanwenxue.com/a ...

- 假期学习【十一】Python爬取百度词条写入csv格式 python 2020.2.10

今天主要完成了根据爬取的txt文档,从百度分类从信息科学类爬取百度词条信息,并写入CSV格式文件. txt格式文件如图: 为自己爬取内容分词后的结果. 代码如下: import requests fr ...

- 用Python抓取漫画并制作mobi格式电子书

想看某一部漫画,但是用手机看感觉屏幕太小,用电脑看吧有太不方面.正好有一部Kindle,决定写一个爬虫把漫画爬取下来,然后制作成 mobi 格式的电子书放到kindle里面看. 一.编写爬虫程序 用C ...

- python 爬取文章后存储excel 以及csv

import requests from bs4 import BeautifulSoup import random import openpyxl xls=openpyxl.Workbook() ...

- python爬取博客圆首页文章链接+标题

新人一枚,初来乍到,请多关照 来到博客园,不知道写点啥,那就去瞄一瞄大家都在干什么好了. 使用python 爬取博客园首页文章链接和标题. 首先当然是环境了,爬虫在window10系统下,python ...

- python爬取网站数据

开学前接了一个任务,内容是从网上爬取特定属性的数据.正好之前学了python,练练手. 编码问题 因为涉及到中文,所以必然地涉及到了编码的问题,这一次借这个机会算是彻底搞清楚了. 问题要从文字的编码讲 ...

- 没有内涵段子可以刷了,利用Python爬取段友之家贴吧图片和小视频(含源码)

由于最新的视频整顿风波,内涵段子APP被迫关闭,广大段友无家可归,但是最近发现了一个"段友"的app,版本更新也挺快,正在号召广大段友回家,如下图,有兴趣的可以下载看看(ps:我不 ...

- python爬取微信公众号

爬取策略 1.需要安装python selenium模块包,通过selenium中的webdriver驱动浏览器获取Cookie的方法.来达到登录的效果 pip3 install selenium c ...

- 萌新学习Python爬取B站弹幕+R语言分词demo说明

代码地址如下:http://www.demodashi.com/demo/11578.html 一.写在前面 之前在简书首页看到了Python爬虫的介绍,于是就想着爬取B站弹幕并绘制词云,因此有了这样 ...

随机推荐

- 使用pip管理库

2.5 使用pip管理库 安装Python后会默认安装pip工具,该工具可以用来安装.升级和移除库.默认情况下 pip 将从[Python Package Index]https://pypi.org ...

- c#中判断类是否继承于泛型基类

在c#中,有时候我们会编写类似这样的代码: public class a<T> { //具体类的实现 } public class b : a<string>{} 如果b继承a ...

- Python 报错 ValueError list.remove(x) x not in list 解决办法

平时开发 Python 代码过程中,经常会遇到这个报错: ValueError: list.remove(x): x not in list 错误提示信息也很明确,就是移除的元素不在列表之中. 比如: ...

- Prometheus TSDB存储原理

Prometheus 包含一个存储在本地磁盘的时间序列数据库,同时也支持与远程存储系统集成,比如grafana cloud 提供的免费云存储API,只需将remote_write接口信息填写在Prom ...

- C#常见控件与SQL Sever数据库交互

C#常见控件与SQL Sever数据库交互 下拉框(ComboBox)与数据库绑定 首先,我们采用DataSet作为临时的数据库,这样会比较好 那么,我们先创建两个成员(对象) string sqlc ...

- 攻防世界-MISC:base64÷4

这是攻防世界高手进阶区的第一题,题目如下: 点击下载附件一,发现是一个文本文档,打开后得到一串字符串 由题意猜测这些字符串应该是base16加密过的,写个脚本跑一下 import base64 s = ...

- Bugku CTF练习题---分析---flag被盗

Bugku CTF练习题---分析---flag被盗 flag:flag{This_is_a_f10g} 解题步骤: 1.观察题目,下载附件 2.下载的文件是一个数据包,果断使用wireshark打开 ...

- nginx + nginx-rtmp-module搭建直播流服务器实现推流实时直播功能

业务需求 最近公司在做养老相关的业务,现在需要子女从小程序端对家里的老人通过家庭终端交互屏进行实时看护. 解决方案 第三方的一些现成的服务:腾讯音视频通话.直播功能; 阿里的音视频通信;两者都挺好的, ...

- mask-image实现聚光灯效果

大家好,我是半夏,一个刚刚开始写文的沙雕程序员.如果喜欢我的文章,可以关注 点赞 加我微信:frontendpicker,一起学习交流前端,成为更优秀的工程师-关注公众号:搞前端的半夏,了解更多前端知 ...

- 243张图片为你解析轻量级自动运维化工具Ansible

Ansible 是什么 ? ansible架构图 ansible特性 模块化:调用特定的模块,完成特定的任务: 基于Python语言研发,由Paramiko, PyYAML和Jinja2三个核心库实 ...