Python 之scrapy框架58同城招聘爬取案例

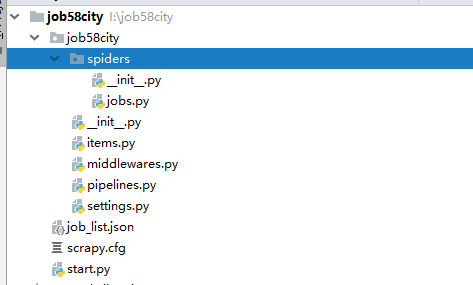

一、项目目录结构:

代码如下:

# -*- coding: utf-8 -*- # Define here the models for your scraped items

#

# See documentation in:

# https://doc.scrapy.org/en/latest/topics/items.html import scrapy class Job58CityItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

job_name = scrapy.Field()

money = scrapy.Field()

job_wel = scrapy.Field()

company = scrapy.Field()

position_type = scrapy.Field()

xueli = scrapy.Field()

jingyan = scrapy.Field()

address = scrapy.Field()

# -*- coding: utf-8 -*-

import scrapy

from ..items import Job58CityItem class JobsSpider(scrapy.Spider):

name = 'jobs'

allowed_domains = ['58.com']

# 配置起始页url

offset = 1

url = "https://cd.58.com/job/pn{0}/"

start_urls = [url.format(str(offset))] #解析html内容

def parse(self, response):

for each in response.xpath("//ul[@id='list_con']/li"):

item = Job58CityItem()

item['job_name'] = each.xpath(".//span[@class='name']/text()").extract()[0]

money_list = each.xpath(".//p[@class='job_salary']/text()").extract()

money = "未知"

if len(money_list) > 0:

money = money_list[0]

item['money'] = money

span = each.xpath(".//div[@class='job_wel clearfix']/span")

item['job_wel'] = []

for i in span:

item['job_wel'].append(i.xpath("./text()").extract()[0])

item['company'] = each.xpath(".//div[@class='comp_name']/a/text()").extract()[0]

item['position_type'] = each.xpath(".//span[@class='cate']/text()").extract()[0]

item['xueli'] = each.xpath(".//span[@class='xueli']/text()").extract()[0]

item['jingyan'] = each.xpath(".//span[@class='jingyan']/text()").extract()[0]

item['address'] = each.xpath("//span[@class='address']/text()").extract()[0]

yield item

if self.offset < 100:

self.offset += 1

yield scrapy.Request("https://cd.58.com/job/pn{0}/".format(str(self.offset)), callback=self.parse)

from scrapy import cmdline if __name__ == '__main__':

cmdline.execute("scrapy crawl jobs".split())

数据:

源码链接:https://github.com/yangsphp/Scrapy-master

Python 之scrapy框架58同城招聘爬取案例的更多相关文章

- python爬虫 scrapy框架(一)爬取壁纸照片

此项目仅供学习参考, 不用于任何商业用途 若侵权留言,立刻删除 刚入门爬虫不久,一心想找个网站试试,然后朋友推荐了这个壁纸网站

- Scrapy 框架 CrawlSpider 全站数据爬取

CrawlSpider 全站数据爬取 创建 crawlSpider 爬虫文件 scrapy genspider -t crawl chouti www.xxx.com import scrapy fr ...

- scrapy框架用CrawlSpider类爬取电影天堂.

本文使用CrawlSpider方法爬取电影天堂网站内国内电影分类下的所有电影的名称和下载地址 CrawlSpider其实就是Spider的一个子类. CrawlSpider功能更加强大(链接提取器,规 ...

- 爬虫(十七):Scrapy框架(四) 对接selenium爬取京东商品数据

1. Scrapy对接Selenium Scrapy抓取页面的方式和requests库类似,都是直接模拟HTTP请求,而Scrapy也不能抓取JavaScript动态谊染的页面.在前面的博客中抓取Ja ...

- python爬虫scrapy框架

Scrapy 框架 关注公众号"轻松学编程"了解更多. 一.简介 Scrapy是用纯Python实现一个为了爬取网站数据.提取结构性数据而编写的应用框架,用途非常广泛. 框架的力量 ...

- python爬虫scrapy框架——人工识别登录知乎倒立文字验证码和数字英文验证码(2)

操作环境:python3 在上一文中python爬虫scrapy框架--人工识别知乎登录知乎倒立文字验证码和数字英文验证码(1)我们已经介绍了用Requests库来登录知乎,本文如果看不懂可以先看之前 ...

- Python爬虫(四)——开封市58同城数据模型训练与检测

前文参考: Python爬虫(一)——开封市58同城租房信息 Python爬虫(二)——对开封市58同城出租房数据进行分析 Python爬虫(三)——对豆瓣图书各模块评论数与评分图形化分析 数据的构建 ...

- [Python爬虫] 使用 Beautiful Soup 4 快速爬取所需的网页信息

[Python爬虫] 使用 Beautiful Soup 4 快速爬取所需的网页信息 2018-07-21 23:53:02 larger5 阅读数 4123更多 分类专栏: 网络爬虫 版权声明: ...

- 【图文详解】scrapy爬虫与动态页面——爬取拉勾网职位信息(2)

上次挖了一个坑,今天终于填上了,还记得之前我们做的拉勾爬虫吗?那时我们实现了一页的爬取,今天让我们再接再厉,实现多页爬取,顺便实现职位和公司的关键词搜索功能. 之前的内容就不再介绍了,不熟悉的请一定要 ...

随机推荐

- Chrome 如何查看/修改Cookie

- 将list转为json字符串

//确保JSP和servlet的编码方式一致 resp.setContentType("text/html;charset=GBK"); List<String> jy ...

- Mac: 通过蓝牙用安卓手机向Mac发送文件

1. 打开Mac蓝牙和手机蓝牙 2. 配对 3. mac 系统偏好设置>共享 勾蓝牙共享,选接受并存储 4. 手机发送文件

- Lein: Exception in thread "Thread-3" java.net.ConnectException: Connection refused

leiningen Leiningen是你的主要工具, 它用于: 启动一个 REPL 下载+安装类库 运行你的程序 启动一个服务器, 运行你所写的webapps 安装 brew install lei ...

- Android 高仿 频道管理----网易、今日头条、腾讯视频 (能够拖动的GridView)附源代码DEMO

距离上次公布(android高仿系列)今日头条 --新闻阅读器 (二) 相关的内容已经半个月了.近期利用空暇时间,把今日头条client完好了下.完好的功能一个一个所有实现后.就放整个源代码.开发的进 ...

- C#保留2位小数几种场景总结 游标遍历所有数据库循环执行修改数据库的sql命令 原生js轮盘抽奖实例分析(幸运大转盘抽奖) javascript中的typeof和类型判断

C#保留2位小数几种场景总结 场景1: C#保留2位小数,.ToString("f2")确实可以,但是如果这个数字本来就小数点后面三位比如1.253,那么转化之后就会变成1.2 ...

- Android自己定义提示框

在开发中,假设感觉系统自带的提示框不好看,开发人员能够自定义提示框的样式.主要是继承Dialog 程序文件夹结构 关键代码 package com.dzt.custom.dialog; import ...

- Android数据存储之IO

Android开发中免不了数据本地的存储,今天我们来说一说怎样利用IO流来进行数据存储. 这里我们通过模拟一个QQ登陆界面的小demo来实际操作IO流. 功能描写叙述:点击button能够保存用户输入 ...

- react State改变,页面却没有改变

react 小白编程 做项目时遇到了个问题,无论我怎么查看我的action.reducer 还是 dispatch 函数,都没有发现有什么毛病.但是 debugger 的时候,state 改变了,页面 ...

- 数据分析在web交互设计中的作用 页面跳出率 100% 原因分析

通过分析访问的路径,发现,访问者访问其他页面,直接跳出 页面跳出率 100% 说明: 连作者都发现的导航路径不清晰 对导航进行改版:清晰.明了