爬虫小例1:ajax形式的网页数据的抓取

---恢复内容开始---

下面记录如何抓取ajax形式加载的网页数据:

目标:获取“https://movie.douban.com/typerank?type_name=%E5%89%A7%E6%83%85&type=11&interval_id=100:90&action=”下的网页数据

第一步:网页数据分析-----》特点:当列表条滚动到页面下方时数据自动加载,而页面的url并未发生变化

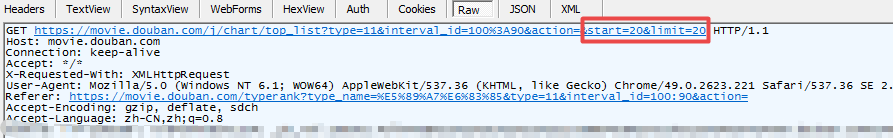

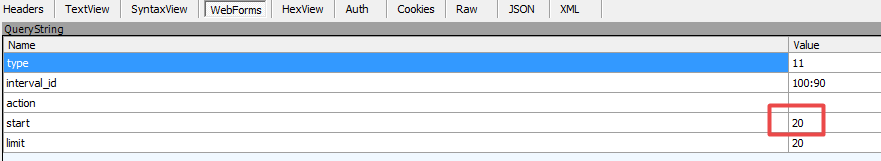

第二步:利用Fiddler抓包,如下图:

图一:请求数据

图二:form表单

通过抓包获取到数据规律:图二from表单中start对应数据和图一中的url中start对应数据随着每次加载而递增,其他数据未发生变化。对应这种规律我们便可构造相应请求获取数据

需注意,数据形式为json

代码如下:

1).urllib形式

import urllib2

import urllib

#此处的url为上述抓包获取的url去掉start以及limit,start以及limit数据后边以form表单的形式传入

url = ' https://movie.douban.com/j/chart/top_list?type=11&interval_id=100%3A90&action='

#请求投信息,伪造成浏览器,方式被反爬虫策略拦截

headers = {"User-Agent":"Mozilla/5.0 (Windows NT 6.1; Win64; x64; rv:60.0) Gecko/20100101 Firefox/60.0"}

#构建form表单

formdata = {

"start":"",

"limit":""

}

#urlencode()urllib中的函数,作用:将key:value形式的键值对转换为"key=value"形式的字符串

data = urllib.urlencode(formdata)

#构建request实例对象

request = urllib2.Request(url,data=data,headers=headers)

#发送请求并返回响应信息

response = urllib2.urlopen(request)

#注意此处的数据形式并不是html文档,而是json数据

json = response.read()

print html

2).request库的get请求代码

#coding=utf-8 import requests

url = ' https://movie.douban.com/j/chart/top_list?type=11&interval_id=100%3A90&action='

headers = {"User-Agent":"Mozilla/5.0 (Windows NT 6.1; Win64; x64; rv:60.0) Gecko/20100101 Firefox/60.0"}

data = {

"start":"",

"limit":"",

}

response = requests.get(url,params = data,headers = headers)

print response.text

3).request库的post请求

#coding=utf-8 import requests

url = ' https://movie.douban.com/j/chart/top_list?type=11&interval_id=100%3A90&action='

formdata = {

"start":"",

"limit":""

}

headers = {"User-Agent":"Mozilla/5.0 (Windows NT 6.1; Win64; x64; rv:60.0) Gecko/20100101 Firefox/60.0"}

response = requests.post(url,data=formdata,headers=headers)

print response.text

---恢复内容结束---

爬虫小例1:ajax形式的网页数据的抓取的更多相关文章

- 使用 Chrome 浏览器插件 Web Scraper 10分钟轻松实现网页数据的爬取

web scraper 下载:Web-Scraper_v0.2.0.10 使用 Chrome 浏览器插件 Web Scraper 可以轻松实现网页数据的爬取,不写代码,鼠标操作,点哪爬哪,还不用考虑爬 ...

- c# 正则表达式对网页进行内容抓取

原文 c# 正则表达式对网页进行内容抓取 搜索引擎中一个比较重要的环节就是从网页中抽取出有效内容.简单来说,就是吧HTML文本中的HTML标记去掉,留下我们用IE等浏览器打开HTML文档看到的部分(我 ...

- Python 网页投票信息抓取

最近学习python,为了巩固一下学过的知识,花了半天(主要还是因为自己正则表达式不熟)写了个小脚本来抓取一个网站上的投票信息,排名后进行输出. 抓取的网站网址是http://www.mudidi.n ...

- [Python爬虫] 之二十八:Selenium +phantomjs 利用 pyquery抓取网站排名信息

一.介绍 本例子用Selenium +phantomjs爬取中文网站总排名(http://top.chinaz.com/all/index.html,http://top.chinaz.com/han ...

- [Python爬虫] 之二十五:Selenium +phantomjs 利用 pyquery抓取今日头条网数据

一.介绍 本例子用Selenium +phantomjs爬取今日头条(http://www.toutiao.com/search/?keyword=电视)的资讯信息,输入给定关键字抓取资讯信息. 给定 ...

- 爬虫小探-Python3 urllib.request获取页面数据

使用Python3 urllib.request中的Requests()和urlopen()方法获取页面源码,并用re正则进行正则匹配查找需要的数据. #forex.py#coding:utf-8 ' ...

- 吴裕雄--天生自然PYTHON爬虫:使用BeautifulSoup解析中国旅游网页数据

import requests from bs4 import BeautifulSoup url = "http://www.cntour.cn/" strhtml = requ ...

- 吴裕雄--天生自然python爬虫:使用requests模块的get和post方式抓取中国旅游网站和有道翻译网站翻译内容数据

import requests url = 'http://www.cntour.cn/' strhtml = requests.get(url) print(strhtml.text) URL='h ...

- [Python爬虫] 之二十九:Selenium +phantomjs 利用 pyquery抓取节目信息信息

一.介绍 本例子用Selenium +phantomjs爬取节目(http://tv.cctv.com/epg/index.shtml?date=2018-03-25)的信息 二.网站信息 三.数据抓 ...

随机推荐

- 知识图谱之图数据库Neo4j

知识图谱中的知识是通过RDF结构来进行表示的,其基本单元是事实.每个事实是一个三元组(S, P, O),在实际系统中,按照存储方式的不同,知识图谱的存储可以分为基于表结构的存储和基于图结构的存储. 基 ...

- DG on Windows 10 S: 执行任意代码

DG on Windows 10 S: 执行任意代码 windows 10 S版本是什么鬼? 众所周知,我们使用的是windows 10企业版 LTSC.更准确一点,CMD运行winver,我的版本是 ...

- mysql(5.6及以下)解析json

转自:https://blog.csdn.net/weixin_33979203/article/details/87621768 #json解析函数 DELIMITER $$ DROP FUNCTI ...

- Mybatis-学习笔记(N)mybatis-generator 生成DAO、Mapper、entity

1.mybatis-generator 生成DAO.Mapper.entity 所需环境:jdk 所需jar包:mybatis-generator-core-1.3.5.jar.MySQL-conne ...

- 图——图的Dijkstra法最短路径实现

1,最短路径的概念: 1,从有向图中某一顶点(起始顶点)到达另一顶点(终止顶点)的路径中,其权值之和最小的路径: 2,问题的提法: 1,给定一个带权有向图 G 与起始顶点 v,求从 v 到 G 中其它 ...

- xss过滤与单例模式(对象的实例永远用一个)

kindeditor里面可以加入script代码,使用re可以过滤掉python有个专门的模块可以处理这种情况,beautifulsoup4 调用代码: content = XSSFilter().p ...

- struts2_对Map进行双层迭代

转自:struts2_对Map进行双层迭代 //后台数据 public String execute() throws Exception { Map<String, List<Produ ...

- nginx配置反向代理,解决前端开发的跨域问题

适用:开发和生产环境 配置如下 server { listen 10901; server_name res.pre.ices.red; #charset koi8-r; #access_log lo ...

- 锋利的jQuery ——jQuery中的事件和动画(四)

一.jQuery中的事件 1)加载DOM $(document).ready()和window.onload的区别 1>执行时机 $(document).ready(){} 方法内注册的事件, ...

- 豆壳CMS本地安装教程

DouPHP安装教程 一.下载DouPHP程序. 解压后得到三个文件夹 将upload文件夹里面的内容复制到wamp的www的文件夹. 二.打开浏览器,输入127.0.0.1. 勾选后选择下一步 注意 ...