一只简单的网络爬虫(基于linux C/C++)————Url处理以及使用libevent进行DNS解析

Url处理

爬虫里使用了两个数据结构来管理Url

下面的这个数据结构用来维护原始的Url,同时有一个原始Url的队列

//维护url原始字符串

typedef struct Surl {

char *url;

int level;//url抓取深度

int type;//抓取类型

} Surl;

原始的Url队列static queue <Surl *> surl_queue;//这个队列存放解析前的

下面的Url结构体用来维护解析后的url,同样的,配有一个url的队列

//解析后的

typedef struct Url {

char *domain;//域名

char *path;//路径

int port;//端口

char *ip;//IP

int level;//深度

} Url;解析后的url队列static queue<Url *> ourl_queue;//这个队列存放DNS解析后的

另外,采用一个map容器用来保存域名解析前后的url的主机名称和ip地址

static map<string, string> host_ip_map;//主机,ip的map容器采用这样的方式的原因是,DNS解析是一个比较浪费时间的过程,解析过的主机名我们将其与ip地址采用map关联起来,因为同一个html页面里可能会有多个url是同一个主机名的,这样一来我们可以直接在map容器中查找该主机名对应的ip,而不必每次都进行DNS解析,这样做可以达到提高效率的效果

两个队列的一些常见的操作(出入队列等)这里就不在弹了

下面看看一个url解析的函数

//解析域名,解析域名后surl队列中surl结构体会转化为url结构体放入url队列

void * urlparser(void *none)

{

Surl *url = NULL;

Url *ourl = NULL;

map<string, string>::const_iterator itr;

//event_base * base = event_base_new();

//evdns_base * dnsbase = evdns_base_new(base, 1);

//event_base_loop(base,EVLOOP_NONBLOCK);

while(1) {

pthread_mutex_lock(&sq_lock);

while (surl_queue.empty()) //surl队列为空则一直等待,直到被唤醒

{

pthread_cond_wait(&sq_cond, &sq_lock);

}

url = surl_queue.front();//取出surl队列中的url

surl_queue.pop();

pthread_mutex_unlock(&sq_lock);

ourl = surl2ourl(url);//原始的结构体转化为ourl

//在回调函数中解析完加进去的

itr = host_ip_map.find(ourl->domain);//在主机IP的map中寻找

if (itr == host_ip_map.end())//找不到的才需要解析,找到说明之前解析过了

{ // not found

//解析DNSdns resolve

event_base * base = event_init();//执行一次libevent库的初始化

evdns_init();//在使用任何解析器函数之前,必须调用evdns_init()函数初始化函数库

evdns_resolve_ipv4(ourl->domain, 0, dns_callback, ourl);//dns_callback回调函数

event_dispatch();

event_base_free(base);

//evdns_base_resolve_ipv4(dnsbase, ourl->domain, 0, dns_callback, ourl);

//event_base_loop(base, EVLOOP_ONCE | EVLOOP_NONBLOCK);

}

else

{

ourl->ip = strdup(itr->second.c_str());//之前解析过,直接拷贝

push_ourlqueue(ourl);//送入队列

}

}

//evdns_base_free(dnsbase, 0);

//event_base_free(base);

return NULL;

}

surl2ourl(Surl * surl)函数如下,主要是将原始的url进行分割,分离出域名和路径,端口等,然后填入解析后的url结构

//原始字符串Surl结构转化为url结构,

static Url * surl2ourl(Surl * surl)

{//calloc在动态分配完内存后,自动初始化该内存空间为零,而malloc不初始化,里边数据是随机的垃圾数据

Url *ourl = (Url *)calloc(1, sizeof(Url));

//strchr函数原型:extern char *strchr(const char *s,char c);查找字符串s中首次出现字符c的位置。

char *p = strchr(surl->url, '/');

if (p == NULL)//原始字符串不存在'/'

{

ourl->domain = surl->url;//直接是域名

ourl->path = surl->url + strlen(surl->url);//路径其实是空的

}

else

{

*p = '\0';//覆盖'/'

ourl->domain = surl->url;//提取域名

ourl->path = p+1;//提取路径

}

// port端口,冒号后面是端口

//查找字符在指定字符串中从正面开始的最后一次出现的位置

p = strrchr(ourl->domain, ':');//找最后一个出现的冒号

if (p != NULL)

{

*p = '\0';

ourl->port = atoi(p+1);

if (ourl->port == 0)

ourl->port = 80;

}

else //Url中若没有端口号,则是默认的80端口

{

ourl->port = 80;

}

// level

ourl->level = surl->level;

return ourl;

}urlparser函数主要完成了下面的工作,surl转化为url结构,查找map容器,如果是之前未解析的,采用lievent进行域名解析,然后加入map容器,url结构进入ourl队列

lievent的DNS解析

lievent的使用可以参考libevent Documentation

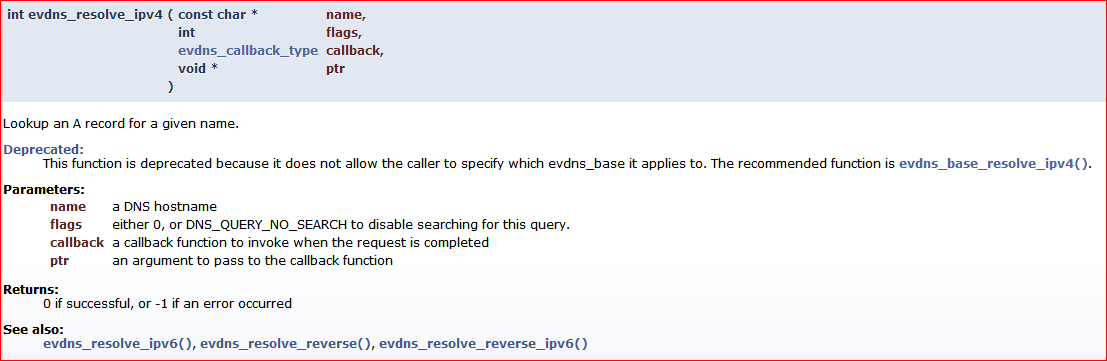

主要是使用了该函数

int evdns_resolve_ipv4 (const char *name,

int flags,

evdns_callback_type callback,

void * ptr

) 参数

name:是想要DNS解析的一个主机名

flags:可以填 0,或者 DNS_QUERY_NO_SEARCH 禁用搜索此查询

callback:是一个回调函数,在解析完成的时候会回调该函数

ptr: 一个传给回调函数的参数在回调函数中可以得到解析后的ip地址

//DNS解析回调函数

static void dns_callback(int result, char type, int count, int ttl, void *addresses, void *arg)

{

Url * ourl = (Url *)arg;

struct in_addr *addrs = (in_addr *)addresses;

if (result != DNS_ERR_NONE || count == 0)

{

SPIDER_LOG(SPIDER_LEVEL_WARN, "Dns resolve fail: %s", ourl->domain);

}

else

{

char * ip = inet_ntoa(addrs[0]);//网络字节序转化为主机字节序

SPIDER_LOG(SPIDER_LEVEL_DEBUG, "Dns resolve OK: %s -> %s", ourl->domain, ip);

host_ip_map[ourl->domain] = strdup(ip);//ip填入domain对应的ip

ourl->ip = strdup(ip);//ip填入ourl

push_ourlqueue(ourl);//加入队列

}

event_loopexit(NULL); // not safe for multithreads

}另外,在主函数中,专门开了一个线程用来进行url的DNS解析的

// 启动用于解析DNS的线程

int err = -1;

if ((err = create_thread(urlparser, NULL, NULL, NULL)) < 0)

{//urlparser在url.cpp中

SPIDER_LOG(SPIDER_LEVEL_ERROR, "创建Url解析线程失败: %s", strerror(err));

}只要原始的url队列不为空,则一直进行DNS的解析,解析后放入另一个队列,若原始url为空(还没有抓取其他的url),则一直在等待,使用的是条件变量

pthread_cond_wait(&sq_cond, &sq_lock);知道surl队列有url入队,被唤醒继续进行DNS解析的服务

//发送一个信号给另外一个正在处于阻塞等待状态的线程,

//使其脱离阻塞状态,继续执行.如果没有线程处在阻塞等待状态,

//pthread_cond_signal也会成功返回

if (surl_queue.size() == 1)

pthread_cond_signal(&sq_cond);一只简单的网络爬虫(基于linux C/C++)————Url处理以及使用libevent进行DNS解析的更多相关文章

- 一只简单的网络爬虫(基于linux C/C++)————开篇

最近学习开发linux下的爬虫,主要是参考了该博客及其他一些网上的资料.网络爬虫(又被称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者),是一种按照一定的规则,自动地抓取万维网信息 ...

- 一只简单的网络爬虫(基于linux C/C++)————线程相关

爬虫里面采用了多线程的方式处理多个任务,以便支持并发的处理,把主函数那边算一个线程的话,加上一个DNS解析的线程,以及我们可以设置的max_job_num值,最多使用了1+1+max_job_num个 ...

- 一只简单的网络爬虫(基于linux C/C++)————主事件流程

该爬虫的主事件流程大致如下: 1.获取命令行参数,执行相应操作 2.读取配置文件,解析得到各种设置 3.载入各种模块 4.种子入队,开启DNS解析线程(原始队列不为空时解析) 5.创建epoll,开启 ...

- 一只简单的网络爬虫(基于linux C/C++)————浅谈并发(IO复用)模型

Linux常用的并发模型 Linux 下设计并发网络程序,有典型的 Apache 模型( Process Per Connection ,简称 PPC ), TPC ( Thread Per Conn ...

- 一只简单的网络爬虫(基于linux C/C++)————支持动态模块加载

插件在软件设计中有很大的好处,可以方便地扩展各种功能,使用插件技术能够在分析.设计.开发.项目计划.协作生产和产品扩展等很多方面带来好处: (1)结构清晰.易于理解.由于借鉴了硬件总线的结构,而且各个 ...

- 一只简单的网络爬虫(基于linux C/C++)————socket相关及HTTP

socket相关 建立连接 网络通信中少不了socket,该爬虫没有使用现成的一些库,而是自己封装了socket的相关操作,因为爬虫属于客户端,建立套接字和发起连接都封装在build_connect中 ...

- 一只简单的网络爬虫(基于linux C/C++)————守护进程

守护进程,也就是通常说的Daemon进程,是Linux中的后台服务进程.它是一个生存期较长的进程,通常独立于控制终端并且周期性地执行某种任务或等待处理某些发生的事件.守护进程常常在系统引导装入时启动, ...

- 一只简单的网络爬虫(基于linux C/C++)————读取命令行参数及日志宏设计

linux上面的程序刚开始启动的时候一般会从命令行获取某些参数,比如以守护进程运行啊什么的,典型的例子就是linux下的man,如下图所示 实现该功能可以使用getopt函数实现,该函数在头文件uni ...

- 一只简单的网络爬虫(基于linux C/C++)————利用正则表达式解析页面

我们向一个HTTP的服务器发送HTTP的请求后,服务器会返回可能一个HTML页面(当然也可以是其他的资源),我们可以利用返回的HTML页面,在其中寻找其他的Url,例如我们可以这样在浏览器上查看一下H ...

随机推荐

- spark模型error java.lang.IllegalArgumentException: Row length is 0

failure: Lost task 18.3 in stage 17.0 (TID 59784,XXXXX, executor 19): java.lang.IllegalArgumentExcep ...

- 常用App用户体验找茬

冯晓云: 哔哩哔哩手机客户端:视频播放只允许横屏全屏:还有长视频的“5分钟诅咒”,遇到网速不好的时候是个大写的悲剧: 必应词典UWP版本:主页新闻链接跳转后,一些页面不支持划词取译,当然本身各个页面也 ...

- E - Dividing Chocolate ATcoder

题目大意:切割图形,给你一个非0即1的矩阵,将它切割成多个长方形,使每个小长方形中1的个数不得多于k个,切割的规则,要么切一整行,要么是一整列. 题解: 二进制枚举. 注意行数最大才是10.用二进制枚 ...

- Laravel路由不生效,除了首页全部404解决方案Nginx环境

原因: 请求根目录/ (http://www.xxx.com/public/),会请求public/index.php 输入其他路由地址时,会把你的请求定位到:http://www.xxx.com/i ...

- eclipse集成 json editor plugin插件

打开eclipse 找到: help--->install new software ——>add name:jsoneditor location:https://marketplace ...

- api接口安全

API接口安全 在做app开发中,如何保证api的接口安全,不被其他app去调用? 接口安全的措施很多,今天记录一个常用的措施 签名: 前台想要调用接口,需要使用几个参数生成签名: 时间戳:当前时间 ...

- WGCLOUD如何监控数据库

WGCLOUD默认是支持mysql,sqlserver,oracle,postgresql数据库监控,不用添加任何配置. DB2也是支持的,但是需要做一些小修改. 因为db2驱动包版本比较多,所以要自 ...

- iview使用之怎样通过render函数在table组件表头添加图标及判断多个状态

在实际项目开发中,我们经常会用到各种各样的表格,比如在表格中填加下拉菜单,按钮,图标及可以根据状态显示对应文字等等,因为这段时间一直在做后台管理系统,所以表格用的就比较多,当然UI组件库我用的是ivi ...

- 一篇文章掌握网页解析神器——xpath

学爬虫不会xpath解析数据? 今天老师带你一堂课带你从零开始精通xpath,从此轻松提取网页信息. 我们在爬虫的过程中,经常会遇到html字符串数据,很多我们需要的数据不是作为标签的文本就是作标签的 ...

- 笔记本安装ubuntu18.08,解决过程中出现的各种问题

笔记本安装ubuntu18.08,解决过程中出现的各种问题 1.做启动U盘 在官网下载要安装的镜像,使用软碟通制作U盘安装盘 文件 -- 打开 然后 启动 -- 写入硬盘映像 -- 选择你的u盘 -- ...