shell及Python爬虫实例展示

1.shell爬虫实例:

[root@db01 ~]# vim pa.sh

#!/bin/bash

www_link=http://www.cnblogs.com/clsn/default.html?page=

for i in {1..8}

do

a=`curl ${www_link}${i} 2>/dev/null|grep homepage|grep -v "ImageLink"|awk -F "[><\"]" '{print $7"@"$9}' >>bb.txt`#@为自己

指定的分隔符.这行是获取内容及内容网址

done

egrep -v "pager" bb.txt >ma.txt #将处理后,只剩内容和内容网址的放在一个文件里

b=`sed "s# ##g" ma.txt` #将文件里的空格去掉,因为for循环会将每行的空格前后作为两个变量,而不是一行为一个变量,这个坑花

了我好长时间。

for i in $b

do

c=`echo $i|awk -F @ '{print $1}'` #c=内容网址

d=`echo $i|awk -F @ '{print $2}'` #d=内容

echo "<a href='${c}' target='_blank'>${d}</a> " >>cc.txt #cc.txt为生成a标签的文本

done

爬虫结果显示:归档文件中惨绿少年的爬虫结果

注意:爬取结果放入博客应在a标签后加 的空格符或其他,博客园默认不显示字符串

的空格符或其他,博客园默认不显示字符串

2、

2.1Python爬虫学习

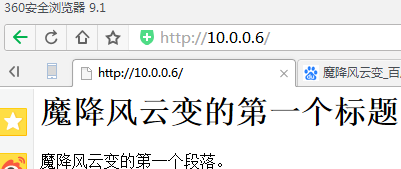

爬取这个网页

import urllib.request

# 网址

url = "http://10.0.0.6/"

# 请求

request = urllib.request.Request(url)

# 爬取结果

response = urllib.request.urlopen(request)

data = response.read()

# 设置解码方式

data = data.decode('utf-8')

# 打印结果

print(data)

结果:

E:\python\python\python.exe C:/python/day2/test.py

<html>

<meta http-equiv="Content-Type" content="text/html;charset=utf-8">

<body>

<h1>魔降风云变的第一个标题</h1>

<p>魔降风云变的第一个段落。</p>

</body>

</html>

print(type(response))

结果:

<class 'http.client.HTTPResponse'>

print(response.geturl())

结果:

http://10.0.0.6/

print(response.info())

结果:

Server: nginx/1.12.

Date: Fri, Mar :: GMT

Content-Type: text/html

Content-Length:

Last-Modified: Fri, Mar :: GMT

Connection: close

ETag: "5a98ff58-b8"

Accept-Ranges: bytes

print(response.getcode())

结果:

2.2爬取网页代码并保存到电脑文件

import urllib.request

# 网址

url = "http://10.0.0.6/"

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) '

'Chrome/51.0.2704.63 Safari/537.36'}

req = urllib.request.Request(url=url, headers=headers)

res = urllib.request.urlopen(req)

data = res.read()

data = data.decode('utf-8')

# 打印抓取的内容

print(data)

结果:

<html>

<meta http-equiv="Content-Type" content="text/html;charset=utf-8">

<body>

<h1>魔降风云变的第一个标题</h1>

<p>魔降风云变的第一个段落。</p>

</body>

</html>

import urllib.request

# 定义保存函数

def saveFile(data): #------------------------------------------

path = "E:\\content.txt"

f = open(path, 'wb')

f.write(data)

f.close() #------------------------------------------

# 网址

url = "http://10.0.0.6/"

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) '

'Chrome/51.0.2704.63 Safari/537.36'}

req = urllib.request.Request(url=url, headers=headers)

res = urllib.request.urlopen(req)

data = res.read()

# 也可以把爬取的内容保存到文件中

saveFile(data) #******************************************

data = data.decode('utf-8')

# 打印抓取的内容

print(data)

添加保存文件的函数并执行的结果:

# # 打印爬取网页的各类信息

print(type(res))

print(res.geturl())

print(res.info())

print(res.getcode())

结果:

<class 'http.client.HTTPResponse'>

http://10.0.0.6/

Server: nginx/1.12.

Date: Fri, Mar :: GMT

Content-Type: text/html

Content-Length:

Last-Modified: Fri, Mar :: GMT

Connection: close

ETag: "5a98ff58-b8"

Accept-Ranges: bytes

2.3爬取图片

import urllib.request, socket, re, sys, os

# 定义文件保存路径

targetPath = "E:\\"

def saveFile(path):

# 检测当前路径的有效性

if not os.path.isdir(targetPath):

os.mkdir(targetPath) # 设置每个图片的路径

pos = path.rindex('/')

t = os.path.join(targetPath, path[pos + 1:])

return t

# 用if __name__ == '__main__'来判断是否是在直接运行该.py文件

# 网址

url = "http://10.0.0.6/"

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) ' 'Chrome/51.0.2704.63 Safari/537.36'

}

req = urllib.request.Request(url=url, headers=headers)

res = urllib.request.urlopen(req)

data = res.read()

print(data)

for link, t in set(re.findall(r'(http:[^s]*?(jpg|png|gif))', str(data))):

print(link)

try:

urllib.request.urlretrieve(link, saveFile(link))

except:

print('失败')

2.31

import urllib.request, socket, re, sys, os

url = "http://10.0.0.6/"

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) ' 'Chrome/51.0.2704.63 Safari/537.36'

}

req = urllib.request.Request(url=url, headers=headers)

res = urllib.request.urlopen(req)

data = res.read()

print(req)

print(res)

print(data)

print(str(data))

结果:

<urllib.request.Request object at 0x0000000001ECD9E8>

<http.client.HTTPResponse object at 0x0000000002D1B128>

b'<html>\n<meta http-equiv="Content-Type" content="text/html;charset=utf-8">\n<body>\n<img src="http://10.0.0.6/ma1.png" />\n<img src="http://10.0.0.6/ma2.jpg" />\n<h1>\xe9\xad\x94\xe9\x99\x8d\xe9\xa3\x8e\xe4\xba\x91\xe5\x8f\x98\xe7\x9a\x84\xe7\xac\xac\xe4\xb8\x80\xe4\xb8\xaa\xe6\xa0\x87\xe9\xa2\x98</h1>\n<p>\xe9\xad\x94\xe9\x99\x8d\xe9\xa3\x8e\xe4\xba\x91\xe5\x8f\x98\xe7\x9a\x84\xe7\xac\xac\xe4\xb8\x80\xe4\xb8\xaa\xe6\xae\xb5\xe8\x90\xbd\xe3\x80\x82</p>\n</body>\n</html>\n'

b'<html>\n<meta http-equiv="Content-Type" content="text/html;charset=utf-8">\n<body>\n<img src="http://10.0.0.6/ma1.png" />\n<img src="http://10.0.0.6/ma2.jpg" />\n<h1>\xe9\xad\x94\xe9\x99\x8d\xe9\xa3\x8e\xe4\xba\x91\xe5\x8f\x98\xe7\x9a\x84\xe7\xac\xac\xe4\xb8\x80\xe4\xb8\xaa\xe6\xa0\x87\xe9\xa2\x98</h1>\n<p>\xe9\xad\x94\xe9\x99\x8d\xe9\xa3\x8e\xe4\xba\x91\xe5\x8f\x98\xe7\x9a\x84\xe7\xac\xac\xe4\xb8\x80\xe4\xb8\xaa\xe6\xae\xb5\xe8\x90\xbd\xe3\x80\x82</p>\n</body>\n</html>\n'

2.32

import urllib.request, socket, re, sys, os

url = "http://10.0.0.6/"

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) ' 'Chrome/51.0.2704.63 Safari/537.36'

}

req = urllib.request.Request(url=url, headers=headers)

res = urllib.request.urlopen(req)

data = res.read()

for link in set(re.findall(r'(http:[^s]*?(jpg|png|gif))', str(data))):

print(link)

结果:

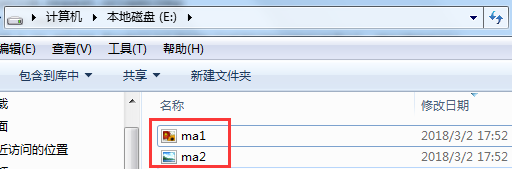

('http://10.0.0.6/ma2.jpg', 'jpg')

('http://10.0.0.6/ma1.png', 'png')

2.33

for link,t in set(re.findall(r'(http:[^s]*?(jpg|png|gif))', str(data))):

print(link)

结果:

http://10.0.0.6/ma1.png

http://10.0.0.6/ma2.jpg

2.34

import urllib.request, socket, re, sys, os

# 定义文件保存路径

targetPath = "E:\\"

def saveFile(path):

# 检测当前路径的有效性

if not os.path.isdir(targetPath):

os.mkdir(targetPath) # 设置每个图片的路径

pos = path.rindex('/')

t = os.path.join(targetPath, path[pos + 1:])

return t

# 用if __name__ == '__main__'来判断是否是在直接运行该.py文件

# 网址

url = "http://10.0.0.6/"

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) ' 'Chrome/51.0.2704.63 Safari/537.36'

}

req = urllib.request.Request(url=url, headers=headers)

res = urllib.request.urlopen(req)

data = res.read()

for link,t in set(re.findall(r'(http:[^s]*?(jpg|png|gif))', str(data))):

print(link)

try:

urllib.request.urlretrieve(link, saveFile(link))

except:

print('失败')

结果:

http://10.0.0.6/ma2.jpg

http://10.0.0.6/ma1.png

2.4登录知乎

参考:http://blog.csdn.net/fly_yr/article/details/51535676

shell及Python爬虫实例展示的更多相关文章

- Python爬虫实例:爬取B站《工作细胞》短评——异步加载信息的爬取

很多网页的信息都是通过异步加载的,本文就举例讨论下此类网页的抓取. <工作细胞>最近比较火,bilibili 上目前的短评已经有17000多条. 先看分析下页面 右边 li 标签中的就是短 ...

- Python爬虫实例:爬取猫眼电影——破解字体反爬

字体反爬 字体反爬也就是自定义字体反爬,通过调用自定义的字体文件来渲染网页中的文字,而网页中的文字不再是文字,而是相应的字体编码,通过复制或者简单的采集是无法采集到编码后的文字内容的. 现在貌似不少网 ...

- Python爬虫实例:爬取豆瓣Top250

入门第一个爬虫一般都是爬这个,实在是太简单.用了 requests 和 bs4 库. 1.检查网页元素,提取所需要的信息并保存.这个用 bs4 就可以,前面的文章中已经有详细的用法阐述. 2.找到下一 ...

- Python 爬虫实例

下面是我写的一个简单爬虫实例 1.定义函数读取html网页的源代码 2.从源代码通过正则表达式挑选出自己需要获取的内容 3.序列中的htm依次写到d盘 #!/usr/bin/python import ...

- Python爬虫实例:糗百

看了下python爬虫用法,正则匹配过滤对应字段,这里进行最强外功:copy大法实践 一开始是直接从参考链接复制粘贴的,发现由于糗百改版导致失败,这里对新版html分析后进行了简单改进,把整理过程记录 ...

- python爬虫实例大全

WechatSogou [1]- 微信公众号爬虫.基于搜狗微信搜索的微信公众号爬虫接口,可以扩展成基于搜狗搜索的爬虫,返回结果是列表,每一项均是公众号具体信息字典. DouBanSpider [2]- ...

- python爬虫实例——爬取歌单

学习自<<从零开始学python网络爬虫>> 爬取酷狗歌单,保存入csv文件 直接上源代码:(含注释) import requests #用于请求网页获取网页数据 from b ...

- Python 爬虫实例(爬百度百科词条)

爬虫是一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成.爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入 ...

- Python爬虫实例(五) requests+flask构建自己的电影库

目标任务:使用requests抓取电影网站信息和下载链接保存到数据库中,然后使用flask做数据展示. 爬取的网站在这里 最终效果如下: 主页: 可以进行搜索:输入水形物语 点击标题进入详情页: 爬虫 ...

随机推荐

- 1080Ti+ubuntu14.04

我来回折腾了几天,从装了好几次系统,后来问了我同学才知道原来是驱动版本的问题,唉,第一次跑去nvidia看他们的online doc.我是相当的郁闷,敢不敢弄得简单点啊,我是电脑小白啊,硬件一窍不通啊 ...

- win10永久激活方法-备份

百度经验 > 游戏/数码 > 电脑 > 笔记本电脑 Win10专业版永久激活方法 听语音 3780404人看了这个视频 返回 暂停 重播 播放 x 1秒后即将播放下一条视 ...

- iOS 崩溃日志分析(个人总结,最实用)

iOS 崩溃日志分析(个人总结,最实用) 要分析奔溃日志需要三个文件:crash日志,symbolicatecrash分析工具,.dSYM符号集 0. 在桌面创建一个crash文件夹 1. 需要Xco ...

- zepto 基础知识(6)

101.$.ajax $.ajax(options) 类型:XMLttpRequest 执行Ajax请求.他可能是本地资源,或者通过支持HTTP access control的浏览器 或者通过 JSO ...

- #leetcode刷题之路3-无重复字符的最长子串

给定一个字符串,请你找出其中不含有重复字符的 最长子串 的长度. 示例 1:输入: "abcabcbb"输出: 3 解释: 因为无重复字符的最长子串是 "abc" ...

- 利用html2canvas将当前网页保存为图片.

先分析下这个技术可实现的方式,以及优缺点吧! 前端实现 缺点是:兼容性查,需要高级浏览器支持,因为需要支持 canvas 绘图,还有就是会操作 html5 canvas api.(如果不会使用canv ...

- PHPPCRE正则解析

一.前言 前面的博客里,有对字符集的解析.这里就不是字符集的事儿了,在PHP中很多函数的处理默认是unicode中的UTF-8编码格式.那么废话不多说,直接开始正题. 二.PHP函数mb_split解 ...

- php Laravel5.5 表单验证常用的验证规则,以及示例

namespace App\Http\Controllers; use App\Models\Users; use Illuminate\Support\Facades\Validator; use ...

- java初级应用:环境安装及配置

相关文件下载: jdk下载路径:http://www.oracle.com/technetwork/java/javase/downloads/index.html eclipse下载路径:https ...

- linux文件操作篇 (四) 目录操作

#include <sys/stat.h>#include <unistd.h>#include <dirent.h> //创建文件夹 路径 掩码 int mkdi ...