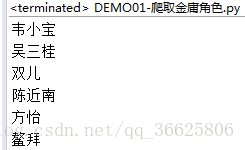

python3爬虫爬取金庸小说所有角色

# -*- coding:utf-8 -*-

import requests

from bs4 import BeautifulSoup

url = 'http://www.jinyongwang.com/data/renwu/';

def getHTML(url):

r = requests.get(url)

return r.content

def parseHTML(html):

soup = BeautifulSoup(html,'html.parser')

body = soup.body

main = body.find('div',attrs={'class':'main'})

booklist = main.find('div',attrs={'class':'booklist'})

for datapice in booklist.find_all('div',attrs={'class':'datapice'}):

for a in datapice.find_all('a'):

print(a.get_text().replace(' ',''))

html = getHTML(url);

print(parseHTML(html))python3爬虫爬取金庸小说所有角色的更多相关文章

- 使用scrapy爬取金庸小说目录和章节url

刚接触使用scrapy的时候,如果一开始就想实现特别复杂的配置,显然是不太现实的,用一些小的例子可以帮助自己理解各个模块. 今天的目标:爬取http://www.luoxia.com/shendiao ...

- Python爬虫爬取全书网小说,程序源码+程序详细分析

Python爬虫爬取全书网小说教程 第一步:打开谷歌浏览器,搜索全书网,然后再点击你想下载的小说,进入图一页面后点击F12选择Network,如果没有内容按F5刷新一下 点击Network之后出现如下 ...

- python3爬虫爬取网页思路及常见问题(原创)

学习爬虫有一段时间了,对遇到的一些问题进行一下总结. 爬虫流程可大致分为:请求网页(request),获取响应(response),解析(parse),保存(save). 下面分别说下这几个过程中可以 ...

- python3 爬虫---爬取糗事百科

这次爬取的网站是糗事百科,网址是:http://www.qiushibaike.com/hot/page/1 分析网址,参数''指的是页数,第二页就是'/page/2',以此类推... 一.分析网页 ...

- python3 爬虫---爬取豆瓣电影TOP250

第一次爬取的网站就是豆瓣电影 Top 250,网址是:https://movie.douban.com/top250?start=0&filter= 分析网址'?'符号后的参数,第一个参数's ...

- python3 爬虫爬取深圳公租房轮候库(深圳房网)

深圳公租房轮候库已经朝着几十万人的规模前进了,这是截至16年10月之前的数据了,贴上来大家体会下 所以17年已更新妥妥的10W+ 今天就拿这个作为爬虫的练手项目 1.环境准备: 操作系统:win10 ...

- python3爬虫-爬取新浪新闻首页所有新闻标题

准备工作:安装requests和BeautifulSoup4.打开cmd,输入如下命令 pip install requests pip install BeautifulSoup4 打开我们要爬取的 ...

- python3爬虫-爬取58同城上所有城市的租房信息

from fake_useragent import UserAgent from lxml import etree import requests, os import time, re, dat ...

- python3爬虫爬取猫眼电影TOP100(含详细爬取思路)

待爬取的网页地址为https://maoyan.com/board/4,本次以requests.BeautifulSoup css selector为路线进行爬取,最终目的是把影片排名.图片.名称.演 ...

随机推荐

- HEALER

项目介绍: 专注是一款时间管理应用,可以帮你管理时间,制定计划,让你保持专注,从快节奏的当下抽离,进入另一个平和安静的时空,以获得更好的工作和学习效率. 主模块(专注):设置分类.专注时长.简介,点击 ...

- Proto3:C++代码生成指南

本章节实际上是介绍Protocol Buffer编译器从给定的protocol定义中生成的C++代码.所有proto2和proto3生成的代码不同之处都会高亮标出 --- 需要注意的是这些不同之处只是 ...

- Gnome Ubuntu16安装Nvidia显卡396驱动,CUDA9.2以及cudnn9.2

深度学习环境配置,安装Nvidia显卡驱动,CUDA以及cudnn OS:ubuntu 16.04;driver: nvidia 396;CUDA: 9.2cudnn: 9.2 卸载原有Nvidia驱 ...

- Dizcuz站点部署-包教会

Dizcuz站点部署-包教会-有需要请联系小编! 小编微信号:wvqusrtg

- C++走向远洋——34(友元函数,成员函数和一般函数的区别)

*/ * Copyright (c) 2016,烟台大学计算机与控制工程学院 * All rights reserved. * 文件名:youyuan.cpp * 作者:常轩 * 微信公众号:Worl ...

- Logstash实践

转载请注明出处:https://www.cnblogs.com/shining5/p/9542710.html Logstash简介 一个开源的数据收集引擎,具有实时数据传输能力,可以统一过滤来自不同 ...

- 一起了解 .Net Foundation 项目 No.10

.Net 基金会中包含有很多优秀的项目,今天就和笔者一起了解一下其中的一些优秀作品吧. 中文介绍 中文介绍内容翻译自英文介绍,主要采用意译.如与原文存在出入,请以原文为准. LLILC LLILC ( ...

- Dart 运行速度测评与比较

引言 Dart 是一门优秀的跨平台语言,尽管生态方面略有欠缺,但无疑作为一门编程语言来说,Dart 是很优美,很健壮的,同时也引入了一些先进的编程范式,值得去学习. 测试内容 现在,我们就来测评一下D ...

- 前后端分离下的跨域CAS请求

最重要的两点: ajax请求跨域的时候,默认不会携带cookie. 请求分为普通请求(HttpRequest)和Ajax请求(XMLHttpRequest) 先屡一下跨域CAS认证的流程: 前端发起a ...

- php+mysql开发一个最简单的在线题库,在线做题系统!

题库,对于教育机构,学校,在线教育,是很有必要的,网上也有不少的第三方在线题库系统,但是本次案例,会让有需要的人了解题库的开发思路,其实很简单,无非就是一个表单验证,数据库验证. 1.先构建表单数据2 ...