【二】Spark 核心

spark 核心

spark core

RDD创建 >>> RDD转换 >>> RDD缓存 >>> RDD行动 >>> RDD输出

RDD[Resilient Distributed Dataset]

它是一个弹性分布式数据集,具有良好的通用性、容错性与并行处理数据的能力,为用户屏蔽了底层对数据的复杂抽象和处理,为用户提供了一组方便的数据转换与求值方法。

弹性

- 存储弹性:n内存与磁盘d额自动切换

- 容错弹性:数据丢失可以自动恢复

- j计算的弹性:计算出错重试机制

- 分片弹性:根据需要重新分片

容错

通常在不同机器上备份数据或者记录数据更新的方式完成容错,但这种对任务密集型任务代价很高

RDD采用数据应用变换(map,filter,join),若部分数据丢失,RDD拥有足够的信息得知这部分数据是如何计算得到的,可通过重新计算来得到丢失的数据

这种恢复数据方法很快,无需大量数据复制操作,可以认为Spark是基于RDD模型的系统

懒操作

- 延迟计算,action的时候才操作

瞬时性

- 用时才产生,用完就释放

Spark允许从以下四个方面构建RDD

- 从共享文件系统中获取,如从HDFS中读数据构建RDD

val RDD = sc.textFile(“/xxx/yyy/file”)

- 通过现有RDD转换得到

val RDD = a.map(x => (x, 1))

- 定义一个scala数组

val RDD = sc.parallelize(1 to 10, 1)

- 有一个已经存在的RDD通过持久化操作生成

val RDD = a.persist(), a. saveAsHadoopFile(“/xxx/yyy/zzz”)

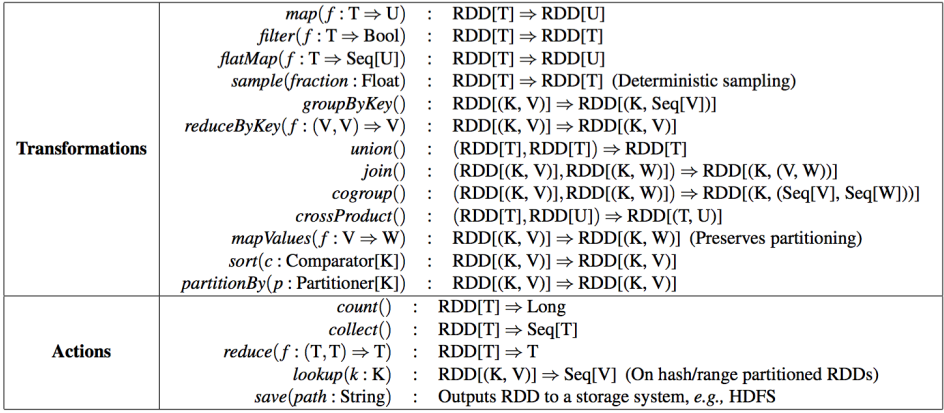

Spark针对RDD提供两类操作:transformations和action

transformations是RDD之间的变换,action会对数据执行一定的操作

transformations采用懒策略,仅在对相关RDD进行action提交时才触发计算

每个RDD包含了数据分块/分区(partition)的集合,每个partition是不可分割的

实际数据块的描述(实际数据到底存在哪,或者不存在)

其值依赖于哪些partition

与父RDD的依赖关系(rddA=>rddB)

宽依赖:B的每个partition依赖于A的所有partition

- 比如groupByKey、 reduceByKey、 join……,由A产生B时会先对A做shuffle分桶

窄依赖: B的每个partition依赖于A的常数个partition

- 比如map、 filter、 union……

RDD 依赖关系

窄依赖

每一个父RDD的Partition最多被子RDD的一个Partition使用

宽依赖

多个RDD的partition会依赖同一个父RDD的partition,会引起shuffle

【二】Spark 核心的更多相关文章

- spark浅谈(2):SPARK核心编程

一.SPARK-CORE 1.spark核心模块是整个项目的基础.提供了分布式的任务分发,调度以及基本的IO功能,Spark使用基础的数据结构,叫做RDD(弹性分布式数据集),是一个逻辑的数据分区的集 ...

- Spark核心—RDD初探

本文目的 最近在使用Spark进行数据清理的相关工作,初次使用Spark时,遇到了一些挑(da)战(ken).感觉需要记录点什么,才对得起自己.下面的内容主要是关于Spark核心-RDD的相关 ...

- Spark 核心篇-SparkContext

本章内容: 1.功能描述 本篇文章就要根据源码分析SparkContext所做的一些事情,用过Spark的开发者都知道SparkContext是编写Spark程序用到的第一个类,足以说明SparkCo ...

- Spark 核心篇-SparkEnv

本章内容: 1.功能概述 SparkEnv是Spark的执行环境对象,其中包括与众多Executor执行相关的对象.Spark 对任务的计算都依托于 Executor 的能力,所有的 Executor ...

- Netty 源码 Channel(二)核心类

Netty 源码 Channel(二)核心类 Netty 系列目录(https://www.cnblogs.com/binarylei/p/10117436.html) 一.Channel 类图 二. ...

- 科普Spark,Spark核心是什么,如何使用Spark(1)

科普Spark,Spark是什么,如何使用Spark(1)转自:http://www.aboutyun.com/thread-6849-1-1.html 阅读本文章可以带着下面问题:1.Spark基于 ...

- 2017.3.31 spring mvc教程(二)核心流程及配置详解

学习的博客:http://elf8848.iteye.com/blog/875830/ 我项目中所用的版本:4.2.0.博客的时间比较早,11年的,学习的是Spring3 MVC.不知道版本上有没有变 ...

- 大数据体系概览Spark、Spark核心原理、架构原理、Spark特点

大数据体系概览Spark.Spark核心原理.架构原理.Spark特点 大数据体系概览(Spark的地位) 什么是Spark? Spark整体架构 Spark的特点 Spark核心原理 Spark架构 ...

- spark核心优化详解

大家好!转眼又到了经验分享的时间了.吼吼,我这里没有摘要也没有引言,只有单纯的经验分享,请见谅哦! 言归正传,目前在大数据领域能够提供的核心计算的工具,如离线计算hadoop生态圈的mr计算模型,以及 ...

随机推荐

- C#实现字符串相似度算法

字符串的相似性比较应用场合很多,像拼写纠错.文本去重.上下文相似性等. 评价字符串相似度最常见的办法就是: 把一个字符串通过插入.删除或替换这样的编辑操作,变成另外一个字符串,所需要的最少编辑次数,这 ...

- package.json作用

这个文档的内容是你必须要知道的,它必须是JSON文本格式.每个项目的根目录下面,一般都有一个package.json文件,定义了这个项目所需要的各种模块,以及项目的配置信息(比如名称.版本.许可证等元 ...

- NAT原理简介、各种 ADSL Modem 及路由器的端口映射方法

NAT原理简介 NAT英文全称是“Network Address Translation”,中文意思是“网络地址转换”,它是一个IETF(Internet Engineering Task Force ...

- SpringMvc学习---基础知识考核

SpringMVC 1.SpringMVC的工作流程 流程 : 1.用户发送请求至前端控制器DispatcherServlet2.DispatcherServlet收到请求调用HandlerMappi ...

- JavaScript学习---JavaScript深入学习

对象的概念 对象分类[3种]: ECMScript(JS自己的对象), BOM(浏览器对象) DOM(文档对象,操作HTML的) 11种内置对象: Array ,String ...

- .htaccess详解及.htaccess参数说明

.htaccess文件(或者”分布式配置文件”)提供了针对目录改变配置的方法, 即,在一个特定的文档目录中放置一个包含一个或多个指令的文件, 以作用于此目录及其所有子目录.作为用户,所能使用的命令受到 ...

- 新增检查sql脚本是否符合ANSI编码格式

'******************************************************************* '作用:transfer转换文件编码格式 '参数含义:inco ...

- Android sdk manager 更新 5.0 太难了,终于解决

由于众所周知的原因,必须在hosts中增加一些网址对应,才可以更新 203.208.46.146 www.google.com 203.208.46.1 plus.google.com 203.208 ...

- [UOJ 0034] 多项式乘法

#34. 多项式乘法 统计 描述 提交 自定义测试 这是一道模板题. 给你两个多项式,请输出乘起来后的多项式. 输入格式 第一行两个整数 nn 和 mm,分别表示两个多项式的次数. 第二行 n+1n+ ...

- c++计算器后续(1)

自娱自乐: 大概是一直在说的代码规范,大概是玩一玩,以上. 代码规范: 参考原文:链接 相关节选: 4 程序的版式 4.4规则:较长的语句(>80字符)要分成多行书写. 4.5规则:不允许把多个 ...