spark集群搭建(三台虚拟机)——spark集群搭建(5)

!!!该系列使用三台虚拟机搭建一个完整的spark集群,集群环境如下:

virtualBox5.2、Ubuntu14.04、securecrt7.3.6_x64英文版(连接虚拟机)

jdk1.7.0、hadoop2.6.5、zookeeper3.4.5、Scala2.12.6、kafka_2.9.2-0.8.1、spark1.3.1-bin-hadoop2.6

本文在前面基础上搭建spark

一、spark1

下面操作在spark1上:

1、spark(spark1.3.1-bin-hadoop2.6)下载解压重命名

2、配置环境变量

export SPARK_HOME=/usr/local/bigdata/spark

export PATH=$PATH:$SPARK_HOME/bin

export CLASSPATH=.:$CLASSPATH:$JAVA_HOME/lib:$JAVA_HOME/jre/lib

修改配置文件

1、spark-env.sh

$ cd ./spark/conf #进入spark的conf目录下

$ mv spark-env.sh.template spark-env.sh

$ vim spark-env.sh

添加如下配置

export JAVA_HOME=/usr/local/bigdata/jdk

export SCALA_HOME=/usr/local/bigdata/scala

export SPARK_MASTER_IP=192.168.43.XXX

export SPARK_WORKER_MEMORY=1g

export HADOOP_CONF_DIR=/usr/local/bigdata/hadoop/etc/hadoop

2、slaves

$ mv slaves.template slaves

$ vim slaves

添加三台主机名

spark1

spark2

spark3

二、spark2和spark3

1、拷贝spark到另外两台机器上

root@spark1:/usr/local/bigdata# scp -r spark root@spark2://usr/local/bigdata/

root@spark1:/usr/local/bigdata# scp -r spark root@spark3://usr/local/bigdata/

2、同理配置spark2和spark3的环境变量,或者直接把环境变量文件拷贝过去

三、启动spark

进入spark的sbin目录下,执行:

$ ./start-all.sh

此时查看jps,spark1上有Master

root@spark1:/usr/local/bigdata/spark/sbin# jps

Worker

NodeManager

SecondaryNameNode

Jps

NameNode

Master

ResourceManager

DataNode

spark2

root@spark2:/usr/local/bigdata# jps

Jps

NodeManager

Worker

DataNode

spark3

root@spark3:/usr/local/bigdata# jps

Jps

NodeManager

Worker

DataNode

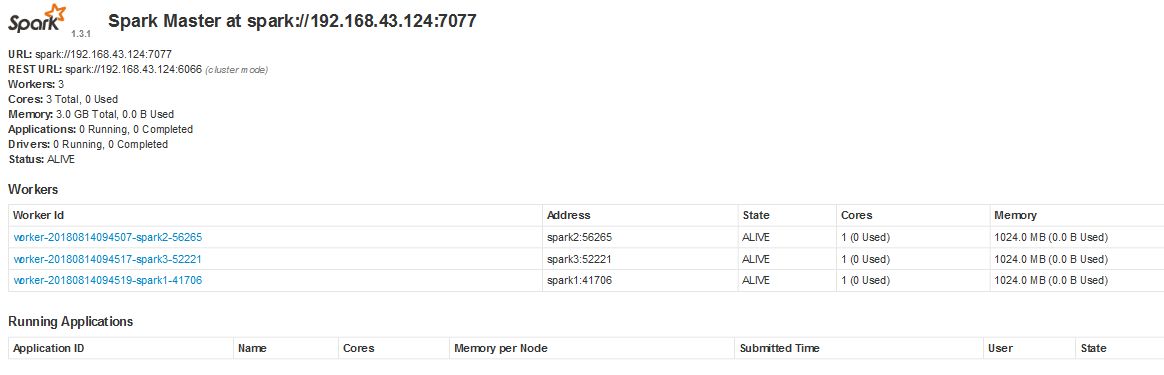

浏览器输入http://spark1:8080/

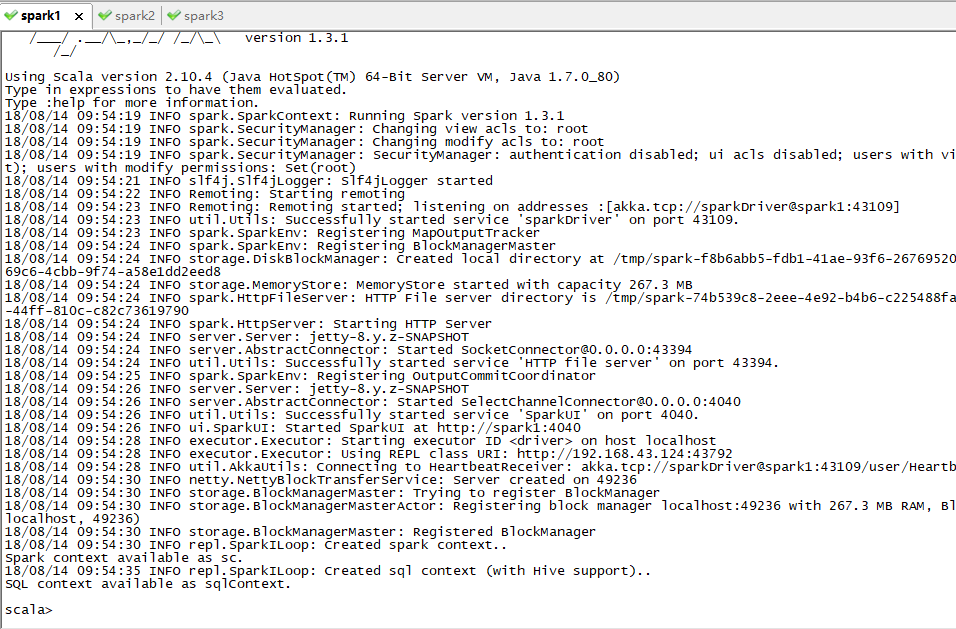

$ spark-shell #进入shell

spark集群搭建(三台虚拟机)——spark集群搭建(5)的更多相关文章

- Centos 7下VMware三台虚拟机Hadoop集群初体验

一.下载并安装Centos 7 传送门:https://www.centos.org/download/ 注:下载DVD ISO镜像 这里详解一下VMware安装中的两个过程 网卡配置 是Add ...

- spark集群搭建(三台虚拟机)——kafka集群搭建(4)

!!!该系列使用三台虚拟机搭建一个完整的spark集群,集群环境如下: virtualBox5.2.Ubuntu14.04.securecrt7.3.6_x64英文版(连接虚拟机) jdk1.7.0. ...

- spark集群搭建(三台虚拟机)——zookeeper集群搭建(3)

!!!该系列使用三台虚拟机搭建一个完整的spark集群,集群环境如下: virtualBox5.2.Ubuntu14.04.securecrt7.3.6_x64英文版(连接虚拟机) jdk1.7.0. ...

- spark集群搭建(三台虚拟机)——hadoop集群搭建(2)

!!!该系列使用三台虚拟机搭建一个完整的spark集群,集群环境如下: virtualBox5.2.Ubuntu14.04.securecrt7.3.6_x64英文版(连接虚拟机) jdk1.7.0. ...

- spark集群搭建(三台虚拟机)——系统环境搭建(1)

!!!该系列使用三台虚拟机搭建一个完整的spark集群,集群环境如下: virtualBox5.2.Ubuntu14.04.securecrt7.3.6_x64英文版(连接虚拟机) jdk1.7.0. ...

- AWS EC2 搭建 Hadoop 和 Spark 集群

前言 本篇演示如何使用 AWS EC2 云服务搭建集群.当然在只有一台计算机的情况下搭建完全分布式集群,还有另外几种方法:一种是本地搭建多台虚拟机,好处是免费易操控,坏处是虚拟机对宿主机配置要求较高, ...

- Spark学习之路(七)—— 基于ZooKeeper搭建Spark高可用集群

一.集群规划 这里搭建一个3节点的Spark集群,其中三台主机上均部署Worker服务.同时为了保证高可用,除了在hadoop001上部署主Master服务外,还在hadoop002和hadoop00 ...

- 用三台虚拟机搭建Hadoop全分布集群

用三台虚拟机搭建Hadoop全分布集群 所有的软件都装在/home/software下 虚拟机系统:centos6.5 jdk版本:1.8.0_181 zookeeper版本:3.4.7 hadoop ...

- 一台虚拟机,基于docker搭建大数据HDP集群

前言 好多人问我,这种基于大数据平台的xxxx的毕业设计要怎么做.这个可以参考之前写得关于我大数据毕业设计的文章.这篇文章是将对之前的毕设进行优化. 个人觉得可以分为两个部分.第一个部分就是基础的平台 ...

随机推荐

- 渗透测试-基于白名单执行payload--zipfldr.dll

0x01 zipfldr.dll简介: zipfldr.dll自Windows xp开始自带的zip文件压缩/解压工具组件. 说明:zipfldr.dll所在路径已被系统添加PATH环境变量中,因此, ...

- 域渗透基础之Windows 2012创建域控制器

创建备份域控制器 这里就拿windows 2012 R2来当备份域控 如果一个域内有多个域控制器,可以有如下好处. 提高用户登录的效率:如果同时有多台域控制器对客户提供服务,可以分担审核用户登录身份( ...

- powershell 基础

目录 本教程概述 用到的工具 标签 简介 0x01使用简介 0x02脚本编写 0x03实例讲解 本教程概述 本课我们学习powershell使用. 用到的工具 cmd.exe powershell ...

- [HDU2294] Pendant - 矩阵加速递推

Pendant Time Limit: 6000/2000 MS (Java/Others) Memory Limit: 32768/32768 K (Java/Others)Total Sub ...

- Android WebSocket实现即时通讯功能

最近做这个功能,分享一下.即时通讯(Instant Messaging)最重要的毫无疑问就是即时,不能有明显的延迟,要实现IM的功能其实并不难,目前有很多第三方,比如极光的JMessage,都比较容易 ...

- BeetleX服务网关之服务发现与泛域名路由

在新版本的服务网关中提供了服务发现和泛域名路由解决功能,服务发现可以在无须配置的情况下实现服务自动注册到网关中解脱对服务配置的繁琐工作:而泛域名路由则可以针对不同的域名制定不同的负载规则. 使用con ...

- HTML CSS整理笔记

——修改placeholder提示的样式: 1.除IE外通用写法 类名或标签名::placeholder {color: red;}2.加兼容前缀写法 css超出一行显示省略号:给定宽度(width: ...

- 后台添加Textbox

/// <summary> /// behind add textbox /// </summary> private void AddTextToTextBox() { Te ...

- Linux常用命令-不定时记录

文件移动命令 命令格式:mv [-fiv] source destination 参数说明:-f:force,强制直接移动而不询问-i:若目标文件(destination)已经存在,就会询问是否覆盖- ...

- Java基础(二十八)Java IO(5)RandomAccessFile类与过滤器流(Filter Stream)

一.RandomAccessFile类 使用RandomAccessFile类可以读取任意位置数据的文件. 1.构造方法 RandomAccessFile(String name, String mo ...