关于c# .net爬虫

刚开始听到爬虫这两个字眼的时候感觉挺稀奇的,之前并没有接触过爬虫,正好这会手上没事,于是便百度了一下。

1.网络爬虫(又被称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者),是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本。另外一些不常使用的名字还有蚂蚁、自动索引、模拟程序或者蠕虫。

当然了,这个解释很清晰,也很高尚,说到底,爬虫就是用来获取网页信息的!

2.有点门路了,于是我就自己写了一段代码

////创建http请求 获取http参数

HttpWebRequest req = (HttpWebRequest)WebRequest.Create(url);

////请求方式

req.Method = "GET";

////接收的内容 这里接收网页的信息

req.Accept = "text/html";

//用户代理

req.UserAgent = "Mozilla/4.0 (compatible; MSIE 8.0; Windows NT 6.1; Trident/4.0)";

string html = null;

////接收请求结果流

HttpWebResponse res = (HttpWebResponse)req.GetResponse();

using (StreamReader reader = new StreamReader(res.GetResponseStream()))

{

////读完

html = reader.ReadToEnd();

}

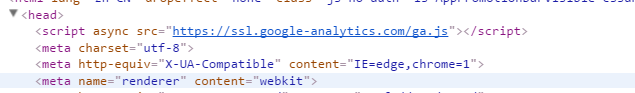

3.没错就是http请求,获取到页面的html所有代码信息,有了这些信息,我就可以进行下一步操作了,(我想爬一下网页上的图片,于是看了一下网页代码)

4.大家发现什么了吗,现在开始下一步操作,解析。。。。

private static string[] GetLinks(string html)

{

const string pattern = @"https*://([\w-]+\.)+[\w-]+(/[\w- ./?%&=]*)?";

Regex r = new Regex(pattern, RegexOptions.IgnoreCase);

MatchCollection m = r.Matches(html);

string[] links = new string[m.Count];

for (int i = 0; i < m.Count; i++)

{

links[i] = m[i].ToString();

}

return links;

}

5.恩,正则匹配我可以那到所有此站点的相关链接

6.当然了,链接仅仅是图片的,css js 网页什么的都是有的,好的 再过滤一下。

if((url.Contains(".jpg") || url.Contains(".gif")

|| url.Contains(".png")))

{

HttpWebRequest httpHelper = (HttpWebRequest)WebRequest.Create(url);

HttpWebResponse httpResponse = (HttpWebResponse)httpHelper.GetResponse();

try

{

this.Invoke((MethodInvoker)(() =>

{

using (Stream sr = httpResponse.GetResponseStream())

{

imageBox.Image = Image.FromStream(sr);

}

}));

}

catch (Exception)

{

}

Thread.Sleep(500);

return false;

}

7.这里我把图片的过滤了出来同时给解析了出来,到这里 你看懂了么。

我们会把当前页面的所有相关图片都给扫出来,这次我们就浅谈到这里.....有兴趣的可以加我的qq:759697338 大家一起成长,一起学习

关于c# .net爬虫的更多相关文章

- 设计爬虫Hawk背后的故事

本文写于圣诞节北京下午慵懒的午后.本文偏技术向,不过应该大部分人能看懂. 五年之痒 2016年,能记入个人年终总结的事情没几件,其中一个便是开源了Hawk.我花不少时间优化和推广它,得到的评价还算比较 ...

- Scrapy框架爬虫初探——中关村在线手机参数数据爬取

关于Scrapy如何安装部署的文章已经相当多了,但是网上实战的例子还不是很多,近来正好在学习该爬虫框架,就简单写了个Spider Demo来实践.作为硬件数码控,我选择了经常光顾的中关村在线的手机页面 ...

- Python 爬虫模拟登陆知乎

在之前写过一篇使用python爬虫爬取电影天堂资源的博客,重点是如何解析页面和提高爬虫的效率.由于电影天堂上的资源获取权限是所有人都一样的,所以不需要进行登录验证操作,写完那篇文章后又花了些时间研究了 ...

- scrapy爬虫docker部署

spider_docker 接我上篇博客,为爬虫引用创建container,包括的模块:scrapy, mongo, celery, rabbitmq,连接https://github.com/Liu ...

- scrapy 知乎用户信息爬虫

zhihu_spider 此项目的功能是爬取知乎用户信息以及人际拓扑关系,爬虫框架使用scrapy,数据存储使用mongo,下载这些数据感觉也没什么用,就当为大家学习scrapy提供一个例子吧.代码地 ...

- 120项改进:开源超级爬虫Hawk 2.0 重磅发布!

沙漠君在历时半年,修改无数bug,更新一票新功能后,在今天隆重推出最新改进的超级爬虫Hawk 2.0! 啥?你不知道Hawk干吗用的? 这是采集数据的挖掘机,网络猎杀的重狙!半年多以前,沙漠君写了一篇 ...

- Python爬虫小白入门(四)PhatomJS+Selenium第一篇

一.前言 在上一篇博文中,我们的爬虫面临着一个问题,在爬取Unsplash网站的时候,由于网站是下拉刷新,并没有分页.所以不能够通过页码获取页面的url来分别发送网络请求.我也尝试了其他方式,比如下拉 ...

- Python多线程爬虫爬取电影天堂资源

最近花些时间学习了一下Python,并写了一个多线程的爬虫程序来获取电影天堂上资源的迅雷下载地址,代码已经上传到GitHub上了,需要的同学可以自行下载.刚开始学习python希望可以获得宝贵的意见. ...

- QQ空间动态爬虫

作者:虚静 链接:https://zhuanlan.zhihu.com/p/24656161 来源:知乎 著作权归作者所有.商业转载请联系作者获得授权,非商业转载请注明出处. 先说明几件事: 题目的意 ...

- 让你从零开始学会写爬虫的5个教程(Python)

写爬虫总是非常吸引IT学习者,毕竟光听起来就很酷炫极客,我也知道很多人学完基础知识之后,第一个项目开发就是自己写一个爬虫玩玩. 其实懂了之后,写个爬虫脚本是很简单的,但是对于新手来说却并不是那么容易. ...

随机推荐

- codevs 3044 矩形面积求并 || hdu 1542

这个线段树的作用其实是维护一组(1维 平面(?) 上的)线段覆盖的区域的总长度,支持加入/删除一条线段. 线段树只能维护整数下标,因此要离散化. 也可以理解为将每一条处理的线段分解为一些小线段,要求每 ...

- RHEL5.6环境下Oracle10g单主机安装步骤记录

操作环境:RedHat Enterprise Linux 5.6 安装版本:Oracle Database 10g Enterprise Edition Release 10.2.0.1.0 - 64 ...

- C. Dasha and Password 预处理 + dp

http://codeforces.com/contest/761/problem/C 对于每一个字符串,可以预处理出其到达数字,字母,和特殊符号所需的最小步数. 然后就是在n个东西中,选出数字.字母 ...

- C. Hongcow Builds A Nation 并查集

http://codeforces.com/contest/745/problem/C 把他们并查集后, 其他没有连去government的点,全部放去同一个并查集,然后选择一个节点数最多的gover ...

- sdut1650I-Keyboard(dp)

链接 题目大意就相当于 跟你一串字符串 让你截成k段 使总体的值最小 想法是递归的 递归太慢 可以转换为递推的 这样就有可以推出状态方程 dp[i][j] = max(dp[i][j],dp[i-1] ...

- Anaconda(miniconda)安装及使用--转

https://www.waitalone.cn/anaconda-install-error.html 3,224 1.Anaconda概述 Anaconda是一个用于科学计算的 ...

- Spring------IOC&DI

一.Spring? Spring兴起:2003年,由Rod Johnson创建.总的来说,Spring Framwork从它诞生至今都一直为人所称道,它的伟大之处自此可见一斑. 核心:IOC& ...

- 波哥!一个不安分的IT男

第一篇博文,紧张,窃喜,辣眼睛! 这个订阅号主要是写给自己的,近期越来越发现记忆力不如以前了! 时光如梭,岁月荏苒,或许这两句经典的开头文比较契合自己的年纪.依稀记得几年前还在组装服务器.搬机柜.做系 ...

- 解决hibernate对Sql Server分页慢的问题

一.hibernate分页 hibernate对MsSql的伪分页 分页是web项目中比不可少的一个功能,数据量大的时候不能全部展示必然要用到分页技术.相信大家对hibernate中的分页都不陌生: ...

- Farseer.net轻量级ORM开源框架 V1.3版本升级消息

SHA-1: abca3b99801648fa23c7f4934de6c128f042cf47 * 提交新版本:V1.31.重构:FS.Mapping命名空间移到 FS.Core.Map中2.重构:对 ...