python爬虫:爬取猫眼TOP100榜的100部高分经典电影

1、问题描述:

爬取猫眼TOP100榜的100部高分经典电影,并将数据存储到CSV文件中

2、思路分析:

(1)目标网址:http://maoyan.com/board/4

(2)代码结构:

(3) init(self)初始化函数

· hearders用到了fake_useragent库,用来随机生成请求头。

· datas空列表,用于保存爬取的数据。

def __init__(self,url):

self.headers = {"User-Agent": UserAgent().random}

self.url = url

self.datas = list()

(4) getPage()函数

猫眼Top100榜总共有10页电影,每页的链接基本一样,只有最后一个数字在变化http://maoyan.com/board/4?offset=10,所以可以通过for循环来访问10页的电影。

# 通过for循环,获取10页的电影信息的源码

def getPage(self):

for i in range(0,10):

url = self.url + "?offset={0}".format(i*10)

response = requests.get(url, headers = self.headers)

if response.status_code == 200:

self.parsePage(response.text)

else:

return None

(5)parsePage()函数

每页都有10部高分经典电影,通过BeautifulSoup获取每页10部电影的详细信息:名字、主演、上映时间、评分。

# 通过BeautifulSoup获取每页10部电影的详细信息

def parsePage(self, html):

soup = BeautifulSoup(html, "html.parser")

details = soup.find_all("dd")

for dd in details:

data = {}

data["index"] = dd.find("i").text

data["name"] = dd.find("p", class_ = "name").text

data["star"] = dd.find("p", class_="star").text.strip()[3:]

data["time"] = dd.find("p", class_="releasetime").text.strip()[5:]

data["score"] = dd.find("p", class_="score").text

self.datas.append(data)

(6)savaData()函数

通过DataFrame(),把Top100的电影存储到CSV文件中。

它默认的是按照列名的字典顺序排序的。想要自定义列的顺序,可以加columns字段

# 通过DataFrame,把Top100的电影存储到CSV文件中

def saveData(self):

self.getPage()

data = pd.DataFrame(self.datas)

columns = ["index", "name", "star", "time", "score"]

data.to_csv(".\maoyanTop100.csv", index=False, columns=columns)

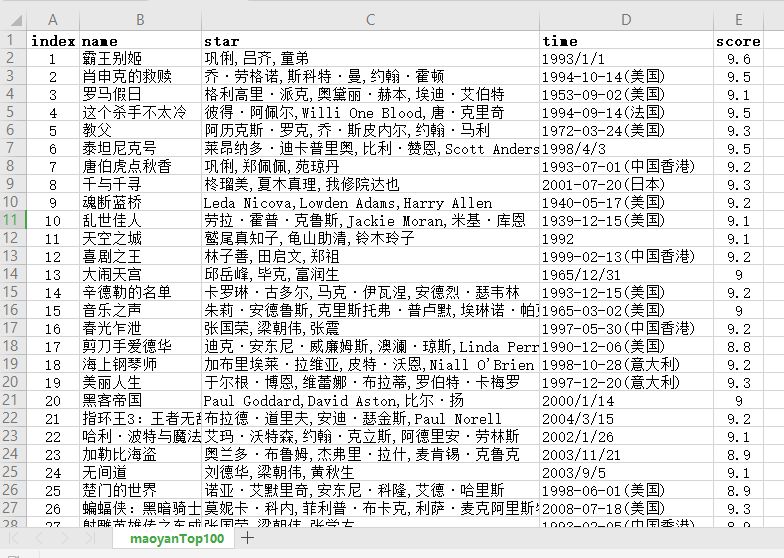

3、效果展示

4、完整代码:

# -* conding: utf-8 *-

#author: wangshx6

#data: 2018-11-08

#description: 爬取猫眼TOP100榜的100部高分经典电影

import requests

from bs4 import BeautifulSoup

import pandas as pd

from fake_useragent import UserAgent

class MaoyanSpider(object):

def __init__(self,url):

self.headers = {"User-Agent": UserAgent().random}

self.url = url

self.datas = list()

# 通过for循环,获取10页的电影信息的源码

def getPage(self):

for i in range(0,10):

url = self.url + "?offset={0}".format(i*10)

response = requests.get(url, headers = self.headers)

if response.status_code == 200:

self.parsePage(response.text)

else:

return None

# 通过BeautifulSoup获取每页10部电影的详细信息

def parsePage(self, html):

soup = BeautifulSoup(html, "html.parser")

details = soup.find_all("dd")

for dd in details:

data = {}

data["index"] = dd.find("i").text

data["name"] = dd.find("p", class_ = "name").text

data["star"] = dd.find("p", class_="star").text.strip()[3:]

data["time"] = dd.find("p", class_="releasetime").text.strip()[5:]

data["score"] = dd.find("p", class_="score").text

self.datas.append(data)

# 通过DataFrame,把Top100的电影存储到CSV文件中

def saveData(self):

self.getPage()

data = pd.DataFrame(self.datas)

columns = ["index", "name", "star", "time", "score"]

data.to_csv(".\maoyanTop100.csv", index=False, columns=columns)

if __name__ == "__main__":

url = "http://maoyan.com/board/4"

spider = MaoyanSpider(url)

spider.saveData()

python爬虫:爬取猫眼TOP100榜的100部高分经典电影的更多相关文章

- 【爬虫】-爬取猫眼TOP100

原文崔庆才<python3网络爬虫实战> 本文为自学记录,如有侵权,请联系删除 目标: 熟悉正则表达式,以及爬虫流程 获取猫眼TOP100榜单 1.网站分析 目标站点为http://www ...

- Python 爬取 猫眼 top100 电影例子

一个Python 爬取猫眼top100的小栗子 import json import requests import re from multiprocessing import Pool #//进程 ...

- Python爬虫 - 爬取百度html代码前200行

Python爬虫 - 爬取百度html代码前200行 - 改进版, 增加了对字符串的.strip()处理 源代码如下: # 改进版, 增加了 .strip()方法的使用 # coding=utf-8 ...

- 用Python爬虫爬取广州大学教务系统的成绩(内网访问)

用Python爬虫爬取广州大学教务系统的成绩(内网访问) 在进行爬取前,首先要了解: 1.什么是CSS选择器? 每一条css样式定义由两部分组成,形式如下: [code] 选择器{样式} [/code ...

- 使用Python爬虫爬取网络美女图片

代码地址如下:http://www.demodashi.com/demo/13500.html 准备工作 安装python3.6 略 安装requests库(用于请求静态页面) pip install ...

- Python爬虫|爬取喜马拉雅音频

"GOOD Python爬虫|爬取喜马拉雅音频 喜马拉雅是知名的专业的音频分享平台,用户规模突破4.8亿,汇集了有声小说,有声读物,儿童睡前故事,相声小品等数亿条音频,成为国内发展最快.规模 ...

- python爬虫爬取内容中,-xa0,-u3000的含义

python爬虫爬取内容中,-xa0,-u3000的含义 - CSDN博客 https://blog.csdn.net/aiwuzhi12/article/details/54866310

- Python爬虫爬取全书网小说,程序源码+程序详细分析

Python爬虫爬取全书网小说教程 第一步:打开谷歌浏览器,搜索全书网,然后再点击你想下载的小说,进入图一页面后点击F12选择Network,如果没有内容按F5刷新一下 点击Network之后出现如下 ...

- python爬虫—爬取英文名以及正则表达式的介绍

python爬虫—爬取英文名以及正则表达式的介绍 爬取英文名: 一. 爬虫模块详细设计 (1)整体思路 对于本次爬取英文名数据的爬虫实现,我的思路是先将A-Z所有英文名的连接爬取出来,保存在一个cs ...

随机推荐

- autofac学习

Instance Scope 1.instance per dependency (the default) builder.RegisterType<classes>();等价于 ...

- hibernate课程 初探一对多映射2-5 创建持久化类并配置映射文件

学习点: 1 一对多映射,一方 Grade.hbm.xml的写法: <hibernate-mapping> <class name="com.ddwei.entity.Gr ...

- jquery-ui sortable 排序

https://blog.csdn.net/u013066244/article/details/51954198 <link ref="stylesheet" href ...

- selenium找不到元素

1.页面元素处于不显示状态时,找不元素.必须使元素处于显示状态.使用js 或者 元素的点击事件等方式可以实现. " src="index.php?m=Index&a=Men ...

- jupyter notebook 报错 ImportError: No module named matplotlib

解决办法: 打开Anaconda Prompt 列出conda环境: conda info --envs 结果显示: # conda environments: # tensorflow * D:\ ...

- sudoers文件解析

分类: LINUX 今天在用户组中新加了一个普 通用户,开始这个用户没有sudo权限,于是通过sudo visudo修改了sudo的配置文件,赋予了普通用户的root权限.后来想着能不能将/etc/s ...

- 批处理实现虚拟WIFI

类似于360免费WiFi那个软件,可以PC发射WiFi(需要有无线网卡). 源码如下: @Echo off title Windows7 虚拟Wifi----By yllinux mode con c ...

- 816 Ambiguous Coordinates (many cases problem)

https://www.cnblogs.com/Java3y/p/8846955.html -- link of the problem 816 IDEA: check the dot and int ...

- AttributeError: module 'requests' has no attribute 'get' 遇到了这个错误,是因为我把python关键字做了包名。。。

初学者总会犯各种低级错误,这是其一,特此记录.

- 问答 请问使用OK("raw:jpg")能返回多张图片吗

请问使用OK("raw:jpg")能返回多张图片吗 发布于 28天前 作者 qq_3aeeb0ad 78 次浏览 复制 上一个帖子 下一个帖子 标签: 无 @At( ...