(二)requests-爬取国家药监局生产许可证数据

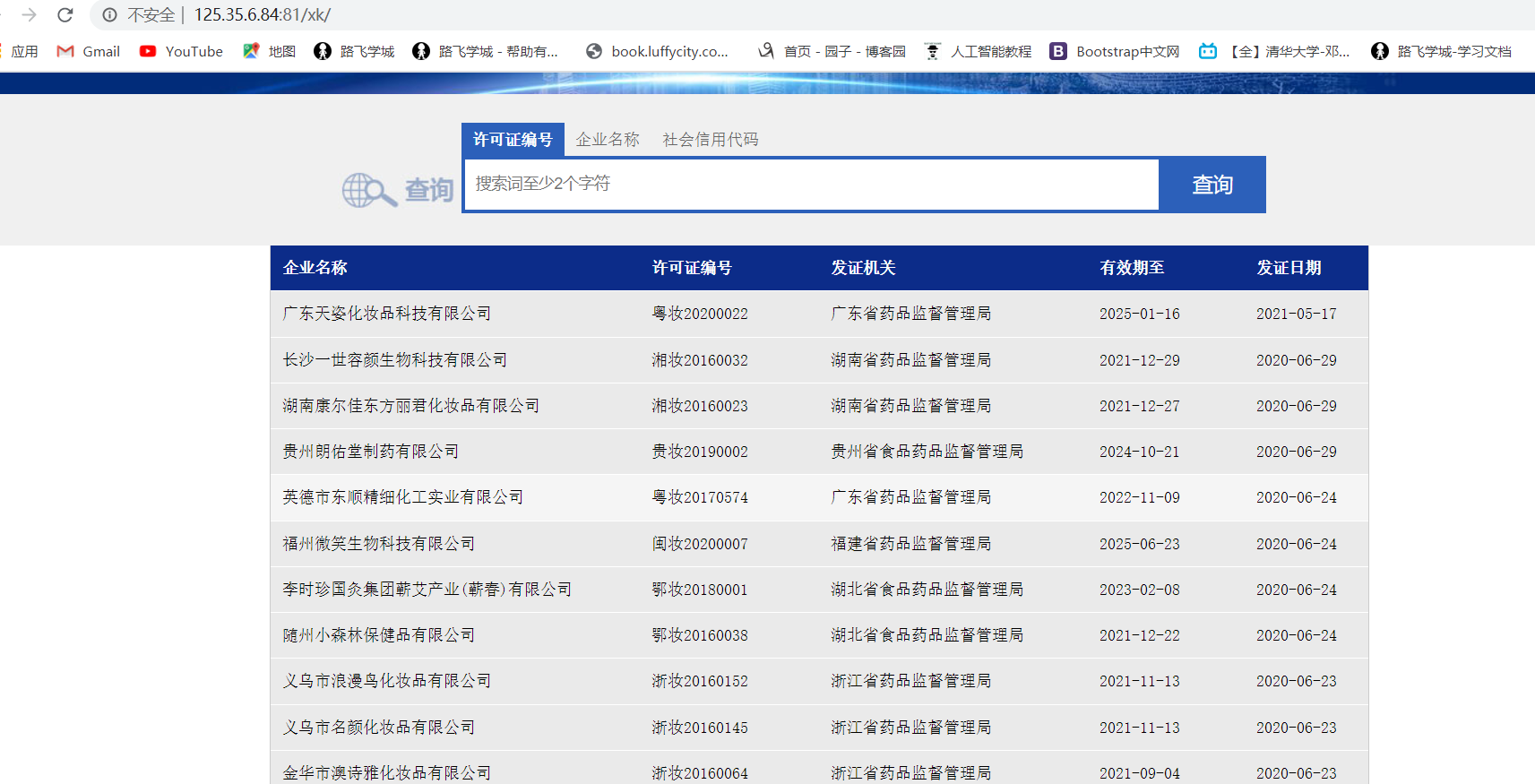

首先访问这个页面 url = 'http://125.35.6.84:81/xk/'

我们的目标是抓取这里的每一个企业的详情页数据,但是可以发现这里只有企业的简介信息,所以这就意味着我们要发送两次get请求。

在写代码之前,我们可以大概看一下我们想要的数据大概在什么位置。

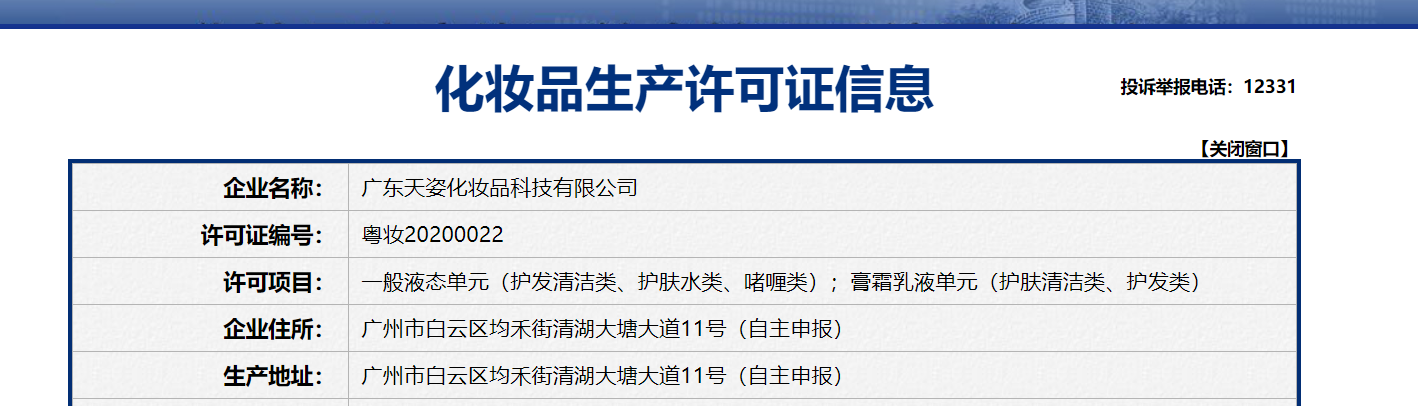

1. 我们打开一个公司的详情页

2. 右击检查,通过Response查找对应的目标数据

从这里我们可以看出,当前的数据是通过ajax请求动态加载出来的

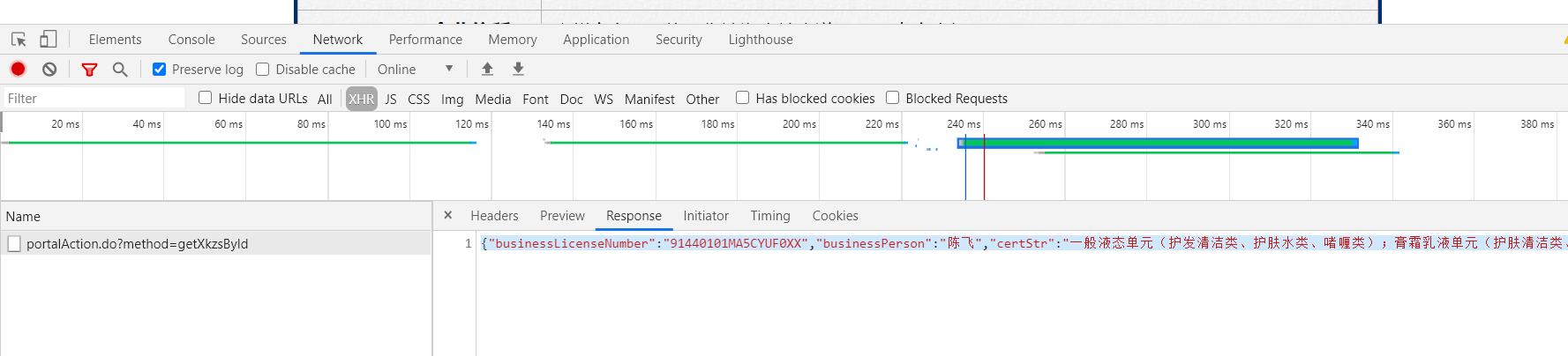

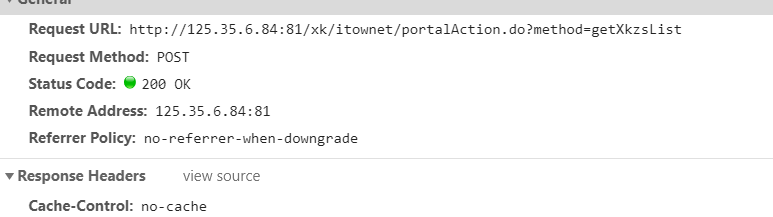

3.查看头信息,以及参数信息

我们可以看出,当前的请求是post请求,所需要的参数是id,但是从以上的数据来看我们并没有发现哪里有id这个参数。因为我们将目光聚焦到首页。

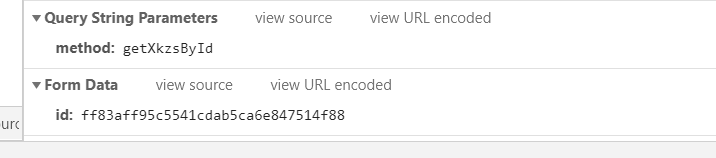

4. 分析首页所返回的数据

同样是右击检查,打开抓包工具

从这里我们可以看出首页的数据也是通过ajax动态加载出来的,并且通过观察我们可以发现在ID的踪迹,至此我们就可以形成一条完整的思路。

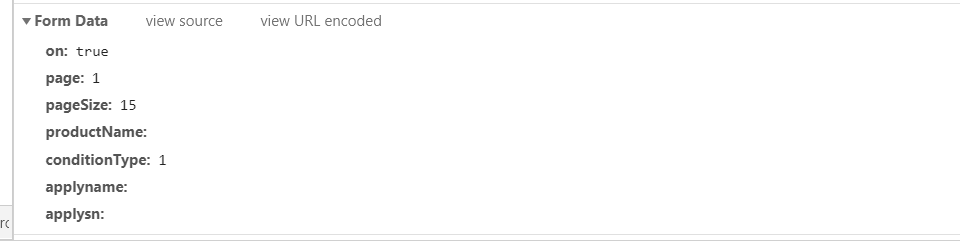

5.我们可以看看首页的请求方式,与是否携带了参数

6. 思路:拿到首页的响应数据的ID,并以此为参数向详情页发送post请求,拿到每个详情页的详情数据。

7.代码实现:

import requests

import json if __name__ == '__main__':

# 获取各个企业id

id_list = []

# 这里的url并非是首页的url 首页中的所有企业信息都是通过ajax动态请求的 因此应查看对应包中的url

url = 'http://125.35.6.84:81/xk/itownet/portalAction.do?method=getXkzsList'

header = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.92 Safari/537.36'

}

# 获取前五页的数据

for page in range(1, 5):

page = str(page)

# 首页请求所需参数

data = {

'on': 'true',

'page': page,

'pageSize': '15',

'productName': '',

'conditionType': '1',

'applyname': '',

'applysn': ''

} # 向首页发送请求

response = requests.post(url=url, data=data, headers=header)

# 拿到json格式的数据

info = response.json()

# 拿到所有企业信息的列表

target_id = info['list']

for i in target_id:

# 获取所有企业的id

id_list.append(i['ID']) # 获取企业详情信息

ret_list = []

url = 'http://125.35.6.84:81/xk/itownet/portalAction.do?method=getXkzsById' # 获取所有企业的详情数据

for i in id_list:

data = {

'id': i

}

ret = requests.post(url=url, data=data, headers=header)

ret_list.append(ret.json()) # 持久化存储

fileName = 'files/药监总局.json'

with open(fileName, 'w', encoding='utf-8') as f:

f.write(json.dumps(ret_list, ensure_ascii=False))

print('work is done')

(二)requests-爬取国家药监局生产许可证数据的更多相关文章

- scrapy爬虫框架教程(二)-- 爬取豆瓣电影TOP250

scrapy爬虫框架教程(二)-- 爬取豆瓣电影TOP250 前言 经过上一篇教程我们已经大致了解了Scrapy的基本情况,并写了一个简单的小demo.这次我会以爬取豆瓣电影TOP250为例进一步为大 ...

- selenium爬取qq空间,requests爬取雪球网数据

一.爬取qq空间好友动态数据 # 爬取qq空间好友状态信息(说说,好友名称),并屏蔽广告 from selenium import webdriver from time import sleep f ...

- 爬虫(二)Python网络爬虫相关基础概念、爬取get请求的页面数据

什么是爬虫 爬虫就是通过编写程序模拟浏览器上网,然后让其去互联网上抓取数据的过程. 哪些语言可以实现爬虫 1.php:可以实现爬虫.php被号称是全世界最优美的语言(当然是其自己号称的,就是王婆 ...

- requests爬取百度音乐

使用requests爬取百度音乐,我想把当前热门歌手的音乐信息爬下来. 首先进行url分析,可以看到: 歌手网页: 薛之谦网页: 可以看到,似乎这些路劲的获取一切都很顺利,然后可以写代码: # -*- ...

- Python爬虫实战二之爬取百度贴吧帖子

大家好,上次我们实验了爬取了糗事百科的段子,那么这次我们来尝试一下爬取百度贴吧的帖子.与上一篇不同的是,这次我们需要用到文件的相关操作. 前言 亲爱的们,教程比较旧了,百度贴吧页面可能改版,可能代码不 ...

- 转 Python爬虫实战二之爬取百度贴吧帖子

静觅 » Python爬虫实战二之爬取百度贴吧帖子 大家好,上次我们实验了爬取了糗事百科的段子,那么这次我们来尝试一下爬取百度贴吧的帖子.与上一篇不同的是,这次我们需要用到文件的相关操作. 本篇目标 ...

- 爬虫学习(二)--爬取360应用市场app信息

欢迎加入python学习交流群 667279387 爬虫学习 爬虫学习(一)-爬取电影天堂下载链接 爬虫学习(二)–爬取360应用市场app信息 代码环境:windows10, python 3.5 ...

- Python爬虫入门——使用requests爬取python岗位招聘数据

爬虫目的 使用requests库和BeautifulSoup4库来爬取拉勾网Python相关岗位数据 爬虫工具 使用Requests库发送http请求,然后用BeautifulSoup库解析HTML文 ...

- Requests爬取网页的编码问题

Requests爬取网页的编码问题 import requests from requests import exceptions def getHtml(): try: r=requests.get ...

- Python爬虫系列之爬取美团美食板块商家数据(二)

今天为大家重写一个美团美食板块小爬虫,说不定哪天做旅游攻略的时候也可以用下呢.废话不多说,让我们愉快地开始吧~ 开发工具 Python版本:3.6.4 相关模块: requests模块: argpar ...

随机推荐

- 技术门槛高?来看 Intel 机密计算技术在龙蜥社区的实践 | 龙蜥技术

简介: 数据可用不可见是怎么做到的? 编者按:龙蜥社区云原生机密计算 SIG 定位于云原生机密计算底层基础设施,专注于机密计算底层技术.在阿里巴巴开源开放周中, 龙蜥社区机密计算 SIG Mainta ...

- [FAQ] iCloud 照片共享, 收到xx集团邀你xx, 拒绝 or 关闭 ?

如果你收到邀请日历这是垃圾邮件和简单地选择"拒绝"选项,这个问题不会消失. 事实上,很可能增加,因为垃圾邮件发送者知道该帐户被激活.这同样适用于iCloud的照片共享. 对于iCl ...

- [Go] go build 减小二进制文件大小的几种方式

第一种 是去除不需要的调试信息: go build -ldflags "-s -w" main.go 实测 19M 减小为 15M,幅度 2% 第二种 压缩 UPX: the Ul ...

- [FAQ] Truffle Deployer 合约传参问题: Invalid number of parameters for "undefined". Got 0 expected 1!

在使用 `truffle migrate` 时,如果合约的构造函数需要传参,而部署脚本里没有传的时候,就会报这个错. 未传参时: const Migrations = artifacts.requir ...

- dotnet 对指针转换为结构体多个不同方法的性能分析

在 dotnet 里面,拿到一个指针,可以有多个不同的方法转换为结构体,本文将来告诉大家这几个方法的性能的差别 特别感谢性能优化狂魔 Stephen Toub 大佬的指导 在 WPF 框架开发中,有小 ...

- dotnet OpenXML 读取形状轮廓线条样式序号超过主题样式列表数

在 OpenXML 中,默认的形状可以通过指定 LineReference 让形状使用文档主题里面的样式.文档主题里面包含多个样式,在形状里面指定样式通过的是序号的方法,如果在形状里面指定的序号超过了 ...

- SQL server 批量删除表

select 'drop table '+name+';' from sys.tables declare c cursor forselect NAME from sysobjects where ...

- STM32 USART串口通信

一.介绍 通用同步异步收发器(USART)提供了一种灵活的方法与使用工业标准NRZ异步串行数据格式的外部设备之间进行全双工数据交换.USART利用分数波特率发生器提供宽范围的波特率选择.它支持同步单向 ...

- SpringBoot 二维码生成

一.基于Google开发工具包ZXing生成二维码 1.引入需要的依赖 <!-- zxing生成二维码 --> <dependency> <groupId>com. ...

- 传入一个List集合,返回分页好的数据

传入一个List集合,返回分页好的数据. 定义分页信息类: package com.cn.common; import java.util.List; public class CommonPage& ...