大数据笔记(二十八)——执行Spark任务、开发Spark WordCount程序

一、执行Spark任务: 客户端

1、Spark Submit工具:提交Spark的任务(jar文件)

(*)spark提供的用于提交Spark任务工具

(*)example:/root/training/spark-2.1.0-bin-hadoop2.7/examples/jars/spark-examples_2.11-2.1.0.jar

(*)SparkPi.scala 例子:蒙特卡罗求PI

bin/spark-submit --master spark://bigdata11:7077 --class org.apache.spark.examples.SparkPi examples/jars/spark-examples_2.11-2.1.0.jar 100

Pi is roughly 3.1419547141954713

bin/spark-submit --master spark://bigdata11:7077 --class org.apache.spark.examples.SparkPi examples/jars/spark-examples_2.11-2.1.0.jar 300

Pi is roughly 3.141877971395932

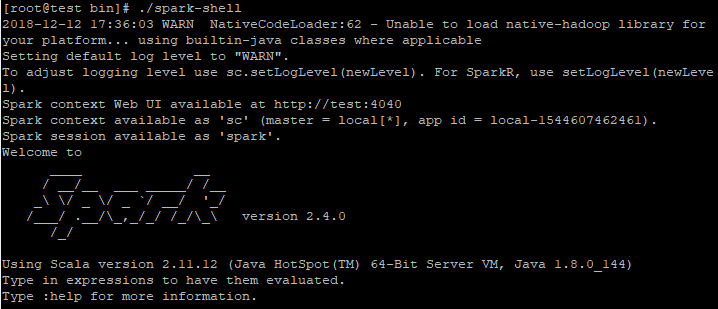

2、Spark Shell 工具:交互式命令行工具、作为一个Application运行

两种模式:(1)本地模式

在spark解压目录/bin下执行:./spark-shell

日志:

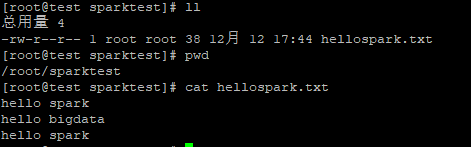

创建一个文件hellospark.txt

读文件:

(2)集群模式

bin/spark-shell --master spark://bigdata11:7077

日志:

Spark context available as 'sc' (master = spark://bigdata11:7077, app id = app-20180209210815-0002).

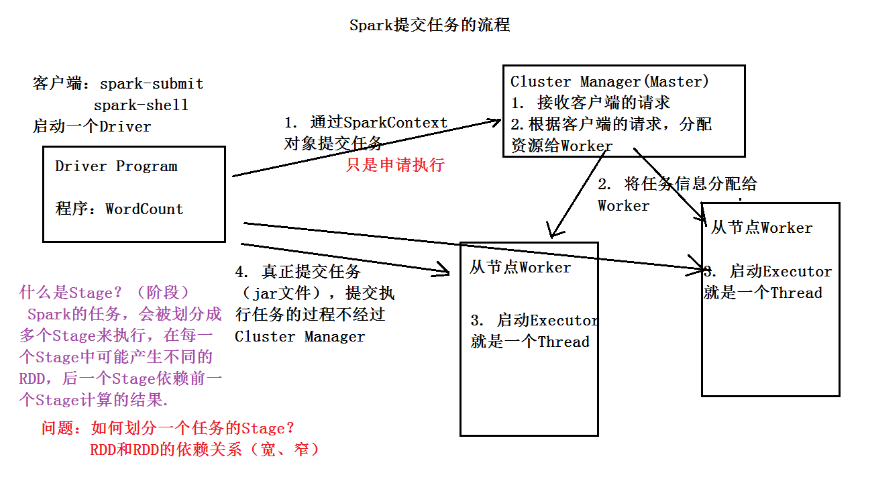

对象:Spark context available as 'sc'

Spark session available as 'spark' ---> 在Spark 2.0后,新提供

是一个统一的访问接口:Spark Core、Spark SQL、Spark Streaming

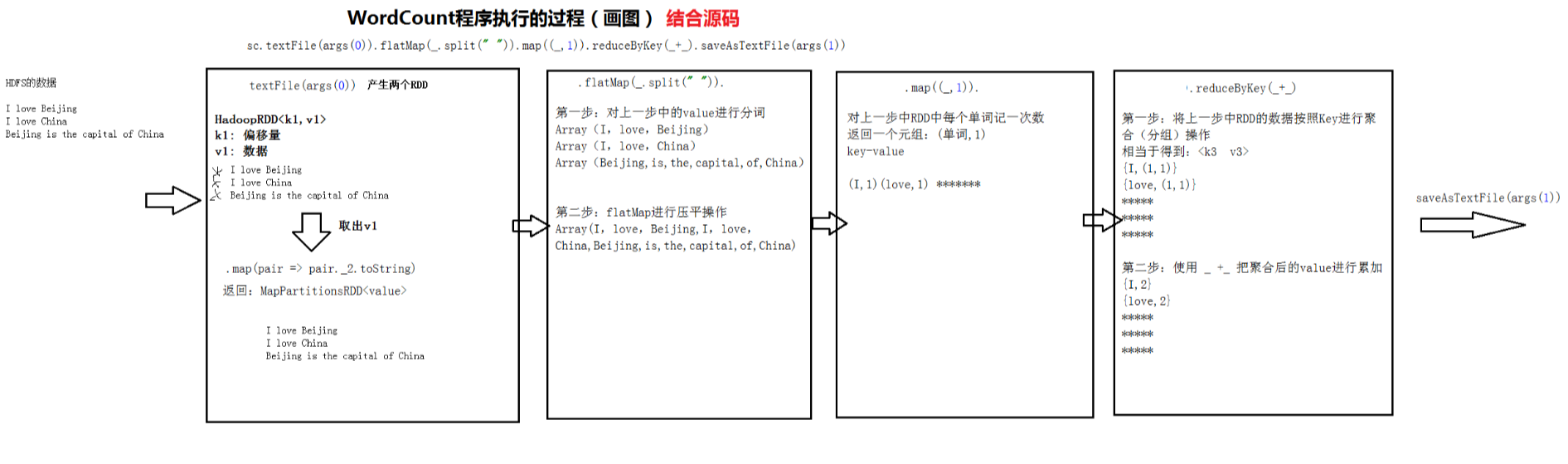

sc.textFile("hdfs://bigdata11:9000/input/data.txt") 通过sc对象读取HDFS的文件

.flatMap(_.split(" ")) 分词操作、压平

.map((_,1)) 每个单词记一次数

.reduceByKey(_+_) 按照key进行reduce,再将value进行累加

.saveAsTextFile("hdfs://bigdata11:9000/output/spark/day0209/wc")

多说一句:

.reduceByKey(_+_)

完整

.reduceByKey((a,b) => a+b)

3、开发WordCount程序

http://spark.apache.org/docs/2.1.0/api/scala/index.html#org.apache.spark.package

(1)Scala版本: 在IDEA中

package mydemo /*

提交

bin/spark-submit --master spark://bigdata11:7077 --class mydemo.MyWordCount /root/temp/MyWordCount.jar hdfs://bigdata11:9000/input/data.txt hdfs://bigdata11:9000/output/spark/day0209/wc1

*/ import org.apache.spark.{SparkConf, SparkContext} //开发一个Scala版本的WordCount

object MyWordCount {

def main(args: Array[String]): Unit = {

//创建一个Config

val conf = new SparkConf().setAppName("MyScalaWordCount") //核心创建SparkContext对象

val sc = new SparkContext(conf) //使用sc对象执行相应的算子(函数)

sc.textFile(args(0))

.flatMap(_.split(" "))

.map((_,1))

.reduceByKey(_+_)

.saveAsTextFile(args(1)) //停止SparkContext对象

sc.stop() }

}

分析WordCount程序执行的过程

Spark 提交任务的流程

大数据笔记(二十八)——执行Spark任务、开发Spark WordCount程序的更多相关文章

- 大数据笔记(十八)——Pig的自定义函数

Pig的自定义函数有三种: 1.自定义过滤函数:相当于where条件 2.自定义运算函数: 3.自定义加载函数:使用load语句加载数据,生成一个bag 默认:一行解析成一个Tuple 需要MR的ja ...

- 大数据笔记(十二)——使用MRUnit进行单元测试

package demo.wc; import java.util.ArrayList; import java.util.List; import org.apache.hadoop.io.IntW ...

- Java基础学习笔记二十八 管家婆综合项目

本项目为JAVA基础综合项目,主要包括: 熟练View层.Service层.Dao层之间的方法相互调用操作.熟练dbutils操作数据库表完成增删改查. 项目功能分析 查询账务 多条件组合查询账务 添 ...

- 大数据笔记(十五)——Hive的体系结构与安装配置、数据模型

一.常见的数据分析引擎 Hive:Hive是一个翻译器,一个基于Hadoop之上的数据仓库,把SQL语句翻译成一个 MapReduce程序.可以看成是Hive到MapReduce的映射器. Hive ...

- 大数据笔记(十)——Shuffle与MapReduce编程案例(A)

一.什么是Shuffle yarn-site.xml文件配置的时候有这个参数:yarn.nodemanage.aux-services:mapreduce_shuffle 因为mapreduce程序运 ...

- angular学习笔记(二十八-附2)-$http,$resource中的promise对象

下面这种promise的用法,我从第一篇$http笔记到$resource笔记中,一直都有用到: HttpREST.factory('cardResource',function($resource) ...

- Java学习笔记二十八:Java中的接口

Java中的接口 一:Java的接口: 接口(英文:Interface),在JAVA编程语言中是一个抽象类型,是抽象方法的集合,接口通常以interface来声明.一个类通过继承接口的方式,从而来继承 ...

- 论文阅读笔记二十八:You Only Look Once: Unified,Real-Time Object Detection(YOLO v1 CVPR2015)

论文源址:https://arxiv.org/abs/1506.02640 tensorflow代码:https://github.com/nilboy/tensorflow-yolo 摘要 该文提出 ...

- 大数据笔记(十九)——数据采集引擎Sqoop和Flume安装测试详解

一.Sqoop数据采集引擎 采集关系型数据库中的数据 用在离线计算的应用中 强调:批量 (1)数据交换引擎: RDBMS <---> Sqoop <---> HDFS.HBas ...

- 大数据笔记(十六)——Hive的客户端及自定义函数

一.Hive的Java客户端 JDBC工具类:JDBCUtils.java package demo.jdbc; import java.sql.DriverManager; import java. ...

随机推荐

- Luogu P2501 [HAOI2006]数字序列

题目 首先把\(a\)改成严格单调上升等于把\(a_i-i\)改成单调不降. 那么第一问可以直接做LIS,答案就是\(n-\)LIS的长度. 同时我们记录一下序列中每个位置结尾的LIS长度. 第二问我 ...

- msql 事务

START TRANSACTION delete from t_emp delete from t_deptcommit START TRANSACTION delete from t ...

- Mysql 事件记录 | performance_schema全方位介绍

Mysql 事件记录 | performance_schema全方位介绍 | 导语 在上一篇 初相识|performance_schema全方位介绍 中,我们详细介绍了performance_sche ...

- 如何解决 u盘 错误0x80071AC3:请运行chkdsk并重试

windows: 一.win+R 打开 cmd 二.确认好U盘在电脑上显示的盘符,输入代码:chkdsk G:/f (G为U盘所在盘符) Bonus:U盘一般会有文件系统,主要有NTFS.FAT16. ...

- mysql优化--explain关键字

MySQL性能优化---EXPLAIN 参见:https://blog.csdn.net/jiadajing267/article/details/81269067 参见:https://www.cn ...

- 自己对GIS的思考

这只是我自己的理解,谈不上对整个行业的理解,只能从自己的角度谈谈GIS,谈谈爱和恨. 现在在武汉的一所所谓的全国GIS数一数二的学校里面读硕士,从高中开始我就很喜欢地理学科,大学选择了地球信息科技这个 ...

- 2019.9.17更换ubuntu的镜像源 ubuntu安装lamp iis安装网站和ftp站

更换ubuntu的镜像源 /etc/apt/sources.list cp /etc/apt/sources.list /etc/apt/sources.list.bak 备份这个文件 vim / ...

- Vim安装插件支持 MarkDown 语法、实时预览等

使用 markdown-preview.vim 插件可以实时通过浏览器预览 markdown 文件 使用该插件需要 vim 支持py2/py3 安装 使用 vim-plug: 在 .vimrc 或 i ...

- 递归算法几个实例---C/C++

//1.斐波那契数列 int fibo(int n) { || n==) { ; } else { ) + fibo(n-); } } //2.阶乘 int fac(int n) { || n==) ...

- WPF选项卡页面分离之Page调用Window类

此项目源码下载地址:https://github.com/lizhiqiang0204/WPF_PageCallWindow 如果Page与Window直接没有任何调用就用这种方法https://ww ...