python 爬虫实例(一)

一个简单的爬虫工程

环境:

OS:Window10

python:3.7

安装一些库文件

pip install requests

pip install beautifulsoup4

pip install lxml

在安装的时候如果遇到了你的pip版本过低的错误的话,可以找到你本地的C:\Users\XXX\PycharmProjects\getHtml\venv\Lib\site-packages下面的pip-18.1.dist-info文件夹删除,之后在进行更新

下面是提取一个网页的图片代码

import time import requests

import os

import threading from bs4 import BeautifulSoup class BeautifulPicture(): def __init__(self):

self.headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.110 Safari/537.36'}

self.web_url = "https://unsplash.com/"

self.folder_path = r'C:\Users\peiqiang\Desktop\python Pic' def request(self, url):

r = requests.get(url)

return r def mkdir(self, path):

path = path.strip()

isExists = os.path.exists(path)

if not isExists:

print("创建名字叫做", path, "的文件夹")

os.makedirs(path)

print("创建成功!")

else:

print(path, '文件夹已经存在了,不再创建') def save_img(self, url, name):

print('开始保存图片...')

img = self.request(url)

file_name = self.folder_path + '\{}.jpg'.format(name)

print('开始保存文件')

f = open(file_name, 'ab')

f.write(img.content)

f.close()

thread_lock.release()

print(file_name, '文件保存成功!') def get_pic(self):

print('开始网页get请求')

r = self.request(self.web_url)

print('开始获取所有img标签')

all_a = BeautifulSoup(r.text, 'lxml').find_all('img')

print('开始创建文件夹')

self.mkdir(self.folder_path)

print('开始切换文件夹')

os.chdir(self.folder_path)

i=0

for a in all_a:

i += 1

print("開始下載第{}張圖片".format(i))

thread_lock.acquire()

print("抓取圖片的URL:", a["src"])

self.save_img(a["src"], i) thread_lock = threading.BoundedSemaphore(value=10)

beauty = BeautifulPicture()

beauty.get_pic()

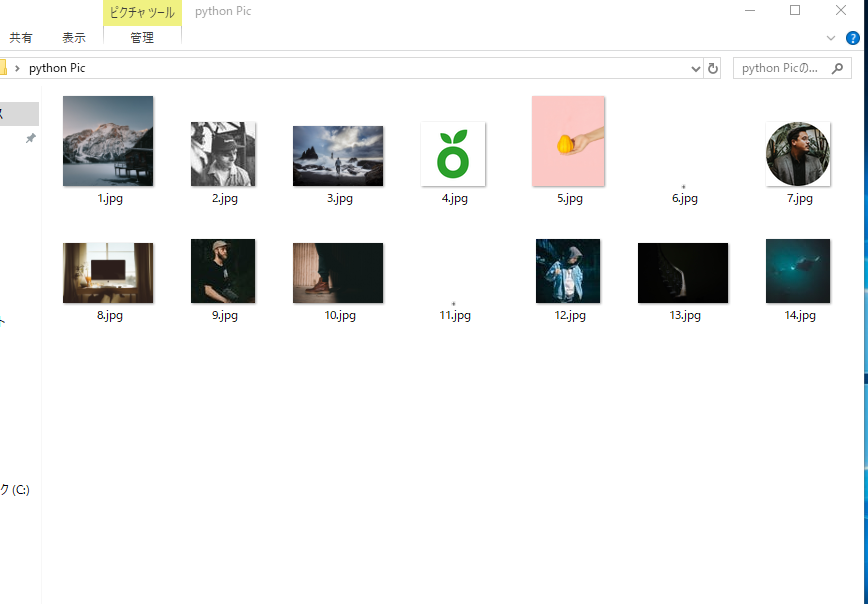

效果如下

本地的存放的路径下

python 爬虫实例(一)的更多相关文章

- Python爬虫实例:爬取B站《工作细胞》短评——异步加载信息的爬取

很多网页的信息都是通过异步加载的,本文就举例讨论下此类网页的抓取. <工作细胞>最近比较火,bilibili 上目前的短评已经有17000多条. 先看分析下页面 右边 li 标签中的就是短 ...

- Python爬虫实例:爬取猫眼电影——破解字体反爬

字体反爬 字体反爬也就是自定义字体反爬,通过调用自定义的字体文件来渲染网页中的文字,而网页中的文字不再是文字,而是相应的字体编码,通过复制或者简单的采集是无法采集到编码后的文字内容的. 现在貌似不少网 ...

- Python爬虫实例:爬取豆瓣Top250

入门第一个爬虫一般都是爬这个,实在是太简单.用了 requests 和 bs4 库. 1.检查网页元素,提取所需要的信息并保存.这个用 bs4 就可以,前面的文章中已经有详细的用法阐述. 2.找到下一 ...

- Python 爬虫实例

下面是我写的一个简单爬虫实例 1.定义函数读取html网页的源代码 2.从源代码通过正则表达式挑选出自己需要获取的内容 3.序列中的htm依次写到d盘 #!/usr/bin/python import ...

- shell及Python爬虫实例展示

1.shell爬虫实例: [root@db01 ~]# vim pa.sh #!/bin/bash www_link=http://www.cnblogs.com/clsn/default.html? ...

- python爬虫实例——爬取歌单

学习自<<从零开始学python网络爬虫>> 爬取酷狗歌单,保存入csv文件 直接上源代码:(含注释) import requests #用于请求网页获取网页数据 from b ...

- Python爬虫实例:糗百

看了下python爬虫用法,正则匹配过滤对应字段,这里进行最强外功:copy大法实践 一开始是直接从参考链接复制粘贴的,发现由于糗百改版导致失败,这里对新版html分析后进行了简单改进,把整理过程记录 ...

- python爬虫实例大全

WechatSogou [1]- 微信公众号爬虫.基于搜狗微信搜索的微信公众号爬虫接口,可以扩展成基于搜狗搜索的爬虫,返回结果是列表,每一项均是公众号具体信息字典. DouBanSpider [2]- ...

- Python 爬虫实例(爬百度百科词条)

爬虫是一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成.爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入 ...

- Python爬虫实例(三)代理的使用

一些网站会有相应的反爬虫措施,例如很多网站会检测某一段时间某个IP的访问次数,如果访问频率太快以至于看起来不像正常访客,它可能就会会禁止这个IP的访问.所以我们需要设置一些代理服务器,每隔一段时间换一 ...

随机推荐

- CODE FESTIVAL 2016 qual A题解

传送门 不知道为什么\(AGC\)系列的题里突然多了这些--那就做吧-- \(A\) 什么玩意儿-- upd:因为没看到最后要加换行居然没有\(1A\)好气哦-- const int N=15; ch ...

- AtCoder Grand Contest 009 题解

传送门 为啥这场题目少一点啊-- \(A\) 易知增加的数前面肯定比后面大,那么我们倒着做,然后维护一下最小要加多少就可以了 typedef long long ll; const int N=1e5 ...

- vim的四大模式

vim的四大模式 总结了下我经常使用的模式中的一些基本命令 正常模式 通过vim进入到界面, 首次即为正常模式 编辑模式 (i,a,o,s,I,A,S) i: 当前节点插入光标点 a: 下一个字母后插 ...

- 《挑战30天C++入门极限》C++的iostream标准库介绍(1)

C++的iostream标准库介绍(1) 我们从一开始就一直在利用C++的输入输出在做着各种练习,输入输出是由iostream库提供的,所以讨论此标准库是有必要的,它与C语言的stdio库不同 ...

- Python之☞float浮点数精度问题

Python的浮点数损失精度问题(转) 一个简单的面试题: >>>0.1+0.1+0.1 0.2 >>>0.1+0.1+0.1 0.3000000000000000 ...

- Linux shell head 命令

输出前25行 head -n25 input.txt head -n input.txt head - input.txt 输出前5个字符 head -c5 test.cpp head -c test ...

- CF1205题解

B 最高有\(64\)位,当\(n\le 128\)时,最坏情况形成不了三元环,\(floyed\)暴力做 否则直接输出\(3\) C 题意的\(n\)均为奇数,设\((i,j)\),把\(i+j\) ...

- ubuntu之路——day7.4 梯度爆炸和梯度消失、初始化权重、梯度的数值逼近和梯度检验

梯度爆炸和梯度消失: W[i] > 1:梯度爆炸(呈指数级增长) W[i] < 1:梯度消失(呈指数级衰减) *.注意此时的1指单位矩阵,W也是系数矩阵 初始化权重: np.random. ...

- 第07组 Alpha冲刺(2/6)

队长:摇光 队长:杨明哲 组长博客:求戳 作业博客:求再戳 队长:杨明哲 过去两天完成了哪些任务 文字/口头描述:重写后端,完成了数据请求部分的后端. 展示GitHub当日代码/文档签入记录:(组内共 ...

- C语言中size_t类型详细说明【转载】

来看看网上的一些说法: C语言 size_t到底是个什么东东? 大神求解 . 简单理解为 unsigned int就可以了 . 这是在不同的机器里面的的头文件定义的相应宏定义,实际上是unsigned ...