Python 爬虫利器 Selenium

前面几节,我们学习了用 requests 构造页面请求来爬取静态网页中的信息以及通过 requests 构造 Ajax 请求直接获取返回的 JSON 信息。

还记得前几节,我们在构造请求时会给请求加上浏览器 headers,目的就是为了让我们的请求模拟浏览器的行为,防止被网站的反爬虫策略限制。今天要介绍的 Selenium 是一款强大的工具,它可以控制我们的浏览器,这样一来程序的行为就和人类完全一样了。

通过使用 Selenium 可以解决几个问题:

- 页面内容是由 JavaScript 动态生成,通过 requests 请求页面无法获取内容。

- 爬虫程序被反爬虫策略限制

- 让程序的行为和人一样

安装

pip install selenium安装浏览器驱动

下载后把驱动文件加入环境变量。或者直接把驱动文件和 Python脚本放到同一文件夹下面

测试

安装完成后,可以编写以下脚本来测试是否安装成功。from selenium import webdriver

driver = webdriver.Chrome() # 创建一个 Chrome WebDriver 实例

driver.get('https://www.baidu.com/') # 打开网址

运行后会发现程序自动打开了 Chrome 浏览器,并且定向到了百度首页。

与页面交互

WebDriver定义了很多方法,我们可以很方便的操作页面上的元素

比如获取元素,可以通过driver.find_element_by_id("id")或者driver.find_element_by_name("name")以及 xpath路径的方式来获取元素。可以通过send_keys 向输入框中写入文本。from selenium import webdriver

driver = webdriver.Chrome()

driver.get('https://www.baidu.com/')

search_input = driver.find_element_by_id("kw") # 获取到百度搜索框

search_input.send_keys("刘亦菲") # 自动输入 刘亦菲

submit = driver.find_element_by_id("su") # 获取到百度一下按钮

submit.click() # 点击搜索

运行以上脚本,程序会自动打开 Chrome 浏览器,并自动搜索 刘亦菲

其他操作

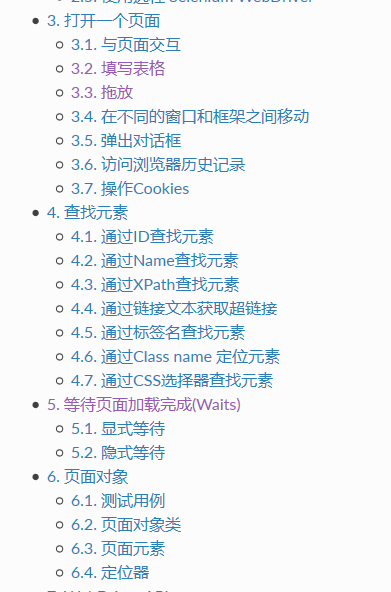

Selenium 可以进行各种各样的操作,使程序完全符合人类的操作习惯。下面看一下还有哪些功能。

具体可以看官方文档,这里贴一下地址

[https://selenium-python-zh.readthedocs.io/en/latest/index.html](https://selenium-python-zh.readthedocs.io/en/latest/index.html)Python 爬虫利器 Selenium的更多相关文章

- Python 爬虫利器 Selenium 介绍

Python 爬虫利器 Selenium 介绍 转 https://mp.weixin.qq.com/s/YJGjZkUejEos_yJ1ukp5kw 前面几节,我们学习了用 requests 构造页 ...

- python爬虫利器Selenium使用详解

简介: 用pyhon爬取动态页面时普通的urllib2无法实现,例如下面的京东首页,随着滚动条的下拉会加载新的内容,而urllib2就无法抓取这些内容,此时就需要今天的主角selenium. Sele ...

- (转)Python爬虫利器一之Requests库的用法

官方文档 以下内容大多来自于官方文档,本文进行了一些修改和总结.要了解更多可以参考 官方文档 安装 利用 pip 安装 $ pip install requests 或者利用 easy_install ...

- [Python爬虫]使用Selenium操作浏览器订购火车票

这个专题主要说的是Python在爬虫方面的应用,包括爬取和处理部分 [Python爬虫]使用Python爬取动态网页-腾讯动漫(Selenium) [Python爬虫]使用Python爬取静态网页-斗 ...

- Python爬虫利器二之Beautiful Soup的用法

上一节我们介绍了正则表达式,它的内容其实还是蛮多的,如果一个正则匹配稍有差池,那可能程序就处在永久的循环之中,而且有的小伙伴们也对写正则表达式的写法用得不熟练,没关系,我们还有一个更强大的工具,叫Be ...

- Python爬虫之selenium的使用(八)

Python爬虫之selenium的使用 一.简介 二.安装 三.使用 一.简介 Selenium 是自动化测试工具.它支持各种浏览器,包括 Chrome,Safari,Firefox 等主流界面式浏 ...

- python 爬虫利器 Beautiful Soup

python 爬虫利器 Beautiful Soup Beautiful Soup 是一个可以从HTML或XML文件中提取数据的Python库.它能够通过你喜欢的转换器实现惯用的文档导航,查找,修改文 ...

- Python爬虫利器六之PyQuery的用法

前言 你是否觉得 XPath 的用法多少有点晦涩难记呢? 你是否觉得 BeautifulSoup 的语法多少有些悭吝难懂呢? 你是否甚至还在苦苦研究正则表达式却因为少些了一个点而抓狂呢? 你是否已经有 ...

- Python爬虫利器一之Requests库的用法

前言 之前我们用了 urllib 库,这个作为入门的工具还是不错的,对了解一些爬虫的基本理念,掌握爬虫爬取的流程有所帮助.入门之后,我们就需要学习一些更加高级的内容和工具来方便我们的爬取.那么这一节来 ...

随机推荐

- Beautiful用法总结

一.安装 通过命令:pip3 install Beautifulsoup4: 安装后运行:from bs4 import BeautifulSoup,没有报错,说明安装正常: 二.解析库 Beauti ...

- 记录一次go性能调试的过程

安装 go, git, go-torch 备注, go1.11后, 集成了 go-torch

- C++—模板(2)类模板与其特化

我们以顺序表为例来说明,普通顺序表的定义如下: typedef int DataType; //typedef char DataType; class SeqList { private : Dat ...

- Nginx+DNS负载均衡实现

负载均衡有多种实现方法,nginx.apache.LVS.F5硬件.DNS等. DNS的负载均衡就是一个域名指向多个ip地址,客户访问的时候进行轮询解析 操作方法,在域名服务商解析的DNS也可以是第三 ...

- __builtin_expect — 分支预测优化

1.引言 在很多源码如Linux内核.Glib等,我们都能看到likely()和unlikely()这两个宏,通常这两个宏定义是下面这样的形式. #define likely(x) __builtin ...

- SQL反模式学习笔记5 外键约束【不用钥匙的入口】

目标:简化数据库架构 一些开发人员不推荐使用引用完整性约束,可能不使用外键的原因有一下几点: 1.数据更新有可能和约束冲突: 2.当前的数据库设计如此灵活,以至于不支持引用完整性约束: 3.数据库为外 ...

- git 相关学习

1.Git 的一些快捷键 第一次创建本git 本地仓库 :: git init //在本地创建一个 Git仓库 :要在该目录下 第一次 要配置GitHub 的 账号和邮箱: git config ...

- webstorm调试

webstorm调试nodejs https://www.cnblogs.com/dogharry/p/4335157.html webstorm调试js https://www.cnblo ...

- vue-cli3.0使用及配置

1.先全局安装vue-cli3.0 检测安装: vue -V 2.创建项目(这个就跟react创建脚手架项目比较像了) 这里如果你是第一次用3.0版本的话,是没有前两个的,而只有最后两个,这里是 ...

- navigator的一些冷知识

{ 监听屏幕旋转变化接口: orientationchange orientation.angle : 0 竖屏 , 90 向左横屏 , -90/270 向右横屏 , 180 倒屏 } screenO ...