Scrapy模拟登录信息

携带cookie模拟登录

- 需要在爬虫里面自定义一个

start_requests()的函数- 里面的内容:

def start_requests(self):

cookies = '真实有效的cookie'

yield scrapy.Request(

self.start_urls[0],

callback = self.paese,

cookies = cookies

)

下载中间件

- 只需在文件最下面定义自己的中间件即可

下载中间键里可以做很多内容:携带登录信息,设置user-agent,添加代理等

- 使用前要在settings里面设置一下

- 数字代表权重

projectname.middlewares.DownloadMiddlewareName

DOWNLOADER_MIDDLEWARES = {

'superspider.middlewares.SuperspiderDownloaderMiddleware': 543,

}

- 设置user-agent

process_request

定义一个名为RandomUserAgentMiddleware的下载中间件

from fake_useragent import UserAgent

class RandomUserAgentMiddleware:

def process_request(self, request, spider):

##### 还可以为不同爬虫指定不同的中间件

if spider.name == 'spider1':

ua = UserAgent()

request.headers["User-Agent"] = ua.random

在settings里导入

DOWNLOADER_MIDDLEWARES = {

'superspider.middlewares.RandomUserAgentMiddleware': 543

}

- 审核user-agent

process_response- 需要返回response

- 在settings里导入

class UserAgentCheck:

def process_response(self, request, response, spider):

print(request.headers['User-Agent'])

return response

DOWNLOADER_MIDDLEWARES = {

'superspider.middlewares.RandomUserAgentMiddleware': 543,

'superspider.middlewares.UserAgentCheck': 544

}

- 设置代理

- 需要在request的meta信息中添加proxy字段

- 添加代理的形式:协议+IP+端口

- settings里导入

class ProxyMiddleware:

def process_request(self, request, spider):

if spider.name == 'spider0':

request.meta["proxy"] = "http://ip:port"

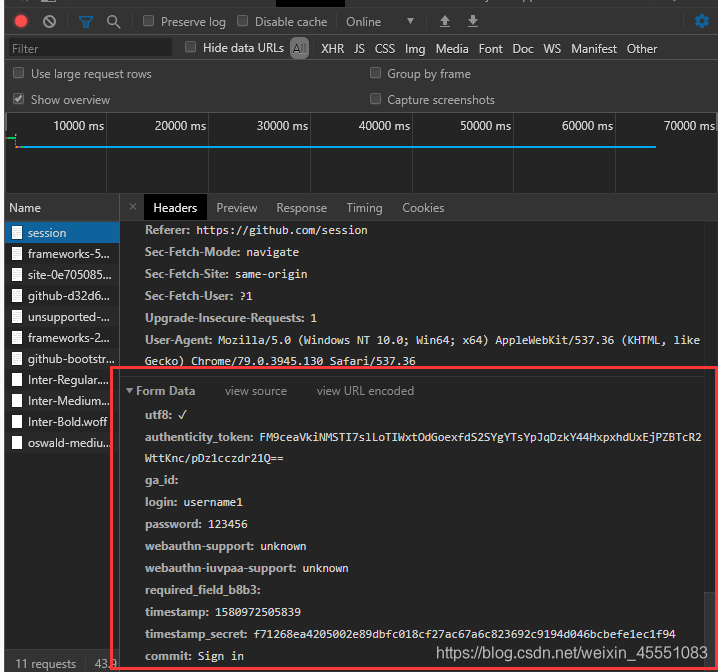

模拟登录GitHub

自己构造表单模拟登录 使用 FormRequest

- 明确要yield的内容,并交给下一个函数处理

# -*- coding: utf-8 -*-

import scrapy

class Spider0Spider(scrapy.Spider):

name = 'spider0'

allowed_domains = ['github.com']

start_urls = ['https://github.com/session']

def parse(self, response):

yield scrapy.FormRequest(

"https://github.com/session",

formdata=,

callback=self.after_login

)

def after_login(self, response):

pass

- formdate的构造

# -*- coding: utf-8 -*-

import scrapy

class Spider0Spider(scrapy.Spider):

name = 'spider0'

allowed_domains = ['github.com']

start_urls = ['https://github.com/session']

def parse(self, response):

form = {

'utf8': "✓",

'authenticity_token': response.xpath(

"//*[@id='unsupported-browser']/div/div/div[2]/form/input[2]/text()").extract_first(),

'ga_id': response.xpath('//*[@id="login"]/form/input[3]/@value').extract_first(),

'login': "",

'password': "",

'webauthn-support': 'supported',

'webauthn-iuvpaa-support': 'supported',

response.xpath('//*[@id="login"]/form/div[3]/input[5]/@name').extract_first(): "",

'timestamp': response.xpath("//*[@id='login']/form/div[3]/input[6]/@value").extract_first(),

"timestamp_secret": response.xpath("//*[@id='login'']/form/div[3]/input[7]/@value").extract_first(),

"commit": "Sign in"

}

print(form)

yield scrapy.FormRequest(

"https://github.com/session",

formdata=form,

callback=self.after_login

)

def after_login(self, response):

pass

自动寻找form表单中的信息

# -*- coding: utf-8 -*-

import scrapy

class Spider0Spider(scrapy.Spider):

name = 'spider0'

allowed_domains = ['github.com']

start_urls = ['https://github.com/session']

def parse(self, response):

yield scrapy.FormRequest.from_response(

response,

formdata={"login": "", "password":""},

callback=self.after_login

)

def after_login(self, response):

print(response.text)

Scrapy模拟登录信息的更多相关文章

- scrapy模拟登录微博

http://blog.csdn.net/pipisorry/article/details/47008981 这篇文章是介绍使用scrapy模拟登录微博,并爬取微博相关内容.关于登录流程为嘛如此设置 ...

- 利用scrapy模拟登录知乎

闲来无事,写一个模拟登录知乎的小demo. 分析网页发现:登录需要的手机号,密码,_xsrf参数,验证码 实现思路: 1.获取验证码 2.获取_xsrf 参数 3.携带参数,请求登录 验证码url : ...

- scrapy模拟登录

对于scrapy来说,也是有两个方法模拟登陆: 直接携带cookie 找到发送post请求的url地址,带上信息,发送请求 scrapy模拟登陆之携带cookie 应用场景: cookie过期时间很长 ...

- python爬虫之scrapy模拟登录

背景: 初来乍到的pythoner,刚开始的时候觉得所有的网站无非就是分析HTML.json数据,但是忽略了很多的一个问题,有很多的网站为了反爬虫,除了需要高可用代理IP地址池外,还需要登录.例如知乎 ...

- Scrapy模拟登录赶集网

1.打开赶集网登录界面,先模拟登录并抓包,获得post请求的request参数 2. 我们只需构造出上面的参数传入formdata即可 参数分析: setcookie:为自动登录所传的值,不勾选时默认 ...

- scrapy 基础组件专题(十二):scrapy 模拟登录

1. scrapy有三种方法模拟登陆 1.1直接携带cookies 1.2找url地址,发送post请求存储cookie 1.3找到对应的form表单,自动解析input标签,自动解析post请求的u ...

- Scrapy模拟登录知乎

建立项目 scrapy startproject zhihu_login scrapy genspider zhihu www.zhihu.com 编写spider 知乎的登录页url是http:// ...

- Scrapy模拟登录GitHub

d: 进入D盘 scrapy startproject GitHub 创建项目 scrapy genspider github github.com 创建爬虫 编辑github.py: # -*- c ...

- scrapy 模拟登录后再抓取

深度好文: from scrapy.contrib.spiders.init import InitSpider from scrapy.http import Request, FormReques ...

随机推荐

- Redis调用lua生成验证码

场景: 通过微信公众号拿验证码在APP上绑定,为了防止重复,尝试使用reids-lua的方法实现此功能 以下是 php 调用 redis.eval 方法传入的 lua 方法,当然这只是修改后的,保 ...

- 相见恨晚的 Git 命令动画演示,一看就懂!

虽然 Git 是一个强大的工具,但是我觉得大部分人都会同意我说的:它也可以是一个--噩梦!我一直觉得,使用 Git 的时候把操作过程在脑海里视觉化会非常有用:当我执行某个命令的时候,分支之间是如何交互 ...

- Promise入门详解

异步调用 异步 JavaScript的执行环境是单线程. 所谓单线程,是指JS引擎中负责解释和执行JavaScript代码的线程只有一个,也就是一次只能完成一项任务,这个任务执行完后才能执行下一个,它 ...

- C 电压

时间限制 : 10000 MS 空间限制 : - KB 评测说明 : 1s,256m 问题描述 JOI社的某个实验室中有着复杂的电路.电路由n个节点和m根细长的电阻组成.节点被标号为1~N ...

- C/C++知识总结 二 C/C++基础知识

C/C++基础知识 C/C++基本格式说明 C/C++基本常识说明 C/C++基本格式说明 C语言基本格式 #include<stdio.h> //预处理文件 int main() //自 ...

- JQ前端上传图片显示在页面以及发送到后端服务器

// 单张上传照片 html: <div class="azwoo"></div> <div class="azwot"& ...

- Tcl编成第二天,set与unset

代码如下: #!/usr/bin/tclsh set value "one" puts $value unset value puts $value set表示创建一个变量第一个参 ...

- 一、华为模拟器eNSP下载与安装教程

简单介绍一下 eNSP: eNSP是一款由华为提供的免费的图形化网络仿真工具平台,它将完美呈现真实设备实景(包括华为最新的ARG3路由器和X7系列的交换机),支持大型网络模拟,让你有机会在没有真实设备 ...

- Powershell抓取网页信息

一般经常使用invoke-restmethod和invoke-webrequest这两个命令来获取网页信息,如果对象格式是json或者xml会更容易 1.invoke-restmethod 我们可以用 ...

- Git应用详解第九讲:Git cherry-pick与Git rebase

前言 前情提要:Git应用详解第八讲:Git标签.别名与Git gc 这一节主要介绍git cherry-pick与git rebase的原理及使用. 一.Git cherry-pick Git ch ...