Python3爬虫实例 代理的使用

现在爬虫越来越难了,一些网站会有相应的反爬虫措施,例如很多网站会检测某一段时间某个IP的访问次数,如果访问频率太快以至于看起来不像正常访客,它可能就会会禁止这个IP的访问。

所以我们需要设置一些代理服务器,每隔一段时间换一个代理,就算IP被禁止,依然可以换个IP继续爬取。

网上有很多网站提供免费代理,但是经过测试基本都不可用,所以就付费买代理IP吧。目前市面有飞蚁代理,代理云,西瓜代理等。下面就介绍一下飞蚁代理使用情况。

1、首先注册一个用户,注册过程会送50元,可以下单测试。

2、下单如下:

这个测试期间有个效期,过期失效,据客服讲,正式的期限都比较长,直到用完为止,

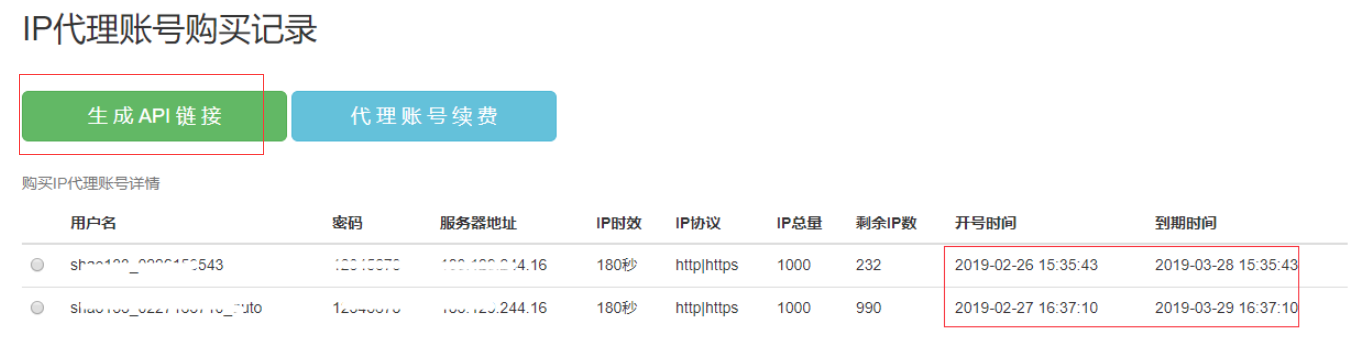

3、生成API链接

4、测试代码

获取代理

#获取代理IP

def getProxyIPs(self,num=1):

'''

获取代理IP

:param num: 获取的代理IP的个数

:return:

'''

proxy_ip=''

try:

url = 'http://183.129.244.16:88/open?user_name=sk133_0226153543×tamp=1551166598&' \

'md5=0ADAF27E30AFD0DD52D7B44F3A5C145F&pattern=json&number=%d' % num response = request.urlopen(url)

page = response.read()

txt = str(page.decode('utf-8'))

dataDict = json.loads(txt)

print(dataDict)

ports = dataDict.get('port')

# domain = dataDict.get('domain')

for port in ports:

proxy_ip = {'http': "http://" + self.proxy_server + ':' + str(port),

'https': 'https://' + self.proxy_server + ':' + str(port), }

except Exception as ex:

print(ex) return proxy_ip

利用获取代理抓取数据

def testproxy(self,url, proxy_IP):

try:

cookie1 = random.choice(self.mycookies)

UserAgent = random.choice(self.user_agent_list)

header = {'User-Agent': UserAgent}

# proxies=proxy_IP ,

txt = requests.get(url,proxies=proxy_IP ,cookies=cookie1, headers=header).text

print(txt)

except Exception as ex:

print(ex)

另外为chrome设置代理IP,以Chrome浏览器为例

chrome_options = Options()

chrome_options.add_argument('--headless')

chrome_options.add_argument('--disable-gpu')

proxy = '181.121.214.16:14140'

chrome_options.add_argument('--proxy-server=' + proxy) driver = webdriver.Chrome(chrome_options=chrome_options)

selenium 模块时,以phantomJS浏览器为例:

driver = webdriver.PhantomJS(service_args = [

'--proxy=183.129.244.16:11310',

'--proxy-type=http',

'--load-images=false'

])

Python3爬虫实例 代理的使用的更多相关文章

- python3.4学习笔记(十三) 网络爬虫实例代码,使用pyspider抓取多牛投资吧里面的文章信息,抓取政府网新闻内容

python3.4学习笔记(十三) 网络爬虫实例代码,使用pyspider抓取多牛投资吧里面的文章信息PySpider:一个国人编写的强大的网络爬虫系统并带有强大的WebUI,采用Python语言编写 ...

- python3.4学习笔记(十四) 网络爬虫实例代码,抓取新浪爱彩双色球开奖数据实例

python3.4学习笔记(十四) 网络爬虫实例代码,抓取新浪爱彩双色球开奖数据实例 新浪爱彩双色球开奖数据URL:http://zst.aicai.com/ssq/openInfo/ 最终输出结果格 ...

- python3爬虫系列19之反爬随机 User-Agent 和 ip代理池的使用

站长资讯平台:python3爬虫系列19之随机User-Agent 和ip代理池的使用我们前面几篇讲了爬虫增速多进程,进程池的用法之类的,爬虫速度加快呢,也会带来一些坏事. 1. 前言比如随着我们爬虫 ...

- Python 爬虫的代理 IP 设置方法汇总

本文转载自:Python 爬虫的代理 IP 设置方法汇总 https://www.makcyun.top/web_scraping_withpython15.html 需要学习的地方:如何在爬虫中使用 ...

- Python3 爬虫之 Scrapy 核心功能实现(二)

博客地址:http://www.moonxy.com 基于 Python 3.6.2 的 Scrapy 爬虫框架使用,Scrapy 的搭建过程请参照本人的另一篇博客:Python3 爬虫之 Scrap ...

- Python 爬虫实例

下面是我写的一个简单爬虫实例 1.定义函数读取html网页的源代码 2.从源代码通过正则表达式挑选出自己需要获取的内容 3.序列中的htm依次写到d盘 #!/usr/bin/python import ...

- Python爬虫实例:爬取B站《工作细胞》短评——异步加载信息的爬取

很多网页的信息都是通过异步加载的,本文就举例讨论下此类网页的抓取. <工作细胞>最近比较火,bilibili 上目前的短评已经有17000多条. 先看分析下页面 右边 li 标签中的就是短 ...

- Python爬虫实例:爬取猫眼电影——破解字体反爬

字体反爬 字体反爬也就是自定义字体反爬,通过调用自定义的字体文件来渲染网页中的文字,而网页中的文字不再是文字,而是相应的字体编码,通过复制或者简单的采集是无法采集到编码后的文字内容的. 现在貌似不少网 ...

- Python爬虫实例:爬取豆瓣Top250

入门第一个爬虫一般都是爬这个,实在是太简单.用了 requests 和 bs4 库. 1.检查网页元素,提取所需要的信息并保存.这个用 bs4 就可以,前面的文章中已经有详细的用法阐述. 2.找到下一 ...

随机推荐

- 51Nod1336 RMQ逆问题 其他

原文链接https://www.cnblogs.com/zhouzhendong/p/51Nod1336.html 题目传送门 - 51Nod1336 题意 题解 我们将输入的一个区间的答案称为 V ...

- Qt界面设计基础

一.安装Qt相关基本组件: 在ubuntu上安装,可以直接使用如下的命令来安装: sudo apt-get install ubuntu-sdk 详细的安装方法可以参考这篇文章:https://blo ...

- waf python build 工具使用流程

waf python build 工具使用流程 waf 的 build 理念 build 了之后,可以跟踪到 ${SRC} 和 ${TGT} 有关联的文件,只有 ${SRC} 被修改过,在下次buil ...

- 直接引用vee-validate校验插件

直接在页面引用vee-validate 源文件下载地址:http://www.bootcdn.cn/vee-validate/ 官方api https://baianat.github.io/vee- ...

- Java集合及LIst接口

一.集合的概念 1.概述: 在学习集合前,先回忆一下数组的一个特征---数组有固定的长度,定义一个数组: int[] array = new int[]; 而针对数据长度可变的情况,产生了集合, ja ...

- Visual Studio 2019及其注册码

Visual Studio 2019 更快地进行代码编写.更智能地执行操作.使用同类最佳IDE 创建未来. 下载Visual Studio 使用从初始设计到最终部署的完整工具集 ...

- centos6.5安装/升级到python2.7

https://www.cnblogs.com/harrymore/p/9024287.html

- Qt程序继承QApplication发生崩溃的原因

一.前情介绍 QApplication是Qt开发中经常用到的一个类,用来管理应用程序的生命周期.跟其相关的类还有QCoreApplication和QGuiApplication,分别用于不同场景下为应 ...

- Jenkins不同job之间传递参数

有的时候不同job直接需要传递一个文件名或者路径,这个时候我们不需要传递文件实体,那这个路径如何传递呢?比如有如下两个项目,我想把A的工作目录传递给B,让B使用. A job配置 首先需要安装一个Pa ...

- Touch事件详解及区别,触屏滑动距离计算

移动端有四个关于触摸的事件,分别是touchstart.touchmove.touchend.touchcancel(比较少用), 它们的触发顺序是touchstart-->touchmove- ...