pyspider爬虫框架webui简介-爬取阿里招聘信息

命令行输入pyspider开启pyspider

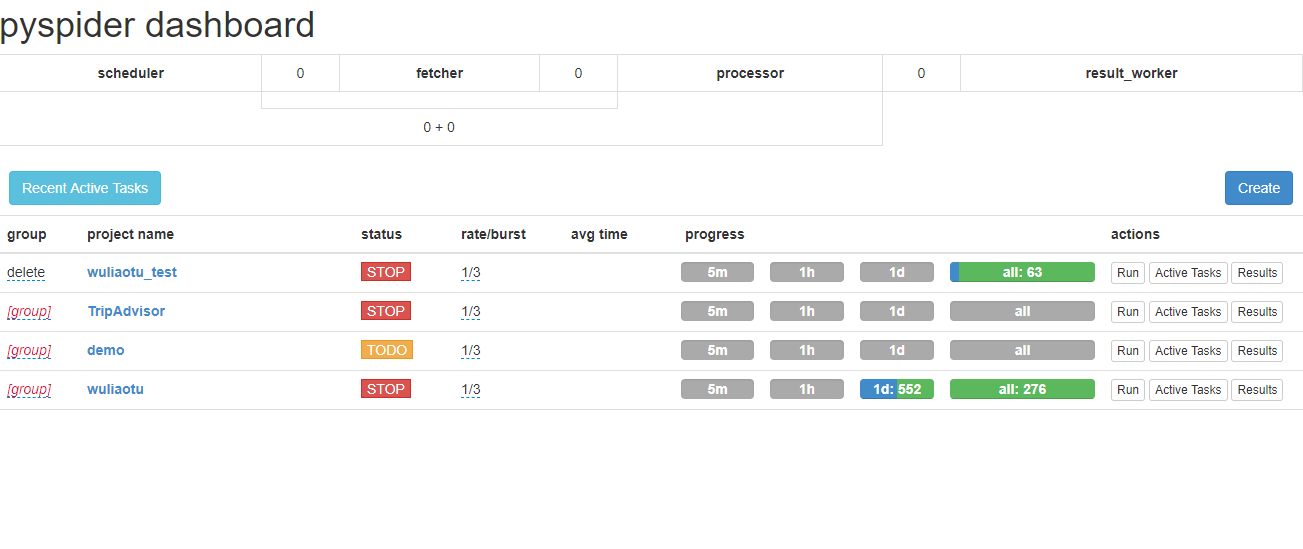

浏览器打开http://localhost:5000/

group表示组名,几个项目可以同一个组名,方便管理,当组名修改为delete时,项目会在一天后自动删除。

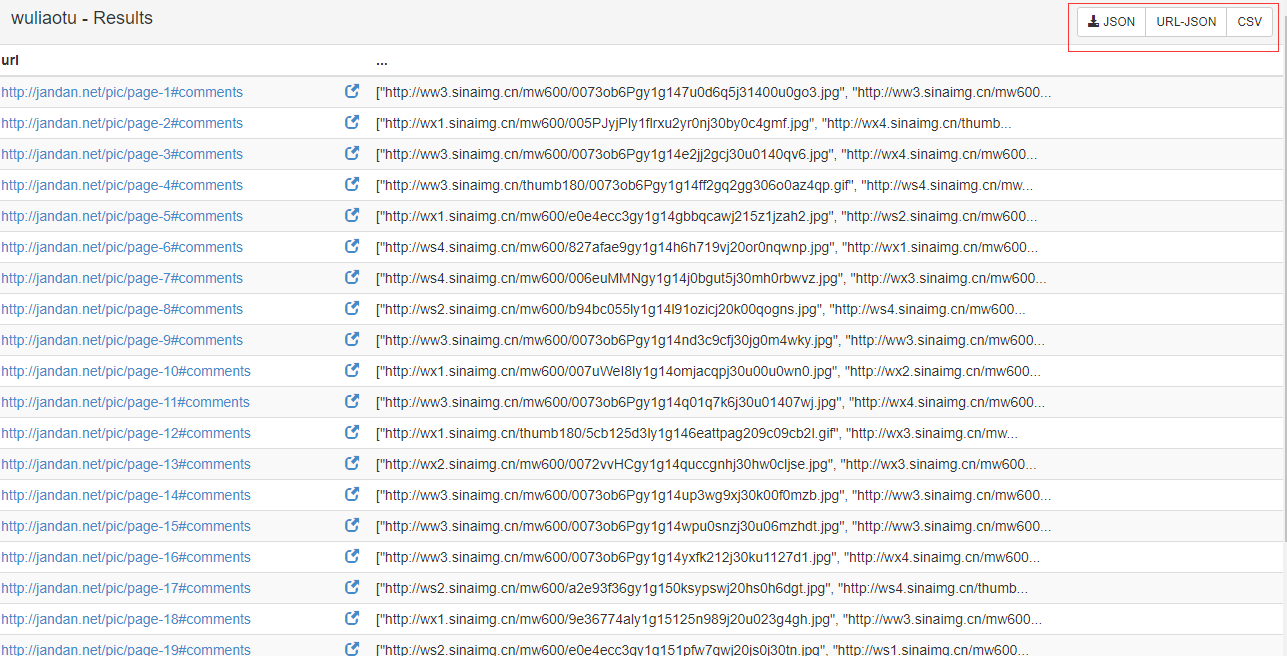

status表示项目的状态,TODO工作环境,STOP停用状态,DEBUG调试状态,RUNNING运行状态。当设置为RUNNING状态时,点击右边actions的Run按钮,程序就会跑起来。actions中的Results按钮点击之后,查看程序爬取的结果,如图:

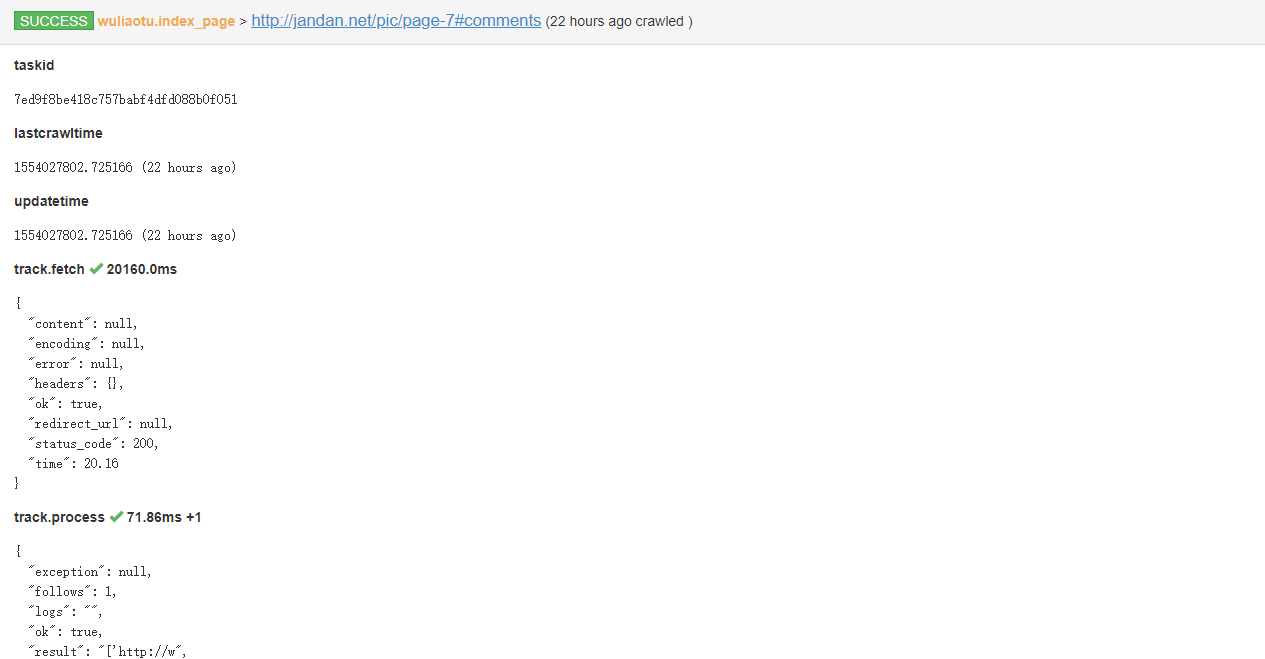

点击右上角,可以以不同格式查看爬取信息,点击url可以查看每个url爬取的任务ID,结果等信息。如图:

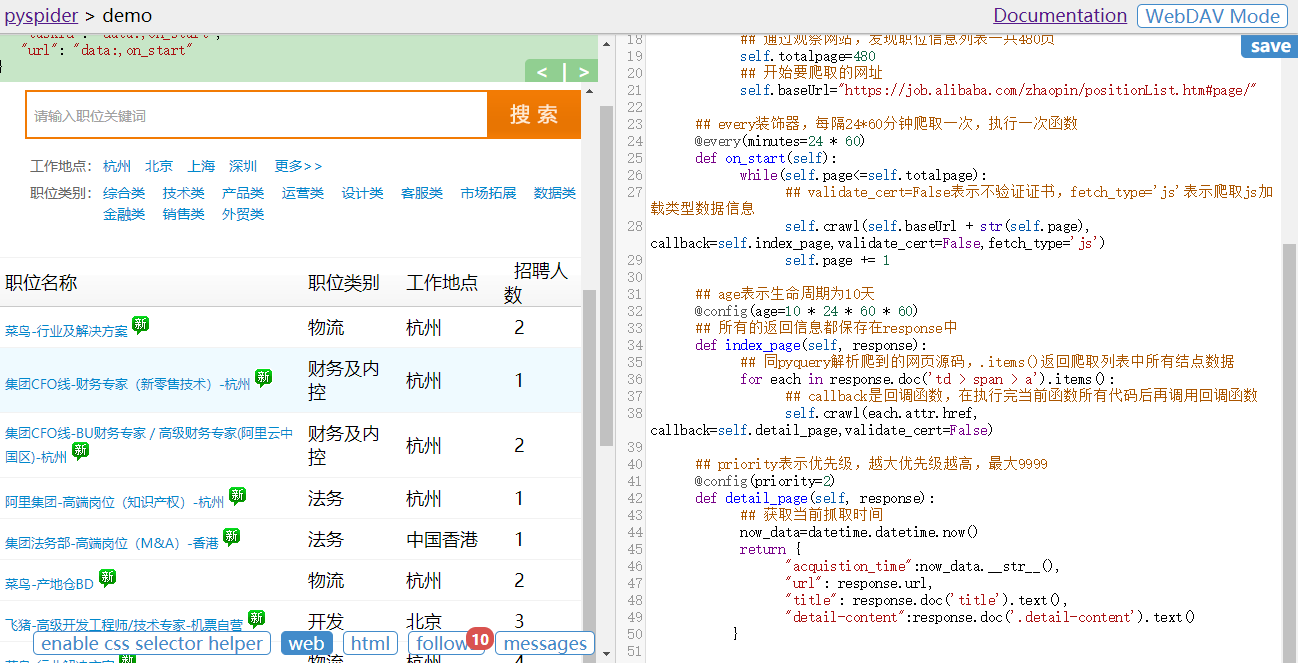

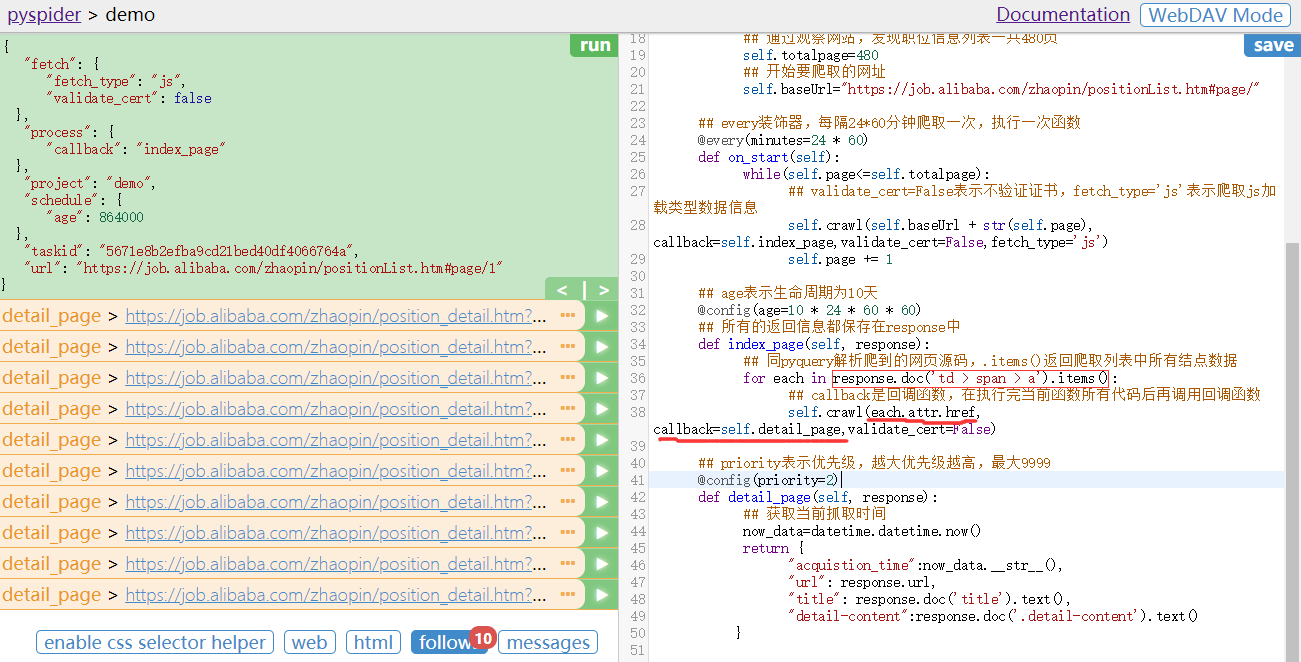

点击项目名,进入代码界面:

看代码,

#!/usr/bin/env python

# -*- encoding: utf-8 -*-

# Created on 2019-03-24 13:51:31

# Project: demo

from pyspider.libs.base_handler import *

import datetime

class Handler(BaseHandler):

crawl_config = {

}

def __init__(self):

'''用户自定义,初始化变量'''

## 当前页码

self.page=1

## 通过观察网站,发现职位信息列表一共480页

self.totalpage=480

## 开始要爬取的网址

self.baseUrl="https://job.alibaba.com/zhaopin/positionList.htm#page/"

## every装饰器,每隔24*60分钟爬取一次,执行一次函数

@every(minutes=24 * 60)

def on_start(self):

while(self.page<=self.totalpage):

## validate_cert=False表示不验证证书,fetch_type='js'表示爬取js加载类型数据信息

self.crawl(self.baseUrl + str(self.page), callback=self.index_page,validate_cert=False,fetch_type='js')

self.page += 1

## age表示生命周期为10天

@config(age=10 * 24 * 60 * 60)

## 所有的返回信息都保存在response中

def index_page(self, response):

## 同pyquery解析爬到的网页源码,.items()返回爬取列表中所有结点数据

for each in response.doc('td > span > a').items():

## callback是回调函数,在执行完当前函数所有代码后再调用回调函数

self.crawl(each.attr.href, callback=self.detail_page,validate_cert=False)

## priority表示优先级,越大优先级越高,最大9999

@config(priority=2)

def detail_page(self, response):

## 获取当前抓取时间

now_data=datetime.datetime.now()

return {

"acquistion_time":now_data.__str__(),

"url": response.url,

"title": response.doc('title').text(),

"detail-content":response.doc('.detail-content').text()

}

然后看左边编辑器,

每次编辑好右边代码后点击右上角SAVE按钮保存,然后点击RUN,运行程序

follows表示当前执行回调函数on_start执行之后,有多少此回调index_page函数,传入参数self。点击follows,出现每一个index_page函数传入的self中的链接,对应链接右边的向右箭头,执行该index_page函数。

点击第一个index_page函数右边箭头之后,点击web按钮,显示index_page传入链接的网页如图,点击html按钮,是web网页对应的源码,点击follows如图,显示执行index_page回调函数后的结果,即列表页信息。

然后,在点击web按钮后,点击enable css selector helper按钮,选中web网页中对应职位标题,单击选中,然后点击左边窗体右上角的箭头,就会将对应选择结点的CSS选择器自动生成到右边代码编辑区鼠标定位处。

继续回来,点击follows,然后点击detail_page回调函数右边的箭头执行每个detail_page回调函数,则爬取了detail_page返回的内容,即详情页信息,每个职位的详细信息。

messages按钮表示右边代码中return的信息,及控制台提示信息、报错信息等。

pyspider爬虫框架webui简介-爬取阿里招聘信息的更多相关文章

- 爬虫框架之Scrapy——爬取某招聘信息网站

案例1:爬取内容存储为一个文件 1.建立项目 C:\pythonStudy\ScrapyProject>scrapy startproject tenCent New Scrapy projec ...

- 【图文详解】scrapy爬虫与动态页面——爬取拉勾网职位信息(2)

上次挖了一个坑,今天终于填上了,还记得之前我们做的拉勾爬虫吗?那时我们实现了一页的爬取,今天让我们再接再厉,实现多页爬取,顺便实现职位和公司的关键词搜索功能. 之前的内容就不再介绍了,不熟悉的请一定要 ...

- 爬取拉勾网招聘信息并使用xlwt存入Excel

xlwt 1.3.0 xlwt 文档 xlrd 1.1.0 python操作excel之xlrd 1.Python模块介绍 - xlwt ,什么是xlwt? Python语言中,写入Excel文件的扩 ...

- Python爬虫框架Scrapy获得定向打击批量招聘信息

爬虫,就是一个在网上到处或定向抓取数据的程序,当然,这样的说法不够专业,更专业的描写叙述就是.抓取特定站点网页的HTML数据.只是因为一个站点的网页非常多,而我们又不可能事先知道全部网页的URL地址, ...

- Python爬取拉勾网招聘信息并写入Excel

这个是我想爬取的链接:http://www.lagou.com/zhaopin/Python/?labelWords=label 页面显示如下: 在Chrome浏览器中审查元素,找到对应的链接: 然后 ...

- Java爬虫框架WebMagic入门——爬取列表类网站文章

初学爬虫,WebMagic作为一个Java开发的爬虫框架很容易上手,下面就通过一个简单的小例子来看一下. WebMagic框架简介 WebMagic框架包含四个组件,PageProcessor.Sch ...

- 爬虫框架Scrapy入门——爬取acg12某页面

1.安装1.1自行安装python3环境1.2ide使用pycharm1.3安装scrapy框架2.入门案例2.1新建项目工程2.2配置settings文件2.3新建爬虫app新建app将start_ ...

- python-scrapy爬虫框架爬取拉勾网招聘信息

本文实例为爬取拉勾网上的python相关的职位信息, 这些信息在职位详情页上, 如职位名, 薪资, 公司名等等. 分析思路 分析查询结果页 在拉勾网搜索框中搜索'python'关键字, 在浏览器地址栏 ...

- Scrapy框架——CrawlSpider爬取某招聘信息网站

CrawlSpider Scrapy框架中分两类爬虫,Spider类和CrawlSpider类. 它是Spider的派生类,Spider类的设计原则是只爬取start_url列表中的网页, 而Craw ...

随机推荐

- Unlink——2016 ZCTF note2解析

简介 Unlink是经典的堆漏洞,刚看到这个漏洞不知道如何实现任意代码执行,所以找了一个CTF题,发现还有一些细节的地方没有讲的很清楚,题目在这里.自己也动手写一遍,体验一下 题目描述 首先,我们先分 ...

- Request.Params

在开发中有时会用到Request.Params["id"]来获取参数,那么到底是从什么地方接收参数呢? 一般情况下,有三种方式进行参数传递1.GET 方式,通过url传递,如?id ...

- .NET [MVC] 利用特性捕捉异常

声明:本代码只适用于.NET MVC. 先创建一个类继承ActionFilterAttribute这个抽象类以及实现IExceptionFilter接口,并实现它的方法OnException. 代码如 ...

- Java开发笔记(七十八)面向对象的后门——反射

作为一门面向对象的编程语言,Java认为一切皆是对象,每个对象都能归属于某个类,甚至每个类均可提取出一种特殊的类型,即Class类型.早在前面介绍多态的时候,就提到每个类都存在独一无二的基因,通过比较 ...

- LeetCode 176. 第二高的薪水(MySQL版)

0.前言 最近刷LeetCode 刷数据库题目 由于数据库课上的是SQL,而MySQL有许多自己的函数的,怕把刚学会的函数忘记 特在此记录! 1.题目 编写一个 SQL 查询,获取 Employee ...

- 第九课 表单及表单控件 html5学习4

表单有由表单域.提示文本.表单3部分构成 一.表单控件 input 控件 1.<input />单标签2.input属性: 可以通过type属性变换形状 value默认值 name名称 c ...

- IBGP默认的TTL值为255

结论: 1.IBGP默认的TTL值为255 组网图: 抓包内容: 1.在AR1和AR2之间抓包,只显示BGP包,显示内容如下:

- MongoDB在Linux下常用优化设置

MongoDB在Linux下常用优化设置 以下是一些MongoDB推荐的常用优化设置.在生产环境下选取合适的参数值,例如预读值和默认文件描述符数目等,会对系统性能有很大的影响. 1.关闭数据库文件的 ...

- Android中将一个图片切割成多个图片

有种场景,我们想将一个图片切割成多个图片.比如我们在开发一个拼图的游戏,就首先要对图片进行切割. 以下是封装好的两个类,可以实现图片的切割.仅供参考和学习. 一个是ImagePiece类,此类保存了一 ...

- Android远程桌面助手之性能监测篇

<Android下获取FPS的几种方法>一文中提到了Gamebench工具,它不仅可以获取FPS,还可以获取CPU及内存占用率等系统状态信息.其局限性也非常明显,切换应用时需要重新选择监控 ...