scrapy爬虫,爬取图片

一、scrapy的安装:

本文基于Anacoda3,

Anacoda2和3如何同时安装?

将Anacoda3安装在C:\ProgramData\Anaconda2\envs文件夹中即可。

如何用conda安装scrapy?

安装了Anaconda2和3后,

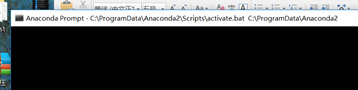

如图,只有一个命令框,可以看到打开的时候:

可以切到Anaconda3对应的路径下即可。

安装的方法:cmd中:conda install scrapy即可。

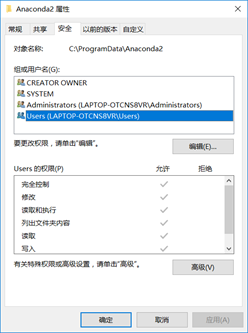

当然,可能会出现权限的问题,那是因为安装的文件夹禁止了读写。可以如图:

将权限都设为“允许“。

注意:此时虽然scapy安装上了,但是在cmd中输入scapy可能会不认,可以将安装scrapy.exe的路径添加到环境变量中。

二、scapy的简单使用

例子:爬取图片

1、 创建scrapy工程

譬如,想要创建工程名:testImage

输入:scrapy startproject testImage

即可创建该工程,按照cmd中提示的依次输入:

cd testImage

scrapy genspider getPhoto www.27270.com/word/dongwushijie/2013/4850.html

其中:在当前项目中创建spider,这仅仅是创建spider的一种快捷方法,该方法可以使用提前定义好的模板来生成spider,后面的网址是一个采集网址的集合,即为允许访问域名的一个判断。注意不要加http/https。

至此,可以在testImage\testImage\spiders中找到创建好的爬虫getPhoto.py,可以在此基础上进行修改。

2、创建爬虫

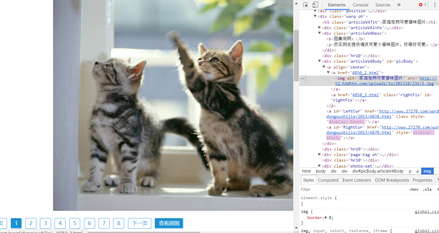

如图,可以在图片的位置右键,检查,查看源码,在图片所在的位置处,将xpath拷贝出来。

此时,可以找出图片的地址:

class GetphotoSpider(scrapy.Spider):

name = 'getPhoto'

allowed_domains = ['www.27270.com']

start_urls = ['http://www.27270.com/word/dongwushijie/2013/4850.html']

def parse(self, response):

urlImage = response.xpath('//*[@id="picBody"]/p/a[1]/img/@src').extract()

print(urlImage)

pass

此时,注意网络路径的正确书写,最后没有/,

http://www.27270.com/word/dongwushijie/2013/4850.html/

此时将4850.html 当作了目录,会出现404找不到路径的错误!

3、 下载图片

items.py:

class PhotoItem(scrapy.Item):

name = scrapy.Field()

imageLink = scrapy.Field()

pipelines.py:

from scrapy.pipelines.images import ImagesPipeline

import scrapy

class ImagePipeline(ImagesPipeline):

def get_media_requests(self,item,info):

image_link = item['imageLink']

yield scrapy.Request(image_link)

settings.py:

IMAGES_STORE = r"C:\Users\24630\Desktop\test"

另外,对于上面的网址,还需要ROBOTSTXT_OBEY = False

并且,访问该网址会出现302错误,这是一个重定向的问题,

MEDIA_ALLOW_REDIRECTS =True

设置该选项,就可以正确下载,但是下载的还是不对,问题不好解决。

当然在爬虫中,还要对items赋值:

from testImage import items

。。。 for urllink in urlImage:

item = items.PhotoItem()

item['imageLink'] = urllink

三、 进一步爬取(读取下一页)

# -*- coding: utf-8 -*-

import scrapy

from testImage import items

class GetphotoSpider(scrapy.Spider):

name = 'getPhoto'

allowed_domains = ['www.wmpic.me']

start_urls = ['http://www.wmpic.me/93912']

def parse(self, response):

#//*[@id="content"]/div[1]/p/a[2]/img

urlImage = response.xpath('//*[@id="content"]/div[1]/p/a/img/@src').extract()

print(urlImage)

for urllink in urlImage:

item = items.PhotoItem()

item['imageLink'] = urllink

yield item ifnext = response.xpath('//*[@id="content"]/div[2]/text()').extract()[0]

# 当没有下一篇,即最后一页停止爬取

if("下一篇" in ifnext):

nextUrl = response.xpath('//*[@id="content"]/div[2]/a/@href').extract()[0]

url=response.urljoin(nextUrl)

yield scrapy.Request(url=url)

此时,便可以看到路径下的下载后的文件了。(由于该网址每页的图片所在的xpath都不一样,故下载的图片不全)

scrapy爬虫,爬取图片的更多相关文章

- 使用scrapy爬虫,爬取17k小说网的案例-方法一

无意间看到17小说网里面有一些小说小故事,于是决定用爬虫爬取下来自己看着玩,下图这个页面就是要爬取的来源. a 这个页面一共有125个标题,每个标题里面对应一个内容,如下图所示 下面直接看最核心spi ...

- [python爬虫] 爬取图片无法打开或已损坏的简单探讨

本文主要针对python使用urlretrieve或urlopen下载百度.搜狗.googto(谷歌镜像)等图片时,出现"无法打开图片或已损坏"的问题,作者对它进行简单的探讨.同时 ...

- python +requests 爬虫-爬取图片并进行下载到本地

因为写12306抢票脚本需要用到爬虫技术下载验证码并进行定位点击所以这章主要讲解,爬虫,从网页上爬取图片并进行下载到本地 爬虫实现方式: 1.首先选取你需要的抓取的URL:2.将这些URL放入待抓 ...

- 使用scrapy框架爬取图片网全站图片(二十多万张),并打包成exe可执行文件

目标网站:https://www.mn52.com/ 本文代码已上传至git和百度网盘,链接分享在文末 网站概览 目标,使用scrapy框架抓取全部图片并分类保存到本地. 1.创建scrapy项目 s ...

- Python 爬虫 爬取图片入门

爬虫 网络爬虫(又被称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者),是一种按照一定的规则,自动的抓取万维网信息的程序或者脚本. 用户看到的网页实质是由 HTML 代码构成的,爬 ...

- python爬虫---scrapy框架爬取图片,scrapy手动发送请求,发送post请求,提升爬取效率,请求传参(meta),五大核心组件,中间件

# settings 配置 UA USER_AGENT = 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, l ...

- <scrapy爬虫>爬取校花信息及图片

1.创建scrapy项目 dos窗口输入: scrapy startproject xiaohuar cd xiaohuar 2.编写item.py文件(相当于编写模板,需要爬取的数据在这里定义) # ...

- 使用scrapy爬虫,爬取今日头条搜索吉林疫苗新闻(scrapy+selenium+PhantomJS)

这一阵子吉林疫苗案,备受大家关注,索性使用爬虫来爬取今日头条搜索吉林疫苗的新闻 依然使用三件套(scrapy+selenium+PhantomJS)来爬取新闻 以下是搜索页面,得到吉林疫苗的搜索信息, ...

- 使用scrapy ImagesPipeline爬取图片资源

这是一个使用scrapy的ImagesPipeline爬取下载图片的示例,生成的图片保存在爬虫的full文件夹里. scrapy startproject DoubanImgs cd DoubanIm ...

- <scrapy爬虫>爬取360妹子图存入mysql(mongoDB还没学会,学会后加上去)

1.创建scrapy项目 dos窗口输入: scrapy startproject images360 cd images360 2.编写item.py文件(相当于编写模板,需要爬取的数据在这里定义) ...

随机推荐

- C语言实现线性表

#include <stdio.h> #include <stdlib.h> //提供malloc()原型 /* 线性表需要的方法: 1. List MakeEmpty():初 ...

- JavaScript的基本介绍

JavaScript入门介绍 输出语句:document.write() 1.执行顺序:从上到下,每一天语句是要加分号的,如果不加的话,浏览器会默认帮你自动添加,分号. 2.注释:一行注释就是 ...

- 差分约束系统专题 && 对差分约束系统的理解

具体能解决的问题: 求最长路,最短路,或者判断解是否存在. 在建边的时候: 一般是给你区间减法的关系,或者是这个点到另一个点的关系.如果给你的关系是除法的话,我们可以通过使用两边同时取log的方式,将 ...

- VUE组件相关总结!

定义使用一个组件 <!doctype html> <html lang="en"> <head> <meta charset=" ...

- PHP简单爬虫 爬取免费代理ip 一万条

目标站:http://www.xicidaili.com/ 代码: <?php require 'lib/phpQuery.php'; require 'lib/QueryList.php'; ...

- UNIX网络编程 第8章 基本UDP套接字编程

UDP是无连接的,不需要accept,TCP通过accept API来接受连接,并且将连接客户端的信息写入到accept将返回的新socket中,该新socket中有服务端和客户端的IP地址和端口,因 ...

- 最长上升子序列O(nlogn) 要强的T^T(2358)

题目来源:http://www.fjutacm.com/Problem.jsp?pid=2358 要强的T^T TimeLimit:1000MS MemoryLimit:65536K 64-bit ...

- [转载]Windows服务编写原理及探讨(3)

(三)对服务的深入讨论之下 现在我们还剩下一个函数可以在细节上讨论,那就是服务的CtrlHandler函数. 当调用RegisterServiceCtrlHandler函数时,SCM得到并保存这个回调 ...

- js函数前加分号和感叹号是什么意思?有什么用?

一般看JQuery插件里的写法是这样的 (function($) { //... })(jQuery); 今天看到bootstrap的javascript组件是这样写的 !function( $ ){ ...

- WiFi无线连接真机进行Appium自动化测试方法

有时需要测试APP 产品的耗电问题,但用自动化又面临了一个USB接电脑供电的问题,从而导致计算出来的功耗与手动跑,存在有很大的误差,因此可使用wifi无线连接到手机进行自动化测试,解决功耗问题. 前提 ...