四十四 Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的基本查询

1、elasticsearch(搜索引擎)的查询

elasticsearch是功能非常强大的搜索引擎,使用它的目的就是为了快速的查询到需要的数据

查询分类:

基本查询:使用elasticsearch内置的查询条件进行查询

组合查询:把多个查询条件组合在一起进行复合查询

过滤:查询同时,通过filter条件在不影响打分的情况下筛选数据

2、elasticsearch(搜索引擎)创建数据

首先我们先创建索引、表、以及字段属性、字段类型、添加好数据

注意:一般我们中文使用ik_max_word中文分词解析器,所有在需要分词建立倒牌索引的字段都要指定,ik_max_word中文分词解析器

系统默认不是ik_max_word中文分词解析器

ik_max_word中文分词解析器是elasticsearch(搜索引擎)的一个插件,在elasticsearch安装目录的plugins/analysis-ik文件夹里,版本为5.1.1

更多说明:https://github.com/medcl/elasticsearch-analysis-ik

说明:

#创建索引(设置字段类型)

#注意:一般我们中文使用ik_max_word中文分词解析器,所有在需要分词建立倒牌索引的字段都要指定,ik_max_word中文分词解析器

#系统默认不是ik_max_word中文分词解析器

PUT jobbole #创建索引设置索引名称

{

"mappings": { #设置mappings映射字段类型

"job": { #表名称

"properties": { #设置字段类型

"title":{ #表名称

"store": true, #字段属性true表示保存数据

"type": "text", #text类型,text类型可以分词,建立倒排索引

"analyzer": "ik_max_word" #设置分词解析器,ik_max_word是一个中文分词解析器插件

},

"company_name":{ #字段名称

"store": true, #字段属性true表示保存数据

"type": "keyword" #keyword普通字符串类型,不分词

},

"desc":{ #字段名称

"type": "text" #text类型,text类型可以分词,但是没有设置分词解析器,使用系统默认

},

"comments":{ #字段名称

"type": "integer" #integer数字类型

},

"add_time":{ #字段名称

"type": "date", #date时间类型

"format":"yyyy-MM-dd" #yyyy-MM-dd时间格式化

}

}

}

}

}

#保存文档(相当于数据库的写入数据)

POST jobbole/job

{

"title":"python django 开发工程师", #字段名称:值

"company_name":"美团科技有限公司", #字段名称:值

"desc":"对django的概念熟悉, 熟悉python基础知识", #字段名称:值

"comments":20, #字段名称:值

"add_time":"2017-4-1" #字段名称:值

} POST jobbole/job

{

"title":"python scrapy redis 分布式爬虫基础",

"company_name":"玉秀科技有限公司",

"desc":"对scrapy的概念熟悉, 熟悉redis基础知识",

"comments":5,

"add_time":"2017-4-2"

} POST jobbole/job

{

"title":"elasticsearch打造搜索引擎",

"company_name":"通讯科技有限公司",

"desc":"对elasticsearch的概念熟悉",

"comments":10,

"add_time":"2017-4-3"

} POST jobbole/job

{

"title":"pyhhon打造推荐引擎系统",

"company_name":"智能科技有限公司",

"desc":"熟悉推荐引擎系统算法",

"comments":60,

"add_time":"2017-4-4"

}

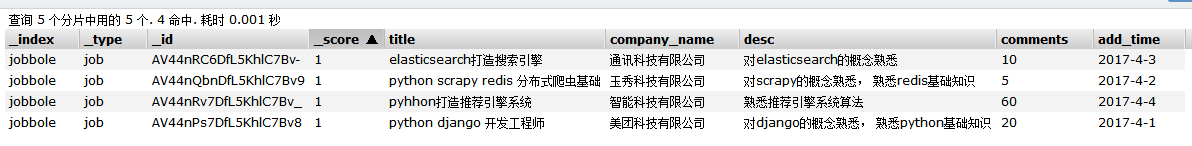

通过上面可以看到我们创建了索引并且设置好了字段的属性、类型、以及分词解析器,创建了4条数据

3、elasticsearch(搜索引擎)基本查询

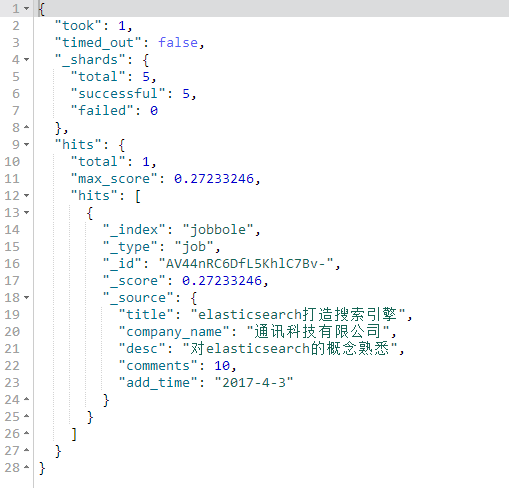

match查询【用的最多】

会将我们的搜索词在当前字段设置的分词器进行分词,到当前字段查找,匹配度越高排名靠前,如果搜索词是大写字母会自动转换成小写

#match查询

#会将我们的搜索词进行分词,到指定字段查找,匹配度越高排名靠前

GET jobbole/job/_search

{

"query": {

"match": {

"title": "搜索引擎"

}

}

}

term查询

不会将我们的搜索词进行分词,将搜索词完全匹配的查询

#term查询

#不会将我们的搜索词进行分词,将搜索词完全匹配的查询

GET jobbole/job/_search

{

"query": {

"term": {

"title":"搜索引擎"

}

}

}

terms查询

传递一个数组,将数组里的词分别匹配

#terms查询

#传递一个数组,将数组里的词分别匹配

GET jobbole/job/_search

{

"query": {

"terms": {

"title":["工程师","django","系统"]

}

}

}

控制查询的返回数量

from从第几条数据开始

size获取几条数据

#控制查询的返回数量

#from从第几条数据开始

#size获取几条数据

GET jobbole/job/_search

{

"query": {

"match": {

"title": "搜索引擎"

}

},

"from": 0,

"size": 3

}

match_all查询,查询所有数据

#match_all查询,查询所有数据

GET jobbole/job/_search

{

"query": {

"match_all": {}

}

}

match_phrase查询

短语查询

短语查询,会将搜索词分词,放进一个列表如[python,开发]

然后搜索的字段必须满足列表里的所有元素,才符合

slop是设置分词后[python,开发]python 与 开发,之间隔着多少个字符算匹配

间隔字符数小于slop设置算匹配到,间隔字符数大于slop设置不匹配

#match_phrase查询

#短语查询

#短语查询,会将搜索词分词,放进一个列表如[python,开发]

#然后搜索的字段必须满足列表里的所有元素,才符合

#slop是设置分词后[python,开发]python 与 开发,之间隔着多少个字符算匹配

#间隔字符数小于slop设置算匹配到,间隔字符数大于slop设置不匹配

GET jobbole/job/_search

{

"query": {

"match_phrase": {

"title": {

"query": "elasticsearch引擎",

"slop":3

}

}

}

}

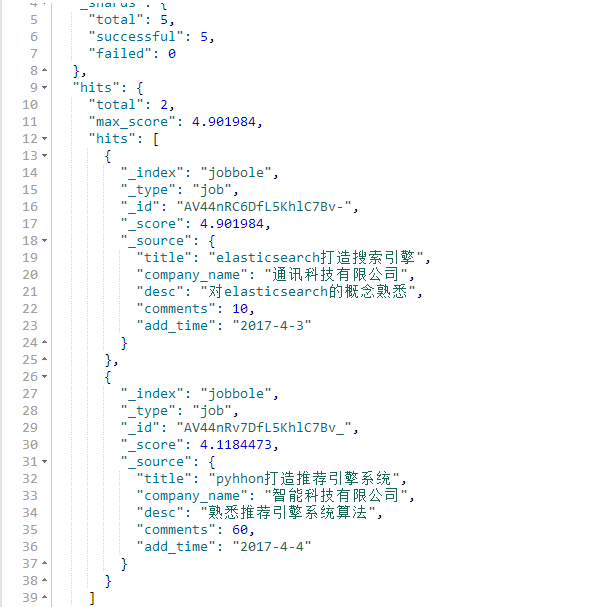

multi_match查询

比如可以指定多个字段

比如查询title字段和desc字段里面包含python的关键词数据

query设置搜索词

fields要搜索的字段

title^3表示权重,表示title里符合的关键词权重,是其他字段里符合的关键词权重的3倍

#multi_match查询

#比如可以指定多个字段

#比如查询title字段和desc字段里面包含python的关键词数据

#query设置搜索词

#fields要搜索的字段

#title^3表示权重,表示title里符合的关键词权重,是其他字段里符合的关键词权重的3倍

GET jobbole/job/_search

{

"query": {

"multi_match": {

"query": "搜索引擎",

"fields": ["title^3","desc"]

}

}

}

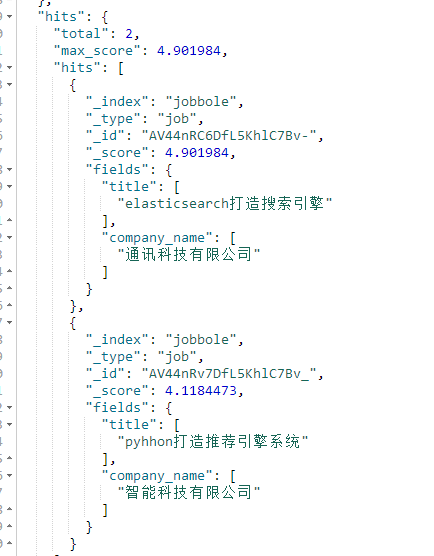

stored_fields设置搜索结果只显示哪些字段

注意:使用stored_fields要显示的字段store属性必须为true,如果要显示的字段没有设置store属性那么默认为false,如果为false将不会显示该字段

#stored_fields设置搜索结果只显示哪些字段

GET jobbole/job/_search

{

"stored_fields": ["title","company_name"],

"query": {

"multi_match": {

"query": "搜索引擎",

"fields": ["title^3","desc"]

}

}

}

通过sort搜索结果排序

注意:排序的字段必须是数字或者日期

desc升序

asc降序

#通过sort搜索结果排序

#注意:排序的字段必须是数字或者日期

#desc升序

#asc降序

GET jobbole/job/_search

{

"query": {

"match_all": {}

},

"sort": [{

"comments": {

"order": "asc"

}

}]

}

range字段值范围查询

查询一个字段的值范围

注意:字段值必须是数字或者时间

gte大于等于

ge大于

lte小于等于

lt小于

boost是权重,可以给指定字段设置一个权重

#range字段值范围查询

#查询一个字段的值范围

#注意:字段值必须是数字或者时间

#gte大于等于

#ge大于

#lte小于等于

#lt小于

#boost是权重,可以给指定字段设置一个权重

GET jobbole/job/_search

{

"query": {

"range": {

"comments": {

"gte": 10,

"lte": 20,

"boost": 2.0

}

}

}

}

range字段值为时间范围查询

#range字段值为时间范围查询

#查询一个字段的时间值范围

#注意:字段值必须是时间

#gte大于等于

#ge大于

#lte小于等于

#lt小于

#now为当前时间

GET jobbole/job/_search

{

"query": {

"range": {

"add_time": {

"gte": "2017-4-1",

"lte": "now"

}

}

}

}

wildcard查询,通配符查询

*代表一个或者多个任意字符

#wildcard查询,通配符查询

#*代表一个或者多个任意字符

GET jobbole/job/_search

{

"query": {

"wildcard": {

"title": {

"value": "py*n",

"boost": 2

}

}

}

}

fuzzy模糊查询

#fuzzy模糊搜索

#搜索包含词的内容

GET lagou/biao/_search

{

"query": {

"fuzzy": {"title": "广告"}

},

"_source": ["title"]

} #fuzziness设置编辑距离,编辑距离就是把要查找的字段值,编辑成查找的关键词需要编辑多少个步骤(插入、删除、替换)

#prefix_length为关键词前面不参与变换的长度

GET lagou/biao/_search

{

"query": {

"fuzzy": {

"title": {

"value": "广告录音",

"fuzziness": 2,

"prefix_length": 2

}

}

},

"_source": ["title"]

}

四十四 Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的基本查询的更多相关文章

- 第三百六十四节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mapping映射管理

第三百六十四节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mapping映射管理 1.映射(mapping)介绍 映射:创建索引的时候,可以预先定义字 ...

- 第三百七十节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现搜索结果分页

第三百七十节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现搜索结果分页 逻辑处理函数 计算搜索耗时 在开始搜索前:start_time ...

- 第三百六十九节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现搜索功能

第三百六十九节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现搜索功能 Django实现搜索功能 1.在Django配置搜索结果页的路由映 ...

- 第三百六十六节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的bool组合查询

第三百六十六节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的bool组合查询 bool查询说明 filter:[],字段的过滤,不参与打分must:[] ...

- 第三百六十五节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的基本查询

第三百六十五节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的基本查询 1.elasticsearch(搜索引擎)的查询 elasticsearch是功能 ...

- 第三百六十三节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mget和bulk批量操作

第三百六十三节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mget和bulk批量操作 注意:前面讲到的各种操作都是一次http请求操作一条数据,如果想 ...

- 第三百六十节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的基本概念

第三百六十节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的基本概念 elasticsearch的基本概念 1.集群:一个或者多个节点组织在一起 2.节点 ...

- 第三百五十九节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)介绍以及安装

第三百五十九节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)介绍以及安装 elasticsearch(搜索引擎)介绍 ElasticSearch是一个基于 ...

- 五十 Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现我的搜索以及热门搜索

第三百七十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现我的搜索以及热门 我的搜素简单实现原理我们可以用js来实现,首先用js获取到 ...

- 第三百六十七节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)scrapy写入数据到elasticsearch中

第三百六十七节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)scrapy写入数据到elasticsearch中 前面我们讲到的elasticsearch( ...

随机推荐

- 剑指Offer——用两个栈实现队列

题目描述: 用两个栈来实现一个队列,完成队列的Push和Pop操作. 队列中的元素为int类型. 分析: 代码: class Solution { public: void push(int node ...

- Java实现对List去重

方式一,使用for循环遍历去除List中的重复元素代码如下 public static void main(String[] args) { Test07 test07 = new Test07(); ...

- python线程间数据共享(示例演示)

``` import threading data_list = [] def task(arg): data_list.append(arg) print(data_list) def run(): ...

- hibernate detached分离查询 与 抓取策略注意事项

1.detached在抓取策略为 jion显式左外连接查询情况下 会产生笛卡儿积现象 DetachedCriteria dc = DetachedCriteria.forClass(Topic.cla ...

- Ubuntu Linux下通过代理(proxy)使用git上github.com

版权声明:本文为博主原创文章,未经博主同意不得转载. https://blog.csdn.net/loveaborn/article/details/24575659 github.com.作为程序猿 ...

- Linux Shell编程第2章——Linux文件系统

目录 用户和用户组管理 用户管理常用命令 用户组管理常用命令 文件和目录操作 文件操作常用命令 目录操作常用命令 文件和目录权限管理 文件查找--find 用户和用户组管理 用户管理常用命令 用户的角 ...

- NHibernate MappingException. No Persister

在另一个Visual Studio项目(议会mm.k.Infrastructure)我有我的映射文件(一个映射目录),我的hibernate.cfg.xml和一些仓库. 这是我的映射文件: <? ...

- [笔记]Go语言的字符串拼装方式性能对比

Go语言中字符串的拼装方法很多,那么问题来了,到底哪家性能好? 下面代码,分别比较了 fmt.Sprintf,string +,strings.Join,bytes.Buffer,方法是循环若干次比较 ...

- html-2, a img ul li ol dl dt dd 标签与列表标签的简单使用

<!-- a: a{ /*清除a标签的下划线*/ text-decoration: none; } (1)超链接 href 超链接的地址 target: _self 默认 在当前中打开链接地 ...

- canvas 事件绑定

Canvas事件绑定 canvas事件绑定 众所周知canvas是位图,在位图里我们可以在里面画各种东西,可以是图片,可以是线条等等.那我们想给canvas里的某一张图片添加一个点击事件该怎么做到 ...