ELK学习实验020:ELK使用kafka缓存

首先安装一个kafka集群,但是zookeeper使用单节点,可以让kafka快速跑起来,后续再研究kafka和zokkeeper的集群

1 安装Kafka集群

下面是三个节点都要做

[root@node1 src]# wget http://mirror.rise.ph/apache/kafka/2.4.0/kafka_2.11-2.4.0.tgz

[root@node1 src]# tar -xf kafka_2.11-2.4.0.tgz

[root@node1 src]# mv kafka_2.11-2.4.0 /usr/local/kafka

[root@node1 src]# cd /usr/local/kafka

就使用node1作为zooker节点

[root@node1 kafka]# nohup ./bin/zookeeper-server-start.sh ./config/zookeeper.properties &

三个节点的kafka配置文件

[root@node1 kafka]# grep -Ev "^$|[;#]" config/server.properties

broker.id=0

listeners=PLAINTEXT://:9092

advertised.listeners=PLAINTEXT://192.168.132.131:9092

num.network.threads=3

num.io.threads=8

socket.send.buffer.bytes=102400

socket.receive.buffer.bytes=102400

socket.request.max.bytes=104857600

log.dirs=/tmp/kafka-logs

num.partitions=1

num.recovery.threads.per.data.dir=1

offsets.topic.replication.factor=1

transaction.state.log.replication.factor=1

transaction.state.log.min.isr=1

log.retention.hours=168

log.segment.bytes=1073741824

log.retention.check.interval.ms=300000

zookeeper.connect=192.168.132.131:2181

zookeeper.connection.timeout.ms=6000

group.initial.rebalance.delay.ms=0

[root@node2 kafka]# grep -Ev "^$|[;#]" config/server.properties

broker.id=1

listeners=PLAINTEXT://:9092

advertised.listeners=PLAINTEXT://192.168.132.132:9092

num.network.threads=3

num.io.threads=8

socket.send.buffer.bytes=102400

socket.receive.buffer.bytes=102400

socket.request.max.bytes=104857600

log.dirs=/tmp/kafka-logs

num.partitions=1

num.recovery.threads.per.data.dir=1

offsets.topic.replication.factor=1

transaction.state.log.replication.factor=1

transaction.state.log.min.isr=1

log.retention.hours=168

log.segment.bytes=1073741824

log.retention.check.interval.ms=300000

zookeeper.connect=192.168.132.131:2181

zookeeper.connection.timeout.ms=6000

group.initial.rebalance.delay.ms=0

[root@node3 kafka]# grep -Ev "^$|[;#]" config/server.properties

broker.id=2

listeners=PLAINTEXT://:9092

advertised.listeners=PLAINTEXT://192.168.132.133:9092

num.network.threads=3

num.io.threads=8

socket.send.buffer.bytes=102400

socket.receive.buffer.bytes=102400

socket.request.max.bytes=104857600

log.dirs=/tmp/kafka-logs

num.partitions=1

num.recovery.threads.per.data.dir=1

offsets.topic.replication.factor=1

transaction.state.log.replication.factor=1

transaction.state.log.min.isr=1

log.retention.hours=168

log.segment.bytes=1073741824

log.retention.check.interval.ms=300000

zookeeper.connect=192.168.132.131:2181

zookeeper.connection.timeout.ms=6000

group.initial.rebalance.delay.ms=0

都启动kafka

[root@node1 kafka]# nohup ./bin/kafka-server-start.sh ./config/server.properties &

[root@node2 kafka]# nohup ./bin/kafka-server-start.sh ./config/server.properties &

[root@node3 kafka]# nohup ./bin/kafka-server-start.sh ./config/server.properties &

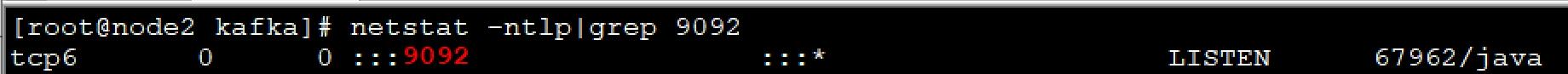

2 检查kafka状态

查看端口

查看其他端口

使用一下

[root@node1 kafka]# ./bin/zookeeper-shell.sh 192.168.132.131:2181

3 测试zookeeper

连接到zookeeper

ls /brokers

[ids, seqid, topics]

ls /brokers/ids

[0, 1, 2]

create /test "hello"

Created /test

get /test

hello

4 测试kafka使用

创建一个topic

[root@node1 kafka]# ./bin/kafka-topics.sh --create --zookeeper 192.168.132.131:2181 --replication factor 3 --partitions 3 --topic kafkatest

Created topic kafkatest.

[root@node1 kafka]# ./bin/kafka-topics.sh --list --zookeeper 192.168.132.131:2181

kafkatest

[root@node1 kafka]# ./bin/kafka-topics.sh --describe --zookeeper 192.168.132.131:2181 --topic kafkatest

Topic: kafkatest PartitionCount: 3 ReplicationFactor: 3 Configs:

Topic: kafkatest Partition: 0 Leader: 0 Replicas: 0,1,2 Isr: 0,1,2

Topic: kafkatest Partition: 1 Leader: 1 Replicas: 1,2,0 Isr: 1,2,0

Topic: kafkatest Partition: 2 Leader: 2 Replicas: 2,0,1 Isr: 2,0,1

测试发送消息

[root@node1 kafka]# ./bin/kafka-topics.sh --create --zookeeper 192.168.132.131:2181 --replication-factor 3 --partitions 3 --topic messagetest

Created topic messagetest.

[root@node1 kafka]# ./bin/kafka-console-producer.sh --broker-list 192.168.132.131:9092,192.168.132.132:9092,192.168.132.133:9092 --topic messagetest

这里可以输入消息

>helloworld

>hello

node2和node3查看

[root@node2 kafka]# ./bin/kafka-console-consumer.sh --bootstrap-server 192.168.132.131:9092 --topic messagetest --from-beginning

helloworld

hello

[root@node3 kafka]# ./bin/kafka-console-consumer.sh --bootstrap-server 192.168.132.131:9092 --topic messagetest --from-beginning

helloworld

hello

5 配置filebeat

配置filebeat文件

filebeat.inputs:

#####################################################

## Nginx log

#####################################################

- type: log

enabled: true

paths:

- /usr/local/nginx/logs/access.log

json.key_under_root: true

json.overwrite_keys: true

tags: ["access"] - type: log

enabled: true

paths:

- /usr/local/nginx/logs/error.log

tags: ["error"]

output.kafka:

hosts: ["192.168.132.131:9092","192.168.132.132:9092","192.168.132.133:9092"]

topic: "elklog"

[root@node4 ~]# systemctl restart filebeat

6 配置logstash

修改logstah

input {

kafka {

bootstrap_server => "192.168.132.131:9092"

topics=>["elklog"]

group_id=>"logstash"

codec => "json"

}

}

filter{

mutate {

convert => ["upstream_time","float"]

convert => ["request_time","float"]

}

}

output{

stdout {}

if "access" in [tags]{

elasticsearch {

hosts => "192.168.132.131:9200"

manage_template => false

index => "nginx_access-%{+yyyy.MM.dd}"

}

}

if "error" in [tags]{

elasticsearch {

hosts => "192.168.132.131:9200"

manage_template => false

index => "nginx_error-%{+yyyy.MM.dd}"

}

}

}

~

启动logstah

[root@node4 ~]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/logsatsh.conf

[INFO ] 2020-01-21 10:15:57.734 [[main]-pipeline-manager] javapipeline - Pipeline started {"pipeline.id"=>"main"}

[INFO ] 2020-01-21 10:15:57.931 [Agent thread] agent - Pipelines running {:count=>1, :running_pipelines=>[:main], :non_running_pipelines=>[]}

[INFO ] 2020-01-21 10:15:58.630 [Api Webserver] agent - Successfully started Logstash API endpoint {:port=>9600}

7 测试整个环境

访问生成数据

查看topic

[root@node1 kafka]# ./bin/kafka-topics.sh --list --zookeeper 192.168.132.131:2181

__consumer_offsets

elklog #已经有定义好的topic

kafkatest

messagetest

查看索引

查看kinban

{

"_index": "nginx_access-2020.01.21",

"_type": "_doc",

"_id": "F1O0yG8BOF7DoSFd9EoQ",

"_version": 1,

"_score": null,

"_source": {

"ecs": {

"version": "1.1.0"

},

"@timestamp": "2020-01-21T15:24:58.441Z",

"agent": {

"type": "filebeat",

"version": "7.4.2",

"hostname": "node4",

"id": "bb3818f9-66e2-4eb2-8f0c-3f35b543e025",

"ephemeral_id": "af9e9e07-03a6-4869-a5ff-9476ccf00dae"

},

"json": {

"Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/79.0.3945.117 Safari/537.36",

"upstreamtime": "-",

"upstreamhost": "-",

"responsetime": 0,

"xff": "-",

"domain": "192.168.132.134",

"@timestamp": "2020-01-21T10:24:57-05:00",

"http_host": "192.168.132.134",

"size": 555,

"status": "404",

"referer": "-",

"url": "/tcp",

"host": "192.168.132.134",

"clientip": "192.168.132.1"

},

"tags": [

"access"

],

"input": {

"type": "log"

},

"@version": "1",

"log": {

"offset": 24522559,

"file": {

"path": "/usr/local/nginx/logs/access.log"

}

},

"host": {

"name": "node4"

}

},

"fields": {

"json.@timestamp": [

"2020-01-21T15:24:57.000Z"

],

"@timestamp": [

"2020-01-21T15:24:58.441Z"

]

},

"sort": [

1579620298441

]

}

实验完成

ELK学习实验020:ELK使用kafka缓存的更多相关文章

- ELK学习实验014:Nginx日志JSON格式收集

1 Kibana的显示配置 https://demo.elastic.co/app/kibana#/dashboard/welcome_dashboard 环境先处理干净 安装nginx和httpd- ...

- ELK学习实验019:ELK使用redis缓存

1 安装一个redis服务 [root@node4 ~]# yum -y install redis 直接启动 [root@node4 ~]# systemctl restart redis [roo ...

- ELK学习实验013:ELK的一个完整的配置操作

前面做了关于ELK组件的各个实验,但是并没有真正的把各个组件结合起来做一个实验,现在使用一个脚本简单的生成日志,模拟生产不断产生日志的效果 一 流程说明 使用脚本产生日志,模拟用户的操作 日志的格式 ...

- ELK学习实验002:Elasticsearch介绍及单机安装

一 简介 ElasticSearch是一个基于Luncene的搜索服务器.它提供了一个分布式多用户能力全文搜索引擎,基于RESTful web接口,ElsticSearch使用Java开发的,并作为A ...

- ELK学习实验001:Elastic Stack简介

1 背景介绍 在我们日常生活中,我们经常需要回顾以前发生的一些事情:或者,当出现了一些问题的时候,可以从某些地方去查找原因,寻找发生问题的痕迹.无可避免需要用到文字的.图像的等等不同形式的记录.用计算 ...

- ELK学习实验012:Logstash的安装和使用

一 logstash安装 1.1下载包 [root@node1 ~]# cd /usr/local/src/ [root@node1 src]# wget https://artifacts.elas ...

- ELK学习实验010:Logstash简介

Logstash是具有实时流水线功能的开源数据收集引擎.Logstash可以动态统一来自不同来源的数据,并将数据规范化为您选择的目标.清除所有数据并使其民主化,以用于各种高级下游分析和可视化用例. 虽 ...

- ELK学习实验008:Kibana的介绍

一 简介 Kiana是一款开源的数据分析和可视化平台,它是 Elastic Stack成员之一,设计用于和 Elasticsearch协作.您可以使用 Kiana对 Elasticsearch索引中的 ...

- ELK学习实验007:Nginx的日志分析系统之Metribeat配置

一 Metricbeat 简介 1.1 系统级监控,更简洁将 Metricbeat 部署到您的所有 Linux.Windows 和 Mac 主机,并将它连接到 Elasticsearch 就大功告成了 ...

随机推荐

- DDD实战让中台和微服务的落地如虎添翼

微服务到底怎么拆分和设计才算合理,拆多小才叫微服务?有没有好的方法来指导微服务和中台的设计呢? 深入DDD的核心知识体系与设计思想,带你掌握一套完整而系统的基于DDD的微服务拆分与设计方法,助力落地边 ...

- Axure常用操作备忘

目录 前言 技巧 边框重合 复制对象文本居中 复制粘贴样式 文本自适应 给图形添加连接点 导出图片无空白 前言 下面列出Axure画图过程中曾经遇到过的问题,备忘一下,避免别人也走弯路,法布施一下~ ...

- Linux(CentOS7)安装与卸载MySQL8.0图文详解

Mysql数据库的安装对于开发者来说,是我们必然会面对的问题,它的安装过程其实并不复杂,并且网络上的安装教程也非常多,但是对于新手来说,各种不同形式的安装教程,又给新手们带来了要选择哪种方式进行安装的 ...

- 2021S软件工程——个人阅读作业1

2021S软件工程--个人阅读作业1 项目 内容 这个作业属于哪个课程 2021春季软件工程(罗杰 任建) 这个作业的要求在哪里 2021年软工-热身阅读作业 我在这个课程的目标是 了解并熟悉软件开发 ...

- 010 Editor体验

源代码的我们现在拥有各式各样的IDE和编辑器可以去查看,但二进制文件对于大多数软件只能做到显示16进制,而不能按照文件类型的格式去显示.今天我们就用dex文件让010 show. 安装软件: http ...

- DLL内存加载

动态加载dll 功能: 把一个处于内存里的dll直接加载并且使用. 用途: 免杀(静态文件查杀),外挂(防止游戏自己hook了loadlibrary等函数),以及其他. 原理: ...

- Windows核心编程 第五章 作业(下)

5.4 查询作业统计信息 前面已经介绍了如何使用 Q u e r y I n f o r m a t i o n J o b O b j e c t函数来获取对作业的当前限制信息.也可以使用它来获取关 ...

- ExtJS4中Ext.onReady、Ext.define、Ext.create

1.Ext.onReady 说明:onReady内的语句块会在页面上下文加载后再执行. 2.Ext.define 说明:创建类,可以继承其他类,也可以被继承. 例子1: 1 <script ty ...

- 四次挥手中你还不知道的ACK机制

为面试做准备中. 后面有对ACK机制的详细讲解. 四次挥手比较好解释. 看一下我的草图. ACK表示发来的数据已确认接收无误. 图中一个箭头代表一次挥手. 第一次挥手: 主动关闭方:发送一个FIN,表 ...

- JSON数据显示在jsp页面上中文乱码的解决办法

在@RequestMapping属性添加属性produces = "text/html;charset=utf-8",设置字符集为utf-8即可 代码如下: @RequestMap ...