四十三 Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mapping映射管理

1、映射(mapping)介绍

映射:创建索引的时候,可以预先定义字段的类型以及相关属性

elasticsearch会根据json源数据的基础类型猜测你想要的字段映射,将输入的数据转换成可搜索的索引项,mapping就是我们自己定义的字段数据类型,同时告诉elasticsearch如何索引数据以及是否可以被搜索

作用:会让索引建立的更加细致和完善

类型:静态映射和动态映射

2、内置映射类型(也就是数据类型)

string类型:text,keyword两种

text类型:会进行分词,抽取词干,建立倒排索引

keyword类型:就是一个普通字符串,只能完全匹配才能搜索到

数字类型:long,integer,short,byte,double,float

日期类型:date

bool(布尔)类型:boolean

binary(二进制)类型:binary

复杂类型:object,nested

geo(地区)类型:geo-point,geo-shape

专业类型:ip,competion

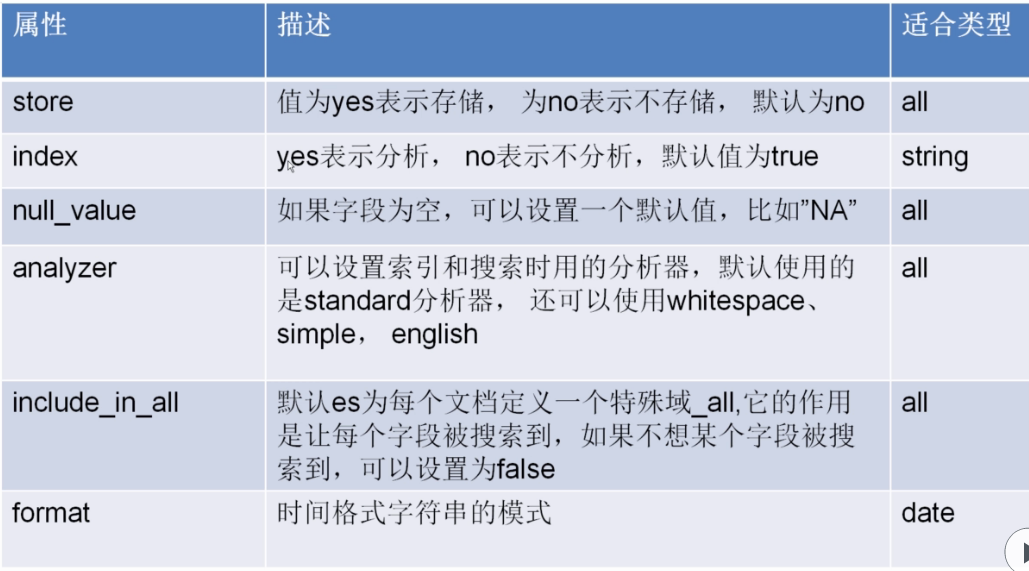

3、属性介绍

store属性

index属性

null_value属性

analyzer属性

include_in_all属性

format属性

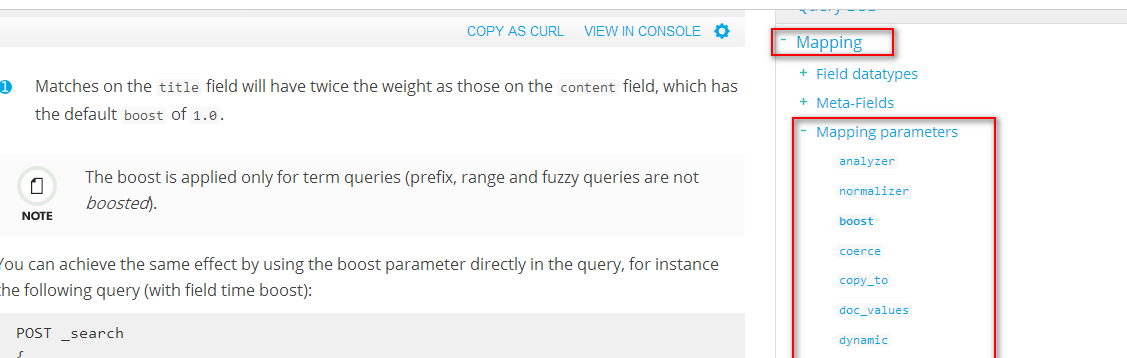

更多属性:https://www.elastic.co/guide/en/elasticsearch/reference/current/mapping-boost.html

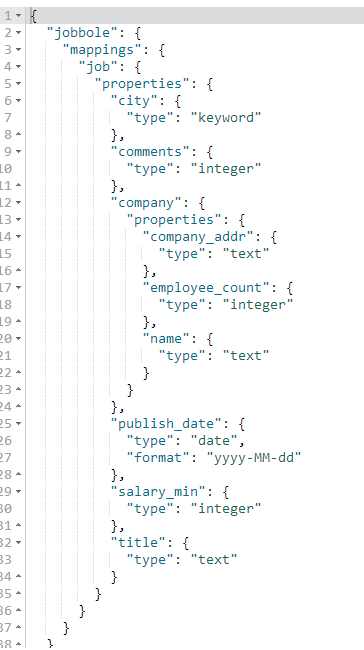

4、创建索引(相当于创建数据库)、创建表、创建字段-设置字段类型,添加数据

说明:

#创建索引(设置字段类型)

PUT jobbole #创建索引设置索引名称

{

"mappings": { #设置mappings映射字段类型

"job": { #表名称

"properties": { #设置字段类型

"title":{ #title字段

"type": "text" #text类型,text类型可以分词,建立倒排索引

},

"salary_min":{ #salary_min字段

"type": "integer" #integer数字类型

},

"city":{ #city字段

"type": "keyword" #keyword普通字符串类型

},

"company":{ #company字段,是嵌套字段

"properties":{ #设置嵌套字段类型

"name":{ #name字段

"type":"text" #text类型

},

"company_addr":{ #company_addr字段

"type":"text" #text类型

},

"employee_count":{ #employee_count字段

"type":"integer" #integer数字类型

}

}

},

"publish_date":{ #publish_date字段

"type": "date", #date时间类型

"format":"yyyy-MM-dd" #yyyy-MM-dd格式化时间样式

},

"comments":{ #comments字段

"type": "integer" #integer数字类型

}

}

}

}

} #保存文档(相当于数据库的写入数据)

PUT jobbole/job/1 #索引名称/表/id

{

"title":"python分布式爬虫开发", #字段名称:字段值

"salary_min":15000, #字段名称:字段值

"city":"北京", #字段名称:字段值

"company":{ #嵌套字段

"name":"百度", #字段名称:字段值

"company_addr":"北京市软件园", #字段名称:字段值

"employee_count":50 #字段名称:字段值

},

"publish_date":"2017-4-16", #字段名称:字段值

"comments":15 #字段名称:字段值

}

代码:

#创建索引(设置字段类型)

PUT jobbole

{

"mappings": {

"job": {

"properties": {

"title":{

"type": "text"

},

"salary_min":{

"type": "integer"

},

"city":{

"type": "keyword"

},

"company":{

"properties":{

"name":{

"type":"text"

},

"company_addr":{

"type":"text"

},

"employee_count":{

"type":"integer"

}

}

},

"publish_date":{

"type": "date",

"format":"yyyy-MM-dd"

},

"comments":{

"type": "integer"

}

}

}

}

} #保存文档(相当于数据库的写入数据)

PUT jobbole/job/1

{

"title":"python分布式爬虫开发",

"salary_min":15000,

"city":"北京",

"company":{

"name":"百度",

"company_addr":"北京市软件园",

"employee_count":50

},

"publish_date":"2017-4-16",

"comments":15

}

5、获取索引下的mappings映射字段类型

#获取一个索引下的所有表的mappings映射字段类型

GET jobbole/_mapping

#获取一个索引下的指定表的mappings映射字段类型

GET jobbole/_mapping/job

【重点】在创建索引时一旦给字段设置了类型后就不可修改了,如果必须要修改就的重新创建索引,所以在创建索引时就必须确定好字段类型

四十三 Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mapping映射管理的更多相关文章

- 第三百六十四节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mapping映射管理

第三百六十四节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mapping映射管理 1.映射(mapping)介绍 映射:创建索引的时候,可以预先定义字 ...

- 第三百六十七节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)scrapy写入数据到elasticsearch中

第三百六十七节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)scrapy写入数据到elasticsearch中 前面我们讲到的elasticsearch( ...

- 第三百七十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现我的搜索以及热门搜索

第三百七十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现我的搜索以及热门 我的搜素简单实现原理我们可以用js来实现,首先用js获取到 ...

- 第三百七十节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现搜索结果分页

第三百七十节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现搜索结果分页 逻辑处理函数 计算搜索耗时 在开始搜索前:start_time ...

- 第三百六十九节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现搜索功能

第三百六十九节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现搜索功能 Django实现搜索功能 1.在Django配置搜索结果页的路由映 ...

- 第三百六十六节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的bool组合查询

第三百六十六节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的bool组合查询 bool查询说明 filter:[],字段的过滤,不参与打分must:[] ...

- 第三百六十五节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的基本查询

第三百六十五节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的基本查询 1.elasticsearch(搜索引擎)的查询 elasticsearch是功能 ...

- 第三百六十三节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mget和bulk批量操作

第三百六十三节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mget和bulk批量操作 注意:前面讲到的各种操作都是一次http请求操作一条数据,如果想 ...

- 第三百六十二节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)基本的索引和文档CRUD操作、增、删、改、查

第三百六十二节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)基本的索引和文档CRUD操作.增.删.改.查 elasticsearch(搜索引擎)基本的索引 ...

- 第三百六十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)倒排索引

第三百六十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)倒排索引 倒排索引 倒排索引源于实际应用中需要根据属性的值来查找记录.这种索引表中的每一项都包 ...

随机推荐

- WTForms In Flask(WTForms在Flask中的应用)

WTForms WTForms是一个支持多个web框架的form组件,主要用于对用户请求数据进行验证. 安装wtforms : pip3/pip install wtforms 用户登录/注册示例 项 ...

- mysql以下c连接mysql数据库

1.安装sudo yum install mysql-devel 安装组件和库 2. #include <stdio.h> #include <stdlib.h> #incl ...

- 自己定义图片的progressbar

版权声明:本文为博主原创文章,未经博主同意不得转载. https://blog.csdn.net/zpf8861/article/details/36183455 Android系统自带的Progre ...

- MB11 生鲜项目原料消耗发货功能

*&---------------------------------------------------------------------* *& 程序名: ZDQFI_925 * ...

- easymake cmake xmake nmake ...

最简单的Makefile,但是还是大程序少不了makefile工具 #CC=arm-linux-gnueabihf-CC=target: $(CC)gcc -o algo_main algo_m ...

- LeetCode:二叉树的后序遍历【145】

LeetCode:二叉树的后序遍历[145] 题目描述 给定一个二叉树,返回它的 后序 遍历. 示例: 输入: [1,null,2,3] 1 \ 2 / 3 输出: [3,2,1] 进阶: 递归算法很 ...

- POJ 1733 Parity game (带权并查集)

题意:有序列A[1..N],其元素值为0或1.有M条信息,每条信息表示区间[L,R]中1的个数为偶数或奇数个,但是可能有错误的信息.求最多满足前多少条信息. 分析:区间统计的带权并查集,只是本题中路径 ...

- rabbitmq的发布确认和事务

摘要: 介绍confirm的工作机制.使用spring-amqp介绍事务以及发布确认的使用方式.因为事务以及发布确认是针对channel来讲,所以在一个连接中两个channel,一个channel可以 ...

- linux命令详解之(at)--6/24

在Linux下,有两个命令可以用来作为计划任务而执行,at:一次性定时任务计划执行crontab :每天定时任务计划执行 以下仅说一下一次性任务计划执行(at)要使用一次性任务计划,linux必须要有 ...

- sq 如何创建全局的临时表。

全局临时表的生命周期一直持续到创建会话(不是创建级别)才终止.例如,如果你在存储过程中创建全局临时表,当超出存储过程的范围时,该表并不会被销毁.当创建会话终止后,SQL Server才会自动尝试删除该 ...