Kafka详解二:如何配置Kafka集群

问题导读

1.Kafka有哪几种配制方法?

2.如何启动一个Consumer实例来消费消息?

Kafka集群配置比较简单,为了更好的让大家理解,在这里要分别介绍下面三种配置

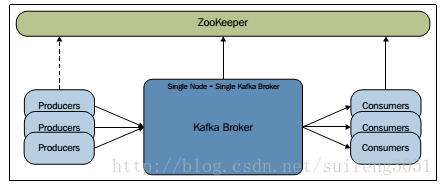

- 单节点:一个broker的集群

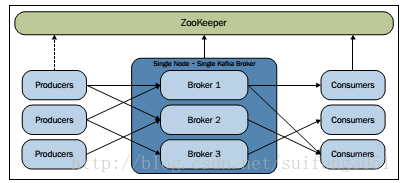

- 单节点:多个broker的集群

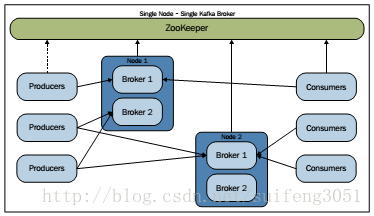

- 多节点:多broker集群

一、单节点单broker实例的配置

1. 首先启动zookeeper服务 Kafka本身提供了启动zookeeper的脚本(在kafka/bin/目录下)和zookeeper配置文件(在kafka/config/目录下),首先进入Kafka的主目录(可通过 whereis kafka命令查找到):

[root@localhost kafka-0.8]# bin/zookeeper-server-start.sh config/zookeeper.properties

zookeeper配置文件的一些重要属性:

# Data directory where the zookeeper snapshot is stored.

dataDir=/tmp/zookeeper

# The port listening for client request

clientPort=2181 默认情况下,zookeeper服务器会监听 2181端口,更详细的信息可去zookeeper官网查阅。

2. 启动Kafka broker 运行kafka提供的启动kafka服务脚本即可:

[root@localhost kafka-0.8]# bin/kafka-server-start.sh config/server.properties

broker配置文件中的重要属性:

# broker的id. 每个broker的id必须是唯一的.

Broker.id=0

# 存放log的目录

log.dir=/tmp/kafka8-logs

# Zookeeper 连接串

zookeeper.connect=localhost:2181

3. 创建一个仅有一个Partition的topic [root@localhost kafka-0.8]# bin/kafka-create-topic.sh --zookeeper localhost:2181 --replica 1 --partition 1 --topic kafkatopic

4. 用Kafka提供的生产者客户端启动一个生产者进程来发送消息 [root@localhost kafka-0.8]# bin/kafka-console-producer.sh --broker-list localhost:9092 --topic kafkatopic

其中有两个参数需要注意:

- broker-list:定义了生产者要推送消息的broker地址,以<IP地址:端口>形式

- topic:生产者发送给哪个topic

然后你就可以输入一些消息了,如下图:

5. 启动一个Consumer实例来消费消息 [root@localhost kafka-0.8]# bin/kafka-console-consumer.sh --zookeeper localhost:2181 --topic kafkatopic --from-beginning

当你执行这个命令之后,你便可以看到控制台上打印出的生产者生产的消息:

和消费者相关的属性配置存放在Consumer.properties文件中,重要的属性有:

# consumer的group id (A string that uniquely identifies a set of consumers

# within the same consumer group)

groupid=test-consumer-group

# zookeeper 连接串

zookeeper.connect=localhost:2181

二、单节点运行多broker实例

1.启动zookeeper 和上面的一样

2.启动Kafka的broker 要想在一台机器上启动多个broker实例,只需要准备多个server.properties文件即可,比如我们要在一台机器上启动两个broker:

首先我们要准备两个server.properties配置文件

- server-1

- brokerid=1

- port=9092

- log.dir=/temp/kafka8-logs/broker1

- server-2

- brokerid=2

- port=9093

- log.dir=/temp/kafka8-logs/broker2

然后我们再用这两个配置文件分别启动一个broker

[root@localhost kafka-0.8]# env JMX_PORT=9999 bin/kafka-server-start.sh config/server-1.properties

[root@localhost kafka-0.8]# env JMX_PORT=10000 bin/kafka-server-start.sh config/server-2.properties

可以看到我们启动是为每个broker都指定了不同的JMX Port,JMX Port主要用来利用jconsole等工具进行监控和排错

3.创建一个topic 现在我们要创建一个含有两个Partition分区和2个备份的broker:

[root@localhost kafka-0.8]# bin/kafka-create-topic.sh --zookeeper localhost:2181 --replica 2 --partition 2 --topic othertopic

4.启动Producer发送消息 如果我们要用一个Producer发送给多个broker,唯一需要改变的就是在broker-list属性中指定要连接的broker:

[root@localhost kafka-0.8]# bin/kafka-console-producer.sh --broker-list localhost:9092,localhost:9093 --topic othertopic

如果我们要让不同的Producer发送给不同的broker,我们也仅仅需要为每个Producer配置响应的broker-list属性即可。

5.启动一个消费者来消费消息 和之前的命令一样

[root@localhost kafka-0.8]# bin/kafka-console-consumer.sh --zookeeper localhost:2181 --topic othertopic --from-beginning

三、集群模式(多节点多实例) 介绍了上面两种配置方法,再理解集群配置就简单了,比如我们要配置如下图所示集群:

zookeeper配置文件(zookeeper.properties):不变

broker的配置配置文件(server.properties):按照单节点多实例配置方法在一个节点上启动两个实例,不同的地方是zookeeper的连接串需要把所有节点的zookeeper都连接起来

# Zookeeper 连接串

zookeeper.connect=node1:2181,node2:2181

转自:http://www.aboutyun.com/thread-11114-1-1.html

Kafka详解二:如何配置Kafka集群的更多相关文章

- HUE配置文件hue.ini 的hdfs_clusters模块详解(图文详解)(分HA集群和非HA集群)

不多说,直接上干货! 我的集群机器情况是 bigdatamaster(192.168.80.10).bigdataslave1(192.168.80.11)和bigdataslave2(192.168 ...

- HUE配置文件hue.ini 的hive和beeswax模块详解(图文详解)(分HA集群和非HA集群)

不多说,直接上干货! 我的集群机器情况是 bigdatamaster(192.168.80.10).bigdataslave1(192.168.80.11)和bigdataslave2(192.168 ...

- HUE配置文件hue.ini 的yarn_clusters模块详解(图文详解)(分HA集群和非HA集群)

不多说,直接上干货! 我的集群机器情况是 bigdatamaster(192.168.80.10).bigdataslave1(192.168.80.11)和bigdataslave2(192.168 ...

- HUE配置文件hue.ini 的hbase模块详解(图文详解)(分HA集群和非HA集群)

不多说,直接上干货! 我的集群机器情况是 bigdatamaster(192.168.80.10).bigdataslave1(192.168.80.11)和bigdataslave2(192.168 ...

- HUE配置文件hue.ini 的zookeeper模块详解(图文详解)(分HA集群)

不多说,直接上干货! 我的集群机器情况是 bigdatamaster(192.168.80.10).bigdataslave1(192.168.80.11)和bigdataslave2(192.168 ...

- HUE配置文件hue.ini 的Spark模块详解(图文详解)(分HA集群和HA集群)

不多说,直接上干货! 我的集群机器情况是 bigdatamaster(192.168.80.10).bigdataslave1(192.168.80.11)和bigdataslave2(192.168 ...

- HUE配置文件hue.ini 的impala模块详解(图文详解)(分HA集群)

不多说,直接上干货! 我的集群机器情况是 bigdatamaster(192.168.80.10).bigdataslave1(192.168.80.11)和bigdataslave2(192.168 ...

- HUE配置文件hue.ini 的liboozie和oozie模块详解(图文详解)(分HA集群)

不多说,直接上干货! 我的集群机器情况是 bigdatamaster(192.168.80.10).bigdataslave1(192.168.80.11)和bigdataslave2(192.168 ...

- HUE配置文件hue.ini 的sqoop模块详解(图文详解)(分HA集群和非HA集群)

不多说,直接上干货! 我的集群机器情况是 bigdatamaster(192.168.80.10).bigdataslave1(192.168.80.11)和bigdataslave2(192.168 ...

随机推荐

- redis string底层数据结构sds

redis的string没有采用c语言的字符串数组而采用自定义的数据结构SDS(simple dynamic string)设计 len 为字符串的实际长度 在redis中获取字符串的key长度的时 ...

- FZU2030(括号匹配)

题目链接:http://acm.hust.edu.cn/vjudge/contest/view.action?cid=110977#problem/E 题目大意:略 题目思路:数据范围很小,可以搜索, ...

- JS 插件 fastclick.js 解决手机端click点击延迟

FastClick 是一个简单,易于使用的JS库用于消除在移动浏览器上触发click事件与一个物理Tap(敲击)之间的300延迟. 对于非移动浏览器不启作用,禁用缩放标签. <meta name ...

- 疯狂创客圈 JAVA死磕系列 总目录

无编程不创客,无案例不学习.疯狂创客圈,一大波高手正在交流.学习中! 疯狂创客圈 Java 死磕系列: [博客园 总入口] QQ群:104131248 [Java 聊天室] 实战从0开始,打造100 ...

- 基于Django的Disqus如何支持每月80亿PV(转)

原文:基于Django的Disqus如何支持每月80亿PV 本文由 伯乐在线 - 贱圣OMG 翻译.未经许可,禁止转载!英文出处:Matt Robenolt.欢迎加入翻译小组. 现在我们Disqus能 ...

- linux下查看cpu,内存,硬盘等硬件信息的方法

说明:Linux下可以在/proc/cpuinfo中看到每个cpu的详细信息.但是对于双核的cpu,在cpuinfo中会看到两个cpu.常常会让人误以为是两个单核的cpu. 一.linux CPU大小 ...

- Servlet 运行原理

一:servlet定义 Servlet是一个Java应用程序,运行在服务器端,用来处理客户端请求并作出响应的程序. 二:简单servlet实例 //导入所需的包 import javax.servle ...

- Linux中的grep和cut

提取行: grep --color 着色 -v 不包含 提取列: cut -f 列号 提取第几列 -d 分隔符 以什么为分隔符,默认是制表键 局限性:如果分隔符不那 ...

- opencv3计算机视觉+Python(一)

基本I/O脚本 读/写图像文件 OpenCV的imread函数和imwrite函数能支持各种静态图像文件格式.不同系统支持的文件格式不一样,但都支持BMP格式,通常还应该支持PNG.JPEG和TIFF ...

- 解决PowerDesigner 反向工程没有注释(备注)

1. 列注释 原来代码: {OWNER, TABLE, S, COLUMN, DTTPCODE, LENGTH, SIZE, PREC, COMPUTE, NOTNULL, IDENTITY, DOM ...