用python来抓取“煎蛋网”上面的美女图片,尺度很大哦!哈哈

所用Python环境为:python 3.3.2 用到的库为:urllib.request re

废话不多说,先上代码:

import urllib.request

import re #获得当前页面的页数page_name

def get_pagenum(url):

req = urllib.request.Request(url)

req.add_header('User-Agent','Mozilla/5.0 (Windows NT 6.3; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/50.0.2661.102 Safari/537.36')

res = urllib.request.urlopen(req)

html = res.read().decode('utf-8')

p = r'<span class="current-comment-page">[^"]+</span>'

temp = re.search(p,html)

page_num = temp.group()[36:39]

return page_num #将此页面上的图片写入我们的mm文件夹中

def get_img(page_url):

req = urllib.request.Request(page_url)

req.add_header('User-Agent','Mozilla/5.0 (Windows NT 6.3; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/50.0.2661.102 Safari/537.36')

res = urllib.request.urlopen(req)

html = res.read().decode('utf-8')

p = r'<img src="([^"]+\.jpg)"'

url_list = re.findall(p,html)

num = 0

for each in url_list:

file = open('C:/Users/lenovo/Desktop/mm/'+each[-8:]+'.jpg','wb')

if each[0:5] == 'http:':

res = urllib.request.urlopen(each)

else:

res = urllib.request.urlopen('http:'+each)

file.write(res.read())

file.close() #只能直接运行

if __name__ == '__main__':

url = 'http://jandan.net/ooxx/'

page_num = get_pagenum(url)

for i in range(10): #抓取了十个页面上美女图片

page_url = url + 'page-'+str(page_num)+'#comments'

get_img(page_url)

page_num = int(page_num) - 1 #下面是写正则的时候方便看所以粘贴过来的连接

#<img src="//ws3.sinaimg.cn/mw600/006wUWIjgy1fgxrw8goikj30hs0qodh7.jpg" style="max-width: 480px; max-height: 750px;"> #http://jandan.net/ooxx/page-143#comments #<span class="current-comment-page">[141]</span> # http://wx3.sinaimg.cn/mw600/661eb95cly1fgioxk7mk3j20xc1e01f1.jpg #<img src="//wx1.sinaimg.cn/mw600/006wUWIjgy1fgxg2yj5f3j30g70s6dgw.jpg" style="max-width: 480px; max-height: 750px;">

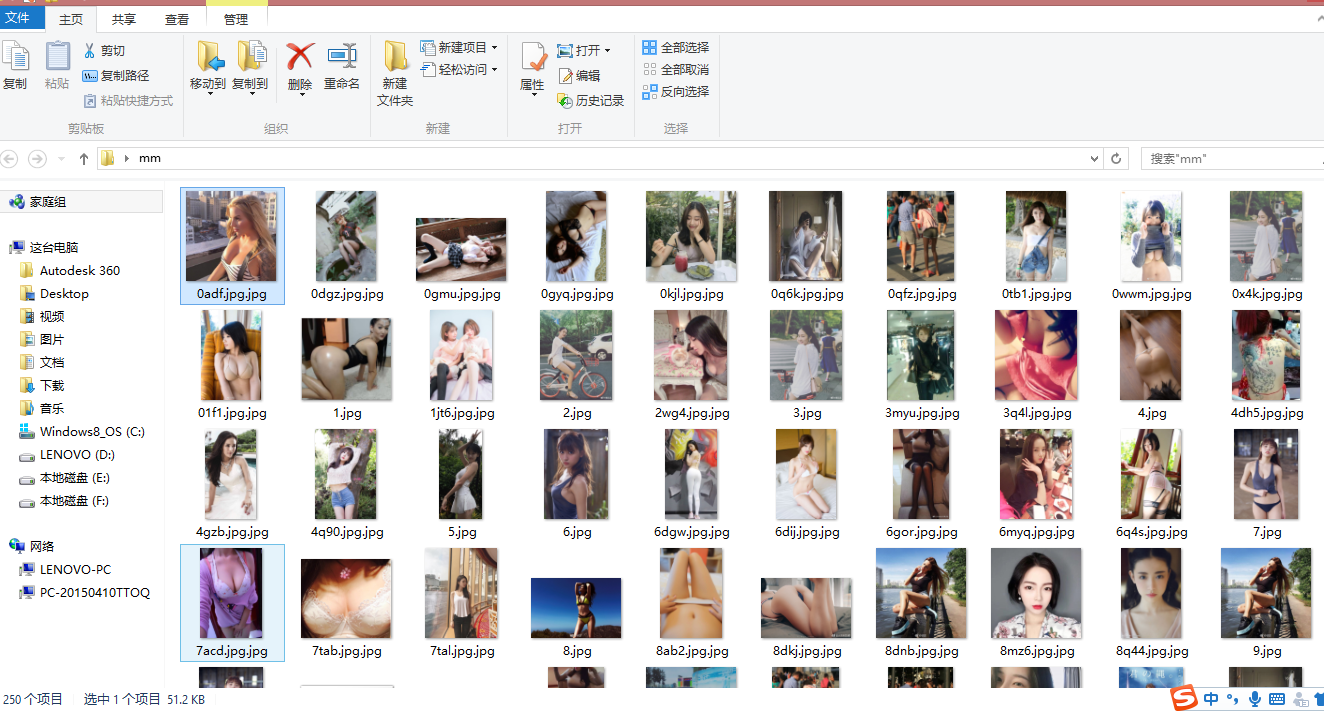

结果如下:

由于时间原因,我只抓取了“煎蛋网”上的十个页面的美女图片罢了,大家可以更改其中的循环次数,可以抓取很多,这里我只抓取了250个图片,一共51.2kb,哈哈,可以很好的欣赏美女图片了,看的都要流鼻血了。。。

当然,此程序还是不够完善,只是我初学python网络爬虫的小作品罢了,以后再些更加完善的。接下来的一段时间真的得好好准备期末考试和考研了,加油!

参考来源: https://zhuanlan.zhihu.com/p/26442105

Note:没有经过我的同意,请勿随便转载!谢谢。

用python来抓取“煎蛋网”上面的美女图片,尺度很大哦!哈哈的更多相关文章

- Python Scrapy 爬取煎蛋网妹子图实例(一)

前面介绍了爬虫框架的一个实例,那个比较简单,这里在介绍一个实例 爬取 煎蛋网 妹子图,遗憾的是 上周煎蛋网还有妹子图了,但是这周妹子图变成了 随手拍, 不过没关系,我们爬图的目的是为了加强实战应用,管 ...

- Python 爬虫 爬取 煎蛋网 图片

今天, 试着爬取了煎蛋网的图片. 用到的包: urllib.request os 分别使用几个函数,来控制下载的图片的页数,获取图片的网页,获取网页页数以及保存图片到本地.过程简单清晰明了 直接上源代 ...

- python爬虫–爬取煎蛋网妹子图片

前几天刚学了python网络编程,书里没什么实践项目,只好到网上找点东西做. 一直对爬虫很好奇,所以不妨从爬虫先入手吧. Python版本:3.6 这是我看的教程:Python - Jack -Cui ...

- Python Scrapy 爬取煎蛋网妹子图实例(二)

上篇已经介绍了 图片的爬取,后来觉得不太好,每次爬取的图片 都在一个文件下,不方便区分,且数据库中没有爬取的时间标识,不方便后续查看 数据时何时爬取的,所以这里进行了局部修改 修改一:修改爬虫执行方式 ...

- python爬虫爬取煎蛋网妹子图片

import urllib.request import os def url_open(url): req = urllib.request.Request(url) req.add_header( ...

- [Java]使用HttpClient实现一个简单爬虫,抓取煎蛋妹子图

第一篇文章,就从一个简单爬虫开始吧. 这只虫子的功能很简单,抓取到”煎蛋网xxoo”网页(http://jandan.net/ooxx/page-1537),解析出其中的妹子图,保存至本地. 先放结果 ...

- Golang分布式爬虫:抓取煎蛋文章|Redis/Mysql|56,961 篇文章

--- layout: post title: "Golang分布式爬虫:抓取煎蛋文章" date: 2017-04-15 author: hunterhug categories ...

- selenium爬取煎蛋网

selenium爬取煎蛋网 直接上代码 from selenium import webdriver from selenium.webdriver.support.ui import WebDriv ...

- python爬虫学习(1)__抓取煎蛋图片

#coding=utf-8 #python_demo 爬取煎蛋妹子图在本地文件夹 import requests import threading import time import os from ...

随机推荐

- getContextPath、getServletPath、getRequestURI、getRealPath、getRequestURL、getPathInfo();的区别

<% out.println("getContextPath: "+request.getContextPath()+"<br/>"); ou ...

- MySQL Select语句的执行顺序

源文章:How is a query executed in MySQL? 当执行SQL的Select查询语句时,SQL指令的执行顺序如下: FROM 子句 WHERE 子句 GROUP BY 子句 ...

- zepto学习(三)之详解

zepto Zepto就是jQuery的移动端版本, 可以看做是一个轻量级的jQuery github地址: https://github.com/madrobby/zepto 官方地址: http: ...

- sip呼叫里SDP的一些字段的含义

v=0 o=- 1 0 IN IP4 164.135.25.51 #local ip ,即本机SIP信令交互地址 s=SNS call #用于传递会话主题 c=IN IP4 164.135.25.51 ...

- WinPE基础知识之重定位表

typedef struct _IMAGE_BASE_RELOCATION { DWORD VirtualAddress; // (重要)需要重定位的位置,这是一个RVA DWORD SizeOfBl ...

- Mysql(三):表操作

一 存储引擎介绍 存储引擎即表类型,mysql根据不同的表类型会有不同的处理机制 详见:http://www.cnblogs.com/6324TV/p/8481061.html 二 表介绍 表相当于文 ...

- github仓库管理项目

一,建立本地git仓库 首先,git要求使用者必须提供自己的身份标识,为此我们需要在git bash中执行以下命令: git config --global user.name 'aa.Tessst ...

- python 中 open与with open 的区别

读写文件是最常见的IO操作.Python内置了读写文件的函数,用法和C是兼容的. 读写文件前,我们先必须了解一下,在磁盘上读写文件的功能都是由操作系统提供的,现代操作系统不允许普通的程序直接操作磁盘, ...

- 第一节:python读取excel文件

写在前面: (1)Excel中数字格式int(1),读出的是float(1.0)类型,导致传参时造成不同,强制转换时,int(str(1.0))在2.7版本又会报错ValueError: invali ...

- 登录网站的autohotkey脚本

;如果需要这个软件的代码逻辑,删除敏感信息只需要把上面3行代码删除即可. !:: ;login经过测试必须用ie浏览器,在默认软件里面浏览器设置成ie即可,其他浏览器不让send密码 ;虽然通过程序把 ...