大数据中Hadoop集群搭建与配置

前提环境是之前搭建的4台Linux虚拟机,详情参见 Linux集群搭建

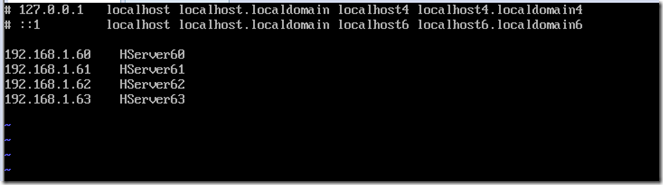

该环境对应4台服务器,192.168.1.60、61、62、63,其中60为主机,其余为从机

软件版本选择:

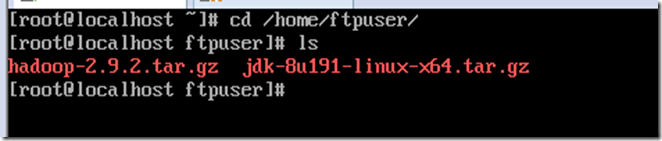

Java:JDK1.8.0_191(jdk-8u191-linux-x64.tar.gz)

Hadoop:Hadoop-2.9.2(hadoop-2.9.2.tar.gz)

上传hadoop与java到服务器并查看

cd /home/ftpuser/

ls

安装Java

解压Java

mkdir /usr/java

tar -zxvf jdk-8u191-linux-x64.tar.gz -C /usr/java/

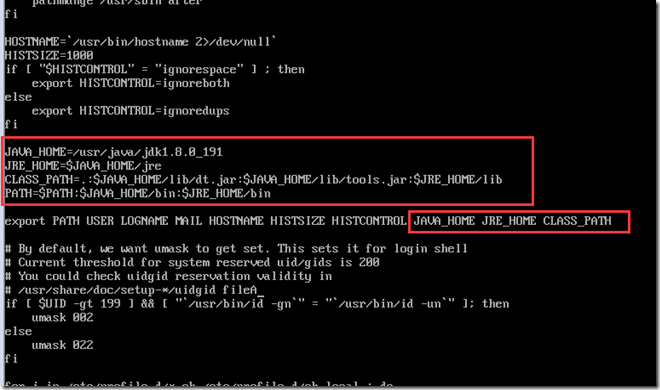

配置Java环境变量

vi /etc/profile

添加Java配置

启用配置

source /etc/profile

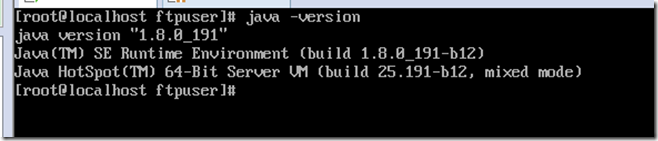

查看是否配置成功

java -version

配置Hadoop主体环境

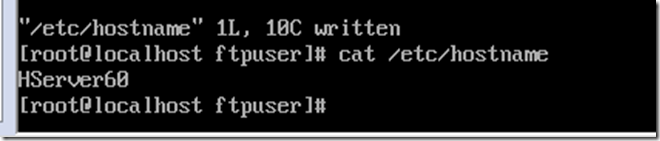

修改hostname,方便认识,这里设置为对应IP的4台服务器HServer60,HServer61,HServer62,HServer63,配置后重启(reboot)生效

vi /etc/hostname

配置hosts文件,对应IP于主机名

vi /etc/hosts

解压hadoop

mkdir /cloud

cd /home/ftpuser/

tar -zxvf hadoop-2.9.2.tar.gz -C /cloud/

一共有5个文件需要配置

hadoop-env.sh

core-site.xml

hdfs-site.xml

yarn-site.xml

yarn-env.sh

mapred-site.xml

slaves

cd /cloud/hadoop-2.9.2/etc/hadoop/

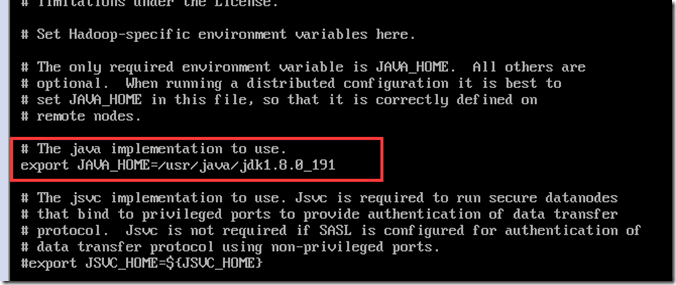

配置hadoop-env.sh

vi hadoop-env.sh

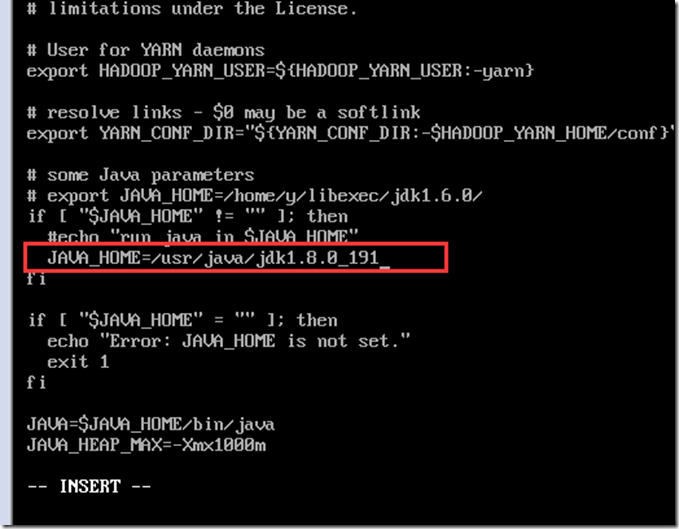

配置yarn-env.sh

vi yarn-env.sh

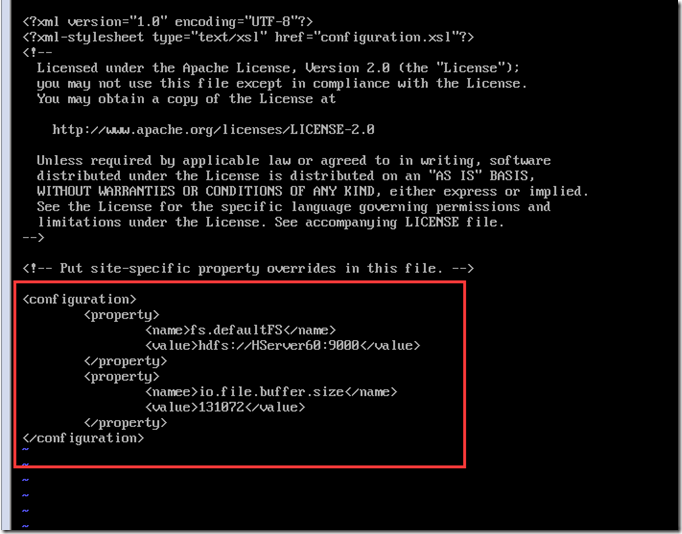

配置core-site.xml

vi core-site.xml

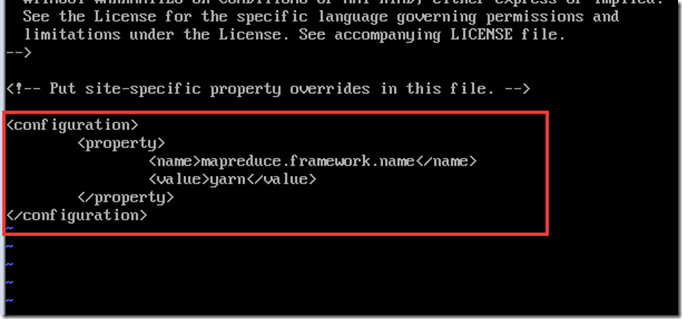

配置mapred-site.xml,先从模板复制一份配置出来,并修改

cp mapred-site.xml.template mapred-site.xml

vi mapred-site.xml

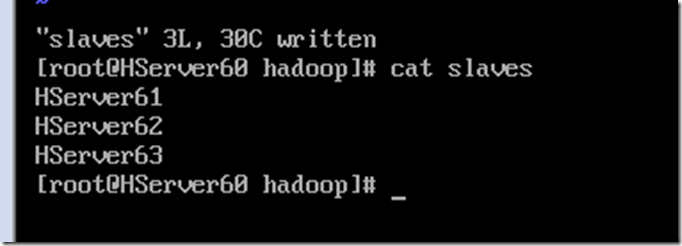

配置slaves,写入从机名称

vi slaves

剩下的2个文件hdfs-site.xml与yarn-site.xml需要区分主机NameNode与从机DataNode的配置

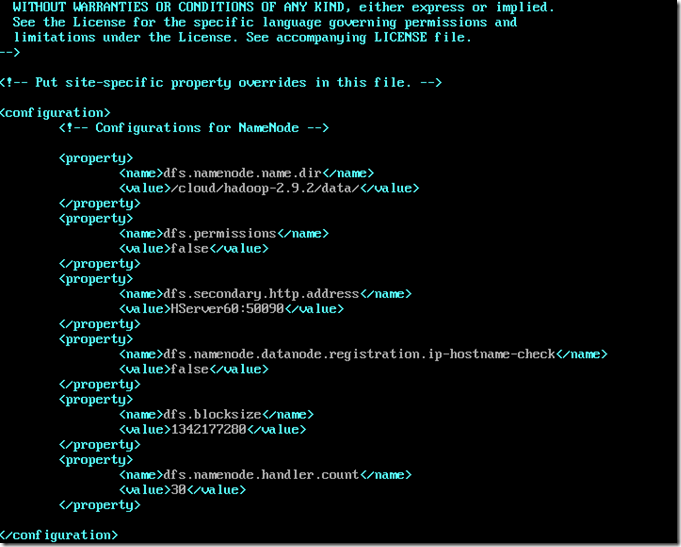

主机NameNode的hdfs-site.xml配置

vi hdfs-site.xml

其中blocksize可以根据情况自行调整,是数据块的大小,handler.cout一般几台小集群10都足够了

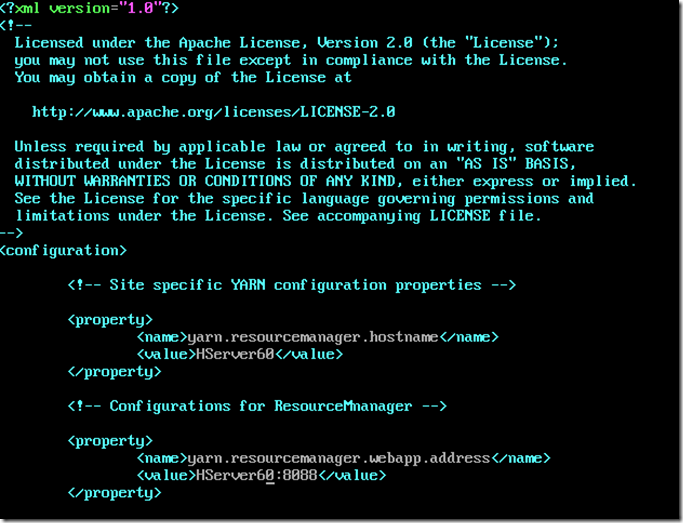

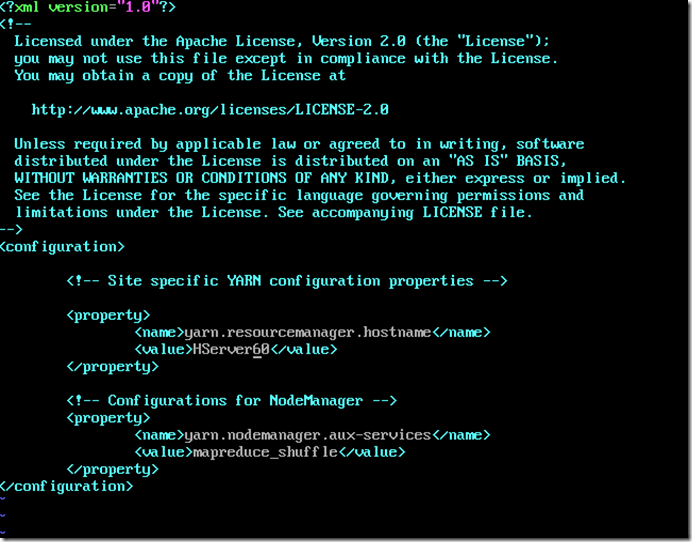

主机NameNode的yarn-site.xml配置

vi yarn-site.xml

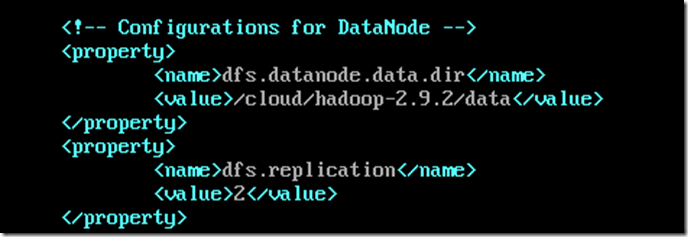

从机DataNode的hdfs-site.xml配置

vi hdfs-site.xml

其中replication为备份数

从机DataNode的yarn-site.xml配置

vi yarn-site.xml

设置NameNode免密登录,在主机上操作

ssh-copy-id -i ~/.ssh/id_rsa.pub root@192.168.1.61

ssh-copy-id -i ~/.ssh/id_rsa.pub root@192.168.1.62

ssh-copy-id -i ~/.ssh/id_rsa.pub root@192.168.1.63

可以将配置好的东西通过scp命令复制到远程服务器上

scp -rp /cloud/hadoop-2.9.2 root@192.168.1.62:/cloud/

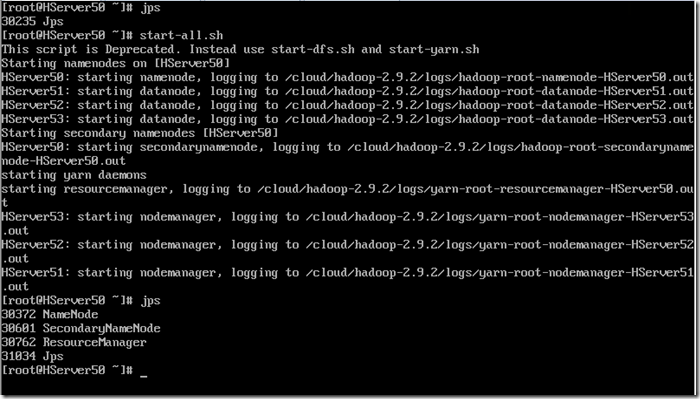

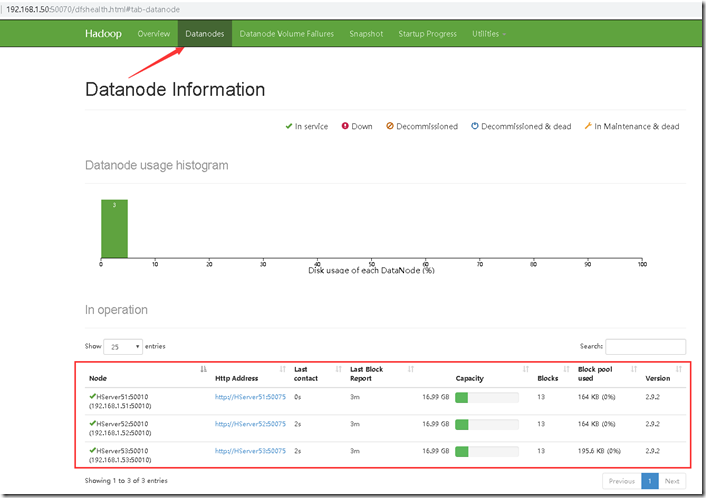

整个Hadoop集群配置完毕,可以启动试试看,这里换到我已经搭建好的4台服务器,50、51、52、53

启动命令在hadoop目录的sbin文件夹中,也可以在/etc/profile文件中配置环境变量,类似java配置,将该目录加入path路径

启动hadoop集群,通过jps查看是否启动了

start-all.sh

主机jps上会有NameNode,ResourceManager,SecondaryNameNode

从机jps上会有NodeManager,DataNode

这样就成功的启动了,访问主机IP:50070的URL访问

大数据中Hadoop集群搭建与配置的更多相关文章

- 大数据中HBase集群搭建与配置

hbase是分布式列式存储数据库,前提条件是需要搭建hadoop集群,需要Zookeeper集群提供znode锁机制,hadoop集群已经搭建,参考 Hadoop集群搭建 ,该文主要介绍Zookeep ...

- 大数据中Linux集群搭建与配置

因测试需要,一共安装4台linux系统,在windows上用vm搭建. 对应4个IP为192.168.1.60.61.62.63,这里记录其中一台的搭建过程,其余的可以直接复制虚拟机,并修改相关配置即 ...

- 大数据学习——HADOOP集群搭建

4.1 HADOOP集群搭建 4.1.1集群简介 HADOOP集群具体来说包含两个集群:HDFS集群和YARN集群,两者逻辑上分离,但物理上常在一起 HDFS集群: 负责海量数据的存储,集群中的角色主 ...

- 大数据平台Hadoop集群搭建

一.概念 Hadoop是由java语言编写的,在分布式服务器集群上存储海量数据并运行分布式分析应用的开源框架,其核心部件是HDFS与MapReduce.HDFS是一个分布式文件系统,类似mogilef ...

- 大数据学习——hadoop集群搭建2.X

1.准备Linux环境 1.0先将虚拟机的网络模式选为NAT 1.1修改主机名 vi /etc/sysconfig/network NETWORKING=yes HOSTNAME=itcast ### ...

- 大数据测试之hadoop集群配置和测试

大数据测试之hadoop集群配置和测试 一.准备(所有节点都需要做):系统:Ubuntu12.04java版本:JDK1.7SSH(ubuntu自带)三台在同一ip段的机器,设置为静态IP机器分配 ...

- Java+大数据开发——Hadoop集群环境搭建(一)

1集群简介 HADOOP集群具体来说包含两个集群:HDFS集群和YARN集群,两者逻辑上分离,但物理上常在一起 HDFS集群: 负责海量数据的存储,集群中的角色主要有 NameNode / DataN ...

- Java+大数据开发——Hadoop集群环境搭建(二)

1. MAPREDUCE使用 mapreduce是hadoop中的分布式运算编程框架,只要按照其编程规范,只需要编写少量的业务逻辑代码即可实现一个强大的海量数据并发处理程序 2. Demo开发--wo ...

- 大数据-HBase HA集群搭建

1.下载对应版本的Hbase,在我们搭建的集群环境中选用的是hbase-1.4.6 将下载完成的hbase压缩包放到对应的目录下,此处我们的目录为/opt/workspace/ 2.对已经有的压缩包进 ...

随机推荐

- Eclipse Debug Daemon Thread

Daemon Thread ["http-bio-8080"-exec-2] (Suspended (exception RuntimeException)) ThreadPool ...

- java StringBuilder案例

实现输出字符串的长度,容量(容量不够则扩容),及内容 import java.util.Arrays; public class MyStringBuilderDemo { //任务:存储字符串并输出 ...

- 谷歌希望让 Swift 成为安卓的优先选择,以取代由 Oracle 开发的 Java 程序语言。

http://news.coolban.com/Web/Index/land/app/2/id/405239

- 将项目发布到Maven中央仓库的不完整纪要

背景 有几个Utils性质的Jar需要跨项目引用,原本想部署私有Maven仓库,后来感觉太麻烦,索性直接发布到中央库,引用时也方便. 发布成功之后,觉得某些细节还是有必要记录一下. 资源 Sonaty ...

- CF993E:Nikita and Order Statistics(FFT)

Description 给你一个数组 $a_{1 \sim n}$,对于 $k = 0 \sim n$,求出有多少个数组上的区间满足:区间内恰好有 $k$ 个数比 $x$ 小.$x$ 为一个给定的数. ...

- 20155314 2016-2017-2 《Java程序设计》实验三 敏捷开发与XP实践

20155314 2016-2017-2 <Java程序设计>实验三 敏捷开发与XP实践 实验内容 XP基础 XP核心实践 相关工具 实验知识点总结 (一)敏捷开发与XP 软件工程:把系统 ...

- P1120 小木棍 [数据加强版]

题目描述 乔治有一些同样长的小木棍,他把这些木棍随意砍成几段,直到每段的长都不超过50. 现在,他想把小木棍拼接成原来的样子,但是却忘记了自己开始时有多少根木棍和它们的长度. 给出每段小木棍的长度,编 ...

- 【git2】git+码云+webStrom

在[git1]中介绍了Git的安装.webstrom配置Git和GitHub.GitHub项目上传下载的方法. 这篇将一下在[git1]步骤(一)基础上webstorm配置码云 实现项目的上传下载. ...

- JavaScript跨源资源共享

CORS(跨 源资源共享)基本思想,就是使用自定义的HTTP头部让浏览器与服务器进行沟通,从而决定请求或响应式应该成功还是失败 IE对CORS的实现 IE8引入了XDR类型,与XHR类似,但可以实现安 ...

- 多进程共享内存的MemoryStream

文章转载于http://www.raysoftware.cn/?p=506 具体用处呢,有很多,比如多进程浏览器共享Cookie啦,多个进程传送点数据啦. 共享内存封装. 封装成了MemoryStre ...