Scrapy-多层爬取天堂图片网

1.根据图片分类对爬取的图片进行分类

开发者选项 --> 找到分类地址

爬取每个分类的地址通过回调函数传入下一层

name = 'sky'

start_urls = ['http://ivsky.com/']

def parse(self, response):

selector = Selector(response)

# print(response.text)

types = selector.xpath("//div[@class='kw']/a")

for type in types:

typeUrl = type.xpath("@href").extract()[0] #分类地址

typeName = type.xpath("text()").extract()[0] #分类名称

# print(typeUrl+" "+typeName)

yield Request(self.start_urls[0]+typeUrl,callback=self.parseTotalPage,meta={'typeName':typeName})

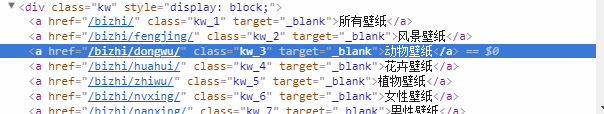

2.点击进入一个类型 --> 开发者选项 --> 找到分页代码段

爬取每一个分页的地址也是通过回调函数传入下一层进行处理

def parseTotalPage(self,response):

typeName = response.meta["typeName"]

# print(typeName)

selector = Selector(response)

# print(response.text)

pageList = selector.xpath("//div[@class='pagelist']//a//@href").extract() #每一页的地址

for page in pageList:

yield Request(self.start_urls[0]+page,callback=self.parseGetImg,meta={'typeName':typeName})

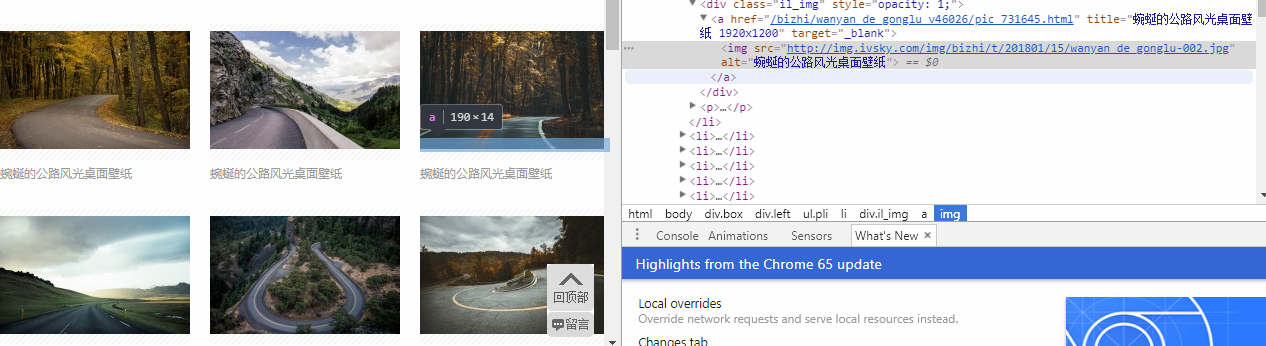

3.获取一类图地址 --> 开发者选项 --> 找到相同类图的地址

爬取这类图的地址通过回调函数传入下一层进行处理

def parseGetImg(self,response):

typeName = response.meta["typeName"]

selector = Selector(response)

imgs = selector.xpath("//div[@class='il_img']//a")

for img in imgs:

imgUrl = img.xpath("@href").extract()[0] #一类图的地址

# print(imgUrl+" "+imgName)

yield Request(self.start_urls[0]+imgUrl,callback=self.parseGetMoreImg)

4.查看每张图片的html代码 --> 找到图片的地址

爬取每张图的地址

def parseGetMoreImg(self,response):

# / html / body / div[3] / div[4] / ul / li[3] / div / a / img

selector = Selector(response)

# print(response.text)

items = IvskyItem()

items["imgName"] = response.meta["imgName"]

items["imgUrl"] = selector.xpath("//div[@class='il_img']//a//img//@src").extract()

# print(items)

yield items

最后将图片传入pipelines.py 进行下载处理,要先在setting.py 设置,否则无法进入pipelines.py

ITEM_PIPELINES = {

'ivsky.pipelines.IvskyPipeline': 300,

}

代码地址:https://github.com/WitW/ivsky

Scrapy-多层爬取天堂图片网的更多相关文章

- Python的scrapy之爬取顶点小说网的所有小说

闲来无事用Python的scrapy框架练练手,爬取顶点小说网的所有小说的详细信息. 看一下网页的构造: tr标签里面的 td 使我们所要爬取的信息 下面是我们要爬取的二级页面 小说的简介信息: 下面 ...

- 使用scrapy爬虫,爬取17k小说网的案例-方法一

无意间看到17小说网里面有一些小说小故事,于是决定用爬虫爬取下来自己看着玩,下图这个页面就是要爬取的来源. a 这个页面一共有125个标题,每个标题里面对应一个内容,如下图所示 下面直接看最核心spi ...

- scrapy实例:爬取中国天气网

1.创建项目 在你存放项目的目录下,按shift+鼠标右键打开命令行,输入命令创建项目: PS F:\ScrapyProject> scrapy startproject weather # w ...

- scrapy框架爬取妹子图片

首先,建立一个项目#可在github账户下载完整代码:https://github.com/connordb/scrapy-jiandan2 scrapy startproject jiandan2 ...

- Python的scrapy之爬取链家网房价信息并保存到本地

因为有在北京租房的打算,于是上网浏览了一下链家网站的房价,想将他们爬取下来,并保存到本地. 先看链家网的源码..房价信息 都保存在 ul 下的li 里面 爬虫结构: 其中封装了一个数据库处理模 ...

- Python的scrapy之爬取妹子图片

闲来无事,做的一个小爬虫项目 爬虫主程序: import scrapy from ..items import MeiziItem class MztSpider(scrapy.Spider): na ...

- 使用scrapy爬虫,爬取起点小说网的案例

爬取的页面为https://book.qidian.com/info/1010734492#Catalog 爬取的小说为凡人修仙之仙界篇,这边小说很不错. 正文的章节如下图所示 其中下面的章节为加密部 ...

- 使用scrapy爬虫,爬取17k小说网的案例-方法二

楼主准备爬取此页面的小说,此页面一共有125章 我们点击进去第一章和第一百二十五章发现了一个规律 我们看到此链接的 http://www.17k.com/chapter/271047/6336386 ...

- Python爬虫【实战篇】scrapy 框架爬取某招聘网存入mongodb

创建项目 scrapy startproject zhaoping 创建爬虫 cd zhaoping scrapy genspider hr zhaopingwang.com 目录结构 items.p ...

随机推荐

- shopnc前台登陆不进去解决方法

安装好shopnc后,注册新用户成功,且登陆后提示登陆成功,但是一两秒后自动跳转回登陆页面,需要重新登陆问题 PHP写session不是自动起的,需要修改后才行,所以 找到PHP的php.ini配置文 ...

- httpd: Could not reliably determine the server's fully qualified domain name, using ::1 for ServerName

问题原因: httpd服务配置文件,并没有设置解析根地址,无法可靠地确定服务器的完全合格的域名 如何解决? httpd的配置文件放在 /etc/httpd/conf/目录下,去掉ServerName注 ...

- Python---多线程(threading)

1. 概述 threading提供线程相关操作,python当前版本的多线程库没有实现优先级.线程组,线程也不能被停止.暂停.恢复和中断 threading提供的类: Thread,Lock,Rloc ...

- 关键字final整理

关键字final整理 由于语境(应用环境)不同,final 关键字的含义可能会稍微产生一些差异.但它最一般的意思就是声明"这个东西不能改变".之所以要禁止改变,可能是考虑到两方面的 ...

- VisionPro笔记(1):动态创建控件

VisionPro学习笔记(1):动态创建控件 有的时候可能需要在程序中动态创建控件,VisionPro实例中提供了一例动态创建Blob控件的方法.当然,动态创建过多的控件会极大的消耗系统的资源,建 ...

- Linux时间转标准时间

[root@nhserver2 ~]# date -d '1970-1-1 0:0:0 GMT + 1394592071 seconds'Wed Mar 12 10:41:11 CST 2014

- LNMP之Nginx

Nginx初探 概念: Nginx是一款免费.开源.高性能的HTTP服务器和反向代理,同时也可作为邮件代理服务器.其因为高性能.稳定.丰富的功能集.配置简单和低系统资源消耗而闻名. Tengine是由 ...

- SDK,API概念

什么是SDK什么是API? SDK 就是 Software Development Kit 的缩写,就是"软件开发工具包". 这是一个覆盖面相当广泛的名词,可以这么说:辅助开发某一 ...

- yum安装centos系统依赖库

安装centos系统依赖库,安装软件过程中,经常需要的一些库,可以在编译安装软件前执行如下命令: 首先更新系统(这步可以不执行) yum -y update 这种更新是全部更新,但是有时一些软件不想更 ...

- MySQL索引之B+树

MySQL索引大都存储在B+树中,除此还有R树和hash索引.B+树的基础还是B树. B树由2部分组成,节点和索引.下面将构建一个B树,每个节点存2个数据,每个节点有前,中,后三个索引.插入数字的顺序 ...