利用python爬取全国水雨情信息

分析

我们没有找到接口,所以打算利用selenium来爬取。

代码

import datetime

import pandas as pd

from bs4 import BeautifulSoup

from selenium import webdriver

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.common.by import By

from selenium.webdriver.support import expected_conditions as EC

from selenium.webdriver.chrome.options import Options #建议使用谷歌浏览器

import time

chrome_options = Options()

chrome_options.add_argument('--headless')

driver = webdriver.Chrome()

# 存储中英文对应的变量的中文名

word_dict = {"poiBsnm": "流域",

"poiAddv": "行政区",

"rvnm": "河名",

"stnm": "站名",

"tm": "时间",

"zl": "水位(米)",

"ql": "流量(立方米/秒)",

"wrz": "警戒水位(米)"}

# 空df接收结果

rain_total = pd.DataFrame([])

url = 'http://xxfb.mwr.cn/sq_dxsk.html'

driver.get(url)

time.sleep(5)

infos = driver.find_elements_by_xpath("/html/body//tbody[@id='DataContainer']/tr")

# pd.set_option('display.max_columns', None)#所有列

# pd.set_option('display.max_rows', None)#所有行

# 列表提取

for info in infos:

poiBsnm = info.find_element_by_xpath("./td[1]").text

poiAddv = info.find_element_by_xpath("./td[2]").text

rvnm = info.find_element_by_xpath("./td[3]").text

stnm = info.find_element_by_xpath("./td[4]").text

tm = info.find_element_by_xpath("./td[5]").text

zl = info.find_element_by_xpath("./td[6]").text

ql = info.find_element_by_xpath("./td[7]").text

wrz = info.find_element_by_xpath("./td[8]").text

# 组成pandas对象

rain_data = [[poiBsnm,poiAddv,rvnm,stnm,tm,zl,ql,wrz]]

rain_df = pd.DataFrame(data=rain_data,columns=list(word_dict.values()))

rain_total = pd.concat([rain_total,rain_df])

print(rain_total)

# 关闭浏览器

driver.close()

# 保存数据

data_str = datetime.datetime.now().strftime('%Y_%m_%d')

rain_total.to_csv("%s_全国水雨情信息.csv" % (data_str),index=None, encoding="GB18030")

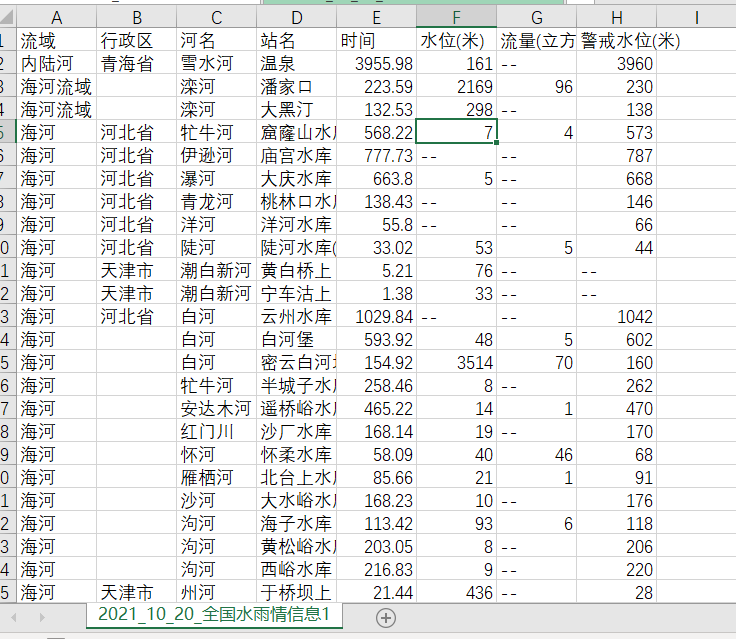

结果

反思

时间爬取出现了一点问题,我也很不理解,其次,循环哪里应该可以简洁代码,写的不是很好,第三,没有形成模块化的代码。还有就是谢谢崔工的支持。

利用python爬取全国水雨情信息的更多相关文章

- 利用python爬取贝壳网租房信息

最近准备换房子,在网站上寻找各种房源信息,看得眼花缭乱,于是想着能否将基本信息汇总起来便于查找,便用python将基本信息爬下来放到excel,这样一来就容易搜索了. 1. 利用lxml中的xpath ...

- 利用Selenium爬取淘宝商品信息

一. Selenium和PhantomJS介绍 Selenium是一个用于Web应用程序测试的工具,Selenium直接运行在浏览器中,就像真正的用户在操作一样.由于这个性质,Selenium也是一 ...

- 利用python爬取58同城简历数据

利用python爬取58同城简历数据 利用python爬取58同城简历数据 最近接到一个工作,需要获取58同城上面的简历信息(http://gz.58.com/qzyewu/).最开始想到是用pyth ...

- 利用python爬取城市公交站点

利用python爬取城市公交站点 页面分析 https://guiyang.8684.cn/line1 爬虫 我们利用requests请求,利用BeautifulSoup来解析,获取我们的站点数据.得 ...

- 利用Python爬取豆瓣电影

目标:使用Python爬取豆瓣电影并保存MongoDB数据库中 我们先来看一下通过浏览器的方式来筛选某些特定的电影: 我们把URL来复制出来分析分析: https://movie.douban.com ...

- python爬取 “得到” App 电子书信息

前言 文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理. 作者: 静觅 崔庆才 PS:如有需要Python学习资料的小伙伴可以加点击下 ...

- 用Python爬取智联招聘信息做职业规划

上学期在实验室发表时写了一个爬取智联招牌信息的爬虫. 操作流程大致分为:信息爬取——数据结构化——存入数据库——所需技能等分词统计——数据可视化 1.数据爬取 job = "通信工程师&qu ...

- 利用Python爬取朋友圈数据,爬到你开始怀疑人生

人生最难的事是自我认知,用Python爬取朋友圈数据,让我们重新审视自己,审视我们周围的圈子. 文:朱元禄(@数据分析-jacky) 哲学的两大问题:1.我是谁?2.我们从哪里来? 本文 jacky试 ...

- Python爬取房天下二手房信息

一.相关知识 BeautifulSoup4使用 python将信息写入csv import csv with open("11.csv","w") as csv ...

随机推荐

- Python文件(File)及读写操作及生成器yield

open函数在内存中创建缓存区,将磁盘上的内容复制到此处.文件内容读入到文件对象缓冲区后,文件对象将缓冲区视为非常大的列表,其中每个元素都有一个索引.文件对象按字节(大约每个字符)来对文件对象缓冲区索 ...

- 通过 layout 探索 kratos 运行原理

创建项目 首先需要安装好对应的依赖环境,以及工具: go 下载 protoc go install google.golang.org/protobuf/cmd/protoc-gen-go@lates ...

- Linux档案权限篇之一

一.查看档案的属性 "ls" 第一列为档案的权限: d:代表是目录 -:代表是文件 l:代表是连接文件(相当于windows里面的快捷方式) b:代表块设备(如硬盘) c:代表字符 ...

- 用python的pandas读取excel文件中的数据

一.读取Excel文件 使用pandas的read_excel()方法,可通过文件路径直接读取.注意到,在一个excel文件中有多个sheet,因此,对excel文件的读取实际上是读取指定文件.并 ...

- Lua io.lines()

前言# 从文章的题目可以看出,今天的内容是和文件的行相关的,其实这个函可以看成是一个文件读取函数,只不过文件读取的形式固定了,就是只能一行一行的读,接下来我们就一起来看看这个函数究竟要怎么使用. 内容 ...

- 【转载】linux 工作队列上睡眠的认识--不要在默认共享队列上睡眠

最近项目组做xen底层,我已经被完爆无数遍了,关键在于对内核.驱动这块不熟悉,导致分析xen代码非常吃力.于是准备细细的将 几本 linux 书籍慢慢啃啃. 正好看到LINUX内核设计与实现,对于内核 ...

- PHP中用+号连接数组的结果是?

我们在开发中,有时候会将两个数组合并连接起来,这个时候要注意了,千万不要偷懒直接使用+号哦,为什么呢?我们看看以下代码: $a = [1, 2]; $b = [4, 5, 6]; $c = $a + ...

- Shell系列(11)- 位置参数变量(4)

作用 往shell脚本里面传递参数 位置参数变量 作用 $n n 为数字,$0 代表命令本身,$1-$9 代表第一到第九个参数,十以上的参数需要用大括号包含,如 ${10} $* 这个变量代表命令行中 ...

- 一朵云、一张网、一体化 ——GRTN 打造最佳流媒体场景实践

阿里巴巴 GRTN 是面向流媒体云原生设计的,方便客户构建自己的流媒体云原生应用,让流媒体服务无处不在. 在近期召开的分布式云主题报告会上,阿里云资深技术专家卢日发表了题为<GRTN 打造阿里云 ...

- Selenium多浏览器并行测试

如果需要同时在IE.firefox.chrome进行测试,可以使用grid. Selenium Grid是一个智能代理服务器,允许Selenium测试将命令路由到远程Web浏览器实例.其目的是提供一种 ...