Python爬虫学习之正则表达式爬取个人博客

实例需求:运用python语言爬取http://www.eastmountyxz.com/个人博客的基本信息,包括网页标题,网页所有图片的url,网页文章的url、标题以及摘要。

实例环境:python3.7

requests库(内置的python库,无需手动安装)

re库(内置的python库,无需手动安装)

实例网站:

第一步,点击网站地址http://www.eastmountyxz.com/,查看页面有哪些信息,网页标题、图片以及摘要等

第二步,查看网页源代码,即可看到想要爬取的基本信息

实例代码:

#encoding:utf-8

import re

#import urllib.request

import requests def getHtmlStr(url):

#content = urllib.request.urlopen(url).read().decode("utf-8")

res = requests.get(url)

res.encoding = res.apparent_encoding

return res.text def parseHtml(content):

#爬取整个网页的标题

title = re.findall(r'<title>(.*?)</title>', content)

print(title[0])

#爬取图片地址

urls = re.findall(r'<img .*src="\./(.*?)"', content)

baseUrl = 'http://www.eastmountyxz.com/' for i in range(len(urls)):

urls[i] = baseUrl + urls[i]

print(urls) #爬取文章信息

p = r'<div class="essay.*?">(.*?)</div>'

artcles = re.findall(p, content, re.S)

for a in artcles:

res = r'<a .*href="(.*?)">'

t1 = re.findall(res, a, re.S) #超链接

print(t1[0])

t2 = re.findall(r'<a .*?>(.*?)</a>', a, re.S) #标题

print(t2[0])

t3 = re.findall('<p style=.*?>(.*?)</p>', a, re.S) #摘要(

print(t3[0].replace(' ',''))

print('') if __name__ == '__main__':

url = "http://www.eastmountyxz.com/"

htmlString = getHtmlStr(url)

parseHtml(htmlString)

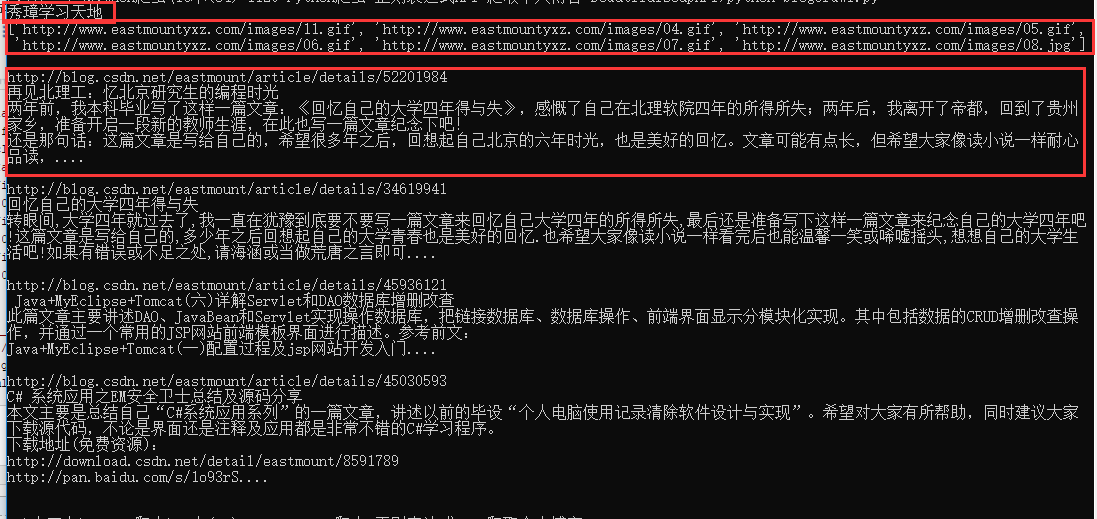

实例结果:

Python爬虫学习之正则表达式爬取个人博客的更多相关文章

- python爬虫学习01--电子书爬取

python爬虫学习01--电子书爬取 1.获取网页信息 import requests #导入requests库 ''' 获取网页信息 ''' if __name__ == '__main__': ...

- Python爬虫之利用正则表达式爬取内涵吧

首先,我们来看一下,爬虫前基本的知识点概括 一. match()方法: 这个方法会从字符串的开头去匹配(也可以指定开始的位置),如果在开始没有找到,立即返回None,匹配到一个结果,就不再匹配. 我们 ...

- python爬虫:利用正则表达式爬取豆瓣读书首页的book

1.问题描述: 爬取豆瓣读书首页的图书的名称.链接.作者.出版日期,并将爬取的数据存储到Excel表格Douban_I.xlsx中 2.思路分析: 发送请求--获取数据--解析数据--存储数据 1.目 ...

- Python爬虫学习笔记之爬取新浪微博

import requests from urllib.parse import urlencode from pyquery import PyQuery as pq from pymongo im ...

- 初识python 之 爬虫:使用正则表达式爬取“糗事百科 - 文字版”网页数据

初识python 之 爬虫:使用正则表达式爬取"古诗文"网页数据 的兄弟篇. 详细代码如下: #!/user/bin env python # author:Simple-Sir ...

- Python爬虫小实践:爬取任意CSDN博客所有文章的文字内容(或可改写为保存其他的元素),间接增加博客访问量

Python并不是我的主业,当初学Python主要是为了学爬虫,以为自己觉得能够从网上爬东西是一件非常神奇又是一件非常有用的事情,因为我们可以获取一些方面的数据或者其他的东西,反正各有用处. 这两天闲 ...

- Python爬虫实战二之爬取百度贴吧帖子

大家好,上次我们实验了爬取了糗事百科的段子,那么这次我们来尝试一下爬取百度贴吧的帖子.与上一篇不同的是,这次我们需要用到文件的相关操作. 前言 亲爱的们,教程比较旧了,百度贴吧页面可能改版,可能代码不 ...

- Python爬虫实战一之爬取糗事百科段子

大家好,前面入门已经说了那么多基础知识了,下面我们做几个实战项目来挑战一下吧.那么这次为大家带来,Python爬取糗事百科的小段子的例子. 首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把 ...

- 转 Python爬虫实战二之爬取百度贴吧帖子

静觅 » Python爬虫实战二之爬取百度贴吧帖子 大家好,上次我们实验了爬取了糗事百科的段子,那么这次我们来尝试一下爬取百度贴吧的帖子.与上一篇不同的是,这次我们需要用到文件的相关操作. 本篇目标 ...

随机推荐

- pythone函数基础(14)发送邮件

导入yagmail模块import yagmailusername='uitestp4p@163.com'password='houyafan123'#生成授权码,qq.163.126都是授权码 ma ...

- 分布式事务Hmily TCC源码--学习整合

一.什么是分布式事务 分布式事务是指事务的参与者.支持事务的服务器.资源服务器以及事务管理器分别位于不同的分布式系统的不同节点上, 本质上来说,分布式事务是为了保证不同数据库的数据一致性 TCC事务主 ...

- angular中如果几个请求相互不依赖,但是请求结果需要一起处理,可以使用

- SpringMvc中Hashmap操作遇到 java.util.ConcurrentModificationException: null

代码按照网上修改为类似,还不能解决问题 for (Iterator<String> it = target.keySet().iterator(); it.hasNext(); ) { i ...

- API Test WebApiTestClient工具安装及使用

一.guget安装: 1.解决方案右键-管理解决方案的nuget程序包打开如下图: 搜索WebApiTestClient,然后选择查询出的项目,右边点击安装即可: 2.安装会有如下图提示: 确定即 ...

- 7I - 数塔

在讲述DP算法的时候,一个经典的例子就是数塔问题,它是这样描述的: 有如下所示的数塔,要求从顶层走到底层,若每一步只能走到相邻的结点,则经过的结点的数字之和最大是多少? 已经告诉你了,这是个DP的题目 ...

- spring boot利用controller来测试写的类

我们在开发spring boot应用程序的时候,往往需要测试某个写好的类,但是在测试的时候发现不太好测试,用Junit等测试框架,总是会报一些问题,大致是找不到配置文件以及无法利用spring创建的对 ...

- 从mysql主从复制到微信开源的phxsql

严格的来说,微信开源的phxsql不是数据库,而是一个数据库的插件: 传统的互联网数据库结构一般是这样的: 服务访问数据库是通过分片来的: 除了这种基于hash的分片,还有一种基于range的分片方式 ...

- git 一些实用的api

v3 获取原始文件内容: curl -H "PRIVATE-TOKEN: <token>" -H "Content-Type: application/jso ...

- 图解Go select语句原理

Go 的select语句是一种仅能用于channl发送和接收消息的专用语句,此语句运行期间是阻塞的:当select中没有case语句的时候,会阻塞当前的groutine.所以,有人也会说select是 ...