06 RDD编程

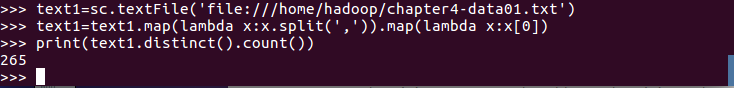

- 总共有多少学生?map(), distinct(), count()

- 开设了多少门课程?

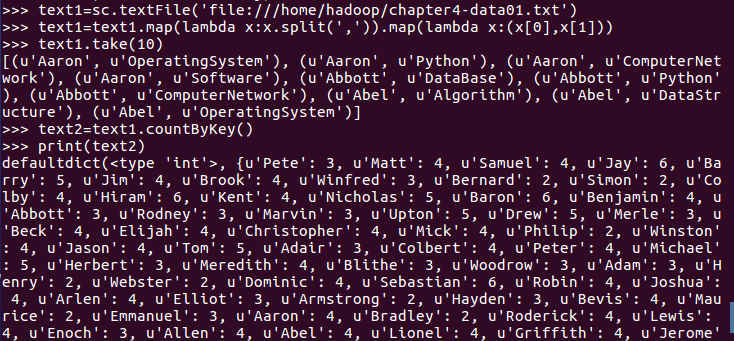

- 每个学生选修了多少门课?map(), countByKey()

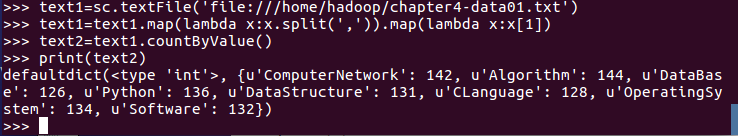

- 每门课程有多少个学生选?map(), countByValue()

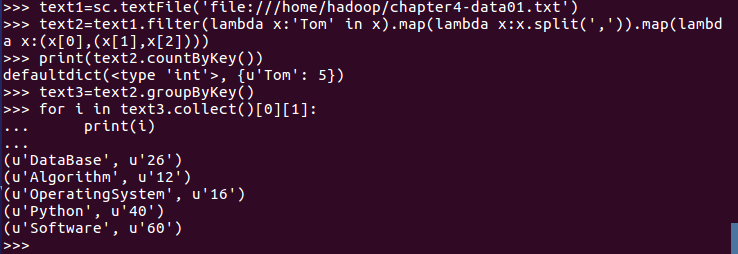

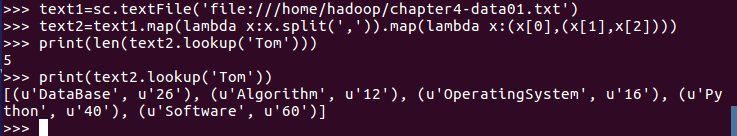

- Tom选修了几门课?每门课多少分?filter(), map() RDD

- Tom选修了几门课?每门课多少分?map(),lookup() list

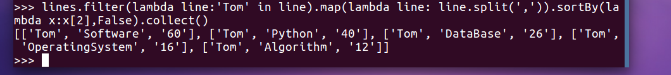

- Tom的成绩按分数大小排序。filter(), map(), sortBy()

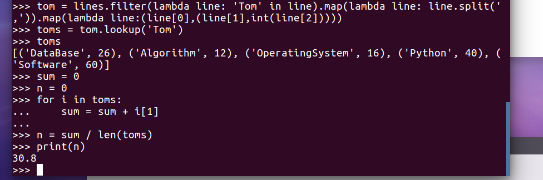

- Tom的平均分。map(),lookup(),mean()

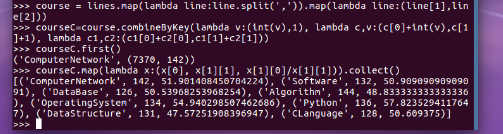

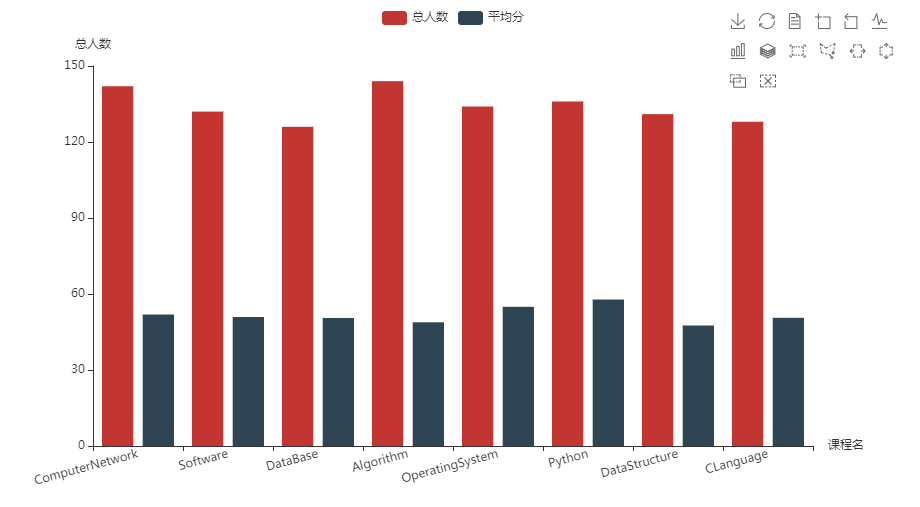

- 求每门课的选修人数及平均分。combineByKey()

course_list = stu_rdd_cource_count_reduce.collect()

sk = ''

rs = 0

zf = 0

for j in range(len(course_list)):

sk = str(course_list[j]).split(',')[0].replace("('",'').replace("'",'')

rs = int(str(course_list[j]).split(',')[1].replace(')',''))

zf = int(str(stu_rdd_cource_sum_reduce.collect()[j]).split(',')[1].replace(')',''))

print(sk, rs,round(zf/rs,2))结果可视化。 pyecharts.charts,Bar()

import pyecharts.options as opts

from pyecharts.charts import Bar

x = ['ComputerNetwork', 'Software', 'DataBase', 'Algorithm', 'OperatingSystem', 'Python', 'DataStructure', 'CLanguage']

y = [

[142, 132, 126, 144, 134, 136, 131, 128],

[51.9, 50.91, 50.54, 48.83, 54.94, 57.82, 47.57, 50.61]

]

bar = (

Bar()

.add_xaxis(x)

.add_yaxis(series_name='总人数', y_axis=y[0])

.add_yaxis(series_name='平均分', y_axis=y[1])

.set_series_opts(label_opts=opts.LabelOpts(is_show=False))

.set_global_opts(title_opts=opts.TitleOpts(title='课程', pos_left='right'))

.set_global_opts(toolbox_opts=opts.ToolboxOpts(is_show=True),

yaxis_opts=opts.AxisOpts(name="总人数"),

xaxis_opts=opts.AxisOpts(name="课程名"),axislabel_opts=opts.LabelOpts(rotate=15))

)

bar.render()

bar.render('./bar.html')

06 RDD编程的更多相关文章

- Spark菜鸟学习营Day3 RDD编程进阶

Spark菜鸟学习营Day3 RDD编程进阶 RDD代码简化 对于昨天练习的代码,我们可以从几个方面来简化: 使用fluent风格写法,可以减少对于中间变量的定义. 使用lambda表示式来替换对象写 ...

- Spark菜鸟学习营Day1 从Java到RDD编程

Spark菜鸟学习营Day1 从Java到RDD编程 菜鸟训练营主要的目标是帮助大家从零开始,初步掌握Spark程序的开发. Spark的编程模型是一步一步发展过来的,今天主要带大家走一下这段路,让我 ...

- Spark学习笔记2:RDD编程

通过一个简单的单词计数的例子来开始介绍RDD编程. import org.apache.spark.{SparkConf, SparkContext} object word { def main(a ...

- Spark编程模型(RDD编程模型)

Spark编程模型(RDD编程模型) 下图给出了rdd 编程模型,并将下例中用 到的四个算子映射到四种算子类型.spark 程序工作在两个空间中:spark rdd空间和 scala原生数据空间.在原 ...

- 02、体验Spark shell下RDD编程

02.体验Spark shell下RDD编程 1.Spark RDD介绍 RDD是Resilient Distributed Dataset,中文翻译是弹性分布式数据集.该类是Spark是核心类成员之 ...

- Spark学习之RDD编程(2)

Spark学习之RDD编程(2) 1. Spark中的RDD是一个不可变的分布式对象集合. 2. 在Spark中数据的操作不外乎创建RDD.转化已有的RDD以及调用RDD操作进行求值. 3. 创建RD ...

- 5.1 RDD编程

一.RDD编程基础 1.创建 spark采用textFile()方法来从文件系统中加载数据创建RDD,该方法把文件的URL作为参数,这个URL可以是: 本地文件系统的地址 分布式文件系统HDFS的地址 ...

- 2. RDD编程

2.1 编程模型 在Spark中,RDD被表示为对象,通过对象上的方法调用来对RDD进行转换.经过一系列的transformations定义RDD之后,就可以调用actions触发RDD的计算,act ...

- spark实验(四)--RDD编程(1)

一.实验目的 (1)熟悉 Spark 的 RDD 基本操作及键值对操作: (2)熟悉使用 RDD 编程解决实际具体问题的方法. 二.实验平台 操作系统:centos6.4 Spark 版本:1.5.0 ...

- 第2章 RDD编程(2.3)

第2章 RDD编程(2.3) 2.3 TransFormation 基本RDD Pair类型RDD (伪集合操作 交.并.补.笛卡尔积都支持) 2.3.1 map(func) 返回一个新的RDD,该 ...

随机推荐

- Apache Kafka 的基本概念

基本概念 主题 Topic topic 是 Kafka 最基础的组织单位,类似于关系数据库中的数据表.做为使用 kafka 的开发者,你最应该考虑的是和 topoc 相关的抽象.创建不同的 topic ...

- python之路46 django request对象 form表单 pycharm连接数据库 ORM简介

静态文件配置 1.编写一个用户登录页面 2.静态文件 不怎么经常变化的文件 主要针对html文件所使用的到的各种资源 css文件.js文件.img文件.第三方框架文件 django针对静态文件资源需要 ...

- P8855 [POI2002]商务旅行

简要题意 给出一个 \(N\) 个节点的树和一个长度为 \(M\) 的序列 \(S\).你需要从 \(1\) 出发,依次经过 \(S\) 中的所有点,求至少需要经过的边数. \(1 \le N \le ...

- MySQL性能优化浅析及线上案例

作者:京东健康 孟飞 1. 数据库性能优化的意义 业务发展初期,数据库中量一般都不高,也不太容易出一些性能问题或者出的问题也不大,但是当数据库的量级达到一定规模之后,如果缺失有效的预警.监控.处理等手 ...

- 基于 VScode 搭建 STM32 运行环境

所需软件 vscode: 是我们的代码编辑器 STM32CubeMX: 是我们配置和初始化的软件 OpenOCD: 是开源片上调试器, 他下载完是一个压缩包, 需要配置环境 arm-none-eabi ...

- BUG日记---运行Tomcat报406错误:根据请求中接收到的主动协商头字段,目标资源没有用户代理可以接受的当前表示,而且服务器不愿意提供缺省表示。

网页报错内容 HTTP Status 406 – 不可接收 Type Status Report 描述 根据请求中接收到的主动协商头字段,目标资源没有用户代理可以接受的当前表示,而且服务器不愿意提供缺 ...

- VS保存后Unity不刷新

目录 问题:Visual Studio写完代码保存好,Unity不会重新编译 三种解决方案 1.先选为默认.重启Unity.更改为想要的代码编写软件. 2.查看Auto Refresh是否开启 3. ...

- TS不能将类型“any[]”分配给类型“never[]”

一.问题 在处理接口返回的数据,赋值给store中的数组时,报类型错误 data:{ cateList: [] } const getCateList = async () => { const ...

- 各种排序算法实现(JAVA)

转载: https://blog.csdn.net/qq_42453117/article/details/100036347 Exer010Sort01BubbleSortV1 import ja ...

- Vue 01 简介

1 官网 1)英文官网: https://vuejs.org/ 2)中文官网: https://cn.vuejs.org/ 2 介绍与描述 1) 动态构建用户界面的渐进式 JavaScript ...