jieba库与词云的使用——以孙子兵法为例

1.打开cmd安装jieba库和 matplotlib。

2.打开python,输入代码。代码如下:

from wordcloud import WordCloud

import matplotlib.pyplot as plt

import jieba def create_word_cloud(filename): text = open("孙子兵法.txt","r",encoding='GBK').read() #打开自己想要的文本 wordlist = jieba.cut(text, cut_all=True) # 结巴分词 wl = " ".join(wordlist) wc = WordCloud( #设置词云 background_color="white", # 设置背景颜色 max_words=50, # 设置最大显示的词云数 font_path='C:/Windows/Fonts/simfang.ttf', # 索引在C盘上的字体库 height=1000, width=1000, max_font_size=150, # 设置字体最大值 random_state=150, # 设置有多少种随机生成状态,即有多少种配色方案 ) myword = wc.generate(wl) # 生成词云 plt.imshow(myword) # 展示词云图 plt.axis("off") plt.show() wc.to_file('img_book.png') # 把词云保存下 txt=open("孙子兵法.txt","r",encoding='GBK').read() #打开自己想要的文本

words=jieba.lcut(txt)

counts={}

for word in words:

if len(word)==1: #排除单个字符的分词结果

continue

else :

counts[word]=counts.get(word,0)+1

items=list(counts.items())

items.sort(key=lambda x:x[1],reverse=True)

for i in range(20):

word,count=items[i]

print ("{0:<20}{1:>5}".format(word,count))

if __name__ == '__main__':

create_word_cloud('孙子兵法') #运行编辑的函数,获得词云

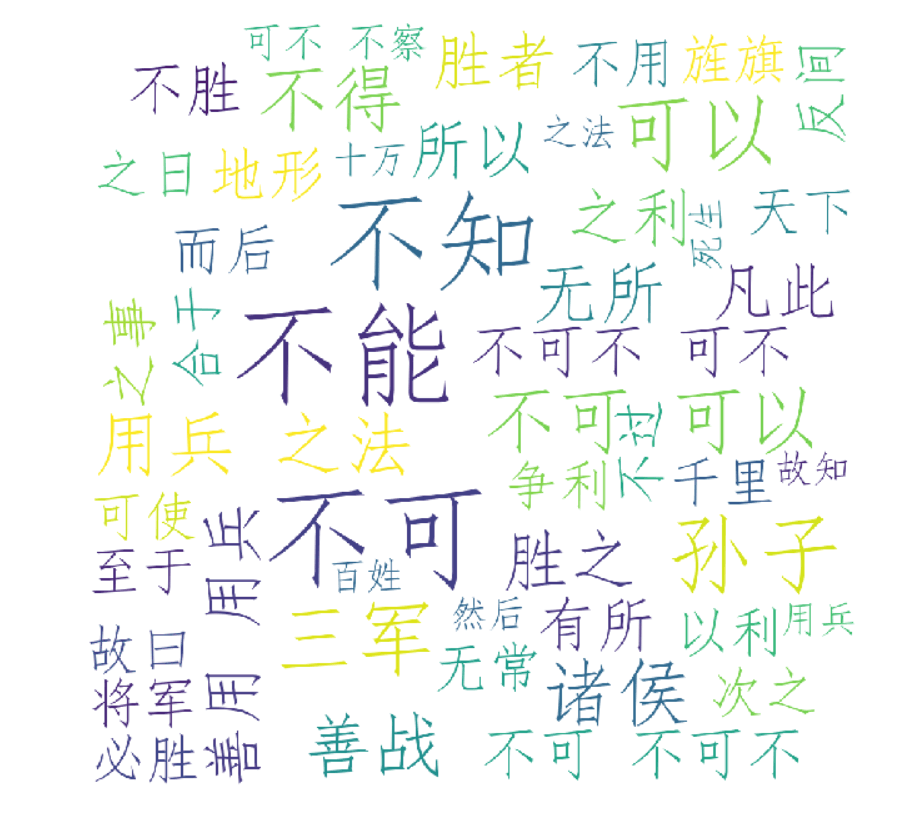

3.结果与词云效果图

jieba库与词云的使用——以孙子兵法为例的更多相关文章

- 利用jieba库画词云

from wordcloud import WordCloud import matplotlib.pyplot as plt import jieba # 生成词云 def create_word_ ...

- jieba分词wordcloud词云

1.jieba库的基本介绍 (1).jieba是优秀的中文分词第三方库 中文文本需要通过分词获得单个的词语 jieba是优秀的中文分词第三方库,需要额外安装 jieba库提供三种分词模式,最简单只需掌 ...

- python 基于 wordcloud + jieba + matplotlib 生成词云

词云 词云是啥?词云突出一个数据可视化,酷炫.以前以为很复杂,不想python已经有成熟的工具来做词云.而我们要做的就是准备关键词数据,挑一款字体,挑一张模板图片,非常非常无脑.准备好了吗,快跟我一起 ...

- python使用matplotlib画图,jieba分词、词云、selenuium、图片、音频、视频、文字识别、人脸识别

一.使用matplotlib画图 关注公众号"轻松学编程"了解更多. 使用matplotlib画柱形图 import matplotlib from matplotlib impo ...

- Python基于jieba的中文词云

今日学习了python的词云技术 from os import path from wordcloud import WordCloud import matplotlib.pyplot as plt ...

- wordcloud + jieba 生成词云

利用jieba库和wordcloud生成中文词云. jieba库:中文分词第三方库 分词原理: 利用中文词库,确定汉字之间的关联概率,关联概率大的生成词组 三种分词模式: 1.精确模式:把文本精确的切 ...

- python抓取数据构建词云

1.词云图 词云图,也叫文字云,是对文本中出现频率较高的"关键词"予以视觉化的展现,词云图过滤掉大量的低频低质的文本信息,使得浏览者只要一眼扫过文本就可领略文本的主旨. 先看几个词 ...

- 如何运用jieba库分词

使用jieba库分词 一.什么是jieba库 1.jieba库概述 jieba是优秀的中文分词第三方库,中文文本需要通过分词获得单个词语. 2.jieba库的使用:(jieba库支持3种分词模式) 通 ...

- Python之利用jieba库做词频统计且制作词云图

一.环境以及注意事项 1.windows10家庭版 python 3.7.1 2.需要使用到的库 wordcloud(词云),jieba(中文分词库),安装过程不展示 3.注意事项:由于wordclo ...

随机推荐

- 高校表白APP-冲刺第三天

第三天,我们进行了第三次会议. 一.任务: 昨日任务:完成APP基本的登陆框架. 今日任务:完成登录界面修改界面注册界面,并解决闪退. 明日任务:完成界面跳转,并彻底解决闪退. 二.遇到的困难: 今天 ...

- springboot使用@data注解,减少不必要代码

一.idea安装lombok插件 二.重启idea 三.添加maven依赖 <dependency> <groupId>org.projectlombok</groupI ...

- 使用 lsyncd 同步文件

https://unix.stackexchange.com/questions/307046/real-time-file-synchronization https://github.com/ax ...

- datagridview 添加数据库数据

private void btnadd_Click(object sender, EventArgs e) { string str = @"Data Source=(localdb)\MS ...

- BZOJ5279: [Usaco2018 Open]Disruption

题目大意:给你一棵n个节点的树,这n条边称为原边,另给出m条带权值的额外边,求删去每条原边后通过给出的m额外条边变回一棵树的最小价值.题解:看完题面以为是Tarjan连通性之类的题目,冷静分析后想到是 ...

- CentOS中使用tcpdump抓包

安装: yum install tcpdump 命令使用: 监听特定网卡 tcpdump 抓取第一块网卡所有数据包 [root@server110 tcpdump]# tcpdump tcpdump: ...

- Dockerfile详解及优化

Dockerfile详解 0. Dockerfile的作用 docker可以根据Dockerfile中的指令来构建docker镜像.Dockerfile是一个文本文件,其应当包含用户想要构建一个镜像的 ...

- [转载]解决"command 'gcc' failed with exit status 1"错误问题

转自:https://blog.csdn.net/learn_tech/article/details/80066583 解决"command 'gcc' failed with exit ...

- SAP 跨公司销售业务

SAP 跨公司销售业务 http://blog.sina.com.cn/s/blog_95ac31e30102x5wh.html 分类: SAP_SD SAP 跨公司销售业务 一.业务简介 在由 ...

- L1范数与L2范数

L1范数与L2范数 L1范数与L2范数在机器学习中,是常用的两个正则项,都可以防止过拟合的现象.L1范数的正则项优化参数具有稀疏特性,可用于特征选择:L2范数正则项优化的参数较小,具有较好的抗干 ...