Python爬虫-爬取手机应用市场中APP下载量

一、首先是爬取360手机助手应用市场信息,用来爬取360应用市场,App软件信息,现阶段代码只能爬取下载量,如需爬取别的信息,请自行添加代码。

使用方法:

1、在D盘根目录新建.tet文件,命名为App_name,并把App名称黏贴到文件内,格式如下:

2、直接运行就好。

最近比较忙,好久没更新博客了,为什么忙呢,是因为最近被派到“App专项治理组”做App治理工作了,在专班成立初期热心网友举报量比较多,天天处理举报问题,和统计被举报App的下载量,而且是5个应用市场下载量和,如果就几款App可能还好,但是每天处理几百款App,俺表示眼睛和手指头都抗议,这时我就想起了python,所以决定做5个爬虫,分别爬取5个应用市场上App信息,废话不多说,下面是我的代码:

1、第一种方法,使用字典完成。

# !/usr/bin/env python

# -*- coding: UTF-8 –*-

__author__ = 'Mr.Li' import requests

from bs4 import BeautifulSoup

import xlsxwriter,time def write_excel(name, download, type_name=0, url=0):

# 全局变量row代表行号 0-2代表列数

global row

sheet.write(row, 0, row)

sheet.write(row, 1, name)

sheet.write(row, 2, download) row += 1 headers = {'User-Agent':'Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/52.0.2743.116 Safari/537.36'} def App_download(url,app_name):

# 获取地址

i = 1

try:

time.sleep(0.5)

req = requests.get(url=url,headers=headers)

req.encoding = 'utf-8' # 获取的内容保存在变量

html_all = req.text div_bf = BeautifulSoup(html_all, 'html.parser') # 使用BeautifulSoup进行解析

div = div_bf.find_all('div',class_='SeaCon')#查找SeaCon元素内容 a_bf = BeautifulSoup(str(div), 'html.parser') # 重新解析

info = a_bf.find_all('li') # 查找元素为'li'的内容,其中包括APP的名称和下载量信息

name = info[0].dl.dd.h3.a.text.strip()

all_list = []

if name == app_name: download_num = BeautifulSoup(str(info[0]), 'html.parser') # 重新解析

texts = download_num.find_all('p', class_='downNum')#查找下载量

find_download_num = texts[0].text.replace('\xa0'*8,'\n\n')[:-3]#去除不需要的信息

print(name, find_download_num)

write_excel(name,find_download_num)#写入xlsx文件

else:

find_download_num1= 'None'

print(app_name,find_download_num1)

write_excel(app_name,find_download_num1) except Exception as e:

#print('error:%s,尝试重新获取'%(e,i))

#print(url)

if i != 3:

App_download(url, app_name)

i += 1 row = 1

# 新建一个excel文件

file = xlsxwriter.Workbook('360_applist.xlsx')

# 新建一个sheet

sheet = file.add_worksheet()

if __name__ == '__main__':

path_file = "D:\\"

Old_AppFlie = open(path_file + "App_name.txt").read()

app_list = Old_AppFlie.split('\n') # 把字符串转为列表

#app_list = ['微信','1113123','支付宝','荔枝']

for app_name in app_list:

yyb_url = 'http://zhushou.360.cn/search/index/?kw={app_name}'.format(app_name=app_name)

App_download(yyb_url,app_name)

file.close()

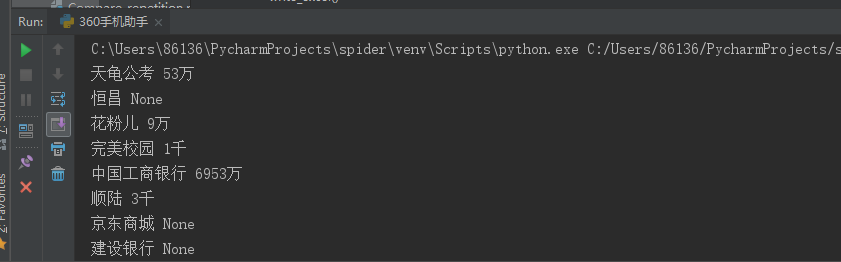

运行结果:

可以查到的,会显示下载量,如果在应用中查不到会显示None,并把结果写到360_applist.xlsx文件中。

已经过一段时间使用以上程序发现一个问题,如果所爬取的程序不存在,也就是在360应用市场中搜索不到的话,程序就会卡死,搜索不到指的是页面一个内容也没有,如下图:

这样的话程序会卡死,最终出错,这是因为我们程序中需要用到索引,在查询结果中进行索引,但是结果是空的,在使用索引就超范围了,所以会卡死报错,我们可以判断是,如果搜索不到内容及搜索结果为空也就是0,我在程序中做了判断,如果搜索结果长度不等于0就执行爬取下载量操作,然后下入数据,如果等于0就直接写入APP名称和None表示没有东西。

修改后代码:

# !/usr/bin/env python

# -*- coding: UTF-8 –*-

__author__ = 'Mr.Li' import requests

from bs4 import BeautifulSoup

import xlsxwriter,time def write_excel(name, download, type_name=0, url=0):

# 全局变量row代表行号 0-2代表列数

global row

sheet.write(row, 0, row)

sheet.write(row, 1, name)

sheet.write(row, 2, download) row += 1 headers = {'User-Agent':'Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/52.0.2743.116 Safari/537.36'} def App_download(url,app_name):

# 获取地址

i = 1

try:

time.sleep(0.5)

req = requests.get(url=url,headers=headers)

req.encoding = 'utf-8' # 获取的内容保存在变量

html_all = req.text div_bf = BeautifulSoup(html_all, 'html.parser') # 使用BeautifulSoup进行解析

div = div_bf.find_all('div',class_='SeaCon')#查找SeaCon元素内容 a_bf = BeautifulSoup(str(div), 'html.parser') # 重新解析

info = a_bf.find_all('li') # 查找元素为'li'的内容,其中包括APP的名称和下载量信息

name = info[0].dl.dd.h3.a.text.strip()

all_list = []

if name == app_name: download_num = BeautifulSoup(str(info[0]), 'html.parser') # 重新解析

texts = download_num.find_all('p', class_='downNum')#查找下载量

find_download_num = texts[0].text.replace('\xa0'*8,'\n\n')[:-3]#去除不需要的信息

print(name, find_download_num)

write_excel(name,find_download_num)#写入xlsx文件

else:

find_download_num1= 'None'

print(app_name,find_download_num1)

write_excel(app_name,find_download_num1) except Exception as e:

#print('error:%s,尝试重新获取'%(e,i))

#print(url)

if i != 3:

App_download(url, app_name)

i += 1 row = 1

# 新建一个excel文件

file = xlsxwriter.Workbook('360_applist.xlsx')

# 新建一个sheet

sheet = file.add_worksheet()

if __name__ == '__main__':

path_file = "D:\\"

Old_AppFlie = open(path_file + "App_name.txt").read()

app_list = Old_AppFlie.split('\n') # 把字符串转为列表

#app_list = ['微信','1113123','支付宝','荔枝']

for app_name in app_list:

yyb_url = 'http://zhushou.360.cn/search/index/?kw={app_name}'.format(app_name=app_name)

App_download(yyb_url,app_name)

file.close()

二、爬取百度应用市场APP信息

# !/usr/bin/env python

# -*- coding: UTF-8 –*-

__author__ = 'Mr.Li'

import requests

from bs4 import BeautifulSoup

import xlsxwriter,time

def write_excel(name, download, type_name=0, url=0):

# 全局变量row代表行号 0-2代表列数

global row

sheet.write(row, 0, row)

sheet.write(row, 1, name)

sheet.write(row, 2, download)

row += 1

headers = {'User-Agent':'Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/52.0.2743.116 Safari/537.36'}

def App_download(url,app_name):

# 获取地址

i = 1

try:

time.sleep(0.5)

req = requests.get(url=url,headers=headers)

req.encoding = 'utf-8'

# 获取的内容保存在变量

html_all = req.text

div_bf = BeautifulSoup(html_all, 'html.parser') # 使用BeautifulSoup进行解析

div = div_bf.find_all('div',class_='SeaCon')#查找SeaCon元素内容

a_bf = BeautifulSoup(str(div), 'html.parser') # 重新解析

info = a_bf.find_all('li') # 查找元素为'li'的内容,其中包括APP的名称和下载量信息

name = info[0].dl.dd.h3.a.text.strip()

if len(info) != 0:

if name == app_name:

download_num = BeautifulSoup(str(info[0]), 'html.parser') # 重新解析

texts = download_num.find_all('p', class_='downNum')#查找下载量

find_download_num = texts[0].text.replace('\xa0'*8,'\n\n')[:-3]#去除不需要的信息

print(name, find_download_num)

write_excel(name,find_download_num)#写入xlsx文件

else:

find_download_num1= 'None'

print(app_name,find_download_num1)

write_excel(app_name,find_download_num1)

else:

print(app_name, 'None')

write_excel(app_name, 'None')

except Exception as e:

#print('error:%s,尝试重新获取'%(e,i))

#print(url)

if i != 3:

App_download(url, app_name)

i += 1

row = 1

# 新建一个excel文件

file = xlsxwriter.Workbook('360_applist.xlsx')

# 新建一个sheet

sheet = file.add_worksheet()

if __name__ == '__main__':

path_file = "D:\\"

Old_AppFlie = open(path_file + "App_name.txt").read()

app_list = Old_AppFlie.split('\n') # 把字符串转为列表

#app_list = ['微信','1113123','支付宝','荔枝']

for app_name in app_list:

yyb_url = 'http://zhushou.360.cn/search/index/?kw={app_name}'.format(app_name=app_name)

App_download(yyb_url,app_name)

file.close()

三、爬取华为应用市场APP信息

# !/usr/bin/env python

# -*- coding: UTF-8 –*-

__author__ = 'Mr.Li' import requests

from bs4 import BeautifulSoup

import xlsxwriter def write_excel(name, download, type_name=0, url=0):

# 全局变量row代表行号 0-2代表列数

global row

sheet.write(row, 0, row)

sheet.write(row, 1, name)

sheet.write(row, 2, download) row += 1 headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/62.0.3202.62 Safari/537.36'} def App_download(url,app_name):

# 获取地址

i = 1

try:

req = requests.get(url=url,headers=headers)

req.encoding = 'utf-8' # 获取的内容保存在变量

html_all = req.text

div_bf = BeautifulSoup(html_all, 'html.parser') # 使用BeautifulSoup进行解析

div = div_bf.find_all('div',class_='unit-main')#查找SeaCon元素内容 a_bf = BeautifulSoup(str(div), 'html.parser') # 重新解析

info = a_bf.find_all('div',class_='list-game-app dotline-btn nofloat') # 查找元素为'li'的内容,其中包括APP的名称和下载量信息 if len(info) != 0: name = info[0].h4.a.text.strip() # 获取app名称,去除两边的空格

if name == app_name:

download_num = BeautifulSoup(str(info[0]), 'html.parser') # 重新解析

texts = download_num.find_all('span') # 查找下载量

find_download_num = texts[3].text.replace('\xa0' * 8, '\n\n')[2:] # 去除不需要的信息

print(name, find_download_num)

write_excel(name, find_download_num) # 写入xlsx文件

else:

find_download_num1= 'None'

print(app_name,find_download_num1)

write_excel(app_name,find_download_num1)

else:

print(app_name, 'None')

write_excel(app_name, 'None') # 写入xlsx文件

except Exception as e:

#print('error:%s,尝试重新获取'%(e,i))

#print(url)

if i != 3:

App_download(url, app_name)

i += 1 row = 1

# 新建一个excel文件

file = xlsxwriter.Workbook('hw_applist.xlsx')

# 新建一个sheet

sheet = file.add_worksheet()

if __name__ == '__main__':

path_file = "D:\\"

Old_AppFlie = open(path_file + "App_name.txt").read()

app_list = Old_AppFlie.split('\n') # 把字符串转为列表

#app_list = ['微信','wea11','支付宝','荔枝']

for app_name in app_list:

yyb_url = 'https://appstore.huawei.com/search/{app_name}'.format(app_name=app_name)

App_download(yyb_url,app_name)

file.close()

爬取华为和百度应用市场代码就不详细介绍了,原理一样,如果感兴趣你还可以在这基础上做出更改,加入爬取APP介绍信息,爬取APP版本等功能。

2019.12.09再次更新,更新原因,因为各大应用市场名称不太一样,为了实现模糊匹配,提高精度,笔者又进行了一次更新,模糊匹配本来应该使用re的正则表达式的,但是考虑到各大应用市场名称的不确定性,以及如果下载量错误,还不如没有下载量的情况,所以笔者在代码中只是增加了一个小小或的判断,看代码:

百度手机助手应用市场代码:

# !/usr/bin/env python

# -*- coding: UTF-8 –*-

__author__ = 'Mr.Li' import requests

from bs4 import BeautifulSoup

import xlsxwriter def write_excel(name, download, type_name=0, url=0):

# 全局变量row代表行号 0-2代表列数

global row

sheet.write(row, 0, row)

sheet.write(row, 1, name)

sheet.write(row, 2, download) row += 1 name_wu = 'None'

find_download_num_wu = '无'

headers = {'User-Agent':'Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/52.0.2743.116 Safari/537.36'} def App_download(url,app_name):

# 获取地址

i = 1

try:

req = requests.get(url=url,headers=headers)

req.encoding = 'utf-8'

# 获取的内容保存在变量

html_all = req.text

div_bf = BeautifulSoup(html_all, 'html.parser') # 使用BeautifulSoup进行解析

div = div_bf.find_all('ul',class_='app-list')#查找app-list元素内容 a_bf = BeautifulSoup(str(div), 'html.parser') # 重新解析

info = a_bf.find_all('div',class_='info') # 查找元素为'info'的内容,其中包括APP的名称和下载量信息

if len(info) != 0:

name = info[0].a.text.strip()#获取app名称,去除两边的空格

download_num = BeautifulSoup(str(info[0]), 'html.parser') # 重新解析

texts = download_num.find_all('span', class_='download-num') # 查找下载量

find_download_num = texts[0].text.replace('\xa0' * 8, '\n\n') # 去除不需要的信息 if app_name in name or name in app_name: #模糊匹配,判断自己输入App名称是否在查找到的内容中

print(name,find_download_num)

write_excel(name,find_download_num)#写入xlsx文件

else:

find_download_num1= 'None'

print(app_name,find_download_num1)

write_excel(app_name,find_download_num1)

else:

print(app_name, 'None')

write_excel(app_name, 'None')

except Exception as e:

#print('error:%s,尝试重新获取'%(e,i))

#print(url)

if i != 3:

App_download(url, app_name)

i += 1 row = 1

# 新建一个excel文件

file = xlsxwriter.Workbook('baidu_applist.xlsx')

# 新建一个sheet

sheet = file.add_worksheet()

if __name__ == '__main__':

path_file = "D:\\"

Old_AppFlie = open(path_file + "App_name.txt").read()

app_list = Old_AppFlie.split('\n') # 把字符串转为列表

#app_list = ['支付宝','as','荔枝']

for app_name in app_list:

yyb_url = 'https://shouji.baidu.com/s?wd={app_name}&data_type=app&f=header_all%40input'.format(app_name=app_name)

App_download(yyb_url,app_name)

file.close()

这样更新后的精度虽然不是很高,但是可以提高一半,最主要是不会爬错,我们要的就是数据准确,哈哈!!,如果小伙伴有高精度要求,可以考虑正则匹配,自己改一下。

Python爬虫-爬取手机应用市场中APP下载量的更多相关文章

- python爬虫爬取内容中,-xa0,-u3000的含义

python爬虫爬取内容中,-xa0,-u3000的含义 - CSDN博客 https://blog.csdn.net/aiwuzhi12/article/details/54866310

- 用Python爬虫爬取广州大学教务系统的成绩(内网访问)

用Python爬虫爬取广州大学教务系统的成绩(内网访问) 在进行爬取前,首先要了解: 1.什么是CSS选择器? 每一条css样式定义由两部分组成,形式如下: [code] 选择器{样式} [/code ...

- 使用Python爬虫爬取网络美女图片

代码地址如下:http://www.demodashi.com/demo/13500.html 准备工作 安装python3.6 略 安装requests库(用于请求静态页面) pip install ...

- Python爬虫|爬取喜马拉雅音频

"GOOD Python爬虫|爬取喜马拉雅音频 喜马拉雅是知名的专业的音频分享平台,用户规模突破4.8亿,汇集了有声小说,有声读物,儿童睡前故事,相声小品等数亿条音频,成为国内发展最快.规模 ...

- Python爬虫爬取全书网小说,程序源码+程序详细分析

Python爬虫爬取全书网小说教程 第一步:打开谷歌浏览器,搜索全书网,然后再点击你想下载的小说,进入图一页面后点击F12选择Network,如果没有内容按F5刷新一下 点击Network之后出现如下 ...

- python爬虫—爬取英文名以及正则表达式的介绍

python爬虫—爬取英文名以及正则表达式的介绍 爬取英文名: 一. 爬虫模块详细设计 (1)整体思路 对于本次爬取英文名数据的爬虫实现,我的思路是先将A-Z所有英文名的连接爬取出来,保存在一个cs ...

- python爬虫-爬取百度图片

python爬虫-爬取百度图片(转) #!/usr/bin/python# coding=utf-8# 作者 :Y0010026# 创建时间 :2018/12/16 16:16# 文件 :spider ...

- Python爬虫 - 爬取百度html代码前200行

Python爬虫 - 爬取百度html代码前200行 - 改进版, 增加了对字符串的.strip()处理 源代码如下: # 改进版, 增加了 .strip()方法的使用 # coding=utf-8 ...

- 一个简单的python爬虫,爬取知乎

一个简单的python爬虫,爬取知乎 主要实现 爬取一个收藏夹 里 所有问题答案下的 图片 文字信息暂未收录,可自行实现,比图片更简单 具体代码里有详细注释,请自行阅读 项目源码: # -*- cod ...

- python爬虫---爬取王者荣耀全部皮肤图片

代码: import requests json_headers = { "User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win ...

随机推荐

- 教你用JavaScript实现计数器

案例介绍 欢迎来到我的小院,我是霍大侠,恭喜你今天又要进步一点点了!我们来用JavaScript编程实战案例,做一个计数器.点击按钮数字改变,点击重置数字归0.通过实战我们将学会forEach循环.c ...

- Cryptohack的Adrien's Signs解题思路

题目如下: 输出的结果: 题目分析: 在原题的题目描述中并没有什么有用的消息,更多的信息是通过代码审计出来的.大致意思是,先把字节flag转换为二进制形式的字符串,然后判断字符串中每个字符,如果为1, ...

- 分享自己亲测过的Visualstudio 2019中开发Typescript时,设置自动编译生成js,无需手工运行命令生成的方法。

步骤1)右键web项目,添加 tsconfig.json文件. 步骤2)确保配置如下,编译版本可自行设置,这里主要关注编译目标目录和自动编译设置: { "compileOnSave" ...

- C++进阶(智能指针)

智能指针原理 C++程序设计中使用堆内存是非常频繁的操作,堆内存的申请和释放都由程序员自己管理.程序员自己管理堆内存可以提高了程序的效率,但是整体来说堆内存的管理是麻烦的,C++11中引入了智能指针的 ...

- 算法学习笔记(5): 最近公共祖先(LCA)

最近公共祖先(LCA) 目录 最近公共祖先(LCA) 定义 求法 方法一:树上倍增 朴素算法 复杂度分析 方法二:dfs序与ST表 初始化与查询 复杂度分析 方法三:树链剖分 DFS序 性质 重链 重 ...

- P5690 [CSP-S2019 江西] 日期

简要题意 给你一个格式为 \(\texttt{MM-DD}\) 的日期.你每一次可以更改一个整数,花费 \(1\) 的代价.求将该日期改为一个合法的日期的最小代价.(注:\(2\) 月视为 \(28\ ...

- (11)go-micro微服务雪花算法

目录 一 雪花算法介绍 二 雪花算法优缺点 三 雪花算法实现 四 最后 一 雪花算法介绍 雪花算法是推特开源的分布式ID生成算法,用于在不同的机器上生成唯一的ID的算法. 该算法生成一个64bit的数 ...

- angular Ionic CLI项目开始

- 图书管理系统BMS

图书管理系统BMS 效果图: 主要代码: 表关系的创建: from django.db import models # Create your models here. class Book(mode ...

- MRS_下载相关问题汇总

解决问题如下: MRS下载编译时,更改生成文件是HEX文件还是BIN文件 关于MounRiver下载时如何选择配置部分擦除 关于MounRiver下载起始地址配置问题 MRS下载编译时,更改生成文件是 ...