Scrapy框架 之某网站产品采集案例

一、创建项目

第一步:scrapy startproject boyuan

第二步:cd boyuan

scrapy genspider product -t crawl boyuan.com

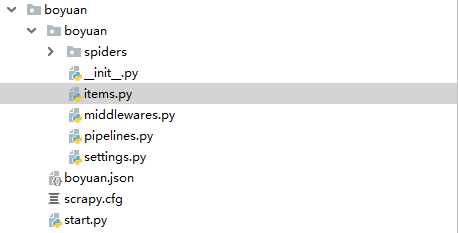

如图:

二、代码编写

1、item.py

# -*- coding: utf-8 -*- # Define here the models for your scraped items

#

# See documentation in:

# https://doc.scrapy.org/en/latest/topics/items.html import scrapy class BoyuanItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

name = scrapy.Field()

address = scrapy.Field()

company = scrapy.Field()

img = scrapy.Field()

time = scrapy.Field()

2、product.py爬虫文件

# -*- coding: utf-8 -*-

import scrapy

from scrapy.spiders import Rule, CrawlSpider

from scrapy.linkextractors import LinkExtractor

from ..items import BoyuanItem class ProductSpider(CrawlSpider):

name = 'product'

allowed_domains = ['boyuan.com']

offset = 1

url = "http://www.boyuan.com/sell/?page={0}"

start_urls = [url.format(str(offset))] page_link = LinkExtractor(allow=("\?page=\d+")) rules = [

Rule(page_link, callback="parse_content", follow=True)

] def parse_content(self, response):

for each in response.xpath("//div[@class='list']//tr"):

item = BoyuanItem()

item['name'] = each.xpath("./td[4]//strong/text()").extract()[0]

item['company'] = each.xpath("./td[4]//li[4]/a/text()").extract()[0]

address = each.xpath("./td[4]//li[3]/text()").extract()[0]

item['address'] = str(address).strip("[").strip("]")

time = each.xpath("./td[4]//li[3]/span/text()").extract()[0]

item['time'] = str(time).strip()

item['img'] = each.xpath("./td[2]//img/@original").extract()[0]

yield item

3、pipelines.py 管道文件

# -*- coding: utf-8 -*- # Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: https://doc.scrapy.org/en/latest/topics/item-pipeline.html

import json

import pymongo

from scrapy.conf import settings class BoyuanPipeline(object): def __init__(self):

host = settings.get("MONGO_HOST")

port = settings.get("MONGO_PORT")

db_name = settings.get("MONGO_DB")

collection = settings.get("MONGO_COLLECTION")

self.client = pymongo.MongoClient(host=host, port=int(port))

db = self.client.get_database(db_name)

if collection not in db.list_collection_names():

db.create_collection(collection)

self.col = db[collection] def process_item(self, item, spider):

# 保存到mongodb中

self.col.insert(dict(item))

return item def close_spider(self, spider):

self.client.close()

3、settings.py 配置文件

# mongodb数据库参数

MONGO_HOST = "localhost"

MONGO_PORT = ""

MONGO_DB = "boyuan"

MONGO_COLLECTION = "product"

4、start.py 启动文件

from scrapy import cmdline if __name__ == '__main__':

cmdline.execute("scrapy crawl product".split())

采集结果如图:

Scrapy框架 之某网站产品采集案例的更多相关文章

- Python 之scrapy框架58同城招聘爬取案例

一.项目目录结构: 代码如下: # -*- coding: utf-8 -*- # Define here the models for your scraped items # # See docu ...

- scrapy框架的解析

1,scrapy框架的官网:https://scrapy.org/ 什么是scrapy框架: scrapy 是一个为了爬取网站数据,提取结构性数据而编写的应用内框架,非常出名,所谓框架就是一个已经继承 ...

- Scrapy框架——CrawlSpider类爬虫案例

Scrapy--CrawlSpider Scrapy框架中分两类爬虫,Spider类和CrawlSpider类. 此案例采用的是CrawlSpider类实现爬虫. 它是Spider的派生类,Spide ...

- Scrapy框架——CrawlSpider爬取某招聘信息网站

CrawlSpider Scrapy框架中分两类爬虫,Spider类和CrawlSpider类. 它是Spider的派生类,Spider类的设计原则是只爬取start_url列表中的网页, 而Craw ...

- 爬虫(十四):Scrapy框架(一) 初识Scrapy、第一个案例

1. Scrapy框架 Scrapy功能非常强大,爬取效率高,相关扩展组件多,可配置和可扩展程度非常高,它几乎可以应对所有反爬网站,是目前Python中使用最广泛的爬虫框架. 1.1 Scrapy介绍 ...

- scrapy框架爬取糗妹妹网站妹子图分类的所有图片

爬取所有图片,一个页面的图片建一个文件夹.难点,图片中有不少.gif图片,需要重写下载规则, 创建scrapy项目 scrapy startproject qiumeimei 创建爬虫应用 cd qi ...

- Python爬虫开发【第1篇】【Scrapy框架】

Scrapy 框架介绍 Scrapy是用纯Python实现一个为了爬取网站数据.提取结构性数据而编写的应用框架. Srapy框架,用户只需要定制开发几个模块就可以轻松的实现一个爬虫,用来抓取网页内容以 ...

- python爬虫scrapy框架

Scrapy 框架 关注公众号"轻松学编程"了解更多. 一.简介 Scrapy是用纯Python实现一个为了爬取网站数据.提取结构性数据而编写的应用框架,用途非常广泛. 框架的力量 ...

- selenium模块使用详解、打码平台使用、xpath使用、使用selenium爬取京东商品信息、scrapy框架介绍与安装

今日内容概要 selenium的使用 打码平台使用 xpath使用 爬取京东商品信息 scrapy 介绍和安装 内容详细 1.selenium模块的使用 # 之前咱们学requests,可以发送htt ...

随机推荐

- You don't have permission to access ××× on this server.

之前开发项目一直在linux上用的xampp集成环境,前几天突然想移到window上面去. 開始在window上安装了一个集成环境(名字大概是 Uniform Service),把项目文件已过去, o ...

- gitlab常见错误解决办法

1 fail: gitlab-workhorse: runsv not running systemctl start gitlab-runsvdir.service systemctl status ...

- Ural1099 Work Scheduling 一般图的最大匹配

Ural1099 给定无向图, 求最大匹配. 在寻找增广路的过程中,可能出现一个奇环,这时候把奇环收缩,成为一朵“花”,并在新图上继续增广. 为了记录匹配关系,需要在花中寻找路径,每一条增广路径都可以 ...

- Oracle强杀进程

1.找到sid,serial#: SELECT /*+ rule */ s.username, l.type, decode(l.type,'TM','TABLE LOCK', ...

- 一句powershell调用mimikatz抓密码

mimikatz神器大家都知道吧,可以抓取系统内的明文密码,但是平时我们测试的时候需要把mimikatz的几个文件上传到目标系统上面,然后再手工执行几个命令才能搞定,今天无意访问一个大神的博客,发现其 ...

- Builder Design pattern

string assemblyName = ConfigurationSettings["BuilderAssembly"]; string builderName = Confi ...

- golang——strconv包常用函数

1.func ParseBool(str string) (value bool, err error) 返回字符串表示的bool值.它接受1.0.t.f.T.F.true.false.True.Fa ...

- (快速幂)51NOD 1046 A^B Mod C

给出3个正整数A B C,求A^B Mod C. 例如,3 5 8,3^5 Mod 8 = 3. Input 3个正整数A B C,中间用空格分隔.(1 <= A,B,C <= 10^ ...

- CSS布局大全

前几天面试,问我某布局感觉回答不是很OK所以研究了一下各种布局. 一.单列布局 1.普通布局(头部.内容.底部) <div class="container"> < ...

- mysql的子查询的提高

统计胜负结果的sql语句 date result 2011-02-01 胜 2011-02-01 负 2011-02-0 ...