Python网络爬虫笔记(四):使用selenium获取动态加载的内容

(一) 说明

上一篇只能下载一页的数据,第2、3、4....100页的数据没法获取,在上一篇的基础上修改了下,使用selenium去获取所有页的href属性值。

使用selenium去模拟浏览器有点麻烦,例如有300页就要点300次(按博客园这种一页20条,也就是6000条数据。要是几百万条,这个就得点好长时间了)

研究下有没有办法调用JS修改页面默认显示的数据条数(例如:博客园默认1页显示20条,改成默认显示1万条数据)。

(二) 完整代码

delayed.py的代码还是和之前一样。最好限速,不限速很容易被拒绝连接,而且也不道德。

from selenium import webdriver

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions

from selenium.webdriver.common.by import By

from selenium.webdriver.support.expected_conditions import StaleElementReferenceException

import time

import urllib.request as ure

from delayed import WaitFor

import lxml.html

import os

import docx

#使用selenium获取所有随笔href属性的值,url只能传小类的,例如https://www.cnblogs.com/cate/python/

def selenium_links(url):

driver = webdriver.Chrome()

driver.maximize_window()

driver.get(url)

#获取最大页数

maxPage = driver.find_element_by_css_selector('#paging_block div.pager a:nth-last-of-type(2)').get_attribute('text')

x=1

url_list=[]

#循环获取当前小类所有页面的href

while x<=int(maxPage):

time.sleep(1) #隐式 显式等待都尝试了,还是报错,只能等待1秒了(调试又正常运行)

x +=1

#等待 Next出现并返回 ,就是博客园翻到下一页的那个元素

lastPage = WebDriverWait(driver, 30).until(expected_conditions.element_to_be_clickable((By.CSS_SELECTOR, '#paging_block div.pager a:last-child')))

#等待元素出现并返回list,这里定位的是页面上的随笔

html = WebDriverWait(driver, 30).until(expected_conditions.presence_of_all_elements_located((By.CSS_SELECTOR, 'a.titlelnk')))

#迭代,将href属性的值添加到url_list

for h in html:

url_list.append(h.get_attribute('href'))

lastPage.click()

driver.quit()

#以列表形式返回所有URL

return url_list

#传入包含url的列表

def link_crawler(seed_url):

html_list = []

#下载crawl_queue中的所有网页

waitFor = WaitFor(2)

x =1

while seed_url:

print('第'+str(x)+'个')

x+=1

url = seed_url.pop()

#下载限速

waitFor.wait(url)

html = download(url)

html_list.append(html)

return html_list

#下载网页并返回

def download(url,user_agent='FireDrich',num=2):

print('下载:'+url)

#设置用户代理

headers = {'user_agent':user_agent}

request = ure.Request(url,headers=headers)

try:

#下载网页

html = ure.urlopen(request).read()

except ure.URLError as e:

print('下载失败'+e.reason)

html=None

if num>0:

#遇到5XX错误时,递归调用自身重试下载,最多重复2次

if hasattr(e,'code') and 500<=e.code<600:

return download(url,num-1)

return html #将下载的网页写入Word文档

def createWord(html):

x = 0

while html:

url = html.pop()

tree = lxml.html.fromstring(url) # 解析HTML为统一的格式

title = tree.xpath('//a[@id="cb_post_title_url"]') # 获取标题

the_file = tree.xpath('//div[@id="cnblogs_post_body"]/p') # 获取正文内容

pre = tree.xpath('//pre') # 获取随笔代码部分(使用博客园自带插入代码功能插入的)

img = tree.xpath('//div[@id="cnblogs_post_body"]/p/img/@src') # 获取图片

# 修改工作目录

os.chdir('F:\Python\worm\data\博客园文件')

try:

# 创建一个空白新的Word文档

doc = docx.Document()

# 添加标题

doc.add_heading(title[0].text_content(), 0)

#有的设置成注册用户才能浏览的随笔,调用download函数时下载不到正确的网页,导致获取不到标题

#title会是空列表,这里忽略这篇随笔,利用http.cookiejar模块应该可以解决这种问题,以后再看看这个模块了

except IndexError as e:

continue

for i in the_file:

# 将每一段的内容添加到Word文档(p标签的内容)

doc.add_paragraph(i.text_content())

# 将代码部分添加到文档中

for p in pre:

doc.add_paragraph(p.text_content())

# 将图片添加到Word文档中

for i in img:

try:

ure.urlretrieve(i, '0.jpg')

doc.add_picture('0.jpg')

except UnicodeEncodeError as e:

print('异常'+str(e))

pass

# 截取标题的前8位作为Word文件名

filename = title[0].text_content()[:8] + '.docx'

# 保存Word文档

# 如果文件名已经存在,将文件名设置为title[0].text_content()[:8]+ str(x).docx,否则将文件名设置为filename

if str(filename) in os.listdir('F:\Python\worm\data\博客园文件'):

doc.save(title[0].text_content()[:8] + str(x) + '.docx')

x += 1

else:

doc.save(filename)

#调用selenium_links获取所有url

html = selenium_links('https://www.cnblogs.com/cate/ruby/')

#调用link_crawler下载所有网页

downHtml = link_crawler(html)

#提取已经下载的网页数据到Word文档中

createWord(downHtml)

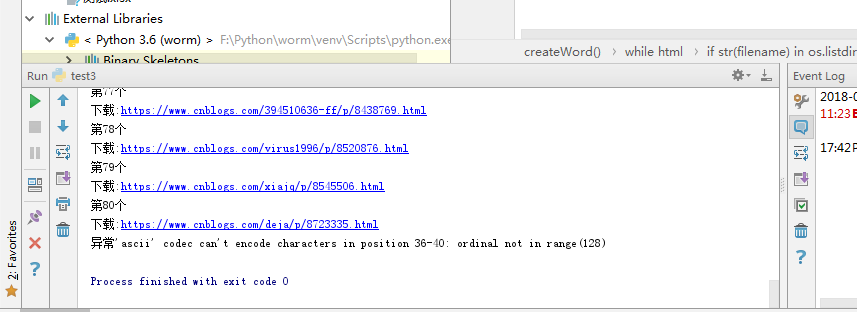

(三)结果

下面这个异常是,有的随笔上传了微信公众号的图片(暂时不确定是全部这样,还是部分这样),解析这个的时候会出现编码错误,目前的处理是输出异常信息,跳过这张图片。

Python网络爬虫笔记(四):使用selenium获取动态加载的内容的更多相关文章

- Python网络爬虫笔记(五):下载、分析京东P20销售数据

(一) 分析网页 下载下面这个链接的销售数据 https://item.jd.com/6733026.html#comment 1. 翻页的时候,谷歌F12的Network页签可以看到下面 ...

- Golang 网络爬虫框架gocolly/colly 五 获取动态数据

Golang 网络爬虫框架gocolly/colly 五 获取动态数据 gcocolly+goquery可以非常好地抓取HTML页面中的数据,但碰到页面是由Javascript动态生成时,用goque ...

- python网络爬虫之自动化测试工具selenium[二]

目录 前言 一.获取今日头条的评论信息(request请求获取json) 1.分析数据 2.获取数据 二.获取今日头条的评论信息(selenium请求获取) 1.分析数据 2.获取数据 房源案例(仅供 ...

- Python网络爬虫笔记(二):链接爬虫和下载限速

(一)代码1(link_crawler()和get_links()实现链接爬虫) import urllib.request as ure import re import urllib.parse ...

- 如何利用Python网络爬虫爬取微信朋友圈动态--附代码(下)

前天给大家分享了如何利用Python网络爬虫爬取微信朋友圈数据的上篇(理论篇),今天给大家分享一下代码实现(实战篇),接着上篇往下继续深入. 一.代码实现 1.修改Scrapy项目中的items.py ...

- 爬虫:获取动态加载数据(selenium)(某站)

如果网站数据是动态加载,需要不停往下拉进度条才能显示数据,用selenium模拟浏览器下拉进度条可以实现动态数据的抓取. 本文希望找到某乎某话题下讨论较多的问题,以此再寻找每一问题涉及的话题关键词(侵 ...

- 爬虫再探实战(四)———爬取动态加载页面——请求json

还是上次的那个网站,就是它.现在尝试用另一种办法——直接请求json文件,来获取要抓取的信息. 第一步,检查元素,看图如下: 过滤出JS文件,并找出包含要抓取信息的js文件,之后就是构造request ...

- 爬虫--selenuim和phantonJs处理网页动态加载数据的爬取

1.谷歌浏览器的使用 下载谷歌浏览器 安装谷歌访问助手 终于用上谷歌浏览器了.....激动 问题:处理页面动态加载数据的爬取 -1.selenium -2.phantomJs 1.selenium 二 ...

- Python网络爬虫实战(四)模拟登录

对于一个网站的首页来说,它可能需要你进行登录,比如知乎,同一个URL下,你登录与未登录当然在右上角个人信息那里是不一样的. (登录过) (未登录) 那么你在用爬虫爬取的时候获得的页面究竟是哪个呢? 肯 ...

随机推荐

- @RequestParam注解

SpringMVC的参数指定注解:@RequestParam,有下面四个方法: value 参数绑定,value里写的是URL里参数名称 name 同上 required 是否必需参数,默认为tr ...

- arm 算力运算

MIPS: Million Instructions executed Per SecondDMIPS: Dhrystone Million Instructions executed Per Sec ...

- c++的动态绑定和静态绑定

为了支持c++的多态性,才用了动态绑定和静态绑定. 1.对象的静态类型:对象在声明时采用的类型.是在编译期确定的. 2.对象的动态类型:目前所指对象的声明.在运行期决定.对象的动态类型可以更改,但是静 ...

- 链表的反转、合并(不借助额外list数组)

链表的基本操作:线性表 (单链表.循环链表-python实现) 反转链表: # -*- coding:utf-8 -*- class ListNode: def __init__(self, x): ...

- redis的高级事务CAS(乐观锁)

Optimistic locking using check-and-set(乐观锁) 乐观锁介绍:watch指令在redis事物中提供了CAS的行为.为了检测被watch的keys在是否有多个cli ...

- 【从0到1学Web前端】CSS定位问题三(相对定位,绝对定位) 分类: HTML+CSS 2015-05-29 23:01 842人阅读 评论(0) 收藏

引子: 开始的时候我想先要解决一个问题,怎么设置一个div盒子撑满整个屏幕? 看下面的html代码: <body> <div id="father-body"&g ...

- SqlServer 查看被锁的表和解除被锁的表

查看被锁的表 1 2 select request_session_id spid,OBJECT_NAME(resource_associated_entity_id) tableName ...

- Android中Serializable和Parcelable序列化对象详解

学习内容: 1.序列化的目的 2.Android中序列化的两种方式 3.Parcelable与Serializable的性能比较 4.Android中如何使用Parcelable进行序列化操作 5.P ...

- 如何恢复windows的exe文件的默认打开方式

事情由来: 有一次在用一个播放器选择打开视频文件的时候,意外的手贱点击打来了 exe 文件,之后戏剧性的恶心开始了,首先当然是打开失败,接着整个桌面的 exe 文件全部被替换成那个播放器的图标,然后所 ...

- linux(centos6.8 64位)下安装mysql5.7(yum方式)

下载mysql源安装包 # wget http:.noarch.rpm 安装mysql源包 #yum localinstall mysql57.noarch.rpm 检查mysql源是否安装成功 # ...