使用Spark进行搜狗日志分析实例——map join的使用

map join相对reduce join来说,可以减少在shuff阶段的网络传输,从而提高效率,所以大表与小表关联时,尽量将小表数据先用广播变量导入内存,后面各个executor都可以直接使用

package sogolog

import org.apache.hadoop.io.{LongWritable, Text}

import org.apache.hadoop.mapred.TextInputFormat

import org.apache.spark.rdd.RDD

import org.apache.spark.{SparkConf, SparkContext}

class RddFile {

def readFileToRdd(path: String): RDD[String] = {

val conf = new SparkConf().setMaster("local").setAppName("sougoDemo")

val sc = new SparkContext(conf);

//使用这种方法能够避免中文乱码

readFileToRdd(path,sc)

}

def readFileToRdd(path: String,sc :SparkContext): RDD[String] = {

//使用这种方法能够避免中文乱码

sc.hadoopFile(path,classOf[TextInputFormat], classOf[LongWritable], classOf[Text]).map{

pair => new String(pair._2.getBytes, 0, pair._2.getLength, "GBK")}

}

}

package sogolog

import org.apache.spark.{SparkConf, SparkContext}

import org.apache.spark.rdd.RDD

import scala.collection.mutable.ArrayBuffer

object MapSideJoin {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setMaster("local").setAppName("sougoDemo")

val sc = new SparkContext(conf);

val userRdd = new RddFile().readFileToRdd("J:\\scala\\workspace\\first-spark-demo\\sougofile\\user",sc)

//解析用户信息

val userMapRDD:RDD[(String,String)] = userRdd.map(line=>(line.split("\t")(0),line.split("\t")(1)))

//将用户信息设置为广播变量,方便各个任务引用

val userMapBroadCast =sc.broadcast(userMapRDD.collectAsMap())

val searchLogRdd = new RddFile().readFileToRdd("J:\\scala\\workspace\\first-spark-demo\\sougofile\\SogouQ.reduced",sc)

val joinResult = searchLogRdd.mapPartitionsWithIndex((index,f)=>{

val userMap = userMapBroadCast.value

var result = ArrayBuffer[String]()

var count = 0

//搜索日志表join用户表

//原来日志列为:时间 用户ID 关键词 排名 URL

//新的日志列为:时间 用户ID 用户名 关键词 排名 URL

f.foreach( log=>{

count=count+1;

val lineArrs = log.split("\t")

val uid = lineArrs(1)

val newLine:StringBuilder = new StringBuilder()

if(userMap.contains(uid)){

newLine.append(lineArrs(0)).append("\t")

newLine.append(lineArrs(1)).append("\t")

newLine.append(userMap.get(uid).get).append("\t") //从广播变量中根据用户ID获取用户名

for (i<- 2 to lineArrs.length-1){

newLine.append(lineArrs(i)).append("\t")

}

result .+= (newLine.toString())

}

})

println("partition_"+index+"处理的行数为:"+count)

result.iterator

})

//打印结果

joinResult.collect().foreach(println)

}

}

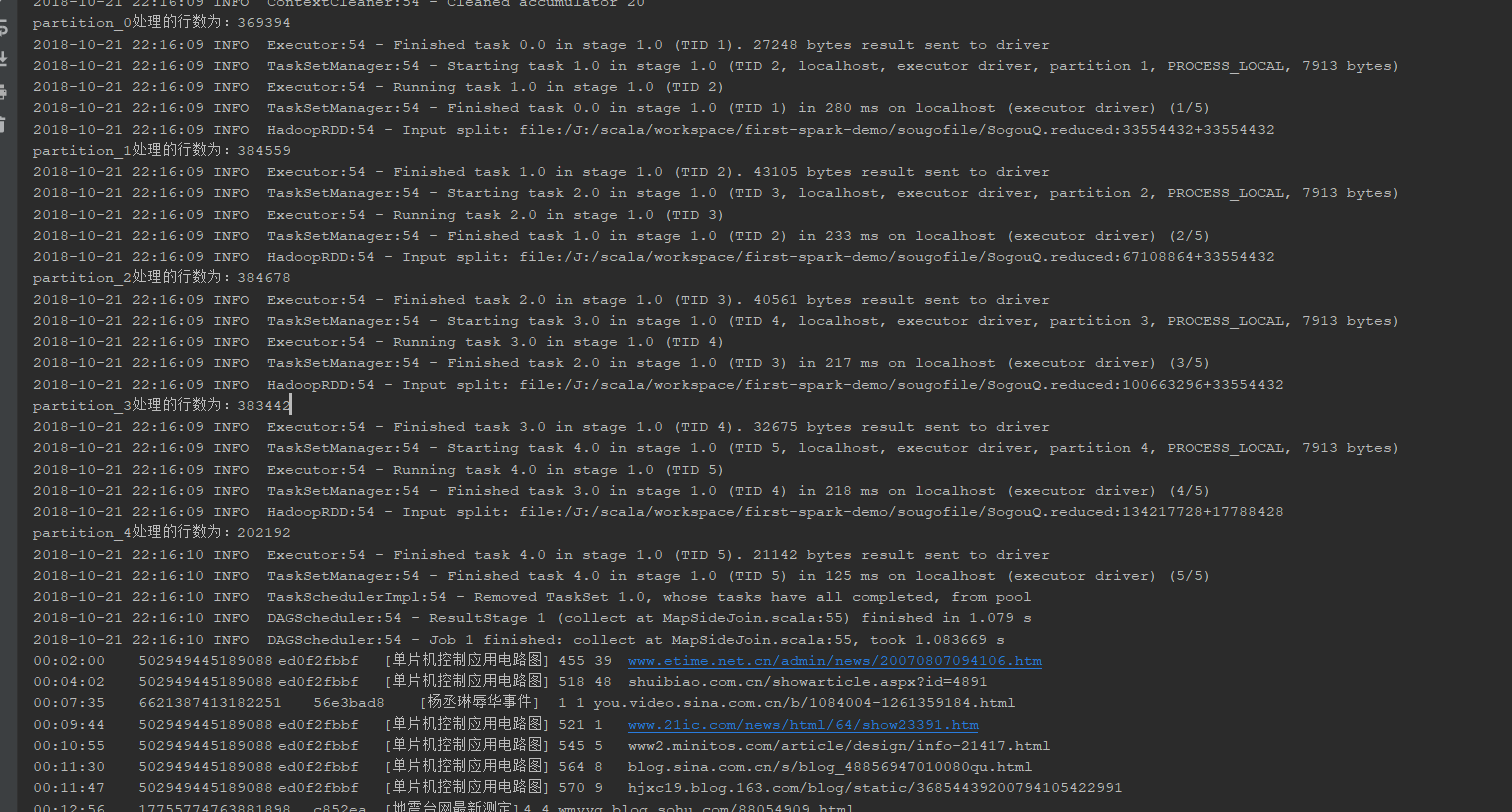

结果展示:

使用Spark进行搜狗日志分析实例——map join的使用的更多相关文章

- 使用Spark进行搜狗日志分析实例——统计每个小时的搜索量

package sogolog import org.apache.spark.rdd.RDD import org.apache.spark.{SparkConf, SparkContext} /* ...

- 使用Spark进行搜狗日志分析实例——列出搜索不同关键词超过10个的用户及其搜索的关键词

package sogolog import org.apache.hadoop.io.{LongWritable, Text} import org.apache.hadoop.mapred.Tex ...

- ELK 日志分析实例

ELK 日志分析实例一.ELK-web日志分析二.ELK-MySQL 慢查询日志分析三.ELK-SSH登陆日志分析四.ELK-vsftpd 日志分析 一.ELK-web日志分析 通过logstash ...

- Spark之搜狗日志查询实战

1.下载搜狗日志文件: 地址:http://www.sogou.com/labs/resource/chkreg.php 2.利用WinSCP等工具将文件上传至集群. 3.创建文件夹,存放数据: mk ...

- 基于Spark的网站日志分析

本文只展示核心代码,完整代码见文末链接. Web Log Analysis 提取需要的log信息,包括time, traffic, ip, web address 进一步解析第一步获得的log信息,如 ...

- spark提交异常日志分析

java.lang.NoSuchMethodError: org.apache.spark.sql.SQLContext.sql(Ljava/lang/String;)Lorg/apache/spar ...

- Spark RDD/Core 编程 API入门系列之动手实战和调试Spark文件操作、动手实战操作搜狗日志文件、搜狗日志文件深入实战(二)

1.动手实战和调试Spark文件操作 这里,我以指定executor-memory参数的方式,启动spark-shell. 启动hadoop集群 spark@SparkSingleNode:/usr/ ...

- 024 关于spark中日志分析案例

1.四个需求 需求一:求contentsize的平均值.最小值.最大值 需求二:请各个不同返回值的出现的数据 ===> wordCount程序 需求三:获取访问次数超过N次的IP地址 需求四:获 ...

- Spark SQL慕课网日志分析(1)--系列软件(单机)安装配置使用

来源: 慕课网 Spark SQL慕课网日志分析_大数据实战 目标: spark系列软件的伪分布式的安装.配置.编译 spark的使用 系统: mac 10.13.3 /ubuntu 16.06,两个 ...

随机推荐

- Arthas:线上问题排查工具

安装 下载 java -jar arthas-boot.jar 查看版本: D:\Program Files\arthas $ java -jar arthas-boot.jar -version [ ...

- unity - ios打包真机测试及模拟器测试

本文介绍unity游戏如何在iphone机和ios模拟器上进行测试打包 准备工作:mac电脑一台.iphone一部.连接mac和iPhone的数据线.unity.Xcode.苹果开发者账号. 苹果开发 ...

- c++ std::advance

// advance example #include <iostream> // std::cout #include <iterator> // std::advance ...

- spring xml配置注入改为手动注入过程

项目中需要使用MQ组件来接受消息,但是有的时候,在使用的时候,并不能满足spring注入的条件,无法注入.例如 在jfinal的config的afterJFinalStart中,由于jfinal集成s ...

- Cocos Creator学习二:查找节点和查找组件

1.目的:只有通过方便的获取节点对象以及组件,才能较好的进行逻辑控制. 2.通过 cc.find(节点全路径名称字符串) 获取节点. 3.通过getComponent获取组件(注意一个是类型,一个是类 ...

- printf打印输出

int PrintVal = 9; /*按整型输出,默认右对齐*/ printf("%d\n",PrintVal); /*按整型输出,补齐4位的宽度,补齐位为空格 ...

- UNDO -- Concept

Undo data Records of the actions of transactions, primarily before they are committed. The database ...

- 小程序 新建项目底部tabbar

在app.json中配置 { "pages": [ "pages/index/index", "pages/staging/staging" ...

- mac电脑上不能用移动硬盘的原因和方法

原因: 一般性是因为这个移动硬盘的格式是 NTFS 格式的,对于这种格式的磁盘格式,在苹果系统中却是不支持往硬盘里写入数据的 解决方法: 方法一: ntfs的格式分区,这种格式分区与我们的苹果电脑自身 ...

- React文档(二十)不使用JSX

JSX并不是使用React的一个强制需求.当你不需要在你的构造环境里设置编译那么不使用JSX会很方便. 每一个JSX元素只是调用React.createElement(componnet, props ...