Python爬虫,爬取腾讯漫画实战

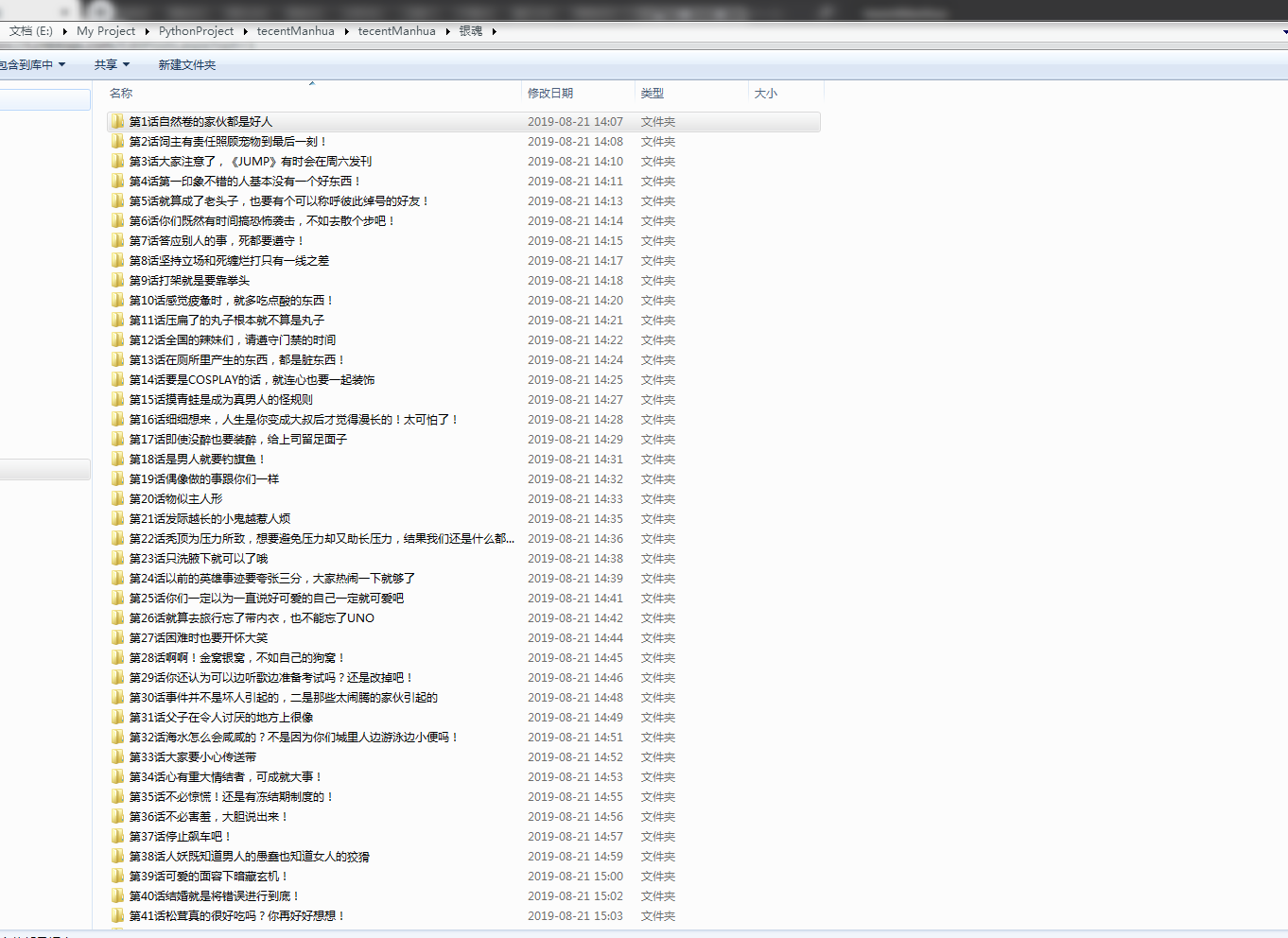

先上个爬取的结果图

最后的结果为每部漫画按章节保存

运行环境

IDE VS2019

Python3.7

Chrome、ChromeDriver

Chrome和ChromeDriver的版本需要相互对应

先上代码,代码非常简短,包含空行也才50行,多亏了python强大的库

import os

import time

import requests

from selenium import webdriver

from lxml import etree def getChapterUrl(url):

headers = {

"User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_13_4) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/66.0.3359.139 Safari/537.36"

}

part_url = "http://ac.qq.com"

res = requests.get(url, headers=headers)

html=res.content.decode()

el = etree.HTML(html)

li_list = el.xpath('//*[@id="chapter"]/div[2]/ol[1]/li')

for li in li_list:

for p in li.xpath("./p"):

for span in p.xpath("./span[@class='works-chapter-item']"):

item = {}

list_title = span.xpath("./a/@title")[0].replace(' ', '').split(':')

if list_title[1].startswith(('第', '序')):

getChapterFile(part_url + span.xpath("./a/@href")[0], list_title[0],list_title[1]) def getChapterFile(url,path1,path2):

#path = os.path.join(path)

#漫画名称目录

path=os.path.join(path1)

if not os.path.exists(path):

os.mkdir(path)

#章节目录

path=path+'\\'+path2

if not os.path.exists(path):

os.mkdir(path)

chrome=webdriver.Chrome()

#"http://ac.qq.com/ComicView/index/id/505435/cid/2"

chrome.get(url)

time.sleep(4)

imgs = chrome.find_elements_by_xpath("//div[@id='mainView']/ul[@id='comicContain']//img")

for i in range(0, len(imgs)):

js="document.getElementById('mainView').scrollTop="+str((i) * 1280)

chrome.execute_script(js)

time.sleep(3)

print(imgs[i].get_attribute("src"))

with open(path+'\\'+str(i)+'.png', 'wb') as f:

f.write(requests.get(imgs[i].get_attribute("src")).content)

chrome.close()

print('下载完成') if __name__ == '__main__':

getChapterUrl('http://ac.qq.com/Comic/ComicInfo/id/505435')

简单解释

输入一个漫画的url即可爬取该漫画所有的章节,由于是模拟用户爬取的,所以速度方面有点慢,我试了下爬取银魂前70章,用了1个半小时,代码中的sleep可以适当简短点已加快爬取的速度

付费的漫画是没有办法爬取的

谈一下过程中遇到的坑

腾讯的漫画网站打开章节时没有把所有图片的url都加载出来,所以我在这里用的方式是使用selenium来模拟用户操作,每次打开页面以后使用js操作滚动条下拉

最后再贴下代码库,其实贴出的代码已经是所有的代码了

https://dev.azure.com/shenjuncaci/PythonTecentManhua

Python爬虫,爬取腾讯漫画实战的更多相关文章

- Python爬虫---爬取腾讯动漫全站漫画

目录 操作环境 网页分析 明确目标 提取漫画地址 提取漫画章节地址 提取漫画图片 编写代码 导入需要的模块 获取漫画地址 提取漫画的内容页 提取章节名 获取漫画源网页代码 下载漫画图片 下载结果 完整 ...

- python爬虫爬取腾讯招聘信息 (静态爬虫)

环境: windows7,python3.4 代码:(亲测可正常执行) import requests from bs4 import BeautifulSoup from math import c ...

- Python爬虫 - 爬取百度html代码前200行

Python爬虫 - 爬取百度html代码前200行 - 改进版, 增加了对字符串的.strip()处理 源代码如下: # 改进版, 增加了 .strip()方法的使用 # coding=utf-8 ...

- 用Python爬虫爬取广州大学教务系统的成绩(内网访问)

用Python爬虫爬取广州大学教务系统的成绩(内网访问) 在进行爬取前,首先要了解: 1.什么是CSS选择器? 每一条css样式定义由两部分组成,形式如下: [code] 选择器{样式} [/code ...

- 使用Python爬虫爬取网络美女图片

代码地址如下:http://www.demodashi.com/demo/13500.html 准备工作 安装python3.6 略 安装requests库(用于请求静态页面) pip install ...

- Python爬虫|爬取喜马拉雅音频

"GOOD Python爬虫|爬取喜马拉雅音频 喜马拉雅是知名的专业的音频分享平台,用户规模突破4.8亿,汇集了有声小说,有声读物,儿童睡前故事,相声小品等数亿条音频,成为国内发展最快.规模 ...

- python爬虫爬取内容中,-xa0,-u3000的含义

python爬虫爬取内容中,-xa0,-u3000的含义 - CSDN博客 https://blog.csdn.net/aiwuzhi12/article/details/54866310

- Python爬虫爬取全书网小说,程序源码+程序详细分析

Python爬虫爬取全书网小说教程 第一步:打开谷歌浏览器,搜索全书网,然后再点击你想下载的小说,进入图一页面后点击F12选择Network,如果没有内容按F5刷新一下 点击Network之后出现如下 ...

- python爬虫—爬取英文名以及正则表达式的介绍

python爬虫—爬取英文名以及正则表达式的介绍 爬取英文名: 一. 爬虫模块详细设计 (1)整体思路 对于本次爬取英文名数据的爬虫实现,我的思路是先将A-Z所有英文名的连接爬取出来,保存在一个cs ...

随机推荐

- MyBatis从入门到精通:update用法、delete用法

update用法: 1.接口类中添加的方法: int updateById(SysUser sysUser); 2.映射文件中添加的代码: <update id="updateById ...

- PipelineDB Install and Test

Installation Prerequisites: CentOS Linux release 7.2.1511 (Core) Download [root@citus1 ~]# wget http ...

- 【并查集】模板 + 【HDU 1213、HDU 1232、POJ 2236、POJ 1703】例题详解

不想看模板,想直接看题目的请戳下面目录: 目录: HDU 1213 How Many Tables[传送门] HDU 1232 畅通工程 [传送门] POJ 2236 Wireless Network ...

- 用canvas绘制时钟

用canvas做时钟其实很简单,下面是我做出的效果: 是不是还挺漂亮的? 下面上代码: html <div class="whole"> <canvas id=& ...

- 个人永久性免费-Excel催化剂功能第18波-在Excel上也能玩上词云图

这年头数据可视化日新月异,在Excel上做数据分析,最后一步,难免要搞个图表输出高大上一回,微软也深知此道,在Excel2016上更新了一大波图表功能,市场上很耀眼的词云图还是没加进来,虽然在各大的在 ...

- C#5.0新增功能01 异步编程

连载目录 [已更新最新开发文章,点击查看详细] 如果需要 I/O 绑定(例如从网络请求数据或访问数据库),则需要利用异步编程. 还可以使用 CPU 绑定代码(例如执行成本高昂的计算),对编写异步 ...

- JAVA面试题 请谈谈你对Sychronized关键字的理解?

面试官:sychronized关键字有哪些特性? 应聘者: 可以用来修饰方法; 可以用来修饰代码块; 可以用来修饰静态方法; 可以保证线程安全; 支持锁的重入; sychronized使用不当导致死锁 ...

- python递归-三元表达式-列表生成式-字典生成式-匿名函数-部分内置函数-04

递归 递归: # 函数在调用阶段直接或间接地又调用了自身 应用场景: # 将列表中的数字依次打印出来(循环的层数是你必须要考虑的点) --> l = [1, [2, [3, [4, [5, ...

- cesium 学习(六) 坐标转换

cesium 学习(六) 坐标转换 一.前言 在场景中,不管是二维还好还是三维也罢,只要涉及到空间概念都会提到坐标,坐标是让我们理解位置的一个非常有效的东西.有了坐标,我们能很快的确定位置相关关系,但 ...

- BFS vs DFS

1 Clone Graph 1 copy ervery nodes by bfs 2 add neighbors public UndirectedGraphNode cloneGraph( ...