Scrapy项目 - 实现百度贴吧帖子主题及图片爬取的爬虫设计

要求编写的程序可获取任一贴吧页面中的帖子链接,并爬取贴子中用户发表的图片,在此过程中使用user agent 伪装和轮换,解决爬虫ip被目标网站封禁的问题。熟悉掌握基本的网页和url分析,同时能灵活使用Xmind工具对Python爬虫程序(网络爬虫)流程图进行分析。

一、项目分析

1. 网页分析

贴吧页面简洁,所有内容让人一目了然,使用起来也较其他社区论坛简单,注册简单甚至可以不注册,发 帖简单。但栏目创建得参差不齐,内容千奇百怪。

2. url分析

分析贴吧中,贴子链接的拼接构成形态,在程序中将贴子链接重构。

如本例实验,经过多次进入不同贴吧可知,贴吧的链接组成为:fullurl=url+key。其中fullurl表示贴吧总链接

url为贴吧链接的共同体:https://tieba.baidu.com/f?

key为经过urlencode编码的贴吧中文名

使用xpath_helper_2_0_2.crx浏览器插件,可将贴子的链接入口归结为:

“//li/div[@class="t_con cleafix"]/div/div/div/a/@href”,贴子中用户发表的图片链接表达式为:“//img ··[@class="BDE_Image"]/@src”

二、项目工具

Python 3.7.1 、 JetBrains PyCharm 2018.3.2

三、项目过程

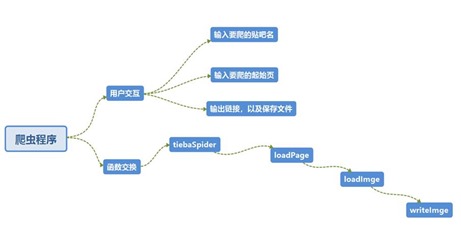

(一)使用Xmind工具对Python爬虫程序(网络爬虫)流程图进行分析,绘制如图4-1所示的程序逻辑框架图

图4-1 程序逻辑框架图

(二)爬虫程序调试过程BUG描述(截图)

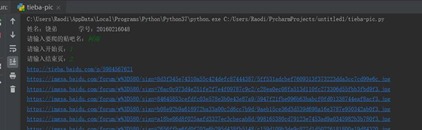

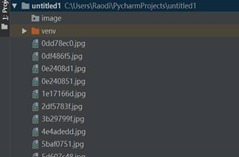

(三)爬虫运行结果

(四)项目心得

关于本例实验心得可总结如下:

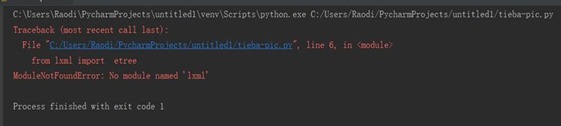

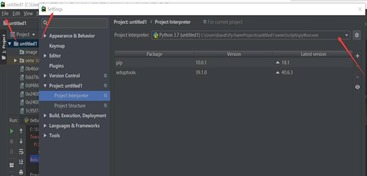

1、 当程序运行结果提示错误为:ModuleNotFoundError: No module named 'lxml',最好的解决方法是:首先排除是否lxml是否安装,再检查lxml是否被导入。本实验中,是由于工程项目为能成功导入lxml,解决方法如图5-1所示,在“Project Interperter”中选择python安装目录,即可。

图5-1 错误解决过程

2、 有的时候要模拟浏览器 ,不然做过反爬虫的网站会知道你是robot

例如针对浏览器的限制我们可以设置User-Agent头部,针对防盗链限制,我们可以设置Referer头部 有的网站用了Cookie来限制,主要是涉及到登录和限流,这时候没有什么通用的方法,只能看能否做自动登录或者分析Cookie的问题了。

3、 我们第一步可以在主界面的html代码中抽取出这些套图起始的链接地址,这里显然需要用到正则来提取这些不同地址。那么,有了每个套图的起始地址之后,我们进入到子页面,刷新网页,观察它的加载流程。

四、项目源码

tieba-pic.py

from urllib import request,parse

import ssl

import random

import time

from lxml import etree

ua_list=[

'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/71.0.3578.98 Safari/537.36',

'Mozilla/4.0 (compatible; MSIE 8.0; Windows NT 6.1; WOW64; Trident/4.0; SLCC2; .NET CLR 2.0.50727; .NET CLR 3.5.30729; .NET CLR 3.0.30729; Media Center PC 6.0; .NET4.0C; .NET4.0E)',

'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:45.0) Gecko/20100101 Firefox/45.0'

]

def loadPage(url):

userAgent=random.choice(ua_list)

headers={"User-Agent":userAgent}

req =request.Request(url,headers=headers)

context=ssl._create_unverified_context()

response=request.urlopen(req,context=context)

html=response.read()

content=etree.HTML(html)

link_list=content.xpath('//li/div[@class="t_con cleafix"]/div/div/div/a/@href') for link in link_list:

fullurl='http://tieba.baidu.com'+link

print(fullurl)

loadImge(fullurl) def loadImge(url):

req = request.Request(url)

context = ssl._create_unverified_context()

response = request.urlopen(req, context=context)

html = response.read()

content = etree.HTML(html)

link_list = content.xpath('//img[@class="BDE_Image"]/@src')

for link in link_list:

print(link)

writeImge(link) def writeImge(url):

req = request.Request(url)

context = ssl._create_unverified_context()

response = request.urlopen(req, context=context)

image = response.read()

filename=url[-12:]

f=open(filename,'wb')

f.write(image)

f.close() def tiebaSpider(url,beginPage,endPage):

for page in range(beginPage,endPage+100):

pn=(page-1)*50

fullurl=url+"&pn="+str(pn)

loadPage(fullurl) if __name__=="__main__":

print("测试成功!")

kw=input("请输入要爬的贴吧名:")

beginPage=int(input("请输入开始页:"))

endPage = int(input("请输入结束页:"))

url="http://tieba.baidu.com/f?"

key=parse.urlencode({"kw":kw})

fullurl=url+key

tiebaSpider(fullurl,beginPage,endPage)

Scrapy项目 - 实现百度贴吧帖子主题及图片爬取的爬虫设计的更多相关文章

- Scrapy项目 - 源码工程 - 实现豆瓣 Top250 电影信息爬取的爬虫设计

一.项目目录结构 spiders文件夹内包含doubanSpider.py文件,对于项目的构建以及结构逻辑,详见环境搭建篇. 二.项目源码 1.doubanSpider.py # -*- coding ...

- Scrapy项目 - 数据简析 - 实现豆瓣 Top250 电影信息爬取的爬虫设计

一.数据分析截图(weka数据分析截图 ) 本例实验,使用Weka 3.7对豆瓣电影网页上所罗列的上映电影信息,如:标题.主要信息(年份.国家.类型)和评分等的信息进行数据分析,Weka 3.7数据分 ...

- Scrapy项目 - 数据简析 - 实现斗鱼直播网站信息爬取的爬虫设计

一.数据分析截图(weka数据分析截图 2-3个图,作业文字描述) 本次将所爬取的数据信息,如:房间数,直播类别和人气,导入Weka 3.7工具进行数据分析.有关本次的数据分析详情详见下图所示: ...

- Scrapy项目 - 实现腾讯网站社会招聘信息爬取的爬虫设计

通过使Scrapy框架,进行数据挖掘和对web站点页面提取结构化数据,掌握如何使用Twisted异步网络框架来处理网络通讯的问题,可以加快我们的下载速度,也可深入接触各种中间件接口,灵活的完成各种需求 ...

- Scrapy项目 - 实现豆瓣 Top250 电影信息爬取的爬虫设计

通过使Scrapy框架,掌握如何使用Twisted异步网络框架来处理网络通讯的问题,进行数据挖掘和对web站点页面提取结构化数据,可以加快我们的下载速度,也可深入接触各种中间件接口,灵活的完成各种需求 ...

- Scrapy项目 - 实现斗鱼直播网站信息爬取的爬虫设计

要求编写的程序可爬取斗鱼直播网站上的直播信息,如:房间数,直播类别和人气等.熟悉掌握基本的网页和url分析,同时能灵活使用Xmind工具对Python爬虫程序(网络爬虫)流程图进行分析. 一.项目 ...

- Scrapy项目 - 数据简析 - 实现腾讯网站社会招聘信息爬取的爬虫设计

一.数据分析截图 本例实验,使用Weka 3.7对腾讯招聘官网中网页上所罗列的招聘信息,如:其中的职位名称.链接.职位类别.人数.地点和发布时间等信息进行数据分析,详见如下图: 图1-1 Weka ...

- Scrapy项目 - 项目源码 - 实现腾讯网站社会招聘信息爬取的爬虫设计

1.tencentSpider.py # -*- coding: utf-8 -*- import scrapy from Tencent.items import TencentItem #创建爬虫 ...

- Python爬虫实例(一)爬取百度贴吧帖子中的图片

程序功能说明:爬取百度贴吧帖子中的图片,用户输入贴吧名称和要爬取的起始和终止页数即可进行爬取. 思路分析: 一.指定贴吧url的获取 例如我们进入秦时明月吧,提取并分析其有效url如下 http:// ...

随机推荐

- 良许 | 命令的输出不会保存?居然连 tee 命令都不会用!

很多情况下,我们需要保存程序/命令的输出到本地,常用的一种方法是重定向,这也是一种很好的方法.但有个问题,如果你想要做后续操作,比如要统计输出的行数等,重定向就有困难了. 这时候,tee 命令就派上用 ...

- macbook 安装redis流程及问题总结

Mac安装redis流程和总结 一.redis安装流程: 1.进入redis官网-->点击download-->选择稳定版本(stable)-->点击Download即可. 2.将下 ...

- SpringBoot 2 快速整合 | 统一异常处理

统一异常处理相关注解介绍 @ControllerAdvice 声明在类上用于指定该类为控制增强器类,如果想声明返回的结果为 RESTFull 风格的数据,需要在声明 @ExceptionHandler ...

- HDU6223——2017ICPC沈阳G Infinite Fraction Path

题意: 给定一个数字串,每个位子都能向(i*i+1)%n的位子转移,输出路径上,字典序最大的,长度为n的串. 参考:https://www.cnblogs.com/mountaink/p/954144 ...

- hdu 1540 Tunnel Warfare(线段树)

题目链接 http://acm.hdu.edu.cn/showproblem.php?pid=1540 题意:D代表破坏村庄,R代表修复最后被破坏的那个村庄,Q代表询问包括x在内的最大连续区间是多少. ...

- poj 1417 True Liars(并查集+背包dp)

题目链接:http://poj.org/problem?id=1417 题意:就是给出n个问题有p1个好人,p2个坏人,问x,y是否是同类人,坏人只会说谎话,好人只会说实话. 最后问能否得出全部的好人 ...

- Docker详解(一)

目录 Docker简介 Docker组成 永远的HelloWorld 序言:众所周知,近几年的互联网各项技术发展的如火如荼,敏捷开发模式越来越普及,"快"似乎成为了行业的标准,于是 ...

- Wamp 新增php版本 教程

a.php版本下载:https://windows.php.net/download b.如果是apache环境下请认准 Thread Safe 版本 下载解压zip c.调整文件名为 php7. ...

- python简介及详细安装方法

1.Python简介 1.1 Python是什么 相信混迹IT界的很多朋友都知道,Python是近年来最火的一个热点,没有之一.从性质上来讲它和我们熟知的C.java.php等没有什么本质的区别,也是 ...

- python爬虫-模拟微博登录

微博模拟登录 这是本次爬取的网址:https://weibo.com/ 一.请求分析 找到登录的位置,填写用户名密码进行登录操作 看看这次请求响应的数据是什么 这是响应得到的数据,保存下来 exect ...